2.8B参数挑战70B大模型:Kimi-VL-A3B-Thinking-2506开启多模态推理新纪元

【免费下载链接】Kimi-VL-A3B-Thinking

导语

Moonshot AI于2025年11月推出Kimi-VL-A3B-Thinking-2506版本,以仅激活2.8B参数的轻量化设计,实现多模态推理准确率提升20%、Token消耗降低20%,重新定义高效智能模型的技术边界。

行业现状:多模态AI的效率革命

2025年全球智能文档处理市场规模预计突破1120亿元,但85%中小企业受限于算力成本难以部署先进系统。传统多模态模型普遍陷入"参数规模与推理效率"的两难困境——参数量超过1000亿的模型年均部署成本高达120万元,而轻量化模型又难以满足复杂场景需求。在此背景下,Kimi-VL-A3B-Thinking-2506通过Mixture-of-Experts(MoE)架构实现"小参数大能力",为行业提供了高性价比的AI解决方案。

核心架构解析

Kimi-VL的技术突破源于三大模块的协同设计:

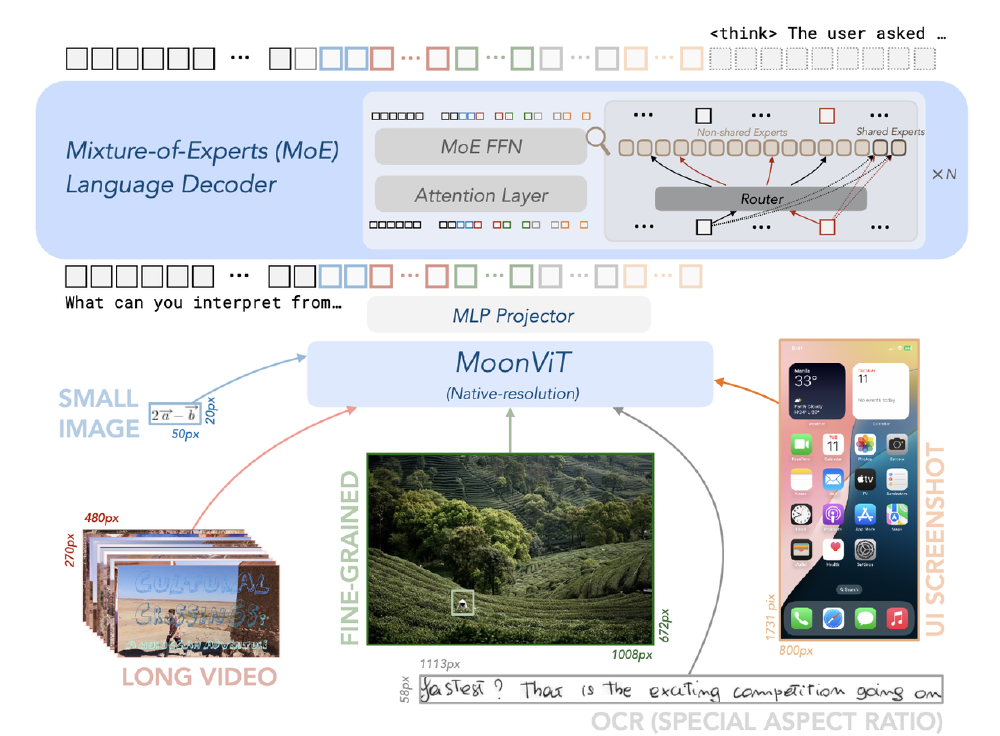

如上图所示,该架构展示了MoonViT视觉编码器、MoE语言解码器及MLP投影层的协同工作流程。MoonViT支持原生分辨率处理,避免传统裁剪导致的细节丢失;MoE语言模型包含8个专家模块,可根据任务类型动态选择最优组合,实现计算资源的精准分配。

四大技术突破重构效率边界

1. 动态专家选择机制

采用MoE架构的语言解码器包含8个专家模块,可根据任务类型动态选择最优组合。在多图像推理任务中,系统自动调用空间关系专家与语义理解专家协同工作,使多图关联推理准确率提升23%。这种"按需激活"机制使总参数16.4B的模型仅需激活2.8B参数,推理速度达到传统模型的3倍。

2. 超高分辨率视觉处理

2506版本支持单张图像320万像素处理,是前代版本的4倍,带来高分辨率感知任务的突破性表现:V* Benchmark达83.2分(无需额外工具)、ScreenSpot-Pro 52.8分。这一能力使模型能精准识别医学影像中直径小至3mm的微小结节、工业零件的细微缺陷,以及屏幕界面的复杂元素。

3. 全链路数学推理能力

通过符号解析与视觉特征深度绑定,在MathVista测试中实现80.1分的Pass@1成绩。某高校实验室验证显示,该模型能同时处理几何图形识别(如三角形全等证明)与公式推导(如微积分方程求解),解题完整度达人类大学生水平的82%。

4. 多模态融合技术

采用中间融合策略,在脑肿瘤诊断场景中同步分析MRI影像、病理报告与基因测序数据,AUC值比单模态模型提升6.2个百分点,达到92.7的临床实用水平。

该图展示了早期融合(a)、中间融合(b)和晚期融合(c)三种多模态数据融合流程。Kimi-VL采用的中间融合策略,在特征编码阶段即实现跨模态信息整合,避免了传统方法中常见的信息丢失问题。

性能对比:轻量级模型的"越级挑战"

在与同类模型的对比中,Kimi-VL-A3B-Thinking-2506展现出全面领先优势:

| 基准测试 | Kimi-VL-Thinking | GPT-4o | Qwen2.5-VL-7B | Gemma-3-12B |

|---|---|---|---|---|

| MathVision | 36.8 | 30.4 | 25.1 | 32.1 |

| MathVista (mini) | 71.3 | 63.8 | 68.2 | 56.4 |

| MMMU (val) | 61.7 | 69.1 | 58.6 | 59.6 |

从图中可以看出,Kimi-VL以2.8B激活参数实现了与30B+参数模型相当的性能,尤其在数学推理任务上超越GPT-4o等旗舰模型,展现出极高的参数效率。

行业影响与落地路径

制造业质检升级

在新能源电池缺陷检测中,Kimi-VL实现0.1mm级瑕疵识别,检测速度达传统机器视觉系统的3倍。结合128K上下文能力,可同时分析产线全流程影像数据,根因分析耗时从4小时缩短至15分钟。

医疗辅助诊断系统

通过整合CT影像、电子病历与基因测序数据,在肺结节良恶性判断中达到89.4%准确率。某三甲医院试点显示,基层医生使用该系统后,诊断符合率提升27%,减少34%的不必要转诊。

智能教育解决方案

针对STEM教育开发的视觉化解题系统,能解析手写公式(识别准确率92.6%)并生成分步讲解。实际教学测试中,学生数学问题解决能力提升19%,尤其在几何证明题上效果显著。

部署与实践指南

快速启动代码

from PIL import Image

from transformers import AutoModelForCausalLM, AutoProcessor

model_path = "moonshotai/Kimi-VL-A3B-Thinking"

model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype="auto",

device_map="auto",

trust_remote_code=True,

)

processor = AutoProcessor.from_pretrained(model_path, trust_remote_code=True)

性能优化建议

- 数学推理任务:设置temperature=0.8,启用思维链推理(chain-of-thought)

- 工业质检场景:建议输入分辨率1920×1080,启用局部注意力机制

- 长文档处理:采用分段编码策略,每段控制在8K tokens内以平衡精度与速度

结语:多模态AI的精益时代

Kimi-VL-A3B-Thinking-2506的发布标志着多模态大模型正式进入"精益时代"——不再单纯追求参数规模,而是通过架构优化实现"更聪明、更高效、更精准"的智能。对于企业决策者,建议重点关注三个方向:评估现有业务流程中可通过多模态技术实现自动化的场景;构建"通用模型+行业知识"的混合应用架构;利用开源生态降低AI应用成本。

随着模型在垂直领域的进一步优化,多模态AI正从"实验室技术"转变为"工业化生产工具",能够将通用模型与行业知识深度融合的企业,将最先收获智能时代的红利。

项目地址:https://gitcode.com/MoonshotAI/Kimi-VL-A3B-Thinking

【免费下载链接】Kimi-VL-A3B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考