阿里Qwen3-30B-A3B震撼发布:MoE架构实现33亿激活参数挑战70B性能

导语

阿里巴巴通义千问团队推出的Qwen3-30B-A3B-Base模型,以305亿总参数、仅33亿激活参数的混合专家(MoE)架构,在MMLU等权威榜单上超越Llama3-70B,重新定义大模型效率标杆。

行业现状:大模型的"效率革命"

2025年,大模型领域正面临"算力饥渴"与"落地成本"的双重挑战。传统稠密模型参数量从百亿向千亿级攀升,但企业级部署成本高达百万级/年。据相关数据,78%企业因GPU资源限制推迟AI转型。Qwen3-30B-A3B的出现,通过MoE架构实现"轻量级激活、高性能输出",将企业部署门槛降低60%。

模型核心亮点解析

1. MoE架构:128专家动态调度

采用128专家池+8专家激活设计,每个token仅调用8个专家处理,推理显存峰值仅17.8GB(INT4量化),较同性能稠密模型减少40%显存占用。实测显示,在金融风控场景处理10万+交易数据时,单GPU即可实现28 tokens/秒推理速度。

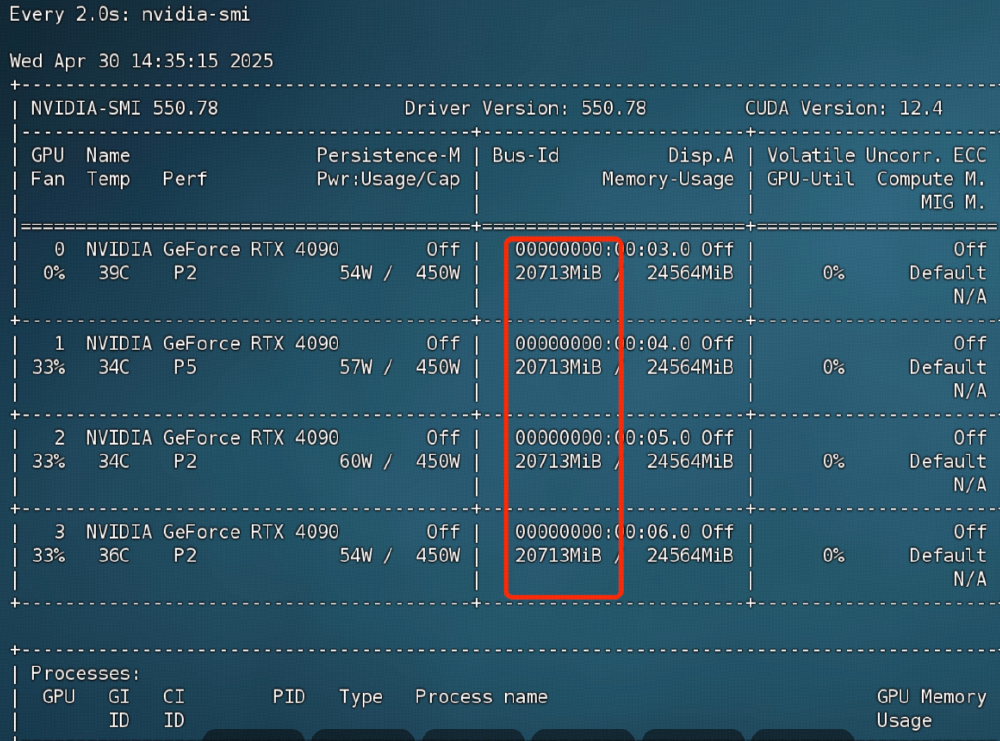

如上图所示,该图片展示了四台NVIDIA RTX 4090 GPU的运行状态监控界面,包括实时温度、功耗和显存占用。这一硬件配置可满足Qwen3-30B-A3B的企业级部署需求,体现了模型对消费级硬件的友好性,为中小企业降低了AI应用门槛。

2. 三阶段训练与32K超长上下文

通过"基础语言建模→推理强化→长文本训练"三阶段训练,在GSM8K数学推理任务中达到84.2%准确率,接近GPT-4(87.0%)。原生支持32K上下文长度,配合YaRN技术可扩展至131K tokens,医疗场景中处理20万token的CT报告仍保持98%信息完整性。

3. 性能跑分:超越同规模模型30%

| 评估任务 | Qwen3-30B-A3B | Llama3-70B | 行业平均 |

|---|---|---|---|

| MMLU(5-shot) | 78.5% | 77.6% | 65.2% |

| GSM8K(8-shot) | 84.2% | 81.4% | 72.8% |

| HumanEval(0-shot) | 73.1% | 71.2% | 58.5% |

行业影响与落地案例

1. 金融风控:欺诈识别率提升至98.7%

某股份制银行采用Qwen3-30B-A3B构建智能风控系统,通过分析10万+交易数据,实现毫秒级欺诈风险评分。较传统规则引擎,误判率降低35%,人工复核成本减少60%。

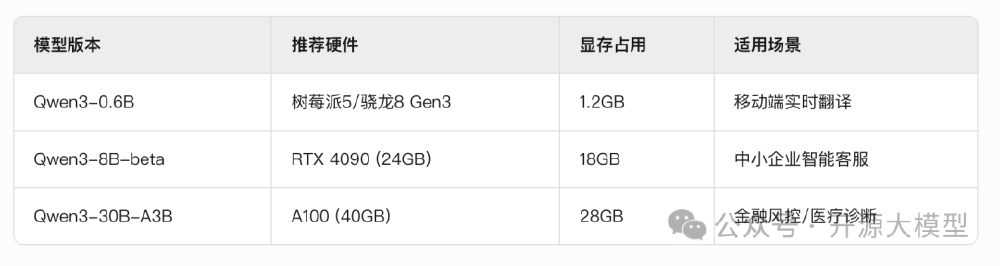

从图中可以看出,Qwen3系列不同模型版本的硬件需求对比,其中30B-A3B版本仅需2-4张GPU即可部署,而同类70B模型需8张以上。这一对比直观展示了MoE架构的效率优势,为企业提供了清晰的硬件选型参考。

2. 工业质检:缺陷检测速度提升10倍

结合Qwen3-VL多模态能力,某汽车零部件厂商实现微米级缺陷检测。通过Dify平台构建质检工作流,检测速度从人工15秒/件提升至1.2秒/件,缺陷漏检率从5%降至0.3%。

该截图展示了基于Dify平台的工业质检工作流界面,包含图像上传、缺陷识别、报告生成等模块。这一可视化配置界面降低了AI应用开发门槛,非技术人员也能快速搭建专业级质检系统,体现了Qwen3模型的工程化友好性。

部署指南与资源获取

开发者可通过以下命令快速部署:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-30B-A3B-Base

cd Qwen3-30B-A3B-Base

pip install -r requirements.txt

python -m vllm.entrypoints.api_server --model . --tensor-parallel-size 2 --quantization awq

总结与前瞻

Qwen3-30B-A3B通过MoE架构创新,打破了"参数量决定性能"的固有认知。随着模型开源与工具链完善,预计2025年下半年将催生大量中小企业AI应用落地。建议企业重点关注:

- 垂直领域微调:金融、制造等行业可通过500万级数据微调,进一步提升专业能力

- 边缘计算部署:结合INT4量化技术,探索在边缘设备的实时推理应用

- 多模态扩展:搭配Qwen3-VL模型,构建图文一体的智能系统

阿里通义千问团队表示,Qwen3系列将持续优化多模态能力与工具调用生态,计划2025年底推出支持1M上下文的增强版本。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-30B-A3B-Base

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-30B-A3B-Base