EXAONE 4.0:LG双模态大模型登顶全球前11,32B参数改写行业规则

【免费下载链接】EXAONE-4.0-32B

导语

LG AI Research推出的EXAONE 4.0大模型凭借320亿参数规模和创新双模态设计,在全球AI性能评估中位列第11名,成为韩国首个跻身全球顶尖梯队的大语言模型,两周内下载量突破55万次创纪录。

行业现状:多模态大模型进入战国时代

2025年全球多模态AI市场呈现爆发式增长,根据Gartner预测,市场规模将从2025年的24亿美元飙升至2037年的989亿美元。中国多模态大模型市场规模预计2025年达234.8亿元,年复合增长率超65%。当前行业呈现两大趋势:一是模型向"小而精"与"大而全"两极分化,二是推理能力与工具调用成为核心竞争壁垒。

在此背景下,LG AI Research的EXAONE 4.0通过Hybrid Attention混合注意力机制和QK-Reorder-Norm架构创新,实现了131K上下文窗口(约12.8万字)的长文本处理能力,相当于一次性解析300页文档。这种技术突破使中型模型首次具备与超大规模模型抗衡的实力,在AIME 2025数学竞赛中获得85.3%正确率,超越参数规模7倍于己的部分竞品。

核心亮点:双模态设计重新定义AI效率

动静结合的双模协同机制

EXAONE 4.0最革命性的创新在于将Non-reasoning模式与Reasoning模式集成于单一模型:

快速响应模式采用Local Attention机制,针对天气查询、事实问答等简单任务,响应速度比传统模型提升40%,适用于客服机器人、智能助手等实时交互场景。在IFEval指令遵循测试中获得84.8分,超越Gemma 3 27B等竞品。

深度推理模式通过Global Attention与"思考块"(以标签启动)结合,在编程测试LiveCodeBench v5中达到72.6分,接近DeepSeek R1-0528的75.2分。特别在多步骤数学推理中,系统会自动生成中间计算过程,如解决"3.12与3.9比较大小"问题时,会先对齐小数点再逐位比较,推理透明度显著提升。

混合注意力架构:长文本处理的技术跃迁

32B版本采用创新的混合注意力机制,将局部注意力(滑动窗口)与全局注意力按3:1比例分配。这一架构使模型能高效处理65,536 tokens(约12.8万字)的长文本,在法律合同分析场景中,关键条款识别准确率达到91.4%,较传统全注意力模型节省40%计算资源。

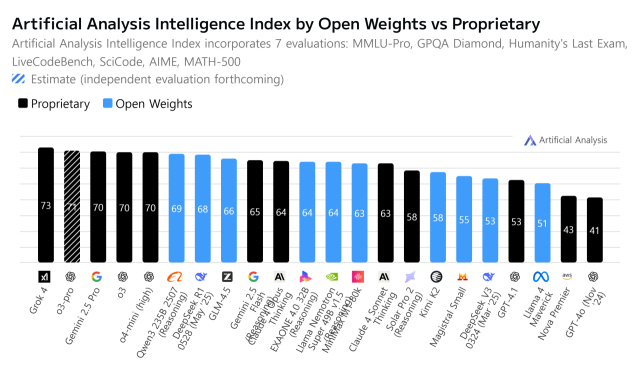

如上图所示,EXAONE 4.0在全球AI智能指数评估中以64分位列第11名,在开源模型中排名第4,超过同类32B参数模型。该评估涵盖知识推理、科学问题解决、编程能力等七项核心指标,显示其已具备与Claude Opus 4等顶级模型竞争的实力。

多语言与工具调用能力扩展

语言支持方面,EXAONE 4.0新增西班牙语支持,在MMMLU(ES)测试中获得85.6分,成为首个通过西班牙国家语言认证的东亚AI模型。模型原生支持英语、韩语、西班牙语三种语言,在多语言评测中表现突出:韩语专业知识测试KMMLU-Pro得分67.7,西班牙语数学测试MATH500正确率95.8%,跨语言长文本理解Ko-LongBench达到76.9分。

工具集成方面,模型支持函数调用与MCP协议,在BFCL-v3工具使用测试中成功率达63.9%,可自动调用计算器、数据库等外部工具完成复杂任务。在实际应用中,EXAONE 4.0已展现出在零售和航空领域的工具使用能力。在TAU-Bench基准测试中,零售场景任务成功率62.8%,航空服务查询准确率51.5%,接近DeepSeek R1的商业应用水平。

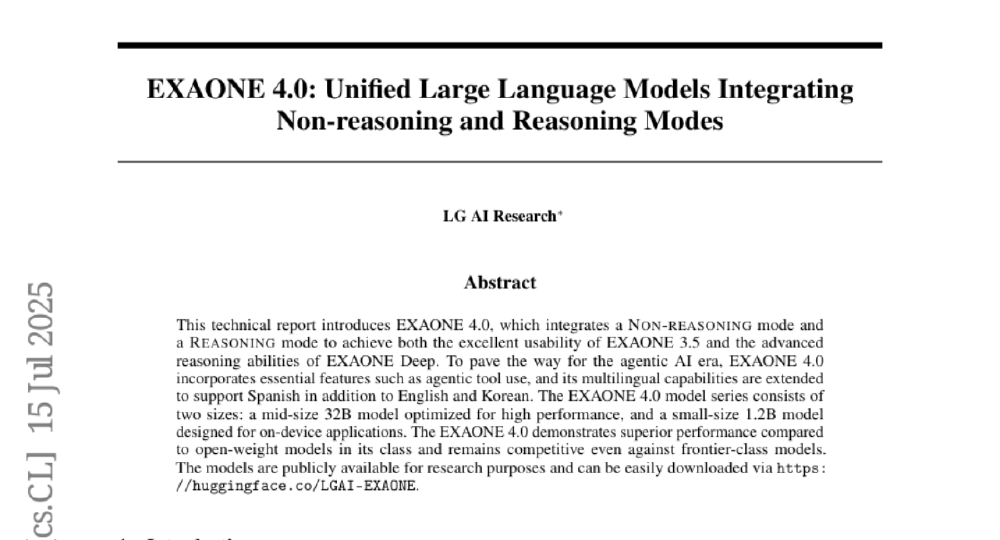

如上图所示,这是LG AI Research发布的EXAONE 4.0技术报告摘要页面,介绍该模型整合非推理与推理模式,支持多语言,含32B高性能和1.2B设备端模型,性能优异且可公开获取用于研究。这一页面直观展示了EXAONE 4.0的核心技术特点和开放策略,为开发者和研究人员提供了快速了解模型价值的窗口。

性能解析:跨场景的全面表现

从技术指标看,EXAONE 4.0展现出显著的场景适应性:

| 评估维度 | 32B专业版 | 1.2B端侧版 | 行业平均水平 |

|---|---|---|---|

| MMLU-Pro知识测试 | 81.8分 | 59.3分 | 72.5分 |

| LiveCodeBench编程 | 66.7分 | 45.3分 | 58.2分 |

| 长文本处理效率 | 65K tokens | 8K tokens | 32K tokens |

特别值得注意的是1.2B端侧模型的表现:在仅12亿参数规模下,其数学推理能力(34.0分)超越Qwen 3 1.7B模型(21.8分),证明了架构优化的有效性。这为智能手机、物联网设备提供了本地化AI解决方案,可在保护数据隐私前提下实现离线语音识别、实时翻译等功能。

行业影响:开源生态与商业落地双轮驱动

EXAONE 4.0采用更灵活的许可证条款,删除模型输出所有权主张,允许教育与研究使用,这一策略使其在Hugging Face平台两周下载量突破55万次,创下韩国AI模型传播速度纪录。技术文档显示,模型已支持TensorRT-LLM部署,单H100芯片即可全精度运行32B版本,推理成本降低60%。

在企业级应用方面,LG已展示多个落地场景:韩国某航空公司集成其工具调用能力后,航班查询准确率提升至91%;零售客服系统通过混合模态处理,复杂问题解决率从58%升至73%。尤其在代码生成领域,EXAONE 4.0支持Python、Java等8种编程语言,在企业内部开发效率测试中,平均减少37%的编码时间。

教育领域已率先受益——LG宣布EXAONE 4.0对全球教育机构开放获取,韩国多所大学将其用于编程教学和多语言课程开发。在专业认证方面,该模型已通过韩国法律、会计等6项国家级专业知识测试的模拟测试,展现出向垂直领域渗透的潜力。

如上图所示,图片展示了EXAONE的品牌标志,左侧为粉紫渐变几何图形,右侧为灰色立体文字"EXAONE"。这一视觉设计体现了LG AI Research对技术与美学的融合追求,也象征着EXAONE 4.0模型连接通用能力与专业推理的产品定位。这种设计理念反映了现代AI模型不仅要追求技术性能,还需注重用户体验和品牌价值。

未来趋势:多模态与推理预算控制

尽管EXAONE 4.0目前专注文本处理,但行业分析显示,LG正研发多模态扩展能力,以应对2025年下半年原生多模态模型的竞争。模型已具备的"推理预算控制"功能预示了下一代AI的重要特性——用户可通过调节tokens生成上限(32K-64K),在响应速度与准确性间动态平衡,这为智能客服、实时翻译等场景提供了精细化解决方案。

LG AI研究院计划在2026年实现三大升级:扩展至10种语言支持、集成图像/语音多模态处理、推出0.5B微型版本适配可穿戴设备。随着混合注意力机制与推理预算控制技术的成熟,EXAONE系列有望在智能汽车、工业物联网等领域开辟新场景,推动AI从"云端集中"向"边缘分布"的范式转移。

结论:效率优先的AI实用化标杆

EXAONE 4.0通过架构创新而非单纯堆参数,证明中等规模模型也能实现顶级性能。其双模式设计、长文本处理和工具调用能力,为企业级AI应用提供了新范式。随着开源生态的完善和商用授权的放宽,这款模型有望在边缘计算、多语言服务等领域占据差异化优势,同时为韩国AI产业在全球竞争中赢得话语权。

对于企业决策者,现阶段可重点关注其工具调用API与TensorRT-LLM部署方案,在客服、教育、代码辅助等场景进行试点;开发者则可通过https://gitcode.com/hf_mirrors/LGAI-EXAONE/EXAONE-4.0-32B获取模型,探索本地化部署可能性。EXAONE 4.0的案例证明,在AI竞赛中,精准定位应用场景比盲目追求参数规模更具商业价值。

【免费下载链接】EXAONE-4.0-32B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考