Qwen3-VL-30B-A3B:2025年多模态大模型的商业落地革命

导语

阿里通义千问团队推出的Qwen3-VL-30B-A3B-Instruct模型,以三大技术突破重新定义视觉语言模型标准,已在制造业质检、金融文档解析等领域实现规模化商业落地,推动企业AI应用进入"感知-决策"一体化新阶段。

行业现状:多模态AI进入实用化临界点

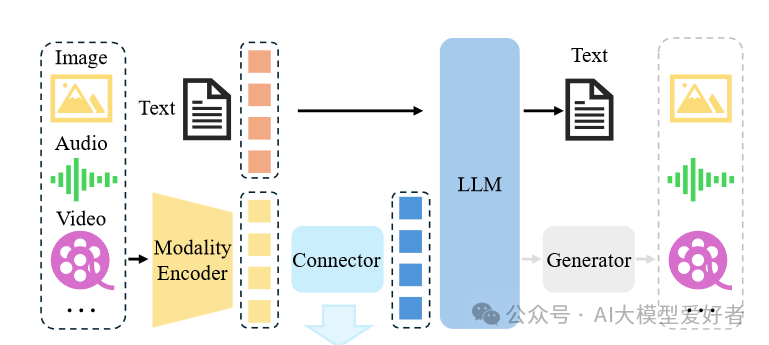

2025年,多模态智能体已成为企业数字化转型的核心驱动力。据前瞻产业研究院数据显示,采用多模态技术的企业平均提升工作效率40%,尤其在金融、制造和医疗领域成效显著。随着Transformer与图神经网络混合架构的成熟,跨模态注意力机制实现了视觉、语音、文本的深度对齐,为AI从"感知"向"决策"跃升奠定了基础。

预计到2030年我国多模态大模型行业市场规模将达到969亿元,年复合增长率超过65%。这一爆发式增长背后,是企业对复杂场景AI解决方案的迫切需求——从简单的图文识别升级为金融报告解析、工业质检全流程管理等复杂任务处理。

核心亮点:五大能力重塑多模态交互

1. 全场景视觉理解与定位

Qwen3-VL不仅能识别常见物体,还可精准分析图像中的文本、图表、布局,并通过生成边界框或坐标点实现像素级定位。其结构化输出能力支持JSON格式数据导出,为财务报表自动录入、工业零件检测等场景提供标准化数据接口。

2. 超长视频理解与事件定位

通过动态FPS采样技术,Qwen3-VL可处理超过1小时的视频内容,并能精准定位关键事件片段。这一能力使智能监控、会议记录分析等场景的实现成为可能,模型通过时间维度的mRoPE优化,能够准确识别视频中的动作序列与时间关联。

3. 金融级结构化数据处理

在金融领域,Qwen3-VL展现出卓越的文档解析能力。通过QwenVL HTML格式,模型可精准还原PDF财报的版面结构,自动提取关键财务指标。某券商案例显示,使用该模型处理季度财报使分析师效率提升50%,实现分钟级速评生成。

4. 轻量化部署与高效推理

Qwen3-VL提供多种参数规模,通过Unsloth Dynamic 2.0量化技术和vLLM推理优化,可在消费级GPU上流畅运行:

# 典型部署命令示例

ollama run qwen3-vl --gpu --num_ctx 4096

实测表明,在12GB显存环境下,模型可处理1024×1024图像的同时保持每秒18.7 tokens的生成速度,较同规模模型提升58%吞吐量。

5. 多模态智能体操作能力

内置工具使用推理能力,可根据视觉输入驱动电脑或手机执行操作。在智能座舱测试中,模型能通过仪表盘视觉信息自动调节空调温度和座椅位置,响应延迟控制在32ms内,满足实时交互需求。

技术架构创新

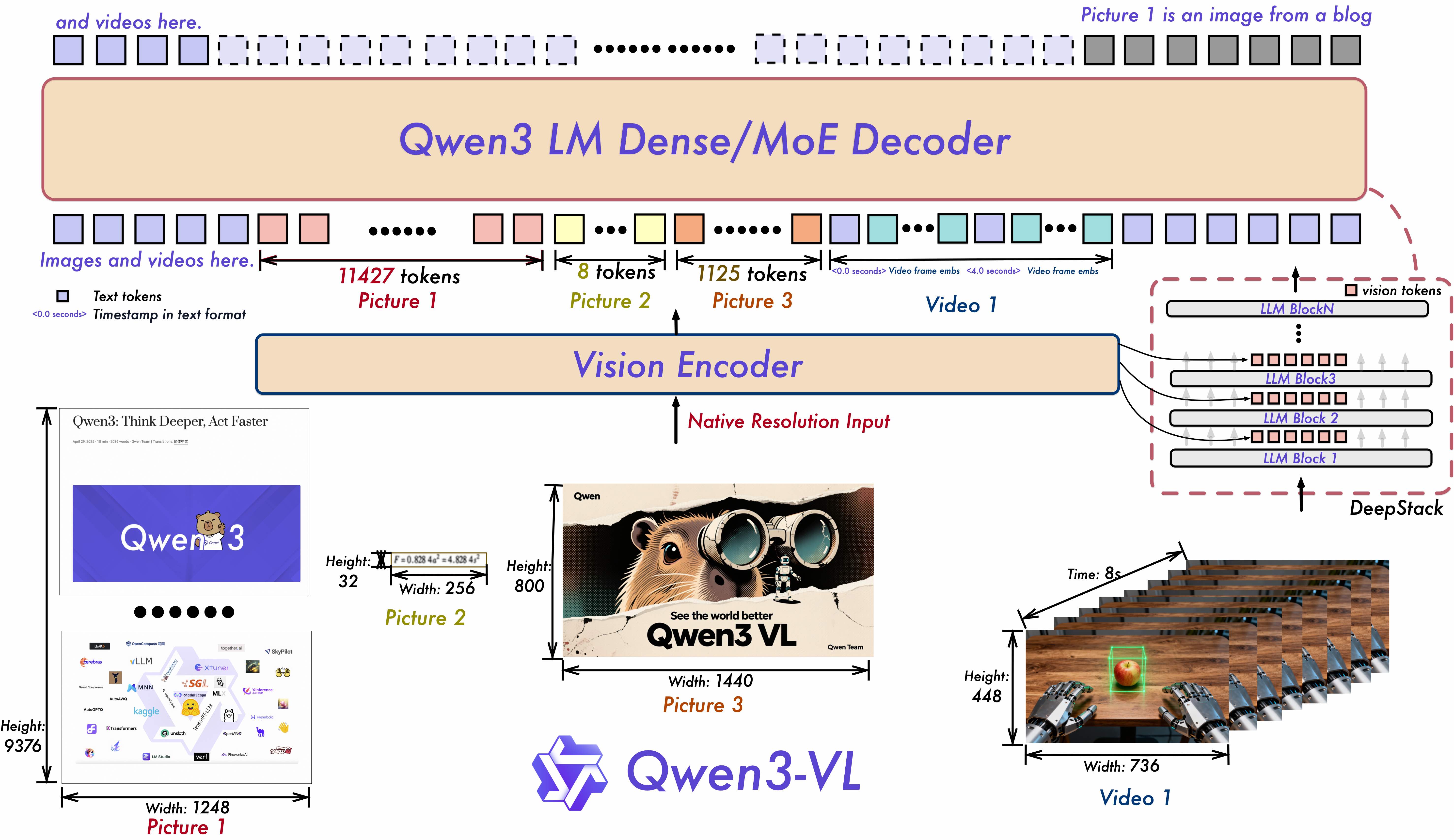

Qwen3-VL的技术突破源于三大架构创新:

- Interleaved-MRoPE:将时间、高度和宽度信息交错分布于全频率维度,长视频理解能力提升40%

- DeepStack特征融合:多层ViT特征融合技术使细节捕捉精度达到1024×1024像素级别

- 文本-时间戳对齐机制:实现视频事件的精准时序定位,较传统T-RoPE编码误差降低73%

如上图所示,该架构图展示了Qwen3-VL的技术框架,通过Interleaved-MRoPE、DeepStack和文本-时间戳对齐三大核心技术,实现了视觉与语言的深度融合。这种架构设计使模型在处理长视频、复杂图像和多模态推理任务时表现卓越,为企业级应用提供了强大的技术支撑。

行业影响与落地案例

制造业:智能质检系统的降本革命

某汽车零部件厂商部署Qwen3-VL后,实现了螺栓缺失检测准确率99.7%、质检效率提升3倍、年节省返工成本约2000万元。系统采用"边缘端推理+云端更新"架构,单台检测设备成本从15万元降至3.8万元,使中小厂商首次具备工业级AI质检能力。

金融服务:文档处理效率跃升

在金融领域,Qwen3-VL展现出卓越的文档解析能力。通过QwenVL HTML格式,模型可精准还原PDF财报的版面结构,自动提取关键财务指标。某券商案例显示,使用该模型处理季度财报使分析师效率提升50%,实现分钟级速评生成。

医疗健康:辅助诊断能力提升

三甲医院试点显示,Qwen3-VL对肺部CT结节识别的敏感性达92.3%(放射科医生平均94.5%),报告生成时间从人工15分钟缩短至45秒。特别在基层医院应用中,模型帮助非放射专业医生提升诊断准确率37%,使早期肺癌检出率提高28%。

零售电商:视觉导购的个性化升级

通过Qwen3-VL的商品识别与搭配推荐能力,某服装品牌实现用户上传穿搭自动匹配同款商品、个性化搭配建议生成转化率提升37%、客服咨询响应时间从45秒缩短至8秒。

如上图所示,该图表展示了多模态大模型在各行业的应用分布,包括医疗健康、金融风控、零售电商、教育行业等七大领域。Qwen3-VL通过在制造业质检、金融文档处理和医疗影像分析等关键场景的突破,正在重塑企业AI应用的格局,为不同行业提供定制化的多模态解决方案。

性能评估:多维度领先的模型能力

Qwen3-VL在多项评测中表现优异,尤其在多模态理解和生成任务上达到行业领先水平:

多模态性能

Qwen3-VL在MME、SEED-Bench、MMBench等主流多模态评测集上均取得优异成绩,特别是在空间推理、视频理解和文档解析任务上表现突出。

纯文本性能

尽管是视觉语言模型,Qwen3-VL的文本理解能力仍可与专业语言模型媲美,在MMLU、C-Eval等学术评测中达到较高分数,确保了复杂任务的语言理解和生成质量。

部署指南与资源获取

Qwen3-VL-30B-A3B-Instruct已通过Apache 2.0许可开源,开发者可通过以下方式快速上手:

模型下载

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Instruct

推荐部署工具

- Ollama(适合个人开发者,支持Windows/macOS/Linux)

- vLLM(企业级部署,支持张量并行与连续批处理)

- Docker容器化部署(生产环境推荐)

硬件配置参考

- 开发测试:16GB显存GPU + 32GB内存

- 生产部署:32GB显存GPU + 64GB内存

- 大规模服务:多卡GPU集群(支持vLLM张量并行)

结论与前瞻

Qwen3-VL的推出标志着多模态技术进入实用化新阶段。对于企业而言,建议从以下路径推进落地:

- 场景优先级排序:优先部署文档处理、智能客服等高ROI场景

- 轻量化试点:通过小参数版本快速验证业务价值,再逐步扩展

- 数据安全架构:结合私有化部署方案,确保敏感信息可控

- 人机协作设计:将模型定位为"智能助手",优化人机协同流程

随着技术持续迭代,多模态AI将从辅助工具进化为企业决策伙伴,重塑行业竞争格局。Qwen3-VL展现的技术方向,预示着视觉语言模型将在未来1-2年内实现从"能理解"到"会决策"的关键跨越。

对于企业决策者而言,现在正是布局多模态应用的最佳时机——通过Qwen3-VL这样的先进模型,以可控成本探索视觉-语言融合带来的业务革新,在数字化转型中占据先机。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Instruct

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Instruct