Qwen3-VL-4B-Instruct震撼发布:三大技术突破重塑多模态AI能力边界

【免费下载链接】Qwen3-VL-4B-Instruct

多模态大模型领域再迎新里程碑!Qwen3-VL-4B-Instruct凭借突破性的技术架构革新,在长视频理解、跨模态对齐与视觉Agent交互等核心能力上实现跨越式提升,为人工智能视觉认知与多模态交互开辟全新可能。

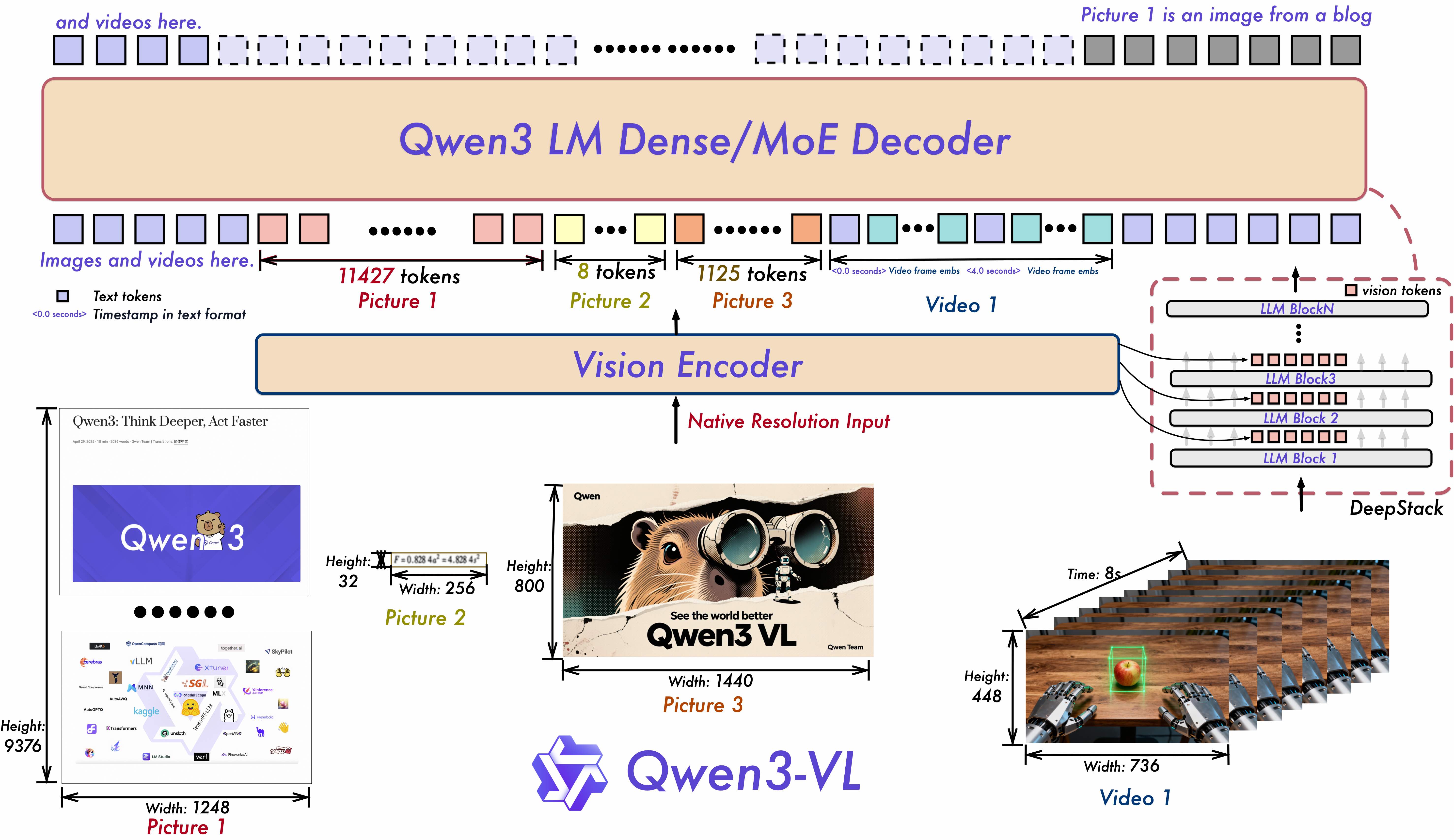

模型架构的深度创新是Qwen3-VL-4B-Instruct实现性能飞跃的核心驱动力。该模型创新性地采用Interleaved-MRoPE技术,通过对时间、宽度和高度三个维度进行全频率的位置信息分配,构建起鲁棒性更强的位置嵌入机制。这一技术突破使得模型在处理长视频序列时,能够精准捕捉帧间时序关系与空间位置信息,长视频推理能力得到显著增强。与此同时,DeepStack架构的引入则通过融合多级别视觉Transformer(ViT)特征,有效提升了图像与文本信息的对齐精度,让跨模态理解更加细腻准确。Text-Timestamp Alignment技术更是突破传统T-RoPE机制的限制,实现了基于时间戳的精确事件定位,进一步强化了模型对视频时序结构的建模能力。

如上图所示,Qwen3-VL的架构图清晰呈现了Interleaved-MRoPE、DeepStack等核心技术模块的协同工作原理。这一整合式架构设计充分体现了模型在多模态信息处理上的系统性创新,为开发者理解模型底层逻辑与技术优势提供了直观参考。

如上图所示,Qwen3-VL的架构图清晰呈现了Interleaved-MRoPE、DeepStack等核心技术模块的协同工作原理。这一整合式架构设计充分体现了模型在多模态信息处理上的系统性创新,为开发者理解模型底层逻辑与技术优势提供了直观参考。

这些架构升级带来的性能提升在空间推理任务中表现得尤为突出。Qwen3-VL-4B-Instruct能够精准判断复杂场景中物体的空间位置关系、视角变换及遮挡情况,同时支持2D和3D grounding技术,为空间推理与具身AI的发展奠定了坚实基础。无论是精确识别图像中物体的坐标信息,还是理解三维空间中物体的相对位置,模型都展现出超越前代产品的处理能力,这为机器人导航、自动驾驶等需要精准空间认知的领域提供了强有力的技术支撑。

在视觉交互能力方面,Qwen3-VL-4B-Instruct通过视觉编码器的深度优化与多模态推理能力的增强,成功实现了视觉Agent功能。该功能使模型能够直接操作PC或移动设备的GUI界面,独立完成界面元素识别、工具调用、多步骤任务执行等复杂操作。例如,在办公场景中,模型可以根据用户指令自动打开应用程序、填写表单、处理文档;在智能家居控制中,能够通过视觉识别操作智能设备界面,实现自动化控制。这种端到端的视觉交互能力大幅提升了模型的实用价值,推动多模态AI从被动感知向主动操作迈进。

随着Qwen3-VL-4B-Instruct的发布,多模态大模型正朝着更智能、更实用的方向快速发展。其在长视频理解、空间推理和视觉Agent等方面的技术突破,不仅拓展了AI的应用边界,更为行业带来了诸多新的可能性。未来,随着技术的不断迭代优化,我们有理由相信Qwen3-VL系列模型将在更多领域发挥重要作用,推动人工智能真正融入生产生活的各个角落,为用户创造更加智能、高效的交互体验。

【免费下载链接】Qwen3-VL-4B-Instruct

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考