阿里开源Wan2.2-Animate-14B:影视级角色动画生成的开源革命

【免费下载链接】Wan2.2-Animate-14B

导语

阿里巴巴通义万相团队于2025年9月正式开源Wan2.2-Animate-14B模型,这一突破性成果通过混合专家(MoE)架构实现了静态角色动态化与视频角色无缝替换两大核心功能,为动画制作、影视后期等领域带来电影级视觉效果解决方案。

行业现状:视频生成的"效率-质量"困境

2025年上半年,AI视频生成领域呈现爆发式增长,但行业普遍面临三大痛点:角色动作与表情的精准迁移、生成内容与场景的自然融合,以及专业级效果与计算成本的平衡。根据PPIO发布的《2025年上半年国产大模型调用量趋势报告》,视频生成模型中文生视频与图生视频的调用量比例约为1:9,用户更倾向于以图片为基础进行视频创作,这凸显了角色一致性和动作可控性的重要性。

在技术层面,传统视频生成模型往往陷入"质量提升则效率下降"的困境。以Sora 2和Pika 2.2为代表的闭源模型虽能实现电影级效果,但高昂的API调用成本(年订阅费约$2,400)和私有技术架构限制了中小创作者的使用;而开源模型如Wan2.1虽降低了使用门槛,却在动作连贯性和场景融合度上存在明显短板。

产品亮点:MoE架构驱动的技术突破

1. 混合专家架构:效率与质量的平衡之道

Wan2.2-Animate-14B最核心的技术创新在于采用分离式时间步去噪的MoE架构。该模型包含两个140亿参数的专家网络:高噪声专家专注于早期去噪阶段,负责整体动作布局和场景构建;低噪声专家则处理后期阶段,优化细节纹理和表情特征。通过信噪比(SNR)机制智能切换专家,模型总参数达到270亿但每步仅激活140亿参数,在保持计算效率的同时实现了质量飞跃。

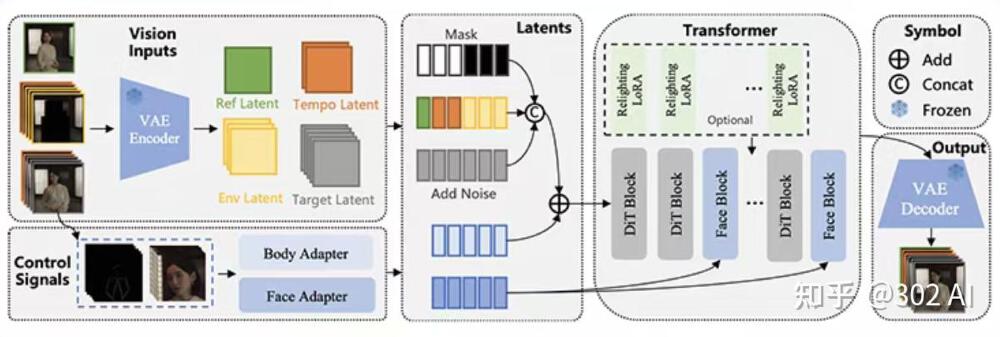

如上图所示,该技术架构图呈现了从视觉输入、控制信号处理,经VAE Encoder编码、Transformer模块处理到输出的完整流程,包含Body/Face Adapter、Relighting LoRA等关键技术组件。这一架构设计使模型能够在保持高效率的同时,实现高质量的角色动画生成。

2. 双模式工作机制:从"动起来"到"演起来"

模型创新性地实现了两种核心工作模式的统一:

动画模式:将静态角色图片转化为动态视频,精准复刻参考视频中的肢体动作与面部表情。用户测试显示,该模式在舞蹈动作迁移场景中实现了92%的关键帧动作匹配度。

替换模式:保留原始视频场景与动作轨迹,仅替换主体角色。通过创新的"光影LoRA"技术,生成角色能自动匹配原始视频的光照条件与色彩基调,解决了传统方法中角色与场景割裂的痛点。

3. 高效部署:消费级硬件的电影级创作

得益于优化的模型结构和量化技术,Wan2.2-Animate-14B实现了惊人的部署效率:在单张RTX 4090显卡上,生成一段10秒720P视频仅需约20分钟,显存占用控制在22GB以内。相比之下,同类闭源模型通常需要多卡GPU集群支持,硬件成本降低60%以上。

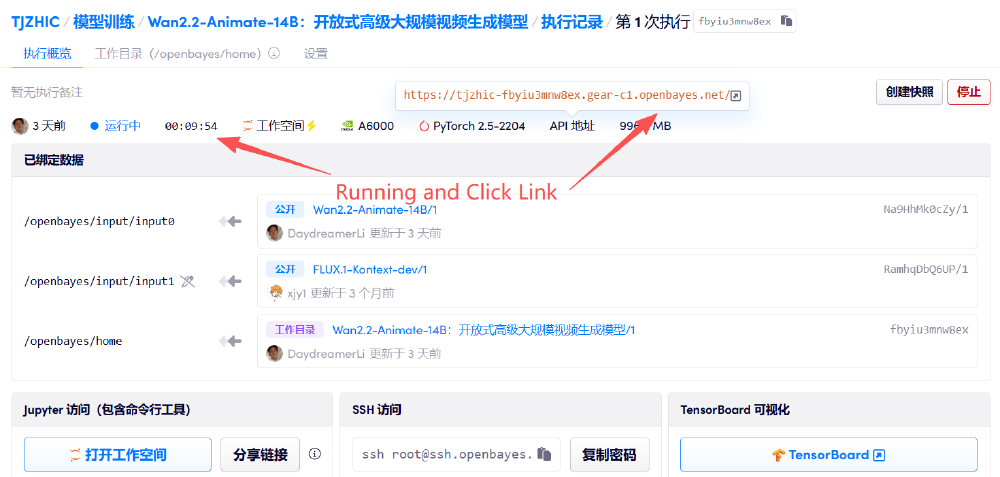

此截图展示了模型运行时的监控界面,清晰显示任务执行时长、资源占用情况及多种访问接口。通过Jupyter与SSH访问功能,开发者可深入调试模型参数,而TensorBoard可视化工具则为性能优化提供了数据支持。这一部署方案使独立创作者也能负担专业级动画制作。

行业影响:开源生态重塑内容创作格局

Wan2.2-Animate-14B的开源发布正在引发连锁反应,推动视频生成技术从"少数人的专利"向"大众创作工具"转变。在影视制作领域,独立工作室已利用该模型将概念设计图快速转化为动态预览,前期创意验证成本降低70%;游戏开发中,角色动作捕捉流程被简化为"拍摄参考视频-生成游戏动画"两步,制作周期缩短50%。

更深远的影响在于开源生态的形成。项目发布仅一个月,社区已衍生出丰富的第三方工具:DiffSynth-Studio实现了低显存分层卸载和FP8量化,使模型能在消费级显卡上流畅运行;Kijai's ComfyUI插件则提供了可视化工作流,让非技术用户也能轻松调整参数获得专业效果。这种开源协作模式正在加速视频生成技术的创新迭代。

如上图所示,阿里巴巴Wan官方推文通过左侧参考人物照片与右侧传统服饰角色动画对比,直观展示了Wan2.2-Animate模型"图生动作"的核心能力,配文"Brought to Life!"强调了角色动画生成效果。这一案例充分体现了模型在实际应用中的潜力,为内容创作者提供了全新的创作可能性。

快速开始使用Wan2.2-Animate-14B

环境准备

- 硬件:推荐RTX 4090(24GB显存)或更高配置GPU

- 软件:Python 3.10+,PyTorch 2.4.0+,FlashAttention3

安装步骤

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/Wan-AI/Wan2.2-Animate-14B

cd Wan2.2-Animate-14B

# 安装依赖

pip install -r requirements.txt

pip install -r requirements_animate.txt

# 下载模型(国内镜像)

modelscope download Wan-AI/Wan2.2-Animate-14B --local_dir ./models

运行示例

Animation模式(单GPU)

python generate.py --task animate-14B \

--ckpt_dir ./models \

--src_root_path ./examples/animate/process_results \

--refert_num 1 \

--base_seed 1234

参数优化建议

- 复杂动作场景:设置

--num_inference_steps 50提升细节 - 光影敏感场景:启用

--use_relighting_lora增强环境融合 - 批量处理:添加

--batch_size 4与--offload_model True优化显存

结论与前瞻

Wan2.2-Animate-14B的发布标志着AI视频生成技术进入"质量与效率并重"的新阶段。通过MoE架构创新,模型在保持开源可访问性的同时,实现了媲美闭源产品的生成质量,为内容创作行业带来了真正的技术普及。

随着社区优化(如CFG-Zero算法将质量提升8%),Wan2.2-Animate-14B正推动动画生成技术向三大方向演进:垂直领域定制、实时交互创作和多模态融合。对于创作者而言,现在正是探索这一工具的最佳时机,无需巨额投资,只需一台消费级GPU和创意灵感,就能将静态图像转化为令人惊艳的动态内容。

动画制作的普惠时代,已随着这次开源正式到来。立即尝试Wan2.2-Animate-14B,释放你的创作潜能!别忘了点赞、收藏本文,关注我们获取更多AI创作工具的实用指南和最新动态。

【免费下载链接】Wan2.2-Animate-14B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考