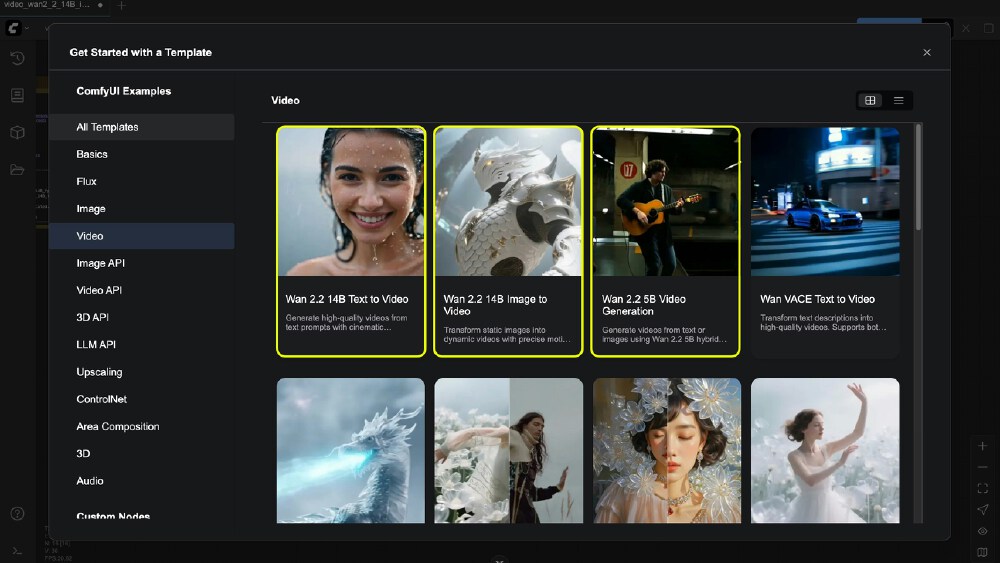

阿里云Wan2.2视频生成模型深度解析:ComfyUI落地实践与行业影响

【免费下载链接】WanVideo_comfy

导语

阿里云通义万相团队推出的Wan2.2视频生成模型,通过创新的MoE架构和多模态交互能力,将AI视频创作推向分钟级长视频生成新阶段,在ComfyUI生态中已形成完整工作流支持。

行业现状:AI视频生成的技术突破点

2025年视频生成领域呈现"效率与质量双突破"的竞争格局。OpenAI Sora 2主打电影级视觉效果但依赖云端算力,快手可灵侧重移动端轻量化,而阿里云Wan2.2则通过混合专家模型(MoE) 实现技术平衡——14B参数量模型同时处理高噪声和低噪声阶段,在A100 40G环境下可生成720P@24fps视频,推理速度较上一代提升3倍。

如上图所示,左侧为传统单一路径扩散模型架构,右侧为Wan2.2创新的双专家协同架构。这一设计使模型在保持14B参数量的同时,实现高噪声细节生成与低噪声运动优化的分离处理,为专业创作者提供了兼顾质量与效率的新选择。

核心亮点:从技术参数到创作体验

1. 多模态生成能力跃升

- 文本控制精度:支持中英文混合提示词,如"赛博朋克风格的上海外滩,雨后夜晚,霓虹灯光反射在湿漉漉的地面"可生成具有电影级镜头语言的视频片段

- 图像引导创新:无需CLIP-H视觉特征提取,直接通过VAE编码参考图,首帧相似度提升至89%

- 首尾帧控制:行业首创FLF2V(First-Last Frame to Video)工作流,用户上传起始帧和结束帧即可生成连贯过渡视频

2. 性能与效率优化

Wan2.2提供5B/14B双版本模型,满足不同算力需求:

- 5B混合模型:单一模型支持T2V/I2V双任务,8GB显存即可运行,适合个人创作者

- 14B专业模型:采用FP8量化技术,显存占用降低40%,配合LightX2V加速插件可实现6步快速生成

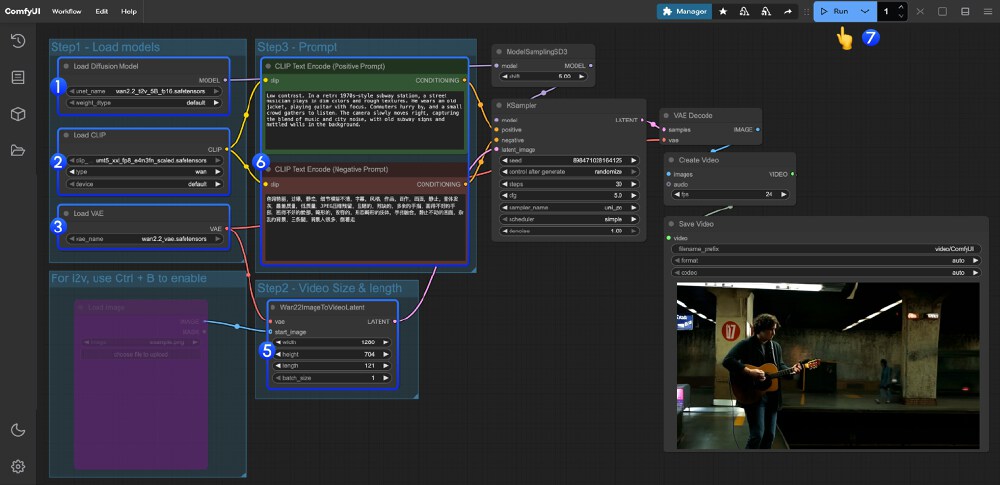

该截图展示了ComfyUI中Wan2.2 14B I2V工作流的完整配置,包含模型加载、提示词设置、视频参数调节等节点。从图中可以看出,通过模块化设计,用户无需代码知识即可完成专业级视频生成配置,这极大降低了AI视频创作的技术门槛。

行业影响:内容生产的范式转移

1. 创作流程重构

传统视频制作需要经历脚本-拍摄-剪辑-特效等多环节,而Wan2.2支持:

- 文本直接生成:营销团队可将产品描述转化为30秒宣传视频

- 图像动态化:设计师上传静态插画即可生成角色动画

- 长视频扩展:通过层次化帧压缩技术实现73帧历史参考,生成5分钟以上连贯内容

2. 开源生态协同

Wan2.2基于Apache2.0协议开源,已形成活跃社区生态:

- 模型仓库:HuggingFace上提供5B/14B各版本模型下载,累计下载量超10万次

- 工具链支持:ComfyUI-WanVideoWrapper插件实现一键部署,社区贡献的优化工作流达23种

- 硬件适配:已验证在A100、RTX 4090、AMD MI50等设备上的运行稳定性

结论与前瞻

Wan2.2通过"高精度控制+高效率生成"的技术组合,正在重塑AI视频创作的技术标准。随着14B模型推理时间压缩至2分钟/分钟视频,以及社区持续贡献的优化工具,预计2026年将实现"文本-视频-编辑"全流程AI辅助。对于内容创作者,建议优先尝试5B模型快速验证创意,专业团队可部署14B版本结合首帧控制功能实现高质量生产。

未来值得关注的方向包括:多角色一致性生成、物理规律模拟优化以及与3D建模工具的协同,这些突破将进一步模糊虚拟与现实内容的界限。

【免费下载链接】WanVideo_comfy

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考