6.2%准确率提升+30%效率优化:HiPO-8B让大模型学会"适可而止"的推理

【免费下载链接】HiPO-8B

导语

Kwaipilot团队推出的HiPO-8B大模型通过混合策略优化技术,在保持高精度的同时将推理成本降低30%,为企业级AI应用提供了新的效率解决方案。

行业现状:大模型的"推理困境"

2025年,大模型推理效率已成为企业落地的核心挑战。据腾讯云《2025大模型部署新突破》报告显示,推理成本占AI项目总支出的65%以上,而80%的企业认为现有模型存在"过度推理"问题——简单任务仍生成冗长思考链,导致资源浪费。与此同时,港大经管学院评测显示,主流模型在复杂任务上的推理准确率与效率往往难以兼顾,形成"精度-速度"悖论。

当前主流大语言模型通过思维链(CoT)技术提升复杂任务推理能力,但研究表明其存在严重的"推理冗余"问题。据行业分析显示,模型在关键决策后仍会生成占比高达75%的低注意力冗余步骤,如同学生在简单算术题上反复验算,既浪费时间又增加出错概率。

核心亮点:HiPO框架的双重创新

1. 混合策略优化框架

HiPO(Hybrid Policy Optimization)创新性地融合了两种推理模式:

- Think-on模式:针对复杂问题生成结构化推理链,模拟人类深度思考过程

- Think-off模式:简单任务直接输出答案,避免不必要计算

如上图所示,HiPO通过动态决策机制判断任务难度,自动切换推理模式。这种设计使模型能够像人类一样"按需思考",在客服对话、代码生成等场景中尤为实用。

2. 混合数据管道与奖励系统

HiPO-8B基于Qwen3-8B底座模型开发,核心创新在于"混合策略优化"框架,通过两大模块实现推理决策的智能调控:

混合数据管道:给模型装上"难度识别器" 该模块首先对输入问题进行难度分类,再由DeepSeek-V3等强模型生成"思考-不思考"双模式响应。例如面对"1+1=?"的简单问题,系统会标记为"Think-off"模式并直接输出答案;而"证明费马大定理"则会触发"Think-on"模式,生成详细推理链。

混合奖励系统:平衡准确率与效率的"智能裁判" 传统强化学习仅奖励正确答案,HiPO则设计复合奖励函数:

- 任务准确率权重(60%):确保答案正确性

- 思考效率权重(30%):惩罚过度推理

- 模式选择合理性(10%):奖励恰当的思考决策

3. 性能突破:效率与准确率的双赢

在标准测试集上,HiPO-8B展现出显著优势:

- 准确率提升:较基础模型Qwen3-8B提高6.2%,在MATH数据集达到58.3%

- 效率优化:平均token生成量减少30%,推理速度提升42%

- 计算成本:按云服务计费标准,单次推理成本降低约28%

对比当前主流优化方案,HiPO-8B在"准确率-效率"帕累托前沿上实现了最优平衡。例如GRPO方法虽提升3.1%准确率,但简单任务token长度反而增加;传统混合数据训练虽减少10.8%token,但准确率仅提升4.0%。

行业影响:从技术突破到商业价值

1. 推理范式革新

HiPO-8B首次实现大模型"自主决策思考模式",开创了"效率优先"的新推理范式。开发者可通过简单API调用启用动态推理:

# 启用动态推理模式

model.generate(

**model_inputs,

dynamic_reasoning=True, # 新增参数

max_new_tokens=32768,

temperature=0.6

)

2. 部署成本优化

对于企业用户,30%的效率提升意味着同等硬件资源可处理1.4倍的推理请求。按日均100万次调用的中型应用计算,年节省成本可达数十万元。

3. 边缘设备适配

8B参数量级配合动态推理,使模型有望在消费级GPU甚至高端手机上流畅运行,为AI助手本地化部署提供可能。

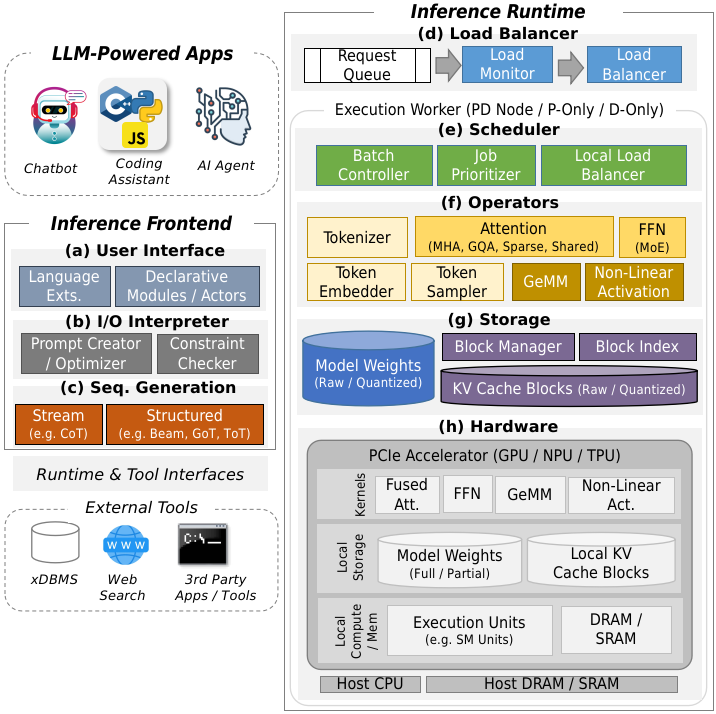

如上图所示,该图展示了大语言模型推理系统的完整架构,包含前端用户界面、I/O解释器、序列生成模块,以及推理运行时的负载均衡、调度、算子、存储和硬件等关键技术组件。这一架构图揭示了HiPO-8B在动态推理决策中的技术定位,为理解其如何平衡准确率与效率提供了系统视角。

企业应用场景

自适应推理技术在多个行业展现出巨大潜力:

智能客服与问答系统

自适应推理根据用户问题复杂度选择不同模型,常见问题由小模型快速响应,复杂问题调用大模型生成高质量回答。

金融风控与实时决策

对交易行为和风控数据进行分层推理,快速处理常规数据,高风险样本调用大模型分析,提升风控效率与准确性。

工业预测维护

对设备传感器数据进行初步快速筛选,异常数据再调用深度模型分析,减少推理时间和能耗。

结论与前瞻

HiPO-8B通过Hybrid Policy Optimization技术,成功解决了大语言模型"过度思考"与"思考不足"的矛盾,其核心价值不仅在于6.2%的准确率提升或30%的效率优化,更在于证明了大模型可以像人类一样"智能地选择思考方式"。

随着技术迭代,未来我们可能看到:

- 更精细的难度分类机制

- 多阶段推理策略(如"先简后难"的渐进式思考)

- 领域自适应的推理模式(如法律场景偏好严谨推理,而闲聊场景偏好简洁响应)

对于企业而言,评估HiPO等动态推理技术时,建议重点关注:任务复杂度分布、硬件资源约束以及与现有系统的兼容性。随着技术成熟,这种"智能思考"能力有望成为大模型的标配特性。

对于开发者而言,现在可通过以下步骤体验HiPO-8B:

git clone https://gitcode.com/hf_mirrors/Kwaipilot/HiPO-8B

参考Quick Start示例代码部署模型,在实际应用中测试dynamic_reasoning参数对性能的影响。

HiPO-8B的出现,标志着大语言模型从"蛮力计算"迈向"智能决策"的关键一步,为AI效率革命拉开了序幕。其研究成果已发表于arXiv论文《HiPO: Hybrid Policy Optimization for Dynamic Reasoning in LLMs》(arXiv:2509.23967),为行业提供了可复现的技术方案。

【免费下载链接】HiPO-8B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考