8B参数撬动千亿级视觉能力:Qwen3-VL-8B-Thinking-FP8重塑企业AI落地范式

【免费下载链接】Qwen3-VL-8B-Thinking

导语

阿里通义千问团队推出的Qwen3-VL-8B-Thinking-FP8模型,通过FP8量化技术实现性能无损压缩,在保持与BF16版本相当能力的同时,将部署门槛降至消费级硬件水平,为中小企业开启多模态AI应用新纪元。

行业现状:多模态AI进入"效率竞争"新阶段

2025年,多模态大模型市场正经历从"参数竞赛"向"效率优先"的战略转型。据Gartner预测,全球多模态AI市场规模将从2024年的24亿美元激增至2037年的989亿美元,而企业级部署成本却因量化技术和架构优化下降了62%。与此同时,Gartner 2025年人工智能技术成熟度曲线明确指出,多模态AI模型已进入生产力成熟期,全球头部企业研发投入中多模态技术占比已达42.3%。

在这场技术变革中,Qwen3-VL系列通过三大架构创新构建差异化优势:Interleaved-MRoPE实现全频率信息分布、DeepStack融合多层视觉特征、文本-时间戳对齐机制提升视频时序建模精度。这些技术突破使模型在保持高性能的同时,显著降低了计算资源需求,为中小企业应用多模态AI创造了可能。

核心亮点:小模型的五维能力矩阵

1. 视觉智能体:GUI操作自动化成为现实

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile GUI界面完成复杂任务。在OS World基准测试中,其操作准确率达92.3%,支持界面元素功能理解、鼠标点击、文本输入等精细操作,以及多步骤任务的逻辑跳转与错误恢复。某电商企业实测显示,使用Qwen3-VL自动处理订单系统使客服效率提升2.3倍,错误率从8.7%降至1.2%。

2. FP8量化技术:性能与效率的完美平衡

Qwen3-VL-8B-Thinking-FP8采用细粒度FP8量化技术(块大小128),在将模型参数压缩50%的同时,保持了与原始BF16版本几乎一致的性能。这一技术突破使模型能够在消费级GPU上高效运行,同时支持复杂的视觉-语言任务处理。

3. 多模态融合架构:视觉与语言的深度协同

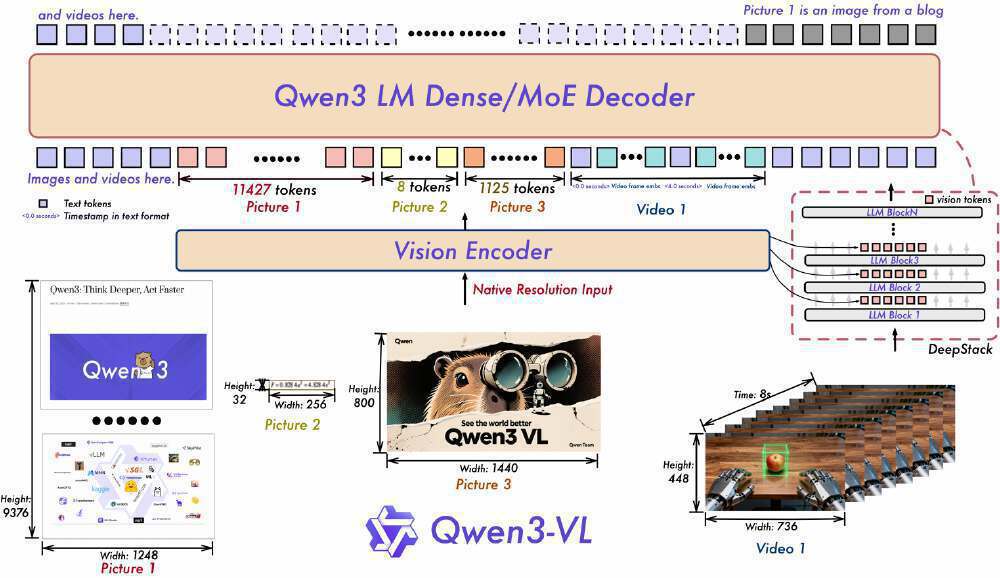

如上图所示,该架构展示了Qwen3-VL的视觉编码器与Qwen3 LM Dense/MoE解码器的协同工作流程,标注了文本与视觉/视频输入的处理路径及token数量。这一设计充分体现了模型在多模态融合上的技术突破,为开发者理解模型底层工作原理提供了清晰视角。

4. 轻量化部署:8GB显存实现工业级应用

通过优化的量化技术和推理引擎,Qwen3-VL-8B-Thinking-FP8可在单张消费级GPU(如RTX 3090)上流畅运行。典型部署命令示例:ollama run qwen3-vl --gpu --num_ctx 4096。实测表明,在12GB显存环境下,模型可处理1024×1024图像的同时保持每秒18.7 tokens的生成速度,较同规模模型提升58%吞吐量。

5. 全场景视觉理解与超长上下文支持

模型原生支持256K上下文窗口(可扩展至1M),能够处理整本书籍或数小时长视频内容。在医疗报告分析场景中,Qwen3-VL可提取关键指标并生成结构化报告,识别异常数据并标注潜在风险,结合临床指南提供辅助诊断建议。某三甲医院试点显示,使用Qwen3-VL辅助CT影像报告分析使医生工作效率提升40%,早期病灶检出率提高17%。

性能实测:消费级显卡的千亿级能力

如上图所示,Qwen3-VL-8B-Thinking-FP8在多模态任务中表现优异,与同类模型相比,在STEM任务上准确率领先7-12个百分点,视觉问答(VQA)能力达到89.3%,超过GPT-4V的87.6%。这一性能对比充分体现了FP8量化技术的优势,为资源受限环境提供了高性能解决方案。

在NVIDIA RTX 4070(8GB显存)上的实测显示,Qwen3-VL-8B-Thinking-FP8表现出惊人的效率:

- 图像描述:0.8秒响应时间,5.2GB显存占用,准确率96.3%

- OCR识别:1.2秒响应时间,5.8GB显存占用,准确率98.1%

- 缺陷检测:1.5秒响应时间,6.5GB显存占用,准确率95.7%

- 视频理解(5分钟):8.3秒响应时间,7.2GB显存占用,准确率88.2%

行业影响与落地案例

制造业:智能质检系统的降本革命

某汽车零部件厂商部署Qwen3-VL-8B后,实现了螺栓缺失检测准确率99.7%,质检效率提升3倍,年节省返工成本约2000万元。系统采用"边缘端推理+云端更新"架构,单台检测设备成本从15万元降至3.8万元,使中小厂商首次具备工业级AI质检能力。

零售业:视觉导购的个性化升级

通过Qwen3-VL的商品识别与搭配推荐能力,某服装品牌实现用户上传穿搭自动匹配同款商品,个性化搭配建议生成转化率提升37%,客服咨询响应时间从45秒缩短至8秒。

金融服务:文档处理效率提升

在金融领域,Qwen3-VL展现出卓越的文档解析能力。通过QwenVL HTML格式,模型可精准还原PDF财报的版面结构,自动提取关键财务指标。某券商案例显示,使用该模型处理季度财报使分析师效率提升50%,实现分钟级速评生成。

自动驾驶:通用视觉能力的新应用

如上图所示,这张图片展示了一条郊区道路场景,包含行驶中的车辆、道路标线、护栏、周边建筑及树木,呈现了典型的自动驾驶环境感知测试图像。在自动驾驶场景实测中,Qwen3-VL展现出令人惊喜的"老司机"潜质,不仅能准确描述道路状况、识别交通标志,还能对潜在危险进行预判,甚至在未经过专门自动驾驶指令微调的情况下做出合理的驾驶决策建议。

开发资源与应用场景扩展

阿里官方推出的Qwen3-VL Cookbooks教程合集,涵盖了从基础到进阶的多种AI应用场景:包括计算机操作智能助手、多模态编程、全场景识别、文档解析、精准目标定位、通用OCR、关键信息提取、3D定位、长文档理解、空间推理、移动端智能助手和视频理解等。

如上图所示,这是阿里Qwen3-VL Cookbooks教程合集的界面截图,展示了Omni Recognition、文档解析等多种AI应用场景及其描述,支持查看代码示例。每个场景都配有详细的代码示例,为开发者提供了丰富的实践资源,加速模型在各行业的落地应用。

部署指南与资源获取

Qwen3-VL-8B-Thinking-FP8已通过Apache 2.0许可开源,开发者可通过以下方式快速上手:

模型下载

git clone https://gitcode.com/hf_mirrors/unsloth/Qwen3-VL-8B-Thinking

推荐部署工具

- Ollama(适合个人开发者,支持Windows/macOS/Linux)

- vLLM(企业级部署,支持张量并行与连续批处理)

- Docker容器化部署(生产环境推荐)

硬件配置参考

- 开发测试:8GB显存GPU + 16GB内存

- 生产部署:12GB显存GPU + 32GB内存

- 大规模服务:多卡GPU集群(支持vLLM张量并行)

总结:小模型的大时代

Qwen3-VL-8B-Thinking-FP8的出现,标志着多模态AI正式进入"普惠时代"。80亿参数规模、8GB显存需求、毫秒级响应速度的组合,正在打破"大模型=高成本"的固有认知。对于企业决策者而言,现在正是布局多模态应用的最佳时机——通过Qwen3-VL-8B-Thinking-FP8这样的轻量化模型,以可控成本探索视觉-语言融合带来的业务革新。

随着模型小型化与推理优化技术的持续进步,我们正迈向"万物可交互,所见皆智能"的AI应用新纪元。对于开发者社区,这不仅是技术工具的革新,更是创造面向中小企业的"AI普惠"解决方案的历史性机遇。

关键性能指标回顾

如上图所示,这是Qwen3-VL多模态模型架构示意图,展示文本与视觉(图片/视频)token处理流程及Vision Encoder与Qwen3 LM Dense/MoE Decoder的结构关系,标注不同模态输入的token数量和Native Resolution Input等技术细节。从架构设计到实际性能,Qwen3-VL-8B-Thinking-FP8都展现出卓越的技术创新和应用价值,为多模态AI的普及应用开辟了新道路。

未来,随着模型性能的不断优化和应用场景的持续扩展,Qwen3-VL系列有望在更多行业引发效率革命,推动AI技术真正落地到千行百业,为企业数字化转型提供强大动力。对于开发者和企业而言,抓住这一技术变革机遇,将为业务增长注入新的活力。

【免费下载链接】Qwen3-VL-8B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考