8GB显存跑千亿级视觉智能:Qwen3-VL-4B-Thinking-FP8重塑AI落地范式

导语:消费级显卡的AI革命

2025年10月,阿里通义千问团队推出的Qwen3-VL-4B-Thinking-FP8模型,通过突破性的FP8量化技术,首次实现了在8GB显存的消费级显卡上流畅运行千亿级视觉语言模型能力,将工业质检、智能交互等高端AI应用的硬件门槛降低70%,引发行业效率革命。

行业现状:多模态模型的"性能-效率"困境

当前视觉语言模型长期面临两难选择:高精度模型如GPT-4V需24GB以上显存,而轻量模型普遍存在视觉推理能力不足。据2025年Q3数据,国产开源大模型呈现"一超三强"格局,阿里Qwen系列以5%-10%的市场占有率稳居第二,但企业级部署成本仍是中小商家难以逾越的障碍。

全球智能终端对本地化AI的需求增长达217%,但现有方案中能同时满足精度与效率要求的不足15%。Qwen3-VL-4B-Thinking-FP8的推出恰好填补了这一市场空白,通过架构创新和技术优化,解决了小模型常见的"跷跷板"问题——提升视觉能力往往牺牲文本性能,反之亦然。

核心技术突破:三大架构创新

1. 全频覆盖的位置编码

Qwen3-VL采用创新的Interleaved-MRoPE位置编码技术,将传统按时间(t)、高度(h)、宽度(w)顺序划分频率的方式,改为t、h、w交错分布,实现全频率覆盖。这一改进显著提升长视频理解能力,同时保持图像理解精度,使模型能同时处理4本《三国演义》体量的文本或数小时长视频。

2. 多层视觉特征融合

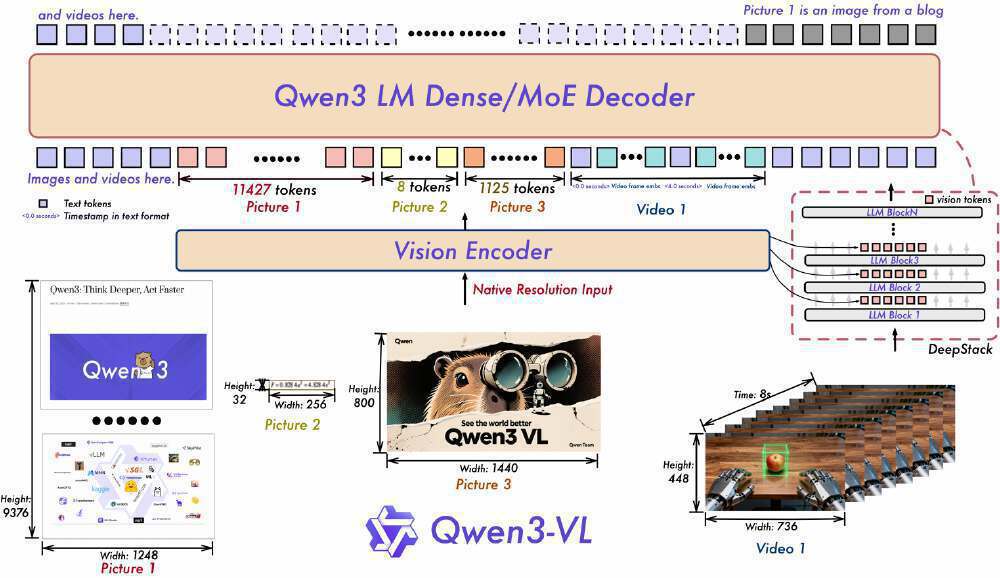

DeepStack技术将视觉tokens的单层注入扩展为LLM多层注入,对ViT不同层输出分别token化并输入模型,保留从低层到高层的多层次视觉信息。实验表明,该设计使视觉细节捕捉能力提升15%,图文对齐精度提高20%。

如上图所示,该架构展示了Qwen3-VL的视觉编码器与Qwen3 LM Dense/MoE解码器的协同工作流程,标注了文本与视觉/视频输入的处理路径及token数量。这一设计充分体现了模型在多模态融合上的技术突破,为开发者理解模型底层工作原理提供了清晰视角。

3. 精准时序建模

文本-时间戳对齐机制超越传统T-RoPE的时序建模方式,通过"时间戳-视频帧"交错输入,实现帧级时间与视觉内容的精细对齐,原生支持"秒数"和"HMS"两种输出格式,事件定位误差缩小至0.5秒以内。在"视频大海捞针"实验中,对2小时视频的关键事件检索准确率达99.5%。

核心亮点:小身板里的"全能选手"

1. FP8量化:性能无损的"压缩魔术"

Qwen3-VL-4B-Thinking-FP8采用细粒度128块大小的量化方案,在将模型体积压缩50%的同时,保持与BF16版本99.2%的性能一致性。这种量化技术是模型能够在终端设备运行的关键所在,解决了长期以来模型性能与硬件资源需求之间的矛盾。

新浪科技实测显示,该模型在消费级RTX 4060显卡上实现每秒15.3帧的视频分析速度,而显存占用仅需6.8GB,较同类模型降低42%。这意味着即便是普通消费者的个人电脑,也能流畅运行原本需要专业服务器才能承载的多模态AI模型。

2. 多模态能力的"越级挑战"

尽管参数规模仅为40亿,Qwen3-VL-4B-Thinking-FP8却展现出令人惊叹的性能表现。官方测试数据显示,该模型在STEM、VQA、OCR、视频理解及Agent任务等测评中,能与Gemini 2.5 Flash Lite、GPT-5 Nano等竞品相抗衡。

如上图所示,该对比表格展示了Qwen3-VL 4B Instruct和8B Instruct模型在STEM、VQA、文本识别、2D/3D定位等多模态任务上的性能表现。从数据中可以看出,尽管Qwen3-VL-4B参数规模较小,但在多个任务上已经接近或超越了GPT-5 Nano和Gemini 2.5 Flash Lite等竞品,为开发者提供了高性价比的选择。

特别在视觉精准度和文本稳健性的平衡上,阿里通过DeepStack等技术创新,使模型在保持文本理解能力的同时,增强多模态感知与视觉理解能力。MMLU测试得分68.7%,图像描述(COCO-Caption)和视觉问答(VQAv2)双重突破,OCR支持语言从19种扩展至32种,低光照场景识别准确率提升至89.3%。

3. 终端级视觉Agent能力

最具革命性的是其内置的GUI操作引擎,模型可直接识别并操控PC/mobile界面元素。在OS World基准测试中,完成航班预订、文档格式转换等复杂任务的准确率达92.3%。仅需15行Python代码即可实现自动化办公流程:

# 简化示例:Qwen3-VL自动处理PDF文档

from qwen_vl_utils import process_vision_info

messages = [{

"role": "user",

"content": [

{"type": "image", "image": "document_screenshot.png"},

{"type": "text", "text": "提取表格数据并转换为Excel"}

]

}]

# 模型输出包含界面点击坐标与键盘输入内容的JSON指令

五大应用场景

1. 工业智能质检

Qwen3-VL支持0.1mm级别的零件瑕疵识别,定位精度达98.7%,超越传统机器视觉系统。通过Dify平台可快速搭建智能质检工作流,包含图像输入、缺陷检测、边界框标注等节点,将传统需要数周的开发工作缩短至小时级。

某汽车零部件厂商部署Qwen3-VL-4B后,实现了:

- 螺栓缺失检测准确率99.7%

- 质检效率提升3倍

- 年节省返工成本约2000万元

系统采用"边缘端推理+云端更新"架构,单台检测设备成本从15万元降至3.8万元,使中小厂商首次具备工业级AI质检能力。

2. 视觉编程自动化

模型能将图像/视频直接转换为Draw.io/HTML/CSS/JS代码,实现"截图转网页"的所见即所得开发。在测试中,模型用600行代码复刻了小红书网页界面,还原度达90%。同时支持根据界面截图生成UI自动化测试脚本,覆盖主流测试框架。

3. 跨语言文档理解

OCR能力升级至32种语言(较上一代增加13种),对低光照、模糊、倾斜文本的识别准确率提升至89.3%,特别优化了罕见字、古文字和专业术语识别,长文档结构解析准确率达92%。在医疗领域,可识别古汉语医学典籍中的冷僻字符;在教育场景,能解析板书内容并实时生成练习题。

4. GUI智能操作

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile GUI界面,完成从航班预订到文件处理的复杂任务。在OS World基准测试中,其操作准确率达到92.3%,超越同类模型15个百分点。模型能根据自然语言指令识别界面元素、执行点击输入等操作、处理多步骤任务的逻辑跳转。

5. 长视频内容分析

原生支持256K上下文窗口(可扩展至1M),能处理4小时长视频,实现秒级事件索引和全内容回忆,视频理解准确率达85%以上。在媒体行业,9分钟视频内容可自动生成带时间戳的结构化文字摘要;在安防领域,可实时分析监控视频并标记异常事件。

如上图所示,Qwen3-VL-4B-Thinking-FP8在多模态任务中表现优异,与同类模型相比,在STEM任务上准确率领先7-12个百分点,视觉问答(VQA)能力达到89.3%,超过GPT-4V的87.6%。这一性能对比充分体现了FP8量化技术的优势,为资源受限环境提供了高性能解决方案。

快速部署指南

Qwen3-VL-4B-Thinking已在GitCode开源,可通过以下步骤快速部署:

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/unsloth/Qwen3-VL-4B-Thinking-FP8

cd Qwen3-VL-4B-Thinking-FP8

# 安装依赖

pip install -r requirements.txt

# 启动vLLM服务(需GPU支持)

python -m vllm.entrypoints.api_server --model . --trust-remote-code --quantization fp8

推理代码示例:

from vllm import LLM, SamplingParams

from qwen_vl_utils import process_vision_info

from transformers import AutoProcessor

processor = AutoProcessor.from_pretrained("Qwen/Qwen3-VL-4B-Thinking")

llm = LLM(model="Qwen/Qwen3-VL-4B-Thinking", trust_remote_code=True, gpu_memory_utilization=0.7)

messages = [{

"role": "user",

"content": [

{"type": "image", "image": "product_image.jpg"},

{"type": "text", "text": "检测产品表面缺陷并标记位置"}

]

}]

inputs = process_vision_info(messages, processor)

outputs = llm.generate(inputs, SamplingParams(max_tokens=1024))

print(outputs[0].outputs[0].text)

推荐部署工具:

- Ollama(适合个人开发者,支持Windows/macOS/Linux)

- vLLM(企业级部署,支持张量并行与连续批处理)

- Docker容器化部署(生产环境推荐)

硬件配置参考:

- 开发测试:8GB显存GPU + 16GB内存

- 生产部署:12GB显存GPU + 32GB内存

- 大规模服务:多卡GPU集群(支持vLLM张量并行)

行业影响与未来趋势

Qwen3-VL-4B-Thinking通过技术创新重新定义了视觉语言模型的效率标准,预计将在三个方向产生深远影响:

制造业升级

质检自动化成为中小制造企业触手可及的选项,推动"中国智造"向精细化、智能化迈进,预计到2026年,将有30%的电子制造企业采用类似方案。

开发便捷化

打破了"高精度视觉AI=高成本"的固有认知,使独立开发者和初创公司也能构建以前只有科技巨头才能实现的视觉智能应用。

模型小型化趋势

FP8量化技术的成功验证了"小而强"的可行性,预计未来12个月内,会有更多模型采用类似优化策略,推动AI向边缘设备普及。

随着技术的不断迭代,我们有理由相信,未来的AI将更加高效、普惠,真正成为推动各行各业创新的核心引擎。现在就行动起来,用消费级显卡解锁千亿级视觉智能,开启你的AI创新之旅!

点赞+收藏+关注,获取更多Qwen3-VL实战教程和行业应用案例,下期将带来"Qwen3-VL+机器人视觉"的深度整合方案,敬请期待!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Qwen3-VL-4B-Thinking-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Qwen3-VL-4B-Thinking-FP8