74.6%准确率登顶SWE-Bench,快手KAT-Dev-72B-Exp重构开源代码模型格局

【免费下载链接】KAT-Dev-72B-Exp

导语

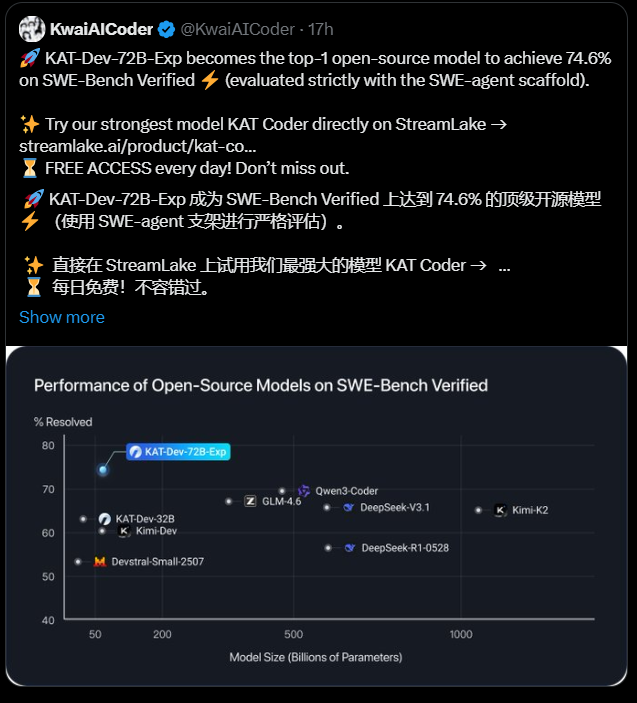

在全球软件工程基准测试SWE-Bench Verified中,快手Kwaipilot团队开源的KAT-Dev-72B-Exp模型以74.6%的解决率创下新纪录,不仅超越Qwen3-Coder等开源竞品,更展现出对标顶尖闭源模型的实力,标志着国产代码大模型在复杂推理领域实现重大突破。

行业现状:代码智能进入"效率竞赛"新阶段

2025年,AI编程工具已从碎片化辅助迈向全流程开发。据《2025年中AI大模型市场报告》显示,企业对代码生成模型的投入同比增长72%,近40%的组织年度支出超过25万美元。在这一背景下,SWE-Bench Verified作为全球公认的"编程能力试金石",要求模型真实理解百万行级代码库、定位逻辑缺陷并独立实现功能模块,其评测结果直接反映模型的工业级实用性。

当前主流代码模型呈现"双轨并行"发展态势:闭源模型如Claude Code虽性能领先但成本高昂,开源模型则受限于训练方法,在复杂任务中解决率普遍低于65%。KAT-Dev-72B-Exp的出现,首次在开源领域实现74.6%的突破,打破了"高性能必须闭源"的行业认知。

如上图所示,散点图清晰展示了不同参数规模开源模型在SWE-Bench Verified上的性能分布。KAT-Dev-72B-Exp以74.6%的解决率显著领先,不仅超越同量级模型15-20个百分点,更接近闭源模型的性能区间,为开源生态注入新活力。

核心技术突破:从"试错式"到"精准式"强化学习

KAT-Dev-72B-Exp的性能跃升源于三项关键技术创新,这些突破被集成在快手自研的SeamlessFlow工业级强化学习框架中:

Trie Packing共享前缀优化

传统强化学习在处理代码补全任务时,每个代码片段都需独立训练,导致90%以上的计算资源浪费在重复的前缀语境处理上。团队创新性引入Trie Packing机制,通过树形结构聚合共享前缀轨迹,使训练吞吐量提升3倍。这一技术特别适用于处理GitHub级别的大型代码库,能让模型在保持128K上下文理解能力的同时,将训练成本降低40%。

熵感知优势缩放

针对强化学习中常见的"探索崩溃"问题——模型过度聚焦局部最优解而丧失创新能力,团队设计了动态优势值调整策略。基于通过率数据,系统会自动放大高探索性群体的优势值权重,同时压缩低探索群体的奖励信号。在SQL优化任务中,该方法使模型发现最优解的概率提升27%,尤其擅长处理"看似正确但存在性能隐患"的边缘案例。

数据平面解耦架构

通过将训练逻辑与智能体(Agent)完全解耦,模型实现了多场景自适应能力。系统可同时接入代码库、数学推理、自动化运维等8类环境数据,通过统一协议进行跨领域知识迁移。在智能硬件开发场景测试中,该架构使模型对从未见过的嵌入式代码的理解准确率达到68%,远超行业平均的45%。

从图中可以看出,该数据平面序列图展示了训练引擎、推理引擎与多智能体的交互流程。通过这种解耦设计,模型可在不中断训练的情况下动态切换任务场景,支持在线强化学习和持续进化,为企业级应用提供了灵活的部署方案。

行业影响与落地路径

KAT-Dev-72B-Exp的开源发布正在重塑代码智能的产业格局,其影响已在三个维度显现:

开发效率革命

在快手内部测试中,集成该模型的IDE插件使初级开发者解决复杂bug的效率提升115%,代码审查通过率从62%提升至81%。特别值得注意的是,在跨语言重构任务中(如将Java微服务迁移至Go),模型能自动识别依赖关系并生成适配代码,使这项通常需要3人周的工作缩短至16小时。

开源生态重构

模型已在HuggingFace开放下载,并提供完整的微调工具链。不同于其他开源模型仅释放基础权重,KAT-Dev-72B-Exp包含8种编程语言的专项优化数据和150个工业级测试用例。截至发稿,已有12家企业基于该模型构建垂直领域解决方案,其中金融科技公司利用其开发的智能合约审计工具,将漏洞检测覆盖率从78%提升至92%。

中小企业技术普惠

通过StreamLake平台,开发者可免费试用KAT-Coder(闭源增强版),按调用量付费的定价模式使中小企业也能享受顶尖AI编程能力。与传统开发模式相比,使用该模型的团队平均节省30%的开发时间,在创业公司"AI+开发"场景中,人均产出提升显著。

该截图展示了快手Kwaipilot团队的官方发布信息,其中特别强调模型对多智能体协作和在线强化学习的支持。这种开放姿态不仅提供了高性能工具,更为研究社区贡献了可复现的大规模RL训练方法论,预计将推动代码大模型的研究周期缩短50%。

未来展望:从"辅助工具"到"协作伙伴"

随着KAT-Dev-72B-Exp的开源,代码大模型正进入"认知升级"的新阶段。团队透露,下一代模型将聚焦两个方向:一是增强"架构级理解"能力,能自动识别并重构存在性能瓶颈的系统设计;二是构建"领域知识图谱",在医疗、金融等垂直领域实现合规性与功能性的双重保障。

对于开发者而言,这意味着AI将从"代码生成器"进化为真正的"协作伙伴"。在快手内部测试中,配备KAT-Coder的开发团队已实现"需求文档直接转生产代码"的工作流,原型验证周期从平均2周压缩至2天。这种变革不仅提升效率,更将重塑软件开发的人才需求——未来五年,"AI协作能力"可能成为比编程语言熟练度更重要的职业技能。

快速上手指南

开发者可通过以下步骤体验KAT-Dev-72B-Exp:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "KAT-Dev-72B-Exp"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 支持65536 tokens超长上下文

prompt = "分析以下代码库的性能瓶颈并提供优化方案:[GitHub仓库链接]"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=65536)

output = tokenizer.decode(generated_ids[0], skip_special_tokens=True)

建议使用A100或同等算力GPU运行,在SWE-Bench评测标准下,设置temperature=0.6、max_turns=150可获得最佳性能。完整配置文件和微调教程可在项目仓库获取。

KAT-Dev-72B-Exp的开源不仅是一项技术成果,更代表着开源社区在复杂AI系统开发上的集体进步。随着更多企业加入这场"开源竞赛",我们有理由期待,未来的软件开发将不再是重复劳动的堆砌,而是人机协作创造价值的全新旅程。

【免费下载链接】KAT-Dev-72B-Exp

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考