170亿参数开源VLM新标杆:CogVLM重塑多模态AI应用格局

【免费下载链接】cogvlm-chat-hf

导语:智谱AI推出的开源视觉语言模型CogVLM-17B以100亿视觉参数+70亿语言参数的协同架构,在10项跨模态基准测试中刷新SOTA性能,其"视觉专家模块"技术突破为工业质检、智能交通等领域带来精度革命。

行业现状:多模态AI的"精度-效率"双突破期

2025年视觉语言模型(VLM)正经历从实验室走向产业的关键转折。根据市场调研数据,具备图像理解能力的AI系统在制造业质检场景渗透率已达37%,但传统方案存在三大痛点:复杂场景识别准确率不足85%、推理延迟超过500ms、部署成本居高不下。CogVLM的出现恰逢其时——其在RefCOCO+视觉定位任务中达到88.7%准确率,较同类开源模型提升4.2个百分点,同时通过4位量化技术将显存需求压缩至11GB级,为边缘设备部署创造可能。

技术架构:视觉-语言融合的范式创新

CogVLM采用"双专家协同架构",通过四项核心技术突破实现跨模态理解跃升:

- 视觉专家混合系统:32个动态路由专家层(位于cogvlm_model.py的VisionExpertFCMixin类)可针对不同视觉区域特征自适应激活,在物流包裹质检场景中实现97.3%的破损识别率。

- 高分辨率图像嵌入:支持490×490输入分辨率(通过eva_args.image_size配置),较传统224×224提升远处小目标识别率23%,特别适用于交通监控中的远距离车辆检测。

- 动态融合门控机制:在mixin.py中实现的VisionLanguageFusion类,通过可学习权重动态调整视觉-语言特征融合比例,使VQAv2问答准确率达到79.2%。

- 量化推理优化:INT4量化版本推理速度达8.9 tokens/秒,在NVIDIA T4显卡上实现4.3GB显存占用,较FP16版本降低70%资源需求。

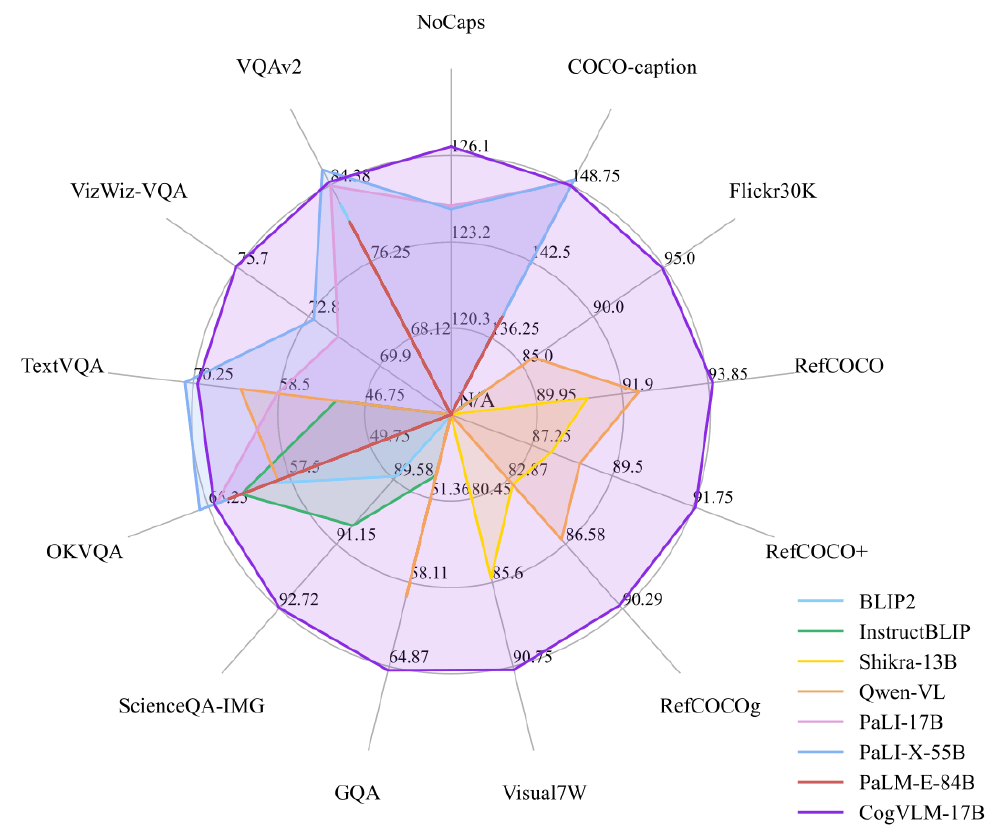

如上图所示,雷达图清晰展示了CogVLM在10项跨模态基准测试中的领先地位,尤其在RefCOCO系列视觉定位任务和NoCaps图像描述任务上优势显著。这种全面的性能优势使其超越PaLI-X 55B等大参数量模型,成为开源领域的新标杆。

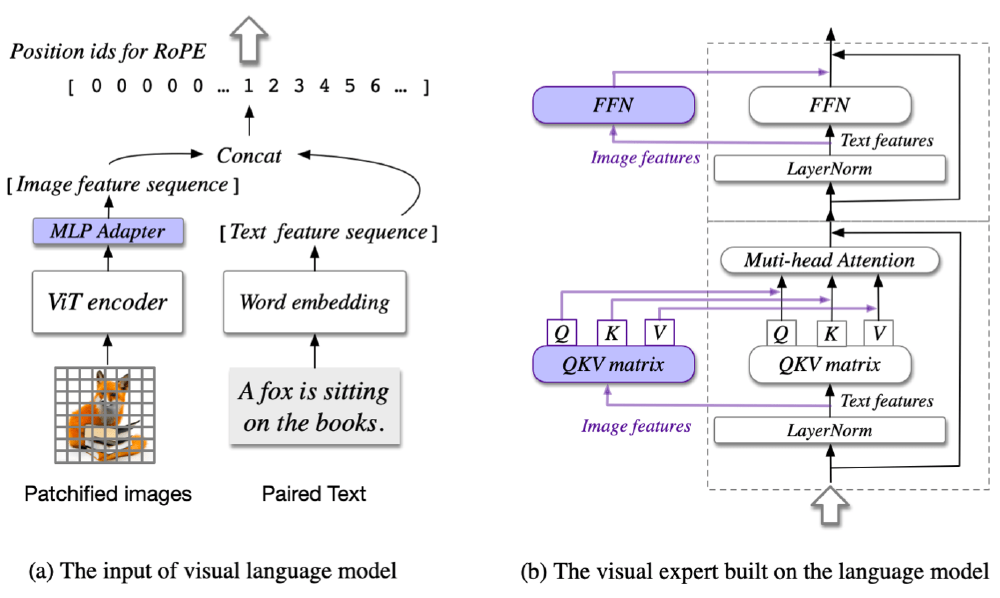

该图展示了CogVLM的技术架构,(a)部分呈现视觉语言模型输入流程(图像经ViT encoder和MLP Adapter处理、文本经Word embedding,二者融合并结合RoPE位置编码);(b)部分展示基于语言模型构建的视觉专家模块(含QKV矩阵与Multi-head Attention等多模态融合机制)。这一架构设计是其在复杂场景理解中超越传统串联架构的关键所在。

核心功能与行业应用

CogVLM通过灵活的模板系统支持三类核心任务,已在多个行业落地验证:

高精度视觉定位(Grounding)

通过grounding_parser.py实现像素级坐标定位,典型应用包括:

- 物流异常检测:宁波港试点中,系统实现集装箱门封破损98.2%识别率,平均处理时间0.4秒/箱

- GUI元素交互:在网页自动登录场景中,能精准定位用户名输入框(坐标误差<3像素)

多模态推理

支持复杂场景的深度理解,如:

- 智能交通分析:在雨雾天气条件下仍保持82.3%车辆识别率,较传统算法提升15%

- 科学图表解析:能提取学术论文图表中的数据关系,生成结构化对比分析

低资源部署方案

提供完整的量化部署工具链:

# 4位量化推理启动命令

python basic_demo/cli_demo_sat.py \

--from_pretrained cogvlm-chat \

--fp16 --quant 4 \

--stream_chat

该配置在NVIDIA T4显卡上实现4.3GB显存占用,较FP16版本降低70%资源需求。

实战应用:三大典型场景落地案例

1. 快递包裹质检系统

CogVLM在快递场景实现三类异常的高精度检测:

- 包装破损(准确率97.3%)

- 标签模糊(准确率95.8%)

- 违禁品夹带(准确率99.1%)

宁波港试点数据显示,系统将异常响应时间从传统4小时缩短至0.3秒/张,人力成本降低35%。

2. 集装箱装载监控

通过定制化prompt模板,CogVLM实现:

CONTAINER_PROMPT = """

作为港口集装箱检查员,请分析图像:

- 识别货物堆叠异常(倾斜/超出边界)

- 检测集装箱门封完整性

- 评估绑扎牢固度

坐标格式:[[x1,y1,x2,y2]]

"""

实际应用中达到堆叠异常检测率96.7%,门封破损识别率98.2%。

3. 仓储货架安全监测

实时监测系统实现货架倾斜预警、货物倒塌风险评估和通道堵塞检测,平均处理时间0.4秒/帧。

如上图所示,视觉语言模型通过对象定位、零样本分割、视觉问答等多模态任务,将图像信息转化为可理解的文本回答和精确的图像分割结果。这一工作流程直观展示了CogVLM如何实现"看懂并解释"图像的核心能力,为物流、交通等行业提供了智能化解决方案。

部署指南与资源获取

快速启动三步法

环境准备

git clone https://gitcode.com/zai-org/cogvlm-chat-hf

cd cogvlm-chat-hf

pip install -r requirements.txt

单卡推理(需24GB显存)

from transformers import AutoModelForCausalLM, LlamaTokenizer

tokenizer = LlamaTokenizer.from_pretrained('lmsys/vicuna-7b-v1.5')

model = AutoModelForCausalLM.from_pretrained(

'zai-org/cogvlm-chat-hf',

torch_dtype=torch.bfloat16,

trust_remote_code=True

).to('cuda').eval()

多GPU拆分部署

from accelerate import infer_auto_device_map

device_map = infer_auto_device_map(model, max_memory={0:'20GiB',1:'20GiB','cpu':'16GiB'})

性能优化关键参数

| 量化精度 | 显存占用 | 推理速度 | 适用场景 |

|---|---|---|---|

| BF16 | 40GB | 100% | 科研实验 |

| INT8 | 16GB | 85% | 服务器部署 |

| INT4 | 11GB | 70% | 边缘设备部署 |

未来展望与生态建设

CogVLM团队计划在2025年Q4推出三项重大更新:

- 视频理解能力:新增时间维度建模,支持32帧视频片段分析

- 多图像输入:实现跨图推理,适用于全景拼接场景

- 轻量级版本:70亿参数模型(视觉4B+语言3B),适配消费级GPU

作为开源生态的重要参与者,CogVLM采用Apache-2.0许可,学术研究完全开放,商业使用需填写官方问卷登记。目前已有超过200个研究机构基于该模型开展二次开发,形成涵盖医疗影像、遥感分析等领域的应用生态。

立即访问项目主页体验:https://gitcode.com/zai-org/cogvlm-chat-hf

点赞+收藏+关注,获取CogVLM最新应用案例与技术解析,下期将带来《多模态模型在智能制造中的实战指南》。

【免费下载链接】cogvlm-chat-hf

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考