4步出片+8G显存起步:WAN2.2-14B如何重构AI视频创作生态

导语

阿里通义万相团队开源的WAN2.2-14B-Rapid-AllInOne模型,以"四合一"全能架构重新定义视频生成效率,让普通创作者也能在消费级显卡上实现电影级视频创作。

行业现状:AI视频生成的"不可能三角"困境

2025年全球AI视频生成市场规模已突破300亿美元,年复合增长率维持在40%以上的高位水平。据IDC最新报告显示,2025年上半年中国视频云市场达52.3亿美元,同比增长8.9%,标志着市场止跌回升,其中音视频AI实时互动等领域增长显著,达4000万美元。

当前行业面临三重矛盾:专业级模型(如Sora 2)需搭载高端显卡,消费级方案(如Runway Gen-4)则需15-20步采样,而开源工具往往要求用户手动配置CLIP、VAE等多个组件。数据显示,图生视频(I2V)与文生视频(T2V)的调用量比例已达9:1,反映出用户对视觉素材可控性的高度需求。这种"速度-质量-门槛"的不可能三角,使得中小创作者难以享受AI视频技术红利。

产品亮点:AllInOne架构的四大突破

1. 一体化设计:从"组件拼图"到"即插即用"

WAN2.2-14B-Rapid-AllInOne通过模型融合技术,将基础模型、CLIP文本编码器、VAE解码器及Lightx2v加速模块整合为单个safetensors文件。用户只需在ComfyUI中添加"Load Checkpoint"节点,即可完成全部配置,彻底告别复杂的工作流搭建。

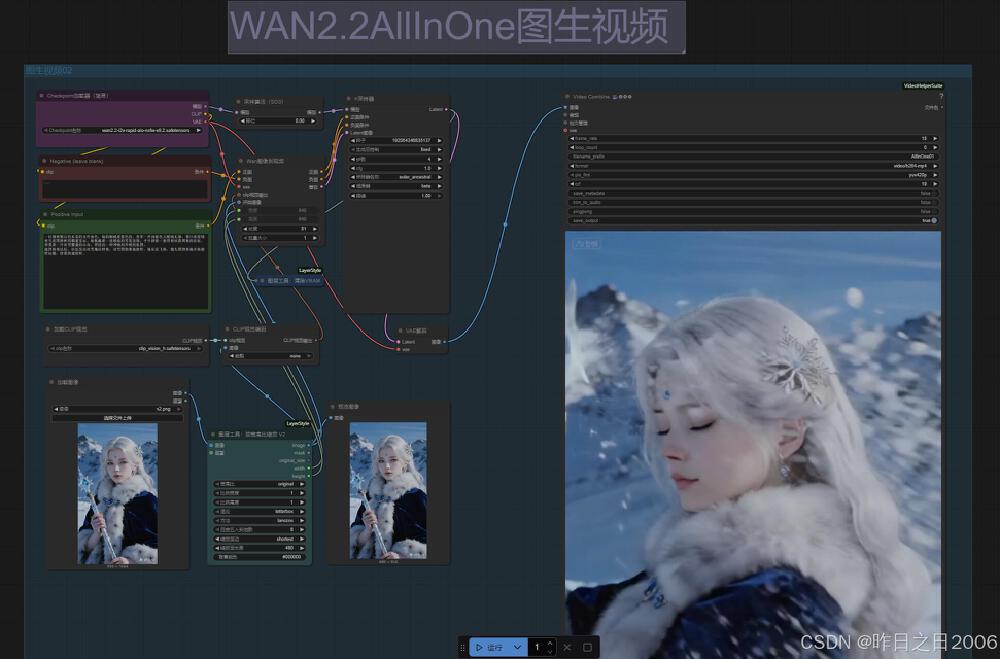

如上图所示,该工作流仅包含5个核心节点:模型加载、采样器、视频合成、预览和保存。这种极简设计将平均配置时间从传统方案的40分钟压缩至2分钟内,特别适合非技术背景的创作者快速上手。

2. 混合专家架构:性能与效率的智能平衡

WAN2.2-14B创新采用Mixture-of-Experts (MoE)架构,通过双专家协同工作实现质量与效率的平衡。高噪声专家专注早期去噪阶段的整体布局,低噪声专家负责后期细节优化,总参数达270亿但每步仅激活140亿参数,保持推理成本与传统模型相当。

如上图所示,MoE架构在去噪过程中动态分配计算资源,早期阶段(左)由高噪声专家处理全局结构,后期阶段(右)切换至低噪声专家优化细节。这种分工使模型在720P分辨率下仍能保持流畅生成速度,消费级显卡即可支持。

3. 极速推理:4步采样的效率革命

内置的Lightx2v加速模块与FP8精度优化,使模型在保持720P画质的同时,将采样步数压缩至仅需4步(CFG=1)。实测数据显示,生成10秒视频在RTX 4070显卡上仅需90秒,较WAN2.1提速300%,与同类14B模型相比节省60%计算资源。

4. 消费级硬件部署:8G显存的创作自由

得益于FP8量化技术和内存优化,模型在普通PC上即可运行:

- 8GB显存显卡可生成短视频片段

- RTX 4090生成5秒720P视频仅需9分钟

- 支持多GPU并行处理,8卡配置可提速至4分钟/段

官方测试显示,即便是8GB显存的入门级显卡,也能通过共享显存技术运行基础功能,这一特性使其成为首个真正意义上"能在游戏本运行的电影级视频模型"。

混合能力:从文本到视频的全场景覆盖

MEGA版本创新性地实现"一模型三模式":

文生视频(T2V):输入"粉色长裙女性在城市中警惕行走"等精确描述,自动生成含运镜、光影变化的电影级片段

图生视频(I2V):支持静态图像扩展为动态场景,首帧噪声控制技术使画面过渡自然度提升40%

首尾帧控制:通过VACE技术实现"起始帧→目标帧"的精准过渡,特别适合产品展示与场景转换

如上图所示,左侧图表展示了WAN2.2模型的信噪比(SNR)与去噪时间步的关系曲线,右侧则对比了不同模型架构的验证损失曲线。测试数据表明,在720P分辨率下,WAN2.2的视频生成质量超越Hunyuan-Avatar和Omnihuman等同类模型,尤其在动态场景和多角色互动中表现突出。

版本演进:11次迭代打造全能模型

从最初的base版本到最新的MEGA v11,模型经历了11次重大更新:

| 版本 | 核心改进 | 采样器推荐 | 关键特性 |

|---|---|---|---|

| V4 | 引入WAN 2.2 Lightning引擎 | euler_a/beta | 提升运动流畅度 |

| V8 | 重构T2V模型 | euler_a/beta | 解决噪声问题 |

| MEGA v1 | 首次实现一体化架构 | ipndm/sgm_uniform | 整合主流加速组件 |

| MEGA v3 | 创新架构组合 | ipndm/beta | 提升控制精度 |

| MEGA v7 | 组件组合优化 | euler_a/beta | 改进运动效果 |

| MEGA v11 | 融合lightx2v引擎 | euler_a/beta | 视频一致性提升30% |

最新的MEGA v11版本基于WAN22.XX_Palingenesis微调,通过动态分配计算资源,在保持4步生成速度的同时,进一步优化了视频的运动连贯性和细节表现。MEGA v12作为最新迭代版本,更采用bf16基础架构,解决了此前存在的技术难题,并精简为有效组件组合,进一步优化了视频运动效果。

应用场景与实战效果

内容创作:从"脚本到成片"的小时级workflow

短视频博主可通过以下流程实现高效创作:

- 使用Midjourney生成参考图像

- 在WAN2.2中加载图像,设置"4步采样+Euler_a scheduler"

- 叠加WAN2.1风格LoRA(如"赛博朋克"、"水墨风")

- 生成后直接导入剪映添加配乐字幕

某美妆博主实测显示,采用该流程使产品展示视频的制作周期从传统拍摄剪辑的2天缩短至1.5小时,内容产出量提升300%。

商业应用:低成本的动态视觉资产生成

- 电商领域:输入家具图片生成360°旋转展示视频,转化率较静态图片提升27%

- 教育场景:将历史事件插画转换为动态短片,学生知识留存率提高19%

- 广告制作:快速生成多版本产品广告变体,A/B测试效率提升5倍

快速上手指南

基础部署步骤

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/Phr00t/WAN2.2-14B-Rapid-AllInOne

# 安装依赖

pip install -r requirements.txt

# 下载模型权重至checkpoints文件夹

# 在ComfyUI中加载模型,使用推荐参数:1 CFG,4步,Euler_a采样器

提示词工程建议

- I2V模式:添加"稳定视角"提示减少场景跳变

- T2V模式:明确指定镜头类型(如"中景固定镜头")

- 运动控制:使用"缓慢平移"而非"快速移动"获得更稳定效果

行业影响与未来展望

WAN2.2-14B-Rapid-AllInOne的发布标志着视频生成技术从"实验室走向工坊"的关键转折。其开源特性(Apache-2.0协议)已催生出丰富的社区生态:

- 第三方开发者推出GGUF量化版本,使6GB显存设备也能体验基础功能

- 艺术社区开发专属LoRA库,涵盖从"宫崎骏风格"到"漫威电影美学"的200+风格模板

- 教育机构将其纳入数字媒体课程,作为AI创作工具的标准教学案例

随着社区生态的完善,我们有理由期待:

- 实时生成:未来版本将优化至10秒视频/分钟的速度

- 多角色互动:计划支持3人以上场景的协同生成

- 风格迁移:新增电影风格迁移功能,一键生成不同类型片视觉效果

对于创作者和企业而言,现在正是布局AI视频能力的关键窗口期。建议内容团队评估WAN2.2等开源方案,建立内部AIGC工作流;技术团队可关注模型微调与垂直领域优化;而决策者则需要制定"AI+视频"战略,把握成本重构带来的商业机遇。随着算力成本持续下降和算法迭代加速,视频生成技术将在未来2-3年实现从"可选工具"到"必备基建"的转变,而WAN2.2正站在这场变革的前沿。

点赞+收藏+关注,获取最新模型迭代教程和高级应用技巧!下期将带来"WAN2.2 LORA训练全攻略",教你定制专属视频风格。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Phr00t/WAN2.2-14B-Rapid-AllInOne

项目地址: https://ai.gitcode.com/hf_mirrors/Phr00t/WAN2.2-14B-Rapid-AllInOne