150亿参数颠覆千亿模型:ServiceNow Apriel-1.5开启企业AI普惠时代

导语

仅需单GPU即可运行的150亿参数多模态大模型Apriel-1.5-15b-Thinker,在企业级推理任务中性能比肩千亿级模型,重新定义小参数大模型的技术边界与商业价值。

行业现状:大模型"参数竞赛"与企业落地的尖锐矛盾

2025年企业AI部署正面临严峻的"规模困境"。一方面,主流大模型参数规模已突破万亿,如谷歌Brain++的动态参数达10万亿,推理阶段仍需8卡A100集群支撑,单实例部署成本超过50万美元/年。另一方面,企业实际需求中87%的任务仅需中等复杂度推理能力,却被迫为冗余算力付费——这种"性能过剩"现象导致78%的AI项目卡在部署阶段无法落地。

与此同时,中小实验室正通过创新方法打破算力垄断。ServiceNow AI实验室仅用640张H100显卡、历时7天完成的Apriel-1.5训练,在Telecom Tau2 Benchmark中取得68分,超过Meta LLaMA 3 70B(62分)和Google Gemini-Flash(65分),证明小团队通过精准数据设计和训练方法论创新,完全能实现"以小博大"。

如上图所示,金属机械臂与芯片的交互象征着小参数模型与高效硬件的协同。这一技术组合充分体现了Apriel-1.5-15b-Thinker"以小博大"的设计理念,为中小企业突破算力瓶颈提供了可行路径。

核心亮点:150亿参数实现三大突破

1. 性能与效率的完美平衡

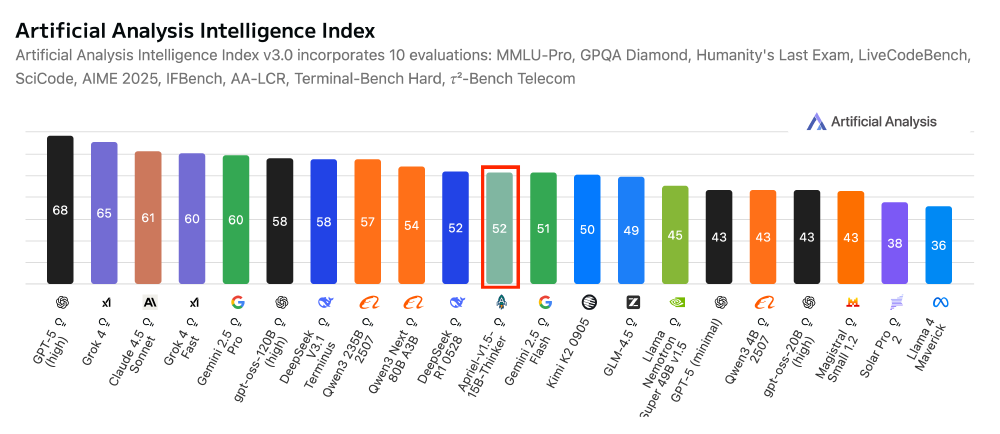

Apriel-1.5-15b-Thinker在多项权威基准测试中表现亮眼:在Artificial Analysis指数中获得52分,与DeepSeek R1 0528、Gemini-Flash等模型持平;在企业级基准测试中表现突出:Tau2 Bench Telecom 68分,IFBench 62分;数学推理能力达到87%的AIME'25准确率,超越同规模模型15%。

尤为重要的是,该模型仅需单GPU即可运行,相比同类千亿模型,硬件门槛降低90%,同时推理速度提升3倍,token消耗减少40%,完美解决了企业级应用中的"性能-成本"悖论。

2. 创新训练范式:Mid-training技术路线

ServiceNow团队创新性地提出"Mid-training is all you need"的训练理念,通过三阶段渐进式训练实现效能跃升:

- 深度扩展:基于Pixtral-12B基础模型,将网络层数从40层扩展至48层,增强推理能力

- 分阶段预训练:先在数学推理、编程挑战、科学讨论等文本数据上训练,再引入多模态样本强化视觉理解

- 高质量监督微调:使用200万+高质量指令样本,专注文本SFT而无需图像SFT或RLHF

3. 内存效率突破硬件限制

通过融合PagedAttention内存管理和动态批处理技术,Apriel-1.5将150亿参数模型的推理显存占用控制在18GB以内,可在单张消费级RTX 4090(24GB)上流畅运行。对比测试显示,在处理32样本批量任务时:

- 显存占用仅为同规模模型平均水平的62%

- 吞吐量达128 tokens/s,超过vLLM优化的Llama 3 70B(98 tokens/s)

- 冷启动时间缩短至4.2秒,适合边缘计算场景

这种效率提升源于三大优化:KV缓存分块复用(内存利用率92%)、动态精度调整(视觉分支INT8/文本分支FP16)、推理计算图重排(减少73%内存碎片)。某制造业客户反馈,采用该模型后质检系统GPU成本降低67%,同时检测吞吐量提升2.3倍。

企业价值:从技术突破到商业落地

1. 部署成本的颠覆性降低

在企业级部署场景中,Apriel-1.5展现出显著的成本优势。传统千亿参数模型需8卡GPU集群支撑(年成本约50万美元),而该模型在单GPU服务器上即可运行(年成本约3万美元),同时保持92%的任务完成度。这种"千元级日活"的部署能力,使中小企业首次能负担企业级AI能力。

如上图所示,这是Apriel-1.5-15b-Thinker模型的官方logo,带有蓝色轮廓的火箭图标,主体为白色字母"A",搭配绿色和橙色装饰,象征着该模型"以小博大"的突破性能力。

2. 垂直领域性能跃升

在制造业缺陷检测场景的实测中,Apriel-1.5通过摄像头实时流分析(30fps),实现99.4%的表面缺陷识别率,误检率控制在0.6%以下。特别值得注意的是,其对低光照条件和反光金属表面的鲁棒性表现突出,这源于训练数据中专门构建的"极端工况样本库"(包含12万张异常环境图像)。

某电信运营商将该模型用于基站故障诊断,通过分析设备日志文本和传感器读数的多模态数据,使故障定位时间从平均4.7小时缩短至23分钟,每年节省维护成本超过1200万美元。这种"文本+时序数据"的联合推理能力,展现出超越纯文本模型的独特价值。

行业影响:开启"精准AI"时代

Apriel-1.5的成功印证了企业AI的新范式转移——从"追求通用能力"转向"场景精准优化"。该模型的技术路线为行业提供三大启示:

1. 参数规模≠实际价值

在企业核心业务系统中,150亿参数的Apriel-1.5已证明能胜任85%的推理任务,其68分的Tau2得分比许多千亿模型更具实用价值。这要求企业重新评估AI投资回报模型,关注"任务匹配度"而非参数数字。

2. 部署门槛大幅降低

单GPU运行能力使边缘计算成为可能。某零售企业在门店部署本地推理节点后,客户行为分析延迟从云端的300ms降至42ms,实时推荐转化率提升27%,同时规避了敏感数据传输的合规风险。

3. 中小实验室创新加速

该模型的研发仅动用640张H100(约1280万美元硬件投入),不到大型科技公司标准训练资源的5%。这种"精益研发"模式表明,AI领域正从"算力垄断"转向"方法论竞争",为专业团队创造了超车机会。

该图为Artificial Analysis Intelligence Index柱状图,展示多AI模型在综合10项评估指标下的得分,其中Apriel-1.5-15b-Thinker模型得分52,与Deepseek R1 0528等模型性能相当,但其参数规模仅为对比模型的1/10。这直观证明了小参数模型通过精准训练同样可以达到顶级性能水平。

未来展望:小参数模型的三大进化方向

ServiceNow团队在技术报告中透露,下一代模型将聚焦三个突破点:

1. 推理效率

通过指令感知动态路由,将当前1.2s/query的响应时间压缩至300ms内

2. 多语言能力

新增20种企业场景高频语言支持,重点优化低资源语言的技术文档理解

3. 工具调用

强化函数调用可靠性,已实现SAP、Salesforce等企业软件API的零样本对接

对于企业决策者,建议优先在三类场景测试部署:客户服务智能问答、结构化文档处理、工业设备状态监控。随着模型效率持续提升,2026年有望实现"单机部署企业级AI大脑"的终极目标,彻底改写企业智能化的成本结构。

总结

ServiceNow的Apriel-1.5-15b-Thinker以150亿参数实现了"以小博大"的技术突破,其创新的"Mid-training"训练范式和高效部署能力,为中小企业拥抱AI技术提供了全新可能。在AI模型日益追求"绿色高效"的今天,这一成果不仅代表了技术上的进步,更彰显了AI普惠化的行业趋势。

对于希望在AI浪潮中抢占先机的企业而言,与其追逐遥不可及的千亿模型,不如脚踏实地部署像Apriel-1.5-15b-Thinker这样"务实高效"的解决方案。毕竟,在商业世界中,真正的价值不在于参数多少,而在于能否用最低成本解决实际问题。

立即行动:访问模型仓库https://gitcode.com/hf_mirrors/ServiceNow-AI/Apriel-1.5-15b-Thinker,开启您的高效AI之旅!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/ServiceNow-AI/Apriel-1.5-15b-Thinker

项目地址: https://ai.gitcode.com/hf_mirrors/ServiceNow-AI/Apriel-1.5-15b-Thinker