腾讯混元A13B-FP8开源:130亿参数实现800亿级性能的能效革命

导语

腾讯正式开源混元A13B大模型的FP8量化版本,通过混合专家架构和低精度优化技术,仅激活130亿参数即可达到800亿级模型性能,单张消费级GPU即可部署,重新定义大模型能效比标准。

行业现状:大模型的能效困局与突围

2025年,生成式AI产业正面临算力需求与能源消耗的双重挑战。据相关研究显示,传统千亿级参数模型的训练能耗相当于数百户家庭一年的用电量,而数据中心铜基通信链路的能源浪费问题尤为突出。在此背景下,行业正从"规模驱动"转向"效率优先",某新型AI芯片已实现能耗减半,而多家科技公司通过架构优化将能效比提升近40%,标志着生成式AI进入精细化迭代阶段。

混元A13B-FP8的推出恰逢其时,其核心突破在于解决三大行业痛点:算力成本压力(训练单个大模型成本逼近数千万美元)、部署门槛高企(传统模型需多GPU支持)、能源消耗激增(全球AI数据中心年耗电量预计2025年突破300TWh)。

核心亮点:四大技术突破重塑效率标准

1. 混合专家架构:800亿参数仅激活130亿

混元A13B采用创新的混合专家(Mixture of Experts, MoE)架构,可类比为"AI专家团队协作系统":总参数规模达800亿(相当于公司全体员工),而每次推理仅激活130亿参数(相当于调动相关部门专家)。具体架构由1个共享专家和64个细粒度非共享专家组成,训练阶段共享专家始终激活,非共享专家中仅8个同时工作。

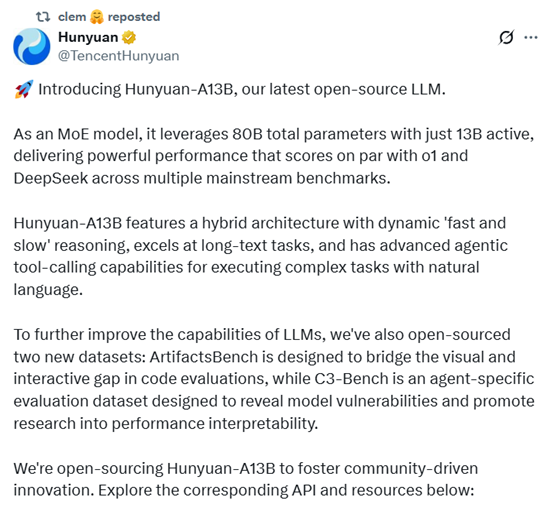

如上图所示,腾讯混元官方推文详细介绍了Hunyuan-A13B作为MoE架构模型的核心优势:总参数800亿、激活130亿,性能媲美顶尖模型,支持动态推理、长文本任务及智能体工具调用。这一架构设计使模型在数学、编程、科学及智能体任务中表现卓越。

2. FP8量化技术:显存占用降低50%的能效革命

A13B-FP8版本采用块大小为128的细粒度FP8量化技术,在保持模型精度的同时将显存占用降低50%。官方测试数据显示,与BF16版本相比,FP8量化使单卡推理吞吐量提升至5281 tokens/s,而显存需求减少至17.33GB,使单张RTX 5060Ti即可流畅运行。

相关数据显示,按日均100万次推理请求计算,采用FP8量化技术可年减少碳排放约38吨,相当于种植2000棵树的环保效益。这一成果与NVIDIA TensorRT-LLM生态结合,正在推动数据中心向绿色低碳目标加速迈进。

3. 双模式推理与256K超长上下文

混元A13B支持"快速/慢速"双模式推理链框架,允许模型根据任务复杂度动态调整推理深度:快速思考模式为简单任务提供高效解决方案,慢速思考模式则针对复杂问题启用反思和回溯机制,生成更长的思维链以提升准确性。

同时,模型原生支持256K超长上下文窗口,结合Grouped-Query Attention技术显著提高KV缓存的内存效率,使系统在处理法律文档分析、医学文献综述等长文本场景时,内存占用仅为传统模型的三分之一。

4. 低门槛部署:单张消费级GPU即可运行

得益于架构优化与量化技术,混元A13B-FP8实现了前所未有的部署灵活性。官方资料显示,该模型可在单张中低端GPU(如RTX 3080)上流畅运行,而采用vLLM或SGLang框架部署时,可进一步降低延迟并提高吞吐量。

上图展示了腾讯混元Hunyuan-A13B混合推理模型的开源界面,用户可直接在此进行AI问答操作。这种低门槛部署能力使中小企业和开发者无需高端计算集群即可开展AI应用开发,极大降低了AI技术落地的硬件门槛。

性能表现:多维度超越同类模型

在数学推理领域,混元A13B表现尤为突出,在AIME 2024测试中获得87.3分,超过某模型的79.8分和某模型的74.3分;MATH数据集得分94.3,与某模型持平。代码能力方面,在MBPP基准测试中以83.86分超越某模型的81.40分,CRUX-I任务得分70.13,大幅领先同类模型。

智能体任务是混元A13B的另一强项,在三个权威基准中分别获得78.3、61.2和63.5分,全面超越某模型的56.9、41.1和55.3分,展现出在工具调用、多步骤推理和复杂任务规划方面的优势。

行业影响与趋势

混元A13B-FP8的开源将加速三大产业变革:首先是边缘AI算力普及化,通过将高性能推理能力下放至消费级硬件,使边缘设备首次具备复杂AI任务处理能力;其次是开源模型商业价值重构,打破"大即优"的行业迷思,证明中小规模模型通过架构创新可实现商业级性能;最后是绿色AI实践,为行业提供了兼顾性能与环保的可持续发展路径。

未来,大模型发展将呈现三大趋势:混合精度标准化(FP4/FP8等低精度格式成为标配)、场景化模型设计(针对垂直领域的微型化模型快速涌现)、能效比评估体系(建立包含性能、能耗、成本的综合评价指标)。

总结与建议

腾讯混元A13B-FP8的开源不仅提供了一个高性能、高效率的AI基础模型,更代表着大模型发展从参数竞赛转向效率竞争的重要拐点。对于企业决策者,建议优先评估轻量级模型在边缘场景的部署价值;开发者可关注模型量化技术与动态推理优化方向;研究者则可基于该架构探索更高效的专家路由机制与低精度训练方法。

通过Gitcode仓库(https://gitcode.com/tencent_hunyuan/Hunyuan-A13B-Instruct-FP8),开发者可获取完整的模型文件、部署指南和示例代码,快速启动本地化部署与应用开发,共同推动AI技术的高效普惠。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/tencent_hunyuan/Hunyuan-A13B-Instruct-FP8

项目地址: https://ai.gitcode.com/tencent_hunyuan/Hunyuan-A13B-Instruct-FP8