GLM-4.5与GLM-4.5-Air大型语言模型:多阶段训练提升多任务性能,参数效率领先

全文摘要

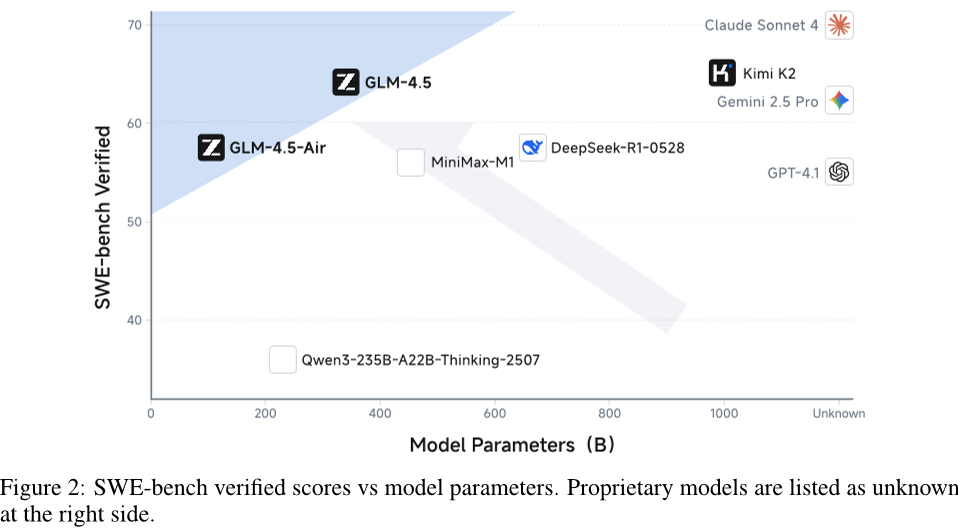

本文聚焦于大型语言模型的研究,提出了GLM-4.5和GLM-4.5-Air两种模型,它们均属于Mixture-of-Experts(MoE)架构,参数规模分别为3550亿和1060亿。这两个模型通过多阶段训练,在包含多语言文本、代码、数学科学文档等类型的23万亿token数据集上进行训练,并结合专家模型迭代和强化学习进行后训练,显著提升了在代理(Agentic)、推理(Reasoning)和编码(Coding)任务上的性能。其中,GLM-4.5在TAU-Bench、AIME 24和SWE-bench Verified等基准测试中分别取得了70.1%、91.0%和64.2%的高分,其参数效率远超其他模型。而GLM-4.5-Air作为紧凑版本,在1000亿参数规模上也展现出了优异的性能。此外,论文还详细介绍了模型架构、预训练数据设计、训练策略以及优化方法,如使用Muon优化器和新型函数调用模板等,这些改进使得模型在复杂任务处理、长上下文理解和工具调用方面表现突出。代码、模型和其他信息可在https://github.com/zai-org/GLM-4.5上获取。

论文方法

模型架构

GLM-4.5基于Mixture-of-Experts(MoE)架构构建,采用loss-free balance routing和sigmoid gates,同时具备特别设计的自注意力组件。在技术细节方面,进行了宽度调整,减少隐藏维度和专家数量的同时增加了层数;采用96个注意力头的多头注意力机制,并应用QK-Norm稳定注意力范围。

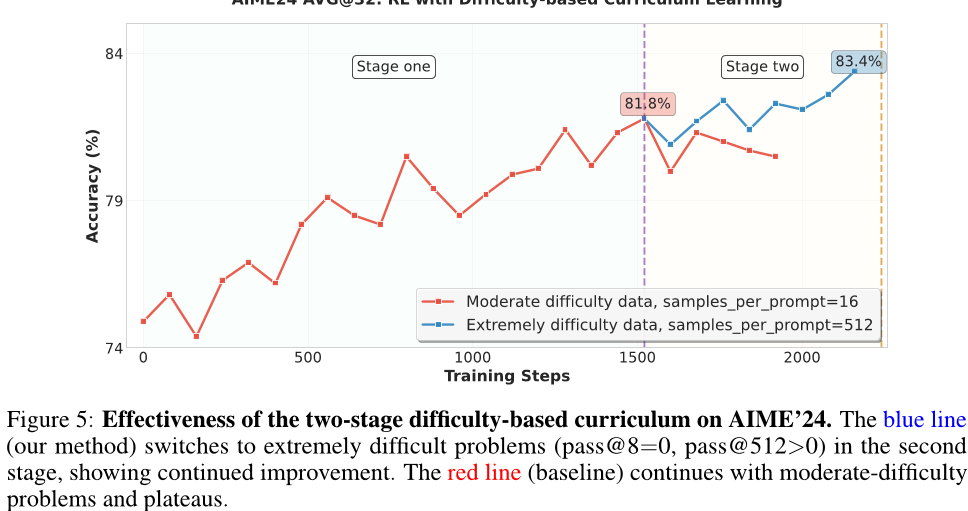

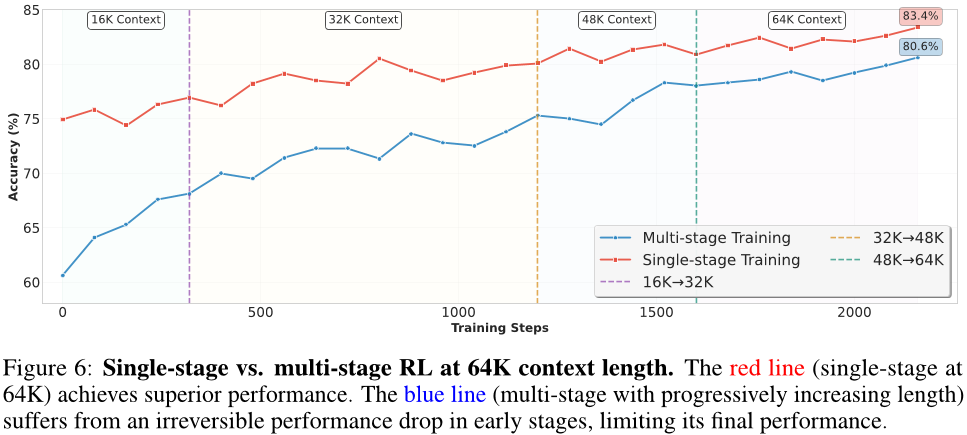

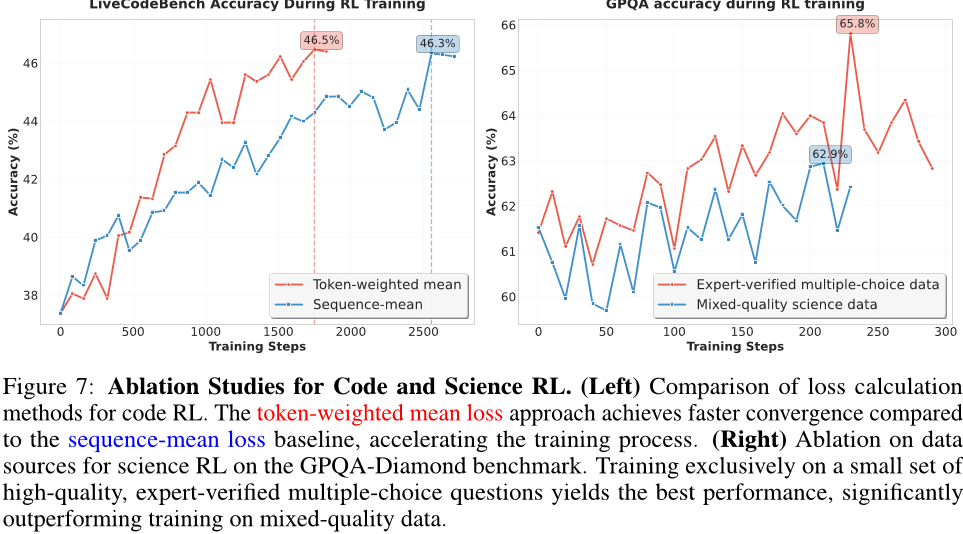

训练策略

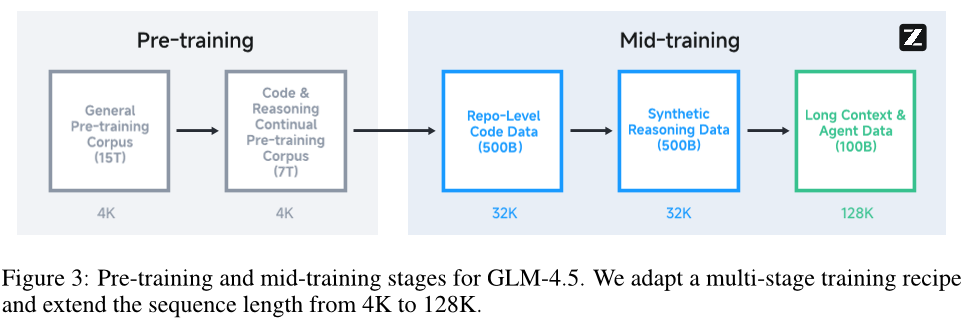

- 预训练阶段:数据来源于网页、社交媒体、书籍等,旨在构建广泛的背景知识库。

- 中期训练:使用特定领域数据(如代码、数学),目标是提升针对特定领域的性能。

- 后期训练:包括专家迭代与统一训练。其中,专家训练是创建专门于不同领域的专家模型;统一训练则利用自我教学法整合专家模型。

方法优势

与传统预训练方法相比,GLM-4.5采用的MoE架构、QK-Norm和Grouped-Query Attention等技术,显著提高了计算效率和推理能力。同时,中期训练和专家模型迭代方法进一步提升了模型性能,使其能够应用于数学、科学、编程竞赛等多个领域,并在多个领域表现出色,还能进一步提升其能力和泛化性能。

论文实验

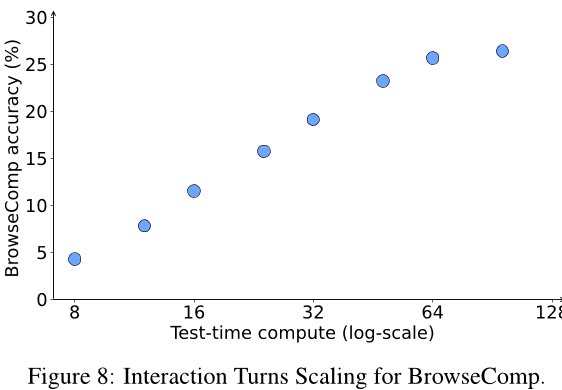

在多个基准测试中,GLM-4.5-Base和GLM-4.5展现出了出色的性能。GLM-4.5-Base在英文、代码、数学和中文任务上均取得稳定成绩,例如在MMLU上得分为86.1,在GSM8K上得分为79.4,在C-Eval上得分为86.9。GLM-4.5在不同类型的基准测试中表现优异,在Agentic Benchmarks(如TAU-Retail得79.7,BFCL V3得77.8,BrowseComp得26.4)、Reasoning Benchmarks(如MMLU-Pro得84.6,AIME 24得91.0,HLE得14.4)以及Coding Benchmarks(SWE-bench Verified得64.2,Terminal-Bench得37.5)中均有突出表现。在General Chat Benchmarks上,GLM-4.5在MMLU上得90.0,在IFEval上得86.1。此外,在SafetyBench上,GLM-4.5的平均得分89.9,其中Ethics & Morality得分94.3。

从脑图中的核心指标来看,GLM-4.5在所有评估模型中总体排名第三,在编码任务上接近最佳性能。其在具体表现方面,在Agentic Benchmark中,TAU-Bench达到70.1%,BFCL v3达到77.8%;在推理能力方面,AIME 24达到91.0%,MATH 500达到79.1%;在编码能力方面,SWE-Bench Verified达到64.2%。

论文总结

GLM-4.5和GLM-4.5-Air这两种大型语言模型通过独特的架构设计、多阶段训练策略以及多种优化方法,在代理、推理和编码等任务上取得了显著的性能提升。在多个基准测试中的出色表现,如在TAU-Bench、AIME 24、SWE-bench Verified等测试中的高分,以及在不同类型任务上的稳定成绩,充分证明了其有效性和优越性。尽管参数数量远少于其他竞争对手,但GLM-4.5在所有评估模型中的排名第三,在代理基准测试中排名第二,展现出了极高的参数效率。同时,GLM-4.5-Air作为紧凑版本也表现优异,为不同场景下的应用提供了更多选择。作者发布了GLM-4.5(355亿参数)和GLM-4.5-Air(106亿参数),将有助于促进对推理和代理AI系统的研究,推动该领域的进一步发展。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/zai-org/GLM-4.5-Air

项目地址: https://ai.gitcode.com/hf_mirrors/zai-org/GLM-4.5-Air