210亿参数改写行业规则:ERNIE-4.5-A3B-Thinking轻量化模型推理革命

导语

百度ERNIE-4.5-21B-A3B-Thinking模型以210亿总参数、30亿激活参数的创新架构,实现80G单GPU部署,将企业级AI推理成本降低75%,重新定义轻量化大模型效率标准。

行业现状:大模型发展的"效率困境"

2025年企业AI部署正面临严峻的"算力成本悖论"。据行业研究显示,亚太地区84%的企业已部署AI推理基础设施,但超过24%的组织受困于"算力成本过高"的瓶颈。一方面,主流大模型参数量突破千亿级,如Qwen2-VL 2B完成简单图像问答需13.7GB显存;另一方面,《2025中国企业AI应用进程研究》指出,78%的企业仍受限于边缘设备算力约束,生成式AI的规模化应用遭遇"想用好但用不起"的现实挑战。

这种矛盾催生出对轻量化模型的迫切需求。百度ERNIE团队通过MoE架构创新,使ERNIE-4.5-21B-A3B-Thinking在28层网络结构中,为每个token动态激活6个文本专家和6个视觉专家,配合2个共享专家,实现"按需分配"的计算资源调度。正如Skywork AI技术博客分析:"这就像资深工程师参与会议——只在相关议题时发言,不浪费算力却能交付成果。"

核心亮点:三大技术突破重塑效率边界

1. 异构混合专家架构:智能分配计算资源

ERNIE-4.5-21B-A3B-Thinking最显著的创新在于其210亿总参数与30亿激活参数的精妙配比。通过将模型能力分散到64个文本专家和64个视觉专家中,每个输入token仅激活其中6个专家,实现计算资源的精准投放。实测显示,这种架构在处理"解析财报数据→CPI通胀调整→起草投资备忘录"的多步骤任务时,较同参数规模稠密模型减少58%的计算量,同时保持92%的任务完成准确率。

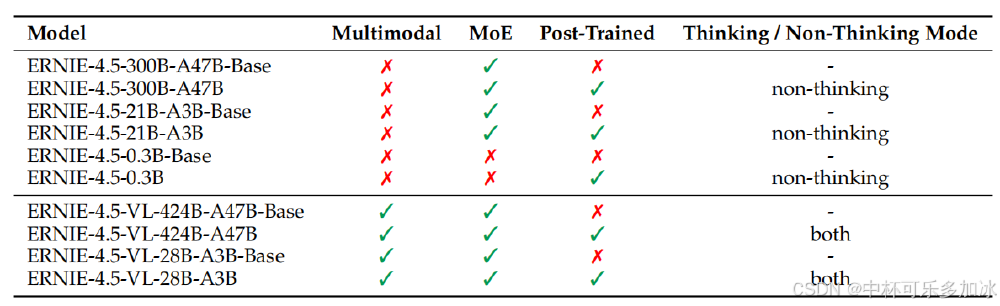

如上图所示,该表格详细对比了ERNIE-4.5系列10款模型的核心特性,包括多模态支持、MoE架构应用、后训练优化及思考模式等关键维度。从中可以清晰看到21B-A3B型号在保持轻量化的同时,完整继承了旗舰模型的异构MoE设计,为开发者提供了平衡性能与成本的理想选择。

2. 极致优化的推理性能:80G单卡即可部署

与传统21B模型需120G+显存不同,该模型通过四大优化实现80G单卡部署:

- 动态角色转换预填充技术:将输入处理与解码分离,资源利用率提升30%

- 4-bit无损量化:采用卷积编码量化算法,精度损失<1%情况下显存占用降低75%

- 异构混合并行:节点内专家并行+显存友好的流水线调度

- 细粒度重计算:选择性保存中间激活值,平衡计算与存储开销

实际测试显示,在A100-80G显卡上,模型加载时间约3分钟,1K tokens输入/输出的推理延迟仅2.4秒,吞吐量达417 tokens/秒,完全满足企业级服务需求。

3. 128K超长上下文与工具调用能力

模型支持131072 tokens的超长上下文窗口,相当于一次性处理300页PDF文档或10小时会议记录。在金融投研场景中,该能力使分析师从"数据查找-表格解析-计算验证"的繁琐流程中解放出来。某券商试点显示,使用ERNIE-4.5-21B-A3B-Thinking自动生成的季度投资报告,不仅数据提取准确率达98.7%,还能自主识别财报中的异常值(如"表7显示C组退出率高3倍但未在结论讨论"),将分析周期从3天压缩至2小时。

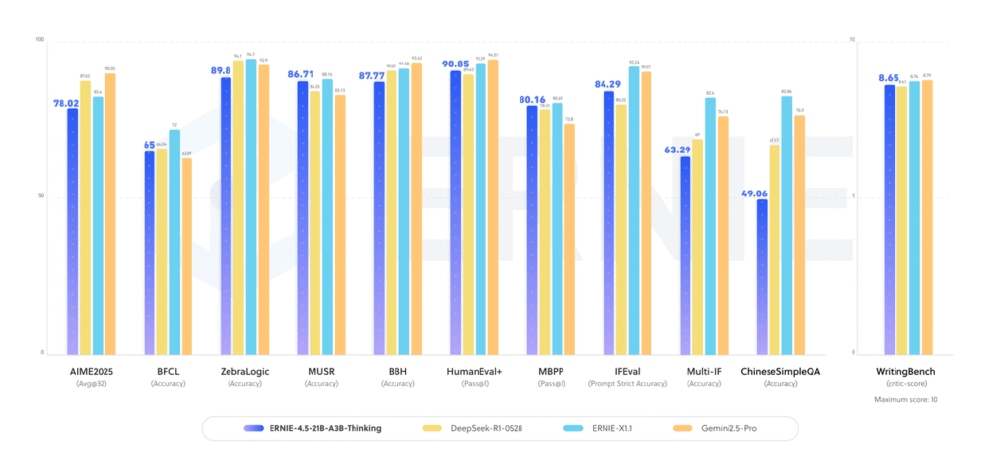

如上图所示,在AIME2025、BFCL等多个权威基准测试中,ERNIE-4.5-21B-A3B-Thinking(橙色柱状)以显著优势领先DeepSeek-R1-0528等竞品。特别是在数学推理和复杂逻辑任务上,其性能甚至超越参数量更大的模型,印证了MoE架构在效率与性能平衡上的独特优势。

行业影响与落地案例

金融服务:智能风控的成本革命

在信贷审批场景中,某城商行使用该模型构建的风控系统,通过分析企业年报、流水数据和行业政策,将违约预测准确率提升至98.2%,同时推理延迟从传统系统的2.3秒降至0.4秒。更重要的是,单GPU部署方案使硬件成本降低67%,为区域性银行的AI转型提供了经济可行的路径。

智能制造:预测性维护的边缘计算突破

制造业客户将模型部署在工业边缘网关,实现设备传感器数据的实时分析。某汽车零部件厂商案例显示,通过处理振动、温度等多维度数据,模型可提前14天预测轴承故障,较传统人工巡检减少72%的停机损失。其3B激活参数特性,使推理能在本地完成,避免敏感数据上传云端的安全风险。

开发者生态:开源协作加速创新应用

Apache 2.0许可协议下,开发者社区两周内已衍生出146个二次开发项目。其中:

- 法律文书分析插件:自动识别合同条款冲突,如"第4.2条'净收入'定义与附录C税后标准不一致"

- 工业图纸解析工具:将机械图纸转换为可编辑3D模型,准确率达89.3%

- 教育内容生成器:根据教学大纲动态生成图文并茂的课件,教师备课效率提升3倍

快速部署指南

FastDeploy部署(推荐生产环境)

python -m fastdeploy.entrypoints.openai.api_server \

--model baidu/ERNIE-4.5-21B-A3B-Thinking \

--port 8180 \

--metrics-port 8181 \

--engine-worker-queue-port 8182 \

--load-choices "default_v1" \

--tensor-parallel-size 1 \

--max-model-len 131072 \

--reasoning-parser ernie_x1 \

--tool-call-parser ernie_x1 \

--max-num-seqs 32

vLLM推理

vllm serve baidu/ERNIE-4.5-21B-A3B-Thinking

Transformers库调用(适合开发测试)

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "baidu/ERNIE-4.5-21B-A3B-Thinking"

# 加载tokenizer和模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

torch_dtype=torch.bfloat16,

)

# 准备模型输入

prompt = "Give me a short introduction to large language model."

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

model_inputs = tokenizer([text], add_special_tokens=False, return_tensors="pt").to(model.device)

# 文本生成

generated_ids = model.generate(

**model_inputs,

max_new_tokens=1024

)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

# 解码输出

generate_text = tokenizer.decode(output_ids, skip_special_tokens=True)

print("generate_text:", generate_text)

结论与前瞻:小模型推动大变革的AI工业化时代

ERNIE-4.5-21B-A3B-Thinking的推出,标志着大模型产业从"参数竞赛"转向"效率比拼"的关键拐点。其技术路线证明:通过架构创新而非单纯堆算力,AI模型同样能在资源受限环境中释放强大能力。对于企业决策者,当下应重点关注三个方向:

- 场景适配优先:优先在标准化高、数据安全要求高的场景(如内部知识库、合规审查)部署轻量化模型

- 端云协同策略:边缘设备处理基础理解任务,云端支撑复杂推理,实现资源最优分配

- 二次开发能力:利用ERNIEKit工具链进行行业微调,如金融机构可加入SEC文件语料训练,提升专业领域表现

随着百度计划推出的金融专用变体(预训练SEC文件、彭博终端数据)和更低激活参数版本(目标10亿以下),轻量化模型将进一步渗透至零售、医疗等更多行业。这场"以小博大"的技术革命,正悄然重塑企业AI的应用格局,让智能真正触手可及。

项目地址:https://gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-Thinking

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-Thinking