导语

【免费下载链接】Ring-flash-2.0

在大模型领域,"混合专家(MoE)+长思维链(Long-CoT)+强化学习(RL)"的技术路线一直被视为提升推理能力的黄金组合,但如何在训练稳定性与模型效果之间找到平衡点,始终是业界公认的技术难关。9月19日,蚂蚁集团百灵大模型团队发布重磅开源成果——Ring-flash-2.0,将这一技术难题转化为可复用的技术方案。

行业现状:大模型进入"效率革命"深水区

当前大模型赛道已从参数规模竞赛转向效率革命,MoE(混合专家模型)架构成为绝对主流。据不完全统计,9月全球发布的40多款大模型中,超过60%采用MoE或混合架构。中国大模型凭借场景化能力和开源策略实现弯道超车,在数学推理、代码生成等细分领域形成技术优势。以蚂蚁百灵大模型为例,其最新开源的Ring-flash-2.0以1000亿总参数量、仅61亿激活参数的高效配置,重新定义了推理型大模型的性价比标准。

核心亮点:icepop算法解决训练稳定性难题

独创"棒冰算法":双向截断技术保障训练持续优化

Ring-flash-2.0实现跨越式突破的核心在于团队原创的"棒冰(icepop)"训练算法。这一机制通过"双向截断+掩码修正"的创新设计,将训练与推理阶段精度差异过大的token实时冻结,阻止其反向传播干扰梯度更新。实验数据显示,在持续60天的强化学习训练周期中,采用icepop算法的模型损失函数曲线始终保持平稳下降趋势,而采用GRPO的对照组在第18天出现显著震荡并最终发散。

高效MoE架构:1/32专家激活比实现性能与效率双赢

继承自Ling 2.0系列的高效MoE架构,通过1/32的超低专家激活比例(即每层仅激活3.125%的专家网络)和多任务感知路由(MTP)层等创新设计,使模型在实际推理时仅激活61亿参数(扣除嵌入层后为48亿),却能实现相当于400亿参数稠密模型的推理效果。在4张H20显卡组成的基础算力平台上,Ring-flash-2.0即可实现每秒200个token以上的生成速度,将高并发场景下推理型大模型的算力成本降低60%以上。

三阶训练体系:从"学会思考"到"精准表达"的能力进化

百灵团队为Ring-flash-2.0构建了循序渐进的三阶训练体系:第一阶段采用长思维链监督微调(Long-CoT SFT),精选数学证明、代码调试等领域数据集;第二阶段引入可验证奖励强化学习(RLVR),通过符号执行器和单元测试提供客观奖励信号;第三阶段通过人类反馈强化学习(RLHF)优化格式规范性和阅读流畅度。这种分阶段训练策略使模型既能突破推理极限,又能满足实际应用需求。

性能表现:四大权威榜单领先的推理能力

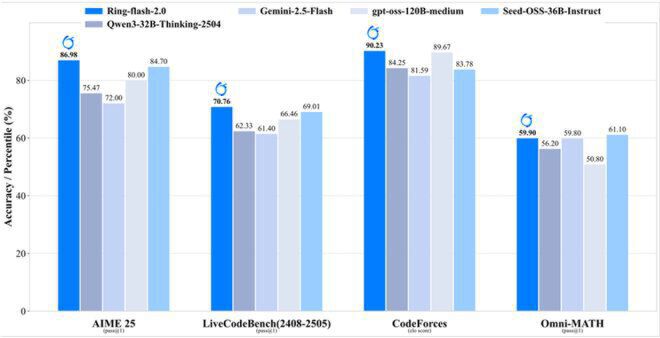

如上图所示,Ring-flash-2.0在数学推理(AIME 25)、代码生成(LiveCodeBench)、编程竞赛(CodeForces)和综合数学(Omni-MATH)四大权威榜单上的准确率均处于领先位置。其中AIME 25测试86.98分、CodeForces elo评分90.23的成绩,不仅超越400亿参数以内稠密模型的最佳水平,更可与更大规模的MoE模型同台竞技。

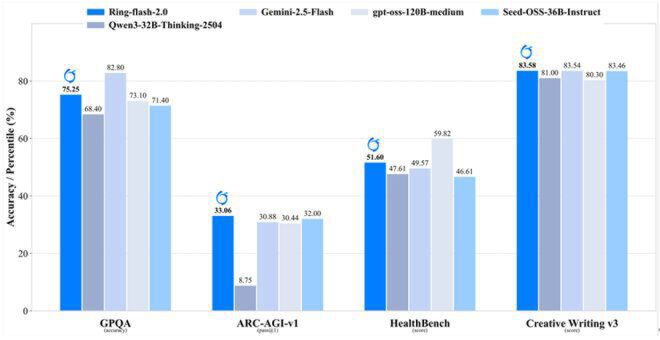

这张对比柱状图展示了Ring-flash-2.0与其他模型在通用推理(GPOA)、科学问答(ARC-AGI-v1)、医疗知识(HealthBench)和创意写作(Creative Writing v3)跨领域任务中的表现。蓝色柱状代表的Ring-flash-2.0在各任务中均展现出与更大模型抗衡的综合实力,验证了高效MoE架构在保持模型通用性方面的优势。

行业影响:降低推理大模型开发门槛

Ring-flash-2.0的开源发布不仅提供预训练模型权重,更完整开放了"棒冰算法"实现代码、三阶训练流水线和高效推理引擎。这种全链路开源策略使中小企业和研究机构能够以极低成本复现400亿级模型的推理能力,有望加速大模型技术在垂直领域的应用落地。特别值得注意的是,该模型原生支持128K上下文窗口,通过YaRN技术可扩展至512K,在处理法律文书分析、学术论文解读等长文本场景时,相对加速比最高可达7倍。

结论与前瞻

Ring-flash-2.0通过原创的icepop算法和高效MoE架构,成功解决了大模型训练稳定性与推理精度之间的核心矛盾,为业界提供了一套兼顾效率与效果的技术范式。随着开源生态的不断完善,我们有理由相信,这种"大参数储备+小参数激活"的模式将成为推理型大模型的主流发展方向。对于开发者而言,现在正是基于Ring-flash-2.0探索垂直领域应用的最佳时机,项目地址:https://gitcode.com/hf_mirrors/inclusionAI/Ring-flash-2.0。

(完)

【免费下载链接】Ring-flash-2.0

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考