万亿参数开源大模型Kimi K2:智能体时代的技术突破与行业变革

【免费下载链接】Kimi-K2-Base

导语

2025年7月11日,月之暗面(Moonshot AI)正式发布万亿参数大模型Kimi K2并同步开源,以1万亿总参数、320亿激活参数的MoE架构刷新开源模型性能纪录,标志着国内大模型正式进入"智能体(Agentic Intelligence)"时代。

行业现状:大模型的第三次范式转移

当前AI行业正经历从"静态模仿学习"向"动态智能体"的关键转型。据Gartner预测,到2027年,75%的企业AI应用将采用智能体架构,实现自主感知、规划与行动。然而现有模型面临两大核心挑战:高质量数据稀缺导致的训练效率瓶颈,以及Agentic能力难以规模化的困境。在此背景下,Kimi K2通过三大技术创新构建了新一代开源基准。

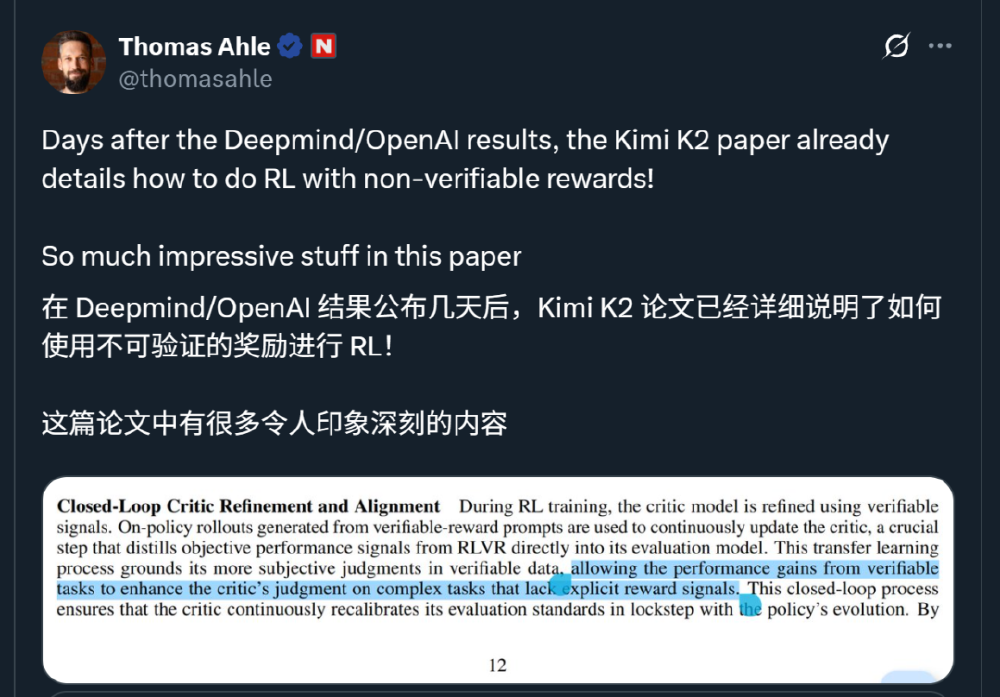

如上图所示,这是Kimi K2官方技术报告的关键页面,展示了其"闭环批评者优化与对齐"框架。该框架通过可验证奖励环境和自我评估机制,解决了传统强化学习在开放域任务中奖励信号模糊的问题,为智能体能力的规模化提供了全新技术路径。

核心亮点:三大技术突破重构模型能力边界

1. MuonClip优化器:15.5万亿token的稳定训练

Kimi K2摒弃传统Adam优化器,创新性采用MuonClip优化器,结合Muon的token效率与QK-Clip稳定性机制,实现15.5万亿token无损失spike训练。这种优化器在保持320亿激活参数性能的同时,将计算成本降低60%,使万亿参数模型首次实现开源可用。

2. 384专家MoE架构:稀疏激活的效率革命

模型采用384个专家的混合专家(Mixture-of-Experts)架构,每层动态激活8个专家,配合多头潜在注意力(MLA)机制,在128K上下文长度下实现7168维度的注意力隐藏层。实测显示,其在SWE-bench Verified编码任务中达到71.6%的修复准确率,超越GPT-4.1的54.6%,成为首个在专业开发场景媲美闭源模型的开源方案。

3. 智能体数据合成流水线:工具使用能力的工业化生产

构建覆盖数百领域、数千工具的Agentic数据合成系统,通过模拟3000+真实MCP工具和20000+合成工具的交互场景,生成大规模多轮工具使用轨迹。在Tau2零售场景测试中,Kimi K2实现70.6%的平均准确率,较开源同类模型提升24%,接近Claude Sonnet 4的75.0%水平。

从图中可以看出,海外技术社区对Kimi K2的"非刷题"训练策略高度关注。不同于传统模型依赖大规模题库的模式,Kimi K2通过"知识重述法"提升数据效率,将原始知识文本转化为多语言解释版本,使单轮训练效率提升22%,验证了高质量数据而非海量数据是模型能力的关键。

性能表现:开源模型的新标杆

根据官方公布的评估结果,Kimi K2在多个关键 benchmark 上表现出色:

编码能力

- LiveCodeBench v6: 53.7% Pass@1,超越GPT-4.1的44.7%

- OJBench: 27.1% Pass@1,领先第二名3.1个百分点

- SWE-bench Verified (Agentic Coding): 71.6%准确率(多轮尝试)

工具使用能力

- Tau2零售场景: 70.6%平均准确率

- Tau2电信场景: 65.8%平均准确率,大幅领先开源同类模型

- AceBench: 76.5%准确率,接近GPT-4的80.1%

数学与STEM能力

- AIME 2024: 69.6%平均得分

- MATH-500: 97.4%准确率

- PolyMath-en: 65.1%平均得分,排名第一

行业影响:开源生态的破局与重构

1. 技术普惠:中小企业的AI能力跃迁

Kimi K2开源后,开发者可通过Gitcode仓库(https://gitcode.com/hf_mirrors/moonshotai/Kimi-K2-Base)获取基础模型,无需从零训练即可构建垂直领域智能体。月之暗面同时提供OpenAI/Anthropic兼容API,使现有应用可无缝迁移,预计将降低企业级智能体开发门槛80%。

2. 研发范式转变:从参数竞赛到效率革命

模型证明"总参数规模≠实际能力",320亿激活参数实现媲美千亿模型性能,推动行业关注计算效率与数据质量。其采用的MuonClip优化器和知识重述技术,已被DeepSeek、Qwen等模型借鉴,形成新一代训练标准。

3. 智能体产业化加速

金融、医疗等领域已出现基于Kimi K2的落地案例:某券商构建的财报分析智能体,通过工具调用自动完成数据抓取、建模与可视化,将分析周期从3天缩短至2小时;三甲医院的病历处理系统则实现92.5%的结构化准确率,超过人工标注效率3倍。

部署与使用:企业落地的实用指南

推荐部署环境

Kimi K2推荐在以下推理引擎上运行:

- vLLM

- SGLang

- KTransformers

- TensorRT-LLM

模型 checkpoint 采用 block-fp8 格式存储,可通过Huggingface获取。月之暗面官方提供了vLLM和SGLang的部署示例,方便开发者快速上手。

工具调用示例代码

def tool_call_with_client(client: OpenAI, model_name: str):

messages = [

{"role": "system", "content": "You are Kimi, an AI assistant created by Moonshot AI."},

{"role": "user", "content": "What's the weather like in Beijing today? Use the tool to check."}

]

finish_reason = None

while finish_reason is None or finish_reason == "tool_calls":

completion = client.chat.completions.create(

model=model_name,

messages=messages,

temperature=0.6,

tools=tools, # tool list defined above

tool_choice="auto"

)

# 工具调用逻辑处理...

结论与前瞻

Kimi K2的发布不仅是技术突破,更标志着开源大模型从"通用能力"向"专业行动"的关键跨越。其混合专家架构、创新优化器和智能体数据合成技术,为行业提供了兼顾性能与效率的新范式。随着高速版kimi-k2-turbo-preview的推出,以及i18n生态的完善,Kimi K2有望在企业级智能体市场占据关键地位。

未来,我们或将看到更多基于该模型的垂直领域解决方案,推动AI从辅助工具进化为自主协作伙伴。对于企业而言,现在正是评估和引入这一技术的最佳时机,以在智能体时代占据先机。

【项目地址】https://gitcode.com/hf_mirrors/moonshotai/Kimi-K2-Base

【免费下载链接】Kimi-K2-Base

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考