最完整Bark音频特征提取指南:从MFCC到频谱分析全流程解析

你还在为音频特征提取的复杂流程烦恼吗?是否想快速掌握Bark模型中音频特征的处理方法?本文将带你从基础的MFCC特征到高级的频谱分析,全面解析Bark项目的音频特征提取技术,让你轻松理解音频如何转化为机器可识别的数字信号。

读完本文你将获得:

- 掌握Bark模型的音频特征提取核心流程

- 理解MFCC、梅尔频谱等关键音频特征的原理

- 学会使用Bark的API进行音频特征提取

- 了解不同语言音频特征的差异处理

Bark模型简介

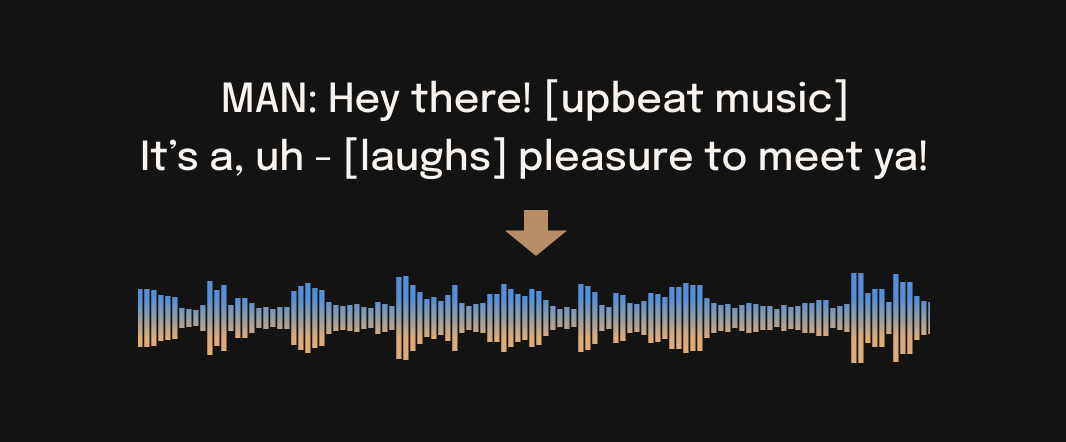

Bark是由Suno开发的基于Transformer的文本到音频模型,能够生成高度逼真的多语言语音以及其他音频,包括音乐、背景噪音和简单的音效。该模型还可以产生非语言交流,如笑、叹气和哭泣。

Bark的核心优势在于它不仅仅是一个传统的文本到语音模型,而是一个完全生成式的文本到音频模型,能够以意想不到的方式偏离提供的提示。项目的完整实现可以在GitHub仓库中找到。

音频特征提取基础

音频特征提取是将原始音频信号转换为适合机器学习模型处理的数字表示的过程。在Bark模型中,这一过程主要通过以下几个步骤完成:

采样率与音频表示

Bark模型使用的采样率为24000Hz,这意味着每秒钟的音频被离散化为24000个样本点。这个参数在generation.py中定义:

SAMPLE_RATE = 24_000

音频信号在计算机中通常表示为一个一维数组,其中每个元素代表特定时间点的音频振幅。

傅里叶变换与频谱分析

傅里叶变换是音频特征提取的基础,它将时域的音频信号转换为频域表示,揭示音频中包含的频率成分。Bark模型中虽然没有直接展示傅里叶变换的代码,但在encodec库中使用了类似的技术进行音频编码。

Bark中的音频特征提取流程

Bark模型的音频特征提取采用了三级处理流程:语义特征提取、粗略音频特征提取和精细音频特征提取。这三个阶段分别由不同的模型处理,共同完成从文本到音频的转换。

语义特征提取

语义特征提取是将文本转换为语义 tokens 的过程。这一步由文本模型完成,在model.py中实现。语义特征的采样率为49.9Hz,词汇量为10000,这些参数在generation.py中定义:

SEMANTIC_RATE_HZ = 49.9

SEMANTIC_VOCAB_SIZE = 10_000

语义特征提取的核心代码在generate_text_semantic函数中实现,该函数接收文本输入并生成对应的语义tokens。

粗略音频特征提取

粗略音频特征提取将语义特征转换为粗略的音频编码。这一步由粗略模型完成,同样在model.py中实现。粗略特征的采样率为75Hz,使用了2个码本,每个码本大小为1024,这些参数在generation.py中定义:

CODEBOOK_SIZE = 1024

N_COARSE_CODEBOOKS = 2

N_FINE_CODEBOOKS = 8

COARSE_RATE_HZ = 75

粗略音频特征提取的核心代码在generate_coarse函数中实现。

精细音频特征提取

精细音频特征提取将粗略特征进一步细化,生成最终的音频编码。这一步由精细模型完成,在model_fine.py中实现。精细特征使用了8个码本,与粗略特征的2个码本共同构成了10个码本的完整音频编码。

精细音频特征提取的核心代码在generate_fine函数中实现。

MFCC特征在Bark中的应用

梅尔频率倒谱系数(MFCC)是音频信号处理中常用的特征表示方法,它模拟了人耳对声音的感知特性。虽然Bark模型没有直接使用传统的MFCC特征,但它的特征提取过程借鉴了MFCC的设计思想,特别是在频谱特征到感知特征的转换方面。

Bark使用了Encodec模型进行音频编码,该模型采用了与MFCC类似的多分辨率分析方法,但通过深度学习模型进行了优化。Encodec的实现在load_codec_model函数中加载:

def load_codec_model(use_gpu=True, force_reload=False):

global models

global models_devices

device = _grab_best_device(use_gpu=use_gpu)

if device == "mps":

# encodec doesn't support mps

device = "cpu"

model_key = "codec"

if OFFLOAD_CPU:

models_devices[model_key] = device

device = "cpu"

if model_key not in models or force_reload:

clean_models(model_key=model_key)

model = _load_codec_model(device)

models[model_key] = model

models[model_key].to(device)

return models[model_key]

多语言音频特征处理

Bark支持多种语言的音频生成,包括英语、德语、西班牙语、法语、 Hindi、意大利语、日语、韩语、波兰语、葡萄牙语、俄语、土耳其语和中文等。不同语言的音频特征存在差异,Bark通过语言检测和特定语言的语音模型来处理这些差异。

支持的语言列表在generation.py中定义:

SUPPORTED_LANGS = [

("English", "en"),

("German", "de"),

("Spanish", "es"),

("French", "fr"),

("Hindi", "hi"),

("Italian", "it"),

("Japanese", "ja"),

("Korean", "ko"),

("Polish", "pl"),

("Portuguese", "pt"),

("Russian", "ru"),

("Turkish", "tr"),

("Chinese", "zh"),

]

每种语言都有对应的语音预设,存储在bark/assets/prompts/目录下。例如,中文语音预设包括zh_speaker_0.npz到zh_speaker_9.npz等文件。

实战:使用Bark提取音频特征

下面我们将通过一个完整的示例,展示如何使用Bark模型提取音频特征。这个示例将从文本输入开始,生成对应的音频特征,并最终合成为音频信号。

准备工作

首先,我们需要安装Bark模型。根据README.md中的说明,正确的安装命令是:

pip install git+https://link.gitcode.com/i/a44275bf73060e41b8fa46d7de854db3.git

提取音频特征的代码示例

from bark import SAMPLE_RATE, generate_audio, preload_models

from scipy.io.wavfile import write as write_wav

import numpy as np

# 下载并加载所有模型

preload_models()

# 从文本生成音频

text_prompt = """

你好,这是一个Bark模型音频特征提取的示例。

这个示例将展示如何从文本生成音频特征并合成音频。

"""

audio_array = generate_audio(text_prompt, history_prompt="v2/zh_speaker_1")

# 保存音频到磁盘

write_wav("bark_audio_example.wav", SAMPLE_RATE, audio_array)

# 音频特征提取在generate_audio函数内部完成

# 该函数依次调用了generate_text_semantic、generate_coarse和generate_fine

# 分别对应语义特征、粗略特征和精细特征的提取

特征提取的核心API

Bark提供了几个核心函数用于音频特征提取:

- generate_text_semantic: 从文本生成语义特征

- generate_coarse: 从语义特征生成粗略音频特征

- generate_fine: 从粗略音频特征生成精细音频特征

这些函数在generation.py中实现,可以单独调用以获取中间特征。

音频特征可视化

为了更好地理解音频特征,我们可以将提取到的特征进行可视化。虽然Bark没有提供专门的可视化工具,但我们可以使用Python的matplotlib库来绘制特征图谱。

以下是一个简单的音频特征可视化示例:

import matplotlib.pyplot as plt

import numpy as np

# 假设我们已经获取了语义特征semantic_features

# semantic_features = generate_text_semantic("你好,世界")

# 创建一个示例语义特征矩阵用于可视化

semantic_features = np.random.rand(100, 10)

# 绘制语义特征热力图

plt.figure(figsize=(12, 6))

plt.imshow(semantic_features.T, aspect='auto', origin='lower')

plt.colorbar(label='特征值')

plt.xlabel('时间步')

plt.ylabel('特征维度')

plt.title('Bark语义特征可视化')

plt.tight_layout()

plt.savefig('semantic_features_visualization.png')

plt.show()

性能优化与硬件要求

音频特征提取是一个计算密集型任务,Bark提供了多种优化选项以适应不同的硬件环境。根据README.md中的说明,Bark在GPU和CPU上都可以运行,但推荐使用GPU以获得更好的性能。

硬件要求

- 完整版本的Bark需要大约12GB的显存

- 小型模型版本需要大约8GB的显存

- 可以通过设置环境变量

SUNO_USE_SMALL_MODELS=True来使用小型模型

这些设置在generation.py中定义:

USE_SMALL_MODELS = _cast_bool_env_var(os.environ.get("SUNO_USE_SMALL_MODELS", "False"))

GLOBAL_ENABLE_MPS = _cast_bool_env_var(os.environ.get("SUNO_ENABLE_MPS", "False"))

OFFLOAD_CPU = _cast_bool_env_var(os.environ.get("SUNO_OFFLOAD_CPU", "False"))

推理速度优化

Bark提供了多种推理速度优化选项,包括:

- 使用Flash Attention加速注意力计算

- 模型卸载到CPU以节省GPU内存

- 小模型模式减少计算量

这些优化在model.py和generation.py中实现,可以通过环境变量或函数参数进行配置。

总结与展望

Bark模型的音频特征提取流程展示了现代语音合成技术的最新进展,通过三级特征提取(语义特征、粗略特征和精细特征)实现了高质量的音频生成。这种方法不仅提高了音频质量,还支持多语言和非语言声音的生成。

未来,Bark的音频特征提取技术可能会在以下方面得到进一步改进:

- 更高质量的多语言支持

- 更低的计算资源需求

- 更丰富的音频特征控制选项

- 实时音频特征提取与生成

如果你对Bark的音频特征提取技术感兴趣,可以通过以下资源深入学习:

- 官方文档:README.md

- 代码实现:bark/generation.py和bark/model.py

- 示例 notebooks:notebooks/

希望本文能够帮助你更好地理解Bark的音频特征提取技术,为你的音频应用开发提供参考。如果你有任何问题或建议,欢迎在项目的GitHub仓库中提出issue或参与讨论。

别忘了点赞、收藏和关注,以获取更多关于Bark和音频处理的技术文章!下一期我们将探讨Bark的语音合成原理,敬请期待。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://gitcode.com/GitHub_Trending/ba/bark

项目地址: https://gitcode.com/GitHub_Trending/ba/bark