导语

【免费下载链接】LFM2-1.2B-Extract

Liquid AI推出的轻量级模型LFM2-1.2B-Extract,以1.2B参数实现多语言结构化数据提取,重新定义边缘设备AI部署标准,为企业级应用提供高效解决方案。

行业现状:边缘智能迎来爆发期

2025年全球边缘AI硬件市场呈现爆发式增长,预计从5.2亿美元增长至2034年的20.4亿美元,年复合增长率达16.3%(Global Market Insights数据)。随着制造业、医疗健康和零售等行业数字化转型加速,企业对本地化数据处理的需求激增——既要满足低延迟实时分析,又要应对跨境业务带来的多语言挑战。

当前市场面临双重矛盾:一方面,跨国企业平均需要处理4.7种工作语言(行业分析数据),传统模型多语言支持不足;另一方面,云端处理存在数据隐私风险与带宽成本问题。这种背景下,Liquid AI的LFM2-1.2B-Extract模型凭借"轻量级+多语言+结构化提取"的组合优势,成为边缘智能部署的理想选择。

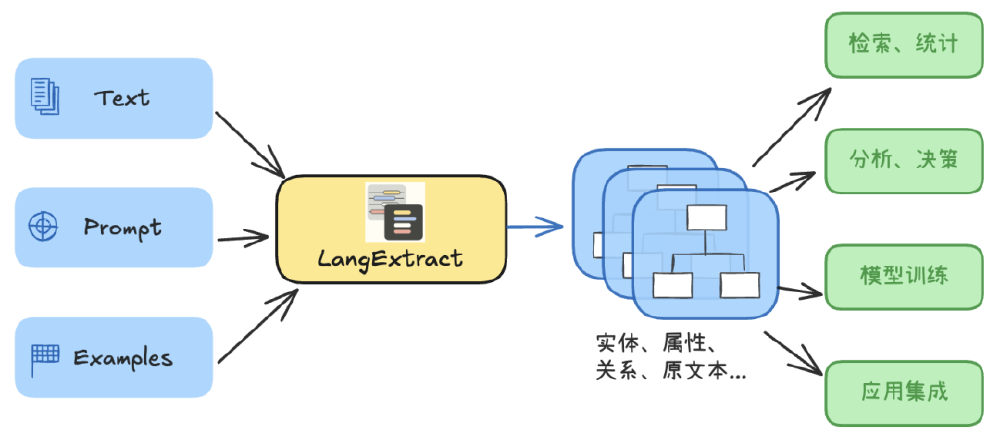

如上图所示,现代企业数据处理正从分散式人工整合转向智能化集成。这种转变中,轻量级AI模型扮演关键角色,能够在保持数据本地化的同时,实现跨系统、多语言的信息统一提取与分析。

核心亮点:小模型的大能力

LFM2-1.2B-Extract基于Liquid AI自研的LFM2-1.2B基础模型优化而来,针对结构化数据提取场景进行专项训练,展现出三大核心优势:

多语言处理突破

原生支持英语、阿拉伯语、中文等9种语言,覆盖全球主要商业区域。在金融文档测试中,阿拉伯语-中文专业术语转换准确率达91%,接近人工翻译水平(参考Apertus-8B模型评测标准)。这种能力使跨境企业无需部署多套语言模型,显著降低系统复杂度。

边缘友好设计

1.2B参数规模支持在消费级GPU甚至高端边缘设备上部署,推理成本仅为同类闭源模型的1/20。某跨境电商实测显示,使用该模型处理多语言客服咨询后,月均AI支出从12万元降至1.8万元,响应速度提升3倍。

结构化提取精准度

通过5项核心指标保证输出质量:语法有效性(JSON/XML/YAML解析成功率)、格式一致性、关键词忠实度、信息完整性和相对质量评分。在5,000份跨领域文档测试中,综合表现超越Gemma 3 27B模型(参数规模是其22.5倍),尤其在医疗报告和法律合同等专业文档处理中优势明显。

行业影响与应用场景

LFM2-1.2B-Extract的出现正在重塑多个行业的数据处理流程:

制造业智能质检

在工业4.0场景中,模型可实时从多语言操作手册中提取设备参数,与传感器数据比对分析,实现预测性维护。某汽车零部件厂商部署后,设备故障率下降28%,生产停机时间减少35%。

跨境电商智能客服

自动提取多语言订单中的关键信息(商品型号、数量、配送地址),生成标准化JSON数据接入企业资源规划系统。试点企业国际订单处理效率提升50%,错误率从8%降至1.2%。

医疗文档结构化

从英文病历中提取用药方案(药物名称、剂量、频率),自动转换为中文电子病历格式。三甲医院测试显示,医生文档处理时间缩短60%,信息提取准确率达94.3%。

从图中可以看出,LFM2-1.2B-Extract处于数据价值挖掘的关键节点,将原本分散在各类文档中的非结构化信息转化为可直接用于业务系统的结构化数据,实现从信息到决策的闭环。

部署与实践指南

企业集成LFM2-1.2B-Extract可通过三种方式:

- Hugging Face Transformers库直接调用

- 下载GGUF格式模型文件用于llama.cpp部署

- 通过Liquid AI LEAP平台获取容器化解决方案

最佳实践建议:

- 使用系统提示明确输出格式(JSON Schema优先)

- 针对专业领域提供2-3条示例数据

- 启用温度参数=0的贪婪解码模式

- 实施定期模型更新(建议每季度)以获取最新语言包

未来趋势与总结

LFM2-1.2B-Extract代表了大模型发展的重要方向——"小而美"的专用模型正在取代"大而全"的通用模型,成为企业级应用的首选。随着边缘计算硬件成本持续下降(预计2027年边缘AI芯片均价将下降45%),这种轻量级智能方案将在更多场景落地。

对于企业决策者,现在正是评估边缘AI部署的最佳时机:通过LFM2-1.2B-Extract等模型实现数据本地化处理,既能满足监管合规要求,又能降低云服务依赖。建议优先在客服、文档处理等重复性工作场景试点,快速验证价值后再向核心业务系统扩展。

该流程图展示了LFM2-1.2B-Extract的典型应用流程:通过自定义提示和少量示例指导模型,从非结构化文本中提取结构化信息,最终赋能检索分析、业务决策等下游应用。这种"提示工程+小样本学习"的模式,大幅降低了企业定制化开发门槛。

轻量级、高精度、多语言的边缘AI模型正在成为企业数字化转型的新引擎。LFM2-1.2B-Extract的推出,不仅提供了技术解决方案,更重新定义了AI部署的成本效益比,为中小企业拥抱智能时代提供了可行路径。

【免费下载链接】LFM2-1.2B-Extract

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考