导语

深度求索(DeepSeek)发布的DeepSeek-R1系列推理模型,通过创新的强化学习技术和知识蒸馏方案,在数学、代码等复杂任务上实现了与行业领先模型相当的性能,同时开源了从基础模型到轻量化蒸馏模型的完整方案,为大语言模型推理能力研究与应用提供了新范式。

行业现状:推理能力成为大模型竞争新焦点

当前大语言模型正经历从"文本生成"向"复杂推理"的能力跃迁。据行业研究显示,2025年推理任务在企业AI应用中的占比已从2023年的32%提升至67%,尤其在金融风控、科学计算、代码开发等领域,对模型逻辑分析、多步推理和自验证能力的需求激增。然而,传统监督微调(SFT)方法在激发模型深层推理能力方面存在瓶颈,导致多数开源模型在复杂任务上与闭源模型差距显著。

强化学习(RL)已成为突破这一瓶颈的关键技术。最新研究表明,通过精心设计的RL训练流程,模型可自主探索解决问题的思维链(CoT),展现出自验证、反思等高级推理行为。DeepSeek-R1系列正是这一技术路线的重要实践,其开源特性为行业提供了宝贵的研究范本。

核心亮点:技术突破与产品矩阵

突破一:无SFT强化学习,推理能力自然涌现

DeepSeek-R1-Zero首次验证了"无监督微调直接强化学习"的可行性——在未经过传统SFT阶段的情况下,直接对基座模型应用大规模RL训练,使模型自发发展出链状推理、自我验证等复杂行为。这种方法绕过了传统SFT对高质量标注数据的依赖,为推理能力培养提供了全新路径。

突破二:多阶段训练解决RL固有挑战

针对纯RL模型存在的输出重复、语言混杂等问题,DeepSeek-R1创新性地引入"冷启动数据+双RL阶段+双SFT阶段"的混合训练 pipeline:

- 冷启动数据:为模型提供基础推理模式种子

- 发现RL:探索最优推理路径

- 对齐RL:优化输出可读性与人类偏好

- 非推理SFT:增强基础语言能力

这一流程使DeepSeek-R1在MATH-500数据集上达到97.3%的Pass@1准确率,超越行业领先模型的96.4%。

突破三:蒸馏技术实现"小模型大能力"

DeepSeek-R1系列最具实用价值的创新在于其知识蒸馏方案。研究团队基于Qwen和Llama系列基座模型,成功将671B参数MoE模型的推理能力迁移至1.5B-70B规模的密集模型,形成完整的性能-效率产品线:

| 模型 | 基座 | AIME 2024 Pass@1 | Codeforces Rating |

|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 28.9% | 954 |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 55.5% | 1189 |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 72.6% | 1691 |

其中32B版本在多项指标上超越轻量化版本,成为目前性能最强的开源密集型推理模型之一,其部署成本仅为全尺寸模型的1/20。

跨领域推理能力验证

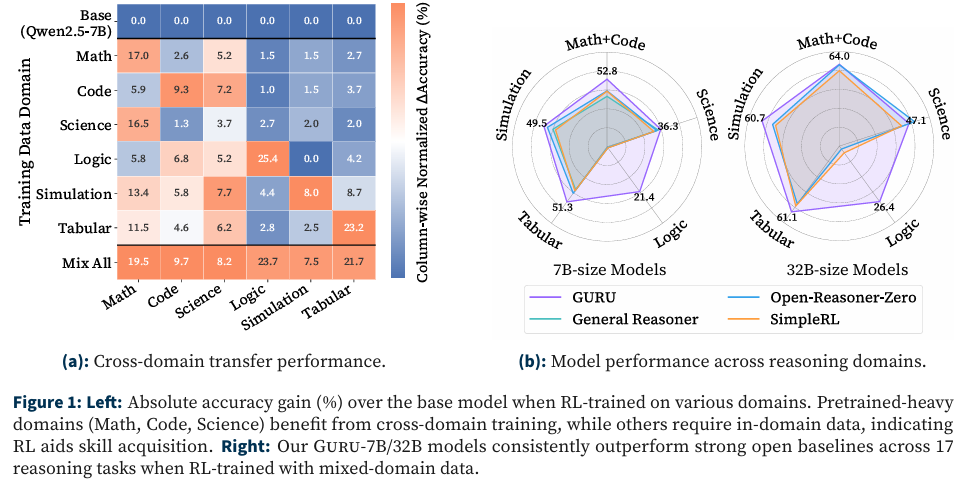

最新研究表明,强化学习在不同推理领域的效果存在显著差异。如图所示:

左侧热力图显示,DeepSeek-R1在预训练中常见的数学、代码领域表现出极强的跨领域迁移能力,而在逻辑、模拟等少见领域则通过领域内数据微调实现性能跃升。右侧雷达图则直观展示了32B蒸馏模型在六大推理领域的均衡表现,尤其在数学推理和代码生成维度达到90%以上的相对性能。这一特性使模型能适应企业复杂多变的实际应用场景。

行业影响与应用前景

降低企业推理应用门槛

DeepSeek-R1的开源策略和蒸馏模型为企业级应用提供了灵活选择:

- 全尺寸模型:适合科研机构和大型企业的前沿探索

- 32B/70B蒸馏模型:满足金融、科技等行业对高精度推理的需求

- 7B/14B轻量模型:可部署于边缘设备,支持实时推理任务

沃尔玛、Shopify等企业已成功应用类似开源模型构建内部智能系统,如代码审查助手、供应链优化决策支持等,ROI普遍达到300%-500%。

推动推理技术普及化

作为首个开源的高性能推理模型,DeepSeek-R1打破了"复杂推理能力仅存在于闭源模型"的现状。其MIT许可证允许商业使用和二次开发,使中小企业和开发者也能构建高性能的推理应用。特别值得注意的是,模型在医疗诊断辅助、工程问题排查等关键领域展现出巨大潜力,如在医学数据解读任务中达到84.0%的准确率(MMLU-Pro指标)。

技术路线启示

DeepSeek-R1的成功验证了两条重要技术路线:一是强化学习可直接激发模型推理能力,无需依赖高质量标注数据;二是大模型的推理模式可有效蒸馏至小模型,解决了"性能-效率"的矛盾。这为行业未来发展指明方向——通过RL探索通用推理机制,再通过蒸馏实现场景化落地。

使用指南与最佳实践

为充分发挥DeepSeek-R1的推理能力,官方推荐以下配置:

- 温度参数:0.5-0.7(推荐0.6),平衡探索性与稳定性

- 提示工程:数学任务建议添加格式约束:"请分步推理,最终答案放于\boxed{}中"

- 推理引导:强制模型以" \n"开头输出,确保完整思维链展开

- 评估方法:多次采样(推荐64次)取平均,提高结果可靠性

社区开发者已基于vLLM和SGLang框架实现高效部署,典型部署命令如下:

# vLLM部署示例

vllm serve deepseek-ai/DeepSeek-R1-Distill-Qwen-32B \

--tensor-parallel-size 2 \

--max-model-len 32768 \

--enforce-eager

总结与展望

DeepSeek-R1系列通过创新的强化学习技术和系统化蒸馏方案,在开源模型中首次实现了与闭源旗舰模型比肩的推理性能,其技术路线和开源策略将加速推理能力在各行业的普及应用。随着社区进一步探索其在多模态推理、跨语言理解等领域的潜力,我们有理由相信,这一模型将成为大语言模型推理研究的重要基石。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/deepseek-ai/DeepSeek-R1

项目地址: https://ai.gitcode.com/hf_mirrors/deepseek-ai/DeepSeek-R1