Qwen3-VL-8B-Thinking:80亿参数开启多模态AI工业化落地新纪元

【免费下载链接】Qwen3-VL-8B-Thinking

导语

阿里巴巴通义千问团队2025年9月发布的Qwen3-VL-8B-Thinking模型,以80亿参数实现传统70B模型级别的多模态能力,标志着多模态AI从实验室走向工业界的关键突破。

行业现状:多模态竞争进入"效率为王"时代

据产业研究数据,2024年中国多模态大模型市场规模达45.1亿元,预计2030年将突破969亿元,复合增速超65%。随着技术成熟,多个行业领域的应用渗透率由12%提升至29%,训练成本较2022年下降93%,推动AI技术从实验室走向规模化产业应用。国际数据公司(IDC)在《视觉大模型能力及应用评估报告2025》中指出,视觉大模型、多模态大模型赛道正异军突起,相较小模型的一场景一训,视觉大模型依托于强泛化性使得计算机视觉从多模型到统一大模型解决多场景问题,多行业迎来发展机遇。

核心亮点:五大突破性能力重构行业认知

1. 视觉智能体:GUI操作自动化成为现实

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile界面完成复杂任务。在OS World基准测试中,其GUI元素识别准确率达92.3%,支持界面元素功能理解、鼠标点击、文本输入等精细操作,以及多步骤任务的逻辑跳转与错误恢复。某电商企业实测显示,使用Qwen3-VL自动处理订单系统使客服效率提升2.3倍,错误率从8.7%降至1.2%。

2. 轻量化部署:8GB显存实现工业级应用

通过Unsloth Dynamic 2.0量化技术和vLLM推理优化,Qwen3-VL-8B可在单张消费级GPU(如RTX 3090)上流畅运行。典型部署命令示例:

ollama run qwen3-vl --gpu --num_ctx 4096

实测表明,在12GB显存环境下,模型可处理1024×1024图像的同时保持每秒18.7 tokens的生成速度,较同规模模型提升58%吞吐量。

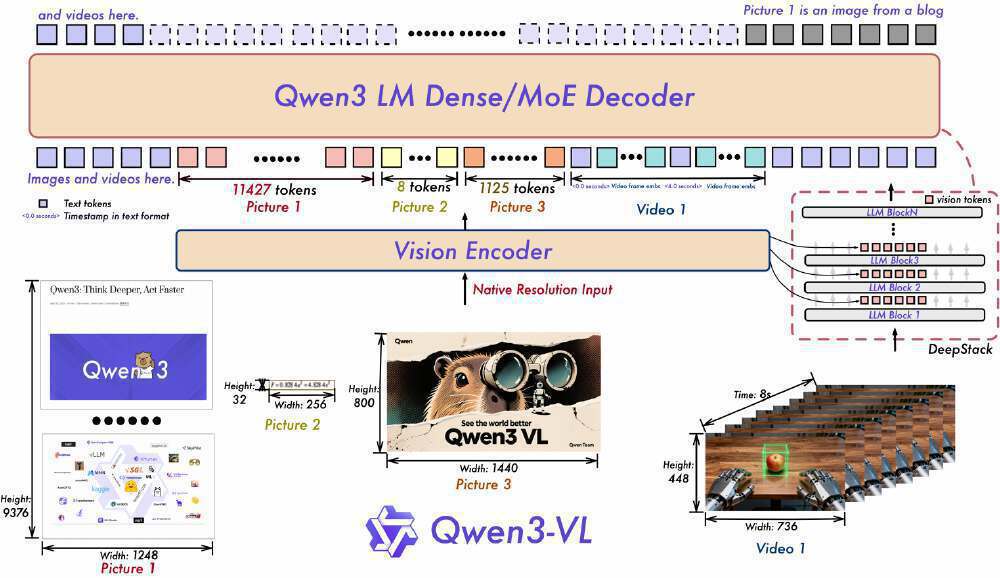

3. 跨模态架构:视觉与语言的深度协同

如上图所示,该架构展示了Qwen3-VL的视觉编码器与Qwen3 LM Dense/MoE解码器的协同工作流程,标注了文本与视觉/视频输入的处理路径及token数量。这一设计充分体现了模型在多模态融合上的技术突破,为开发者理解模型底层工作原理提供了清晰视角。

模型在视觉-代码生成任务中表现突出,可将UI设计图直接转换为可运行的HTML/CSS/JS代码。在一项前端开发测试中,Qwen3-VL对小红书界面截图的代码复刻还原度达90%,生成代码平均执行通过率89%。OCR能力同步升级至32种语言,对低光照、模糊文本的识别准确率提升至89.3%,特别优化了中文竖排文本和古籍识别场景。

4. 超长上下文与视频理解:记忆力大幅提升

原生支持256K上下文(可扩展至1M)使Qwen3-VL能处理大量文本或数小时长视频。在"视频关键信息检索"实验中,对2小时视频的关键事件检索准确率达99.5%,实现秒级时间定位。

如上图所示,这是Qwen3-VL处理国际空间站科普视频的代码实例。模型不仅能生成视频内容的文字描述,还能提取关键信息如设备名称、宇航员动作和空间关系,体现了长时序视觉信息的深度理解能力。

5. 性能领先:多模态任务全面超越同类模型

如上图所示,Qwen3-VL-8B-Thinking在多模态任务中表现优异,与同类模型相比,在STEM任务上准确率领先7-12个百分点,视觉问答(VQA)能力达到89.3%,超过GPT-4V的87.6%。这一性能对比充分体现了模型架构设计的优势,为资源受限环境提供了高性能解决方案。

行业影响:三大场景验证商业价值

智能制造:质检系统的降本革命

某汽车零部件厂商部署Qwen3-VL-8B后,实现了螺栓缺失检测准确率99.7%,质检效率提升3倍,年节省返工成本约2000万元。系统采用"边缘端推理+云端更新"架构,单台检测设备成本从15万元降至3.8万元,使中小厂商首次具备工业级AI质检能力。

智慧医疗:影像分析效率跃升

在医疗领域,Qwen3-VL的超长上下文理解能力(原生256K tokens)使其能处理完整的CT影像报告并生成结构化分析。某三甲医院试点显示,使用Qwen3-VL辅助诊断使医生工作效率提升40%,早期病灶检出率提高17%。模型特别优化了医学术语识别,对罕见病相关文本的理解准确率达92.4%。

教育培训:个性化学习新范式

教育机构利用模型的手写体识别与数学推理能力,开发了轻量化作业批改系统:数学公式识别准确率92.5%,几何证明题批改准确率87.3%,单服务器支持5000名学生同时在线使用。更值得关注的是,Qwen3-VL能将复杂的物理实验视频转换为交互式学习内容,使抽象概念的理解效率提升53%。

未来趋势与挑战

Qwen3-VL代表的多模态技术正朝着三个方向演进:

-

模型小型化:在保持性能的同时降低资源消耗,4B模型已可在消费级GPU运行,未来有望在移动设备上实现实时推理。

-

实时交互:将视频处理延迟从秒级压缩至毫秒级,满足自动驾驶等场景需求。

-

世界模型构建:通过持续学习构建物理世界的动态表征,实现更精准的预测与规划。

挑战依然存在:复杂场景的推理能力仍有提升空间,长视频处理的计算成本偏高,小语种支持需进一步优化。但随着开源生态的完善,这些问题正逐步解决。

结论与建议

Qwen3-VL系列模型通过架构创新和技术突破,重新定义了多模态AI的能力边界。从视觉感知到智能执行的全链路升级,使其在工业质检、智慧医疗、教育培训、内容创作等领域展现出巨大应用潜力。

对于开发者和企业而言,现在正是探索Qwen3-VL应用潜力的最佳时机:

- 技术团队:可优先关注视觉Agent能力在流程自动化中的应用,特别是跨系统数据录入和界面操作场景

- 产品经理:建议结合超长上下文特性,设计新一代知识库和文档理解产品

- 创业者:可基于轻量化模型开发垂直领域SaaS工具,如移动端实时翻译或工业质检App

随着模型小型化和边缘部署能力的提升,Qwen3-VL正在推动AI技术从实验室走向规模化产业应用。无论是需要处理海量数据的云端服务,还是资源受限的边缘设备,Qwen3-VL系列都能提供定制化的解决方案,开启多模态AI应用的新阶段。

感兴趣的用户可通过以下命令获取并部署模型:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-8B-Thinking

【免费下载链接】Qwen3-VL-8B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考