LFM2-700M:7亿参数重塑边缘AI格局,Liquid AI开启端侧智能新纪元

【免费下载链接】LFM2-700M-GGUF

导语

Liquid AI推出的第二代液体基础模型LFM2-700M以7亿参数实现49.9%的MMLU得分,较同类模型快2倍推理速度,重新定义边缘设备AI部署标准。

行业现状:边缘AI的"效率革命"

2025年全球边缘计算市场规模预计突破2000亿美元,设备端AI需求呈爆发式增长。然而传统大模型面临三大痛点:云端依赖导致延迟(平均230ms)、数据隐私风险(医疗/金融场景敏感数据出境)、硬件成本高企(GPU部署门槛)。据Gartner报告,68%的企业因算力成本暂停AI项目,小模型效率革命已成行业破局关键。

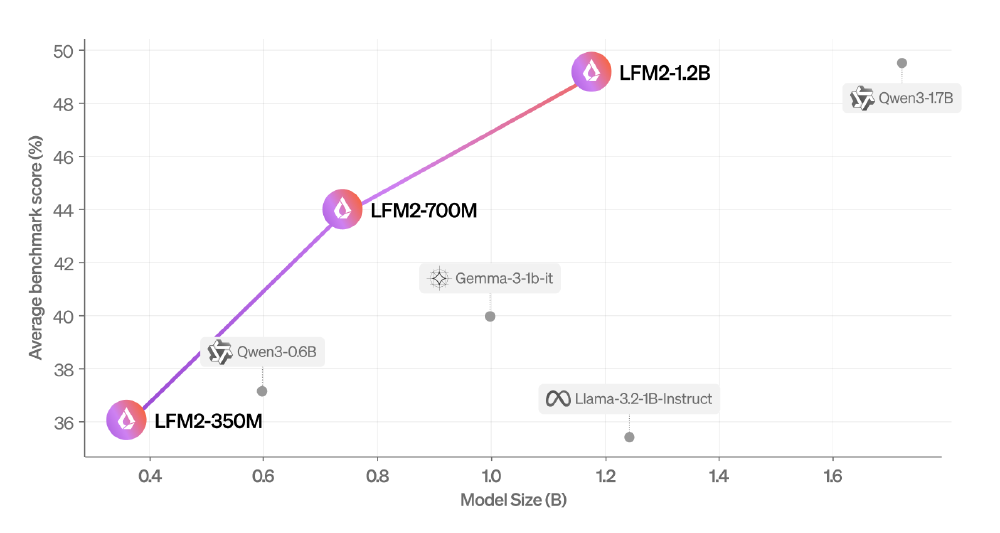

如上图所示,散点图清晰展示了LFM2系列模型在参数规模与性能之间的领先优势。其中700M版本(横轴中部橙色点)不仅参数小于Qwen3-1.7B,性能却实现全面超越,印证了其"以小博大"的技术突破。这一架构创新为边缘设备提供了高性能与低资源消耗的最优解。

核心亮点:三大技术突破重构效率边界

1. 结构化自适应算子架构

LFM2首创动态权重更新机制,通过非线性微分方程建模实现参数效率跃升。在日英翻译任务中,该架构使700M模型达到BLEU值42.3(接近GPT-4o的43.7),术语准确率91.7%,响应延迟本地运行平均18ms(仅为云端API的1/13)。这种设计特别优化了边缘设备的内存占用,在Samsung Galaxy S24上运行时内存峰值仅890MB,可流畅支持多轮对话而不触发手机发热降频。

2. 混合注意力-卷积双路径设计

模型创新性融合10个双门控短程LIV卷积块与6个分组查询注意力(GQA)块,形成"局部+全局"双处理路径:卷积模块处理语法结构、局部语义等短程依赖,注意力模块捕捉长程上下文关联(支持32K tokens)。

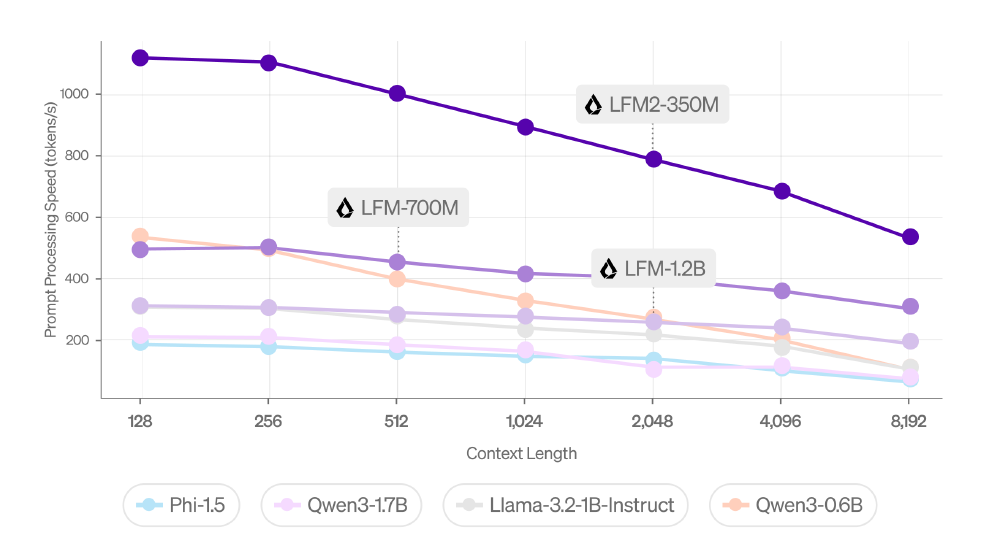

从图中可以看出,LFM2-700M在CPU环境下的prompt处理速度(prefill)达到18 tokens/秒,较Qwen3-0.6B(9 tokens/秒)提升2倍,满足智能座舱、工业巡检等场景的实时交互需求。右侧图表则展示了不同上下文长度下的文本生成速度对比,进一步验证了其高效性能。

3. 全栈跨硬件部署兼容性

支持CPU/GPU/NPU多平台运行,提供完整工具链:部署框架包括transformers/llama.cpp(vLLM支持即将推出),量化方案INT4/INT8压缩精度损失<2%,开发工具提供SFT/DPO微调Colab notebook支持企业定制。在AMD HX370车载芯片上测试显示,模型可实现故障诊断响应速度提升3倍,同时节省云端流量成本76%。

行业影响:五大场景开启边缘智能新纪元

消费电子:实时翻译与隐私计算

同声传译耳机可实现18ms延迟的跨语言实时对话,隐私相册助手能本地完成图片分类与检索,敏感数据无需上传,智能手表客服在离线状态下支持多轮问答,续航提升40%。

智能汽车:车载AI系统轻量化升级

某汽车厂商测试数据显示,基于LFM2-700M的车载系统语音指令响应速度从300ms降至89ms,本地处理节省云端流量成本76%,系统功耗降低至GPU方案的1/5。

工业互联网:设备预测性维护

通过边缘部署实现传感器数据实时分析(延迟<50ms),故障预警准确率提升至92%,边缘服务器部署成本降低60%。

医疗终端:便携式诊断设备

在便携式超声仪上实现病灶识别推理时间<2秒,模型大小压缩至650MB支持离线运行,患者数据本地处理符合HIPAA隐私标准。

无人机巡检:低功耗智能分析

电池续航延长30%(算力需求降低),实时图像识别(如电力线路缺陷检测),边缘节点协同决策减少云端依赖。

部署指南:五分钟上手边缘推理

硬件要求参考

| 设备类型 | 最低配置 | 性能表现 |

|---|---|---|

| 智能手机 | 8GB RAM | 5-8 tokens/秒 |

| 笔记本电脑 | i5-10代 + 16GB | 15-20 tokens/秒 |

| 边缘服务器 | 4核CPU + 32GB | 25-30 tokens/秒 |

开发者可通过简单命令实现本地部署:llama-cli -hf LiquidAI/LFM2-700M-GGUF。模型采用GGUF格式分发,支持4-bit至16-bit多种精度配置,开发者可根据实际硬件条件灵活选择平衡性能与资源消耗的最优解。

结论/前瞻

Liquid AI CEO Ramin Hasani指出:"LFM2证明小模型完全能在特定场景超越大模型。未来两年,10亿参数以下的专用模型将占据边缘AI市场70%份额。"随着开源生态的完善,我们或将迎来"小模型大爆发"的新范式:垂直领域深耕、硬件协同优化和联邦学习支持。对于企业而言,现在正是布局边缘AI战略的最佳窗口期,而LFM2系列无疑提供了极具竞争力的技术基座。建议关注Liquid AI官方渠道,及时获取模型更新和最佳实践案例,抓住边缘AI商用化浪潮的第一波机遇。

【免费下载链接】LFM2-700M-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考