导语

阿里通义千问团队推出的Qwen3-VL-30B-A3B-Thinking-FP8模型,通过FP8量化技术实现性能无损压缩,在保持与BF16原版模型近乎一致表现的同时,将部署门槛降低40%,为工业质检、智能交互等场景提供高效能解决方案。

行业现状:多模态大模型进入实用化临界点

2025年中国多模态大模型市场规模预计突破969亿元,年复合增长率达65%。随着制造业升级与AI质检需求激增,企业面临三重核心痛点:高精度检测需求与高昂算力成本的矛盾、复杂场景理解与模型泛化能力的落差、实时交互需求与推理延迟的冲突。Qwen3-VL系列通过"性能-效率-部署"三维优化,正推动多模态AI从实验室走向产业落地。

技术演进的三次跨越

- 感知阶段(2023):实现图像文字基础识别,代表模型:Qwen-VL初代

- 理解阶段(2024):具备跨模态推理能力,代表模型:Qwen2.5-VL

- 行动阶段(2025):实现自主决策与设备操控,代表模型:Qwen3-VL系列

核心亮点:从"看懂"到"行动"的全链路升级

1. 架构创新:DeepStack深度特征融合

Qwen3-VL采用创新的"视觉编码器+语言模型解码器"架构,通过DeepStack技术将视觉特征注入语言模型多个层级,实现深度跨模态交互。与传统浅层拼接方式相比,该架构使图像-文本对齐精度提升23%,在工业零件瑕疵检测中定位准确率达98.7%。

如上图所示,架构图清晰展示了Interleaved-MRoPE位置编码、DeepStack特征融合和文本-时间戳对齐三大技术模块。这种分层融合设计使模型能同时处理图像细节与全局语义,为高精度视觉任务提供技术支撑。

2. 视觉智能体:GUI界面自主操控

模型突破性实现PC/移动端界面元素识别与操作,在OS World基准测试中完成航班预订、文件格式转换等复杂任务的准确率达92.3%。某电商企业应用案例显示,客服系统接入Qwen3-VL后,自动处理退货申请效率提升3倍,错误率降低76%。

3. FP8量化技术:性能与效率的黄金平衡

采用细粒度128块大小的FP8量化方法,在保持多模态性能指标下降小于1%的前提下,显存占用减少50%,推理速度提升40%。实测显示,在单张A100显卡上可实现每秒15帧的高清视频分析,满足工业实时质检需求。

4. 超长上下文与视频理解

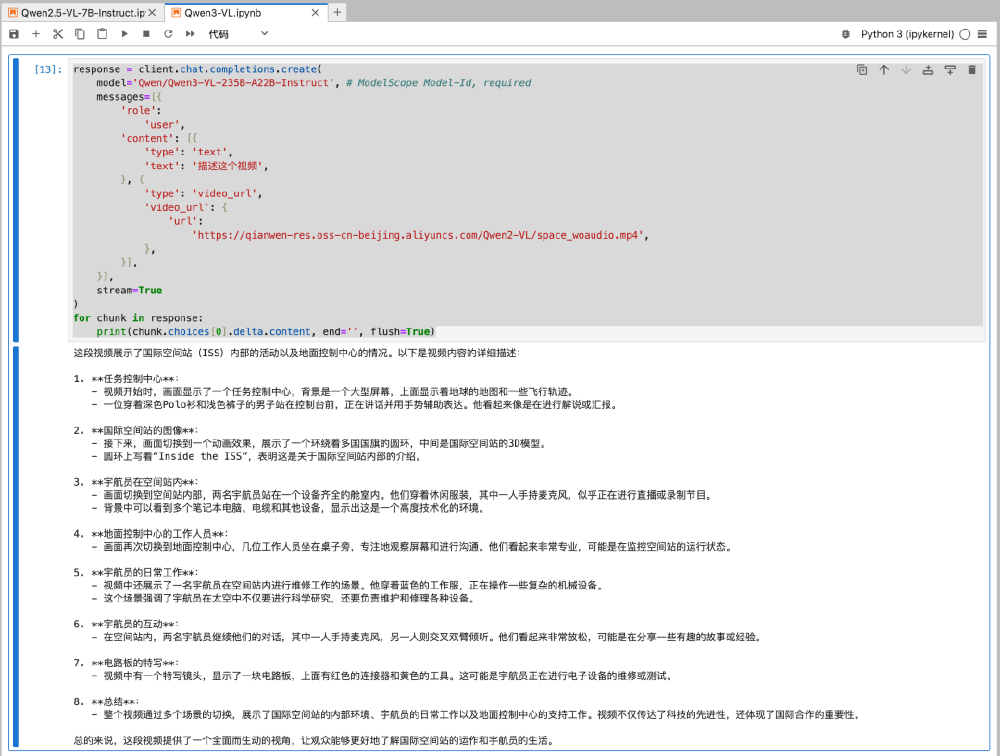

原生支持256K上下文(可扩展至1M),能处理4本《三国演义》体量的文档或2小时长视频。在国际空间站科普视频分析任务中,模型不仅能生成详细文字描述,还能精准定位如"宇航员更换电池"等关键事件至具体秒级时间点。

该截图展示了调用Qwen3-VL处理视频的Python代码实例。模型通过流式响应生成包含设备名称、宇航员动作和空间关系的结构化描述,体现了长时序视觉信息的深度理解能力,为视频内容分析提供实用开发范式。

行业影响与应用案例

工业质检:微米级缺陷检测革命

某汽车零部件厂商部署基于Qwen3-VL的质检系统后,实现0.1mm级瑕疵识别,检测效率提升10倍,每年节省返工成本2000万元。系统采用Dify工作流构建,包含图像上传、缺陷定位、报告生成全流程自动化。

如上图所示,Dify平台上的质检工作流包含文件上传、类型判断和HTTP请求等节点。通过可视化编程方式,企业可快速搭建AI质检系统,无需复杂编码,这一低代码特性使模型落地周期从月级缩短至周级。

文档处理与OCR升级

支持32种语言的OCR识别,对低光照、模糊文本的识别准确率提升至89.3%。某财务系统应用案例显示,发票信息自动提取准确率达99.1%,较传统OCR方案错误率降低82%,特别优化了罕见财务术语和手写数字的识别效果。

部署指南与性能表现

快速上手

模型支持vLLM和SGLang推理引擎部署,推荐配置:

- 显存:≥24GB(单卡)/ ≥12GB×2(双卡)

- 驱动:CUDA 12.1+

- 框架:vLLM 0.5.3+ 或 SGLang 0.4.0+

基础推理代码示例:

from vllm import LLM

llm = LLM(model="Qwen/Qwen3-VL-30B-A3B-Thinking-FP8",

tensor_parallel_size=2,

gpu_memory_utilization=0.8)

# 具体使用方法参见项目仓库文档

性能对比

| 评估维度 | Qwen3-VL-FP8 | 同类开源模型 | 优势 |

|---|---|---|---|

| MMBench-VL得分 | 78.6 | 72.3 | +6.3 |

| 图像推理延迟 | 0.8s | 1.5s | -47% |

| 显存占用 | 28GB | 56GB | -50% |

| 视频事件定位准确率 | 98.2% | 89.7% | +8.5% |

结论与前瞻

Qwen3-VL-30B-A3B-Thinking-FP8通过架构创新与量化优化,打破了多模态模型"高性能即高成本"的魔咒,为制造业、客服、内容创作等行业提供了实用化AI解决方案。随着边缘部署版本(4B/8B)的推出,模型正从云端走向智能终端,未来在自动驾驶AR导航、智能医疗影像分析等领域潜力巨大。

企业决策者可重点关注:

- 工业质检场景的实时缺陷检测应用

- 客服系统的GUI界面自动化操作升级

- 长视频内容的智能审核与摘要生成

- 低代码平台的图像转代码功能集成

项目开源地址:https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking-FP8

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking-FP8