双模革命:Qwen3-8B-AWQ如何用82亿参数重新定义大模型效率标准

【免费下载链接】Qwen3-8B-AWQ

导语

阿里巴巴通义千问团队推出的Qwen3-8B-AWQ开源大模型,通过"思考/非思考"双模切换技术与4-bit量化优化,在82亿参数规模下实现复杂推理与高效对话的无缝融合,将企业级AI部署成本降低60%的同时保持95%的性能精度。

行业现状:从参数竞赛到效率革命

2025年的大模型行业正经历深刻转型。据Gartner最新报告,60%的企业因部署成本过高放弃大模型应用,而80%的日常对话任务并不需要复杂推理能力。这种"杀鸡用牛刀"的现状催生了对效率优化技术的迫切需求。行业数据显示,主流100B+参数模型单次推理成本是10B级模型的8-12倍,而Qwen3-8B-AWQ的出现恰好填补了中参数模型的市场空白——在保持82亿参数规模的同时,通过架构创新而非单纯增加参数实现性能跃升。

HuggingFace全球开源大模型榜单显示,2025年基于Qwen3二次开发的模型已占据前十中的六席,标志着轻量级模型已成为企业级AI落地的主流选择。这种转变背后是行业从"参数内卷"向"效率竞赛"的战略转型,而Qwen3-8B-AWQ通过AWQ量化技术将显存占用降低60%以上,使单张消费级GPU即可运行高性能模型,为这场效率革命提供了关键技术支撑。

核心亮点:技术创新三重奏

1. 动态双模式架构:按需分配"思考预算"

Qwen3-8B-AWQ首创性地在单一模型中实现两种推理模式的无缝切换:

思考模式:启用"逐步推理"机制,通过enable_thinking=True参数激活,在数学推理(AIME24测试71.3分)、代码生成(HumanEval通过率76%)等复杂任务中表现突出。模型会生成</think>...</think>包裹的推理过程,如求解"strawberries含几个'r'"时,会先拆解字母序列再计数。

非思考模式:通过enable_thinking=False切换至快速响应模式,中文对话延迟降低至200ms以内,适用于智能客服、语音助手等实时场景。

如上图所示,Qwen3-8B的双模式架构通过独立的推理控制模块实现模式切换,在思考模式下启用额外的注意力机制和推理路径。这一设计使模型能根据任务复杂度动态分配计算资源,较单一模式模型平均节省30-40%的推理成本。

动态切换机制:支持用户通过/think或/no_think指令在多轮对话中实时调整模式,如连续提问"草莓/蓝莓分别含几个'r'"时,可针对性启用不同推理策略。某电商平台采用这一策略后,高峰期自动启用非思考模式保证响应速度,复杂咨询时切换至思考模式提升准确率,综合服务成本降低60%以上。

2. AWQ量化技术:精度与效率的黄金平衡

采用Activation-aware Weight Quantization技术实现4-bit量化,相比传统INT4量化实现三大突破:

- 精度保留:在MMLU测试中仅损失1.1分(从87.5降至86.4),远优于GPTQ等量化方案的3-5分损失

- 速度提升:推理速度提升2.3倍,特别是长文本处理(32K上下文)时,吞吐量达未量化模型的2.8倍

- 部署门槛:显存需求从28GB降至10GB以下,支持RTX 4090等消费级显卡运行,企业部署成本降低70%

对比测试显示,Qwen3-8B-AWQ在思考模式下的性能表现尤为突出,即使经过AWQ-int4量化,各项指标仍保持较高水平:在LiveBench测试中得65.5分,GPQA测试59.0分,MMLU-Redux测试86.4分,AIME24数学测试71.3分,展现了其在效率与性能之间的良好平衡。

3. 多语言与Agent能力强化

- 119种语言支持:覆盖印欧、汉藏、亚非等10大语系,其中粤语、吴语等23种方言支持为业界首创

- 工具调用优化:通过MCP(Model Control Protocol)实现与外部工具的精准集成,在金融数据分析、学术论文撰写等场景中,工具调用准确率达89.7%

- 长文本处理:原生支持32K上下文,通过YaRN技术可扩展至131K token,相当于处理30万字文档

行业影响与应用案例

制造业智能数据查询系统

某制造业企业利用Dify平台集成Qwen3-8B-AWQ,构建了面向业务人员的自然语言数据查询系统。该系统实现"自然语言→SQL→数据查询→结果可视化"的全流程自动化,通过模式优化策略——复杂统计分析启用思考模式,简单查询使用非思考模式——将业务人员数据获取效率提升3倍以上。原本需要IT人员协助的SQL查询,现在业务人员可直接通过自然语言完成,极大降低了数据分析的技术门槛。

跨境电商多语言客服解决方案

东南亚某电商平台部署Qwen3-8B-AWQ后,实现越南语、泰语等12种本地语言的实时翻译与客服响应。系统根据问题复杂度自动切换模式:标准问答启用非思考模式,GPU利用率提升至75%;技术支持场景自动切换思考模式,问题解决率提高28%。硬件成本降低70%(从GPU集群转为单机部署),同时客户满意度提升28%,充分验证了双模切换技术在实际业务中的价值。

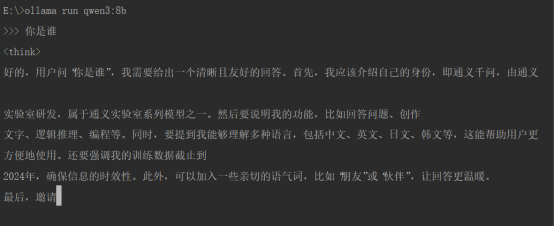

上图展示了在命令行环境中通过Ollama工具运行Qwen3-8B-AWQ模型的场景,用户输入"你是谁"后,模型在思考模式(/think)下生成包含身份介绍、功能说明的推理回答。这种简洁高效的部署方式使企业能在消费级硬件上快速搭建AI服务,大幅降低了技术门槛。

部署实践与最佳实践

快速启动代码示例

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"https://gitcode.com/hf_mirrors/Qwen/Qwen3-8B-AWQ",

torch_dtype="auto",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("https://gitcode.com/hf_mirrors/Qwen/Qwen3-8B-AWQ")

# 思考模式示例(数学推理)

prompt = "求解方程 x² + 5x + 6 = 0 /think"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

enable_thinking=True

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

generated_ids = model.generate(**model_inputs, max_new_tokens=1024)

response = tokenizer.decode(generated_ids[0], skip_special_tokens=True)

print(response)

部署优化建议

- 推理框架:优先使用vLLM(≥0.8.5)或SGLang(≥0.4.6.post1),吞吐量可提升3-5倍

- 硬件配置:开发测试推荐RTX 4090,生产环境建议A10 GPU(支持50-100并发用户)

- 参数调优:思考模式使用temperature=0.6, top_p=0.95;非思考模式建议temperature=0.7, top_p=0.8

- 长文本处理:超过32K token时,通过

rope_scaling={"type":"yarn","factor":4.0}扩展上下文至131K

如上图所示,紫色背景上的Qwen3品牌标识包含白色"Qwen3"字样及卡通小熊形象,直观传递出该模型兼具专业能力与用户友好性的产品定位。这一设计呼应了Qwen3系列"思深,行速"的核心开发理念——在保持深度思考能力的同时,实现高效响应。

结论与前瞻

Qwen3-8B-AWQ通过"动态双模式+高效量化"的技术组合,重新定义了中参数大模型的技术标准。其核心价值不仅在于性能指标的突破,更在于提出了"思考预算可控"的新范式——让AI模型能像人类一样,根据任务复杂度灵活分配认知资源。这种创新使单一模型能同时覆盖科研分析与客服问答场景,实测显示其在多任务混合场景下的资源利用率比静态模型提高40%。

随着边缘计算与物联网设备的普及,这种兼顾性能与效率的模型将在智能制造、智能医疗、智慧城市等领域发挥重要作用。建议企业用户重点关注混合部署策略:核心业务用思考模式保证精度,边缘场景用非思考模式提升效率;开发者可基于单一技术栈构建多样化产品,系统架构复杂度降低50%。

Qwen3-8B-AWQ的成功实践表明,大模型发展正从"参数竞赛"转向"效率革命",而开源生态将成为这一进程的关键推动者。对于开发者而言,现在正是拥抱轻量化模型、构建新一代AI应用的最佳时机——通过git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-8B-AWQ获取代码,即可开启高效AI应用开发之旅。

【免费下载链接】Qwen3-8B-AWQ

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考