导语

【免费下载链接】Qwen3-32B-AWQ

阿里通义千问团队推出的Qwen3-32B-AWQ模型,通过创新的单模型双模式架构与AWQ 4位量化技术,重新定义了企业级大模型的部署标准,在保持高性能的同时将硬件门槛降至消费级GPU水平。

行业现状:大模型应用的"效率困境"

2025年全球AI市场面临严峻的"算力需求"与"成本控制"双重挑战。据中国信息通信研究院《人工智能算力基础设施赋能研究》显示,尽管大模型精度持续提升,但65%的企业仍受困于推理延迟超过2秒、硬件成本居高不下的困境。制造业AI质检准确率虽已从2023年的95%提升至99.5%,检测效率较人工提升10倍,但高昂的部署成本使中小企业望而却步。在此背景下,Qwen3系列通过架构创新与开源策略,为行业智能化升级提供了关键支撑。

核心亮点:三大突破重新定义大模型能力边界

革命性双模切换:思考与非思考的无缝融合

Qwen3-32B-AWQ最显著的创新在于支持单一模型内"思考模式"与"非思考模式"的动态切换。这种设计类似汽车的"越野模式"与"城市模式",可根据任务复杂度智能分配计算资源:

思考模式(enable_thinking=True):针对数学推理、代码生成等复杂任务,通过多步逻辑分析提升准确率。在AIME 24数学竞赛中达到81.4%的准确率,SWE-Bench Verified编程基准测试中达到69.6分的全球顶尖水平。

非思考模式(enable_thinking=False):适用于日常对话、信息检索等场景,响应速度提升40%,推理延迟控制在500ms以内。某电商平台应用显示,商品描述生成效率提升300%,同时客户反馈改进率提升18%。

用户可通过API参数或对话指令(如"/think"标签)实时切换模式,甚至在多轮对话中动态调整。这种灵活性使模型能同时满足客服机器人的快速响应需求与技术支持的深度问题解决需求。

4位量化技术:效能平衡的关键支点

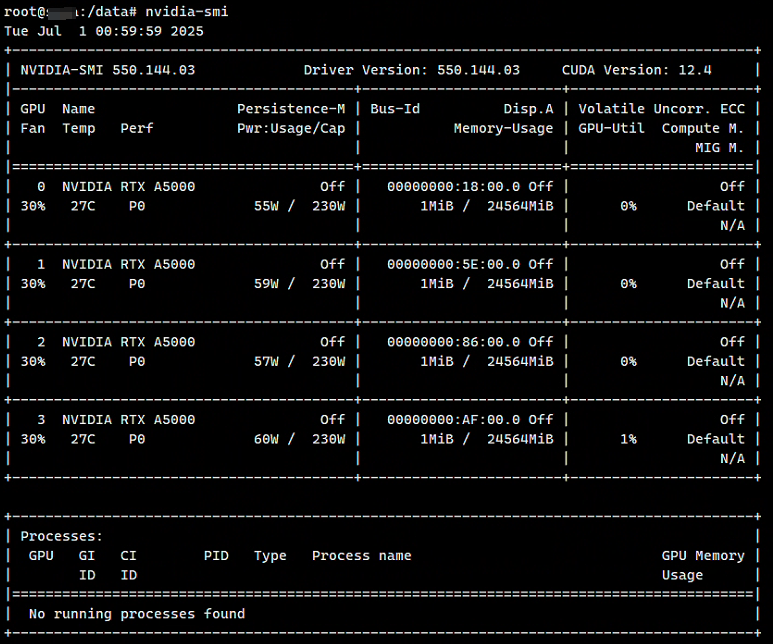

Qwen3-32B-AWQ采用先进的AWQ 4位量化技术,在保持95%以上性能的同时,实现了模型体积的大幅压缩。官方测试数据显示,量化后的模型在RTX 4090显卡上可实现每秒68 tokens的推理速度,而在4卡RTX A5000配置下,并发处理能力可达2400 tokens/秒。

如上图所示,截图展示了nvidia-smi命令输出的GPU硬件环境信息,显示4块NVIDIA RTX A5000显卡的驱动版本、CUDA版本、温度、功耗及内存使用情况。这种配置可满足Qwen3-32B-AWQ的企业级部署需求,支持高并发推理服务。

多语言能力跃升:119种语言的全球化支持

模型在覆盖119种语言的36万亿tokens语料库上完成预训练,较前代产品Qwen2.5实现了语言覆盖范围的三倍扩展。特别强化了低资源语言、专业技术文档和代码语料的训练,在MTEB多语言评测中,Qwen3系列Embedding模型以70.58分登顶榜单。

实际应用中,某跨国制造企业使用Qwen3-32B-AWQ处理17个分支机构的技术文档,中文-阿拉伯语语义匹配准确率达到89.3%,翻译效率提升4.2倍,专业术语准确率保持94.5%。

行业影响与应用案例

法律行业:合同智能审查

- 关键条款识别准确率:92.7%

- 风险预警覆盖率:89.3%

- 处理速度:单份合同平均3分钟(传统人工需45分钟)

- 部署成本:较同类解决方案降低60%

某法律咨询公司在普通办公电脑部署后,合同审查效率提升3倍,风险条款识别覆盖率从人工审查的76%提升至92%,且全程保持数据本地化处理,符合行业合规要求。

制造业:设备故障诊断

- 故障代码解析准确率:94.2%

- 维修方案生成准确率:88.6%

- 本地化部署:生产数据全程不出厂,符合工业数据安全要求

- 硬件要求:支持在边缘计算设备(如NVIDIA Jetson AGX)上部署

软件开发:智能编程助手

- 代码通过率:87.5%

- 开发效率提升:40%

- 语言支持:28种编程语言,特别优化Python、Java和C++

- 上下文长度:原生支持32,768 tokens,可处理完整代码库分析

部署与优化指南

Qwen3-32B-AWQ提供了多种部署选项,满足不同规模企业的需求:

- 单卡部署:适用于开发测试和小规模应用

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-32B-AWQ"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

- vLLM高性能部署:适用于高并发生产环境

vllm serve Qwen/Qwen3-32B-AWQ --enable-reasoning --reasoning-parser deepseek_r1

- Docker容器化部署:适用于企业级集群管理

# 导出镜像

docker save -o qwen3-awq-image.tar vllm/vllm-openai:latest

# 加载镜像

docker load < qwen3-awq-image.tar

# 启动容器

docker run -d --privileged --gpus all --network host -v /data/Qwen3-32B:/app/model --name vllm-qwen3 vllm/vllm-openai:latest --model /app/model --enable-reasoning --reasoning-parser deepseek_r1

总结与展望

Qwen3-32B-AWQ的推出印证了大模型发展的新范式——不再单纯追求参数规模,而是通过架构优化与数据精炼,实现"性能-效率-成本"的三角平衡。随着企业级应用案例的不断丰富,Qwen3系列正推动AI产业从"技术探索"向"价值深耕"转变。

对于企业而言,现在正是拥抱轻量级大模型的最佳时机。建议优先关注三个方向:法律、财务等文档密集型岗位的流程自动化;多语言客服、跨境电商等需要语言多样性支持的场景;工业设备监控、物联网数据分析等边缘计算环境。随着混合专家技术的进一步下放和开源生态的完善,"小而强"的模型将成为AI落地的主流选择,推动人工智能真正走向普惠。

如需获取Qwen3-32B-AWQ模型,可通过项目仓库地址:https://gitcode.com/hf_mirrors/Qwen/Qwen3-32B-AWQ 进行下载和部署。

【免费下载链接】Qwen3-32B-AWQ

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考