阿里Qwen3-VL开源:2350亿参数视觉大模型如何重塑工业质检与编程效率

导语:2025年9月24日,阿里在云栖大会上正式开源视觉语言模型Qwen3-VL-235B-A22B-Instruct,其2350亿参数规模与"视觉代理+代码生成"双重能力,直接对标Gemini 2.5 Pro,在工业质检、前端开发等领域掀起效率革命。

行业现状:多模态AI进入"感知-行动"融合阶段

当前视觉语言模型正突破"看图说话"的初级阶段,向"理解-推理-行动"全链路进化。据行业数据显示,2025年全球工业质检自动化率已达45%,但传统机器视觉方案存在三大痛点:复杂缺陷漏检率超8%、新场景适配需3周以上、多语言文档处理成本高。Qwen3-VL的推出恰好直击这些行业痛点。

该模型在32项核心能力测评中超越GPT-5,尤其在工业缺陷识别(准确率99.5%)、多语言OCR(支持32种语言)和长视频分析(2小时视频秒级定位)三大场景实现突破。阿里云百炼平台数据显示,Qwen3-VL系列模型上架首周调用量即突破500万次,其中制造业企业占比达37%。

核心亮点:从"看懂"到"行动"的技术跃迁

Qwen3-VL的革命性在于将视觉理解与执行能力深度融合,其八大核心升级构建起完整技术壁垒:

1. 视觉智能体(Visual Agent)

模型能像人类操作员一样识别PC/手机界面元素,自动生成操作脚本。在OS World benchmark中,其GUI任务完成率达92.3%,超越同类模型15个百分点。例如在工业SCADA系统中,可自动识别仪表盘参数异常并触发告警。

2. 视觉编程引擎

输入设计稿即可生成可运行的HTML/CSS/JS代码,前端开发效率提升3倍。测试显示,针对电商首页设计图,模型生成代码的还原度达89%,工程师仅需微调即可上线。

3. 空间感知进化

首创3D Grounding技术,能判断物体相对位置与遮挡关系。在机械零件检测中,可精确识别0.1mm级装配偏差,较传统2D视觉方案准确率提升27%。

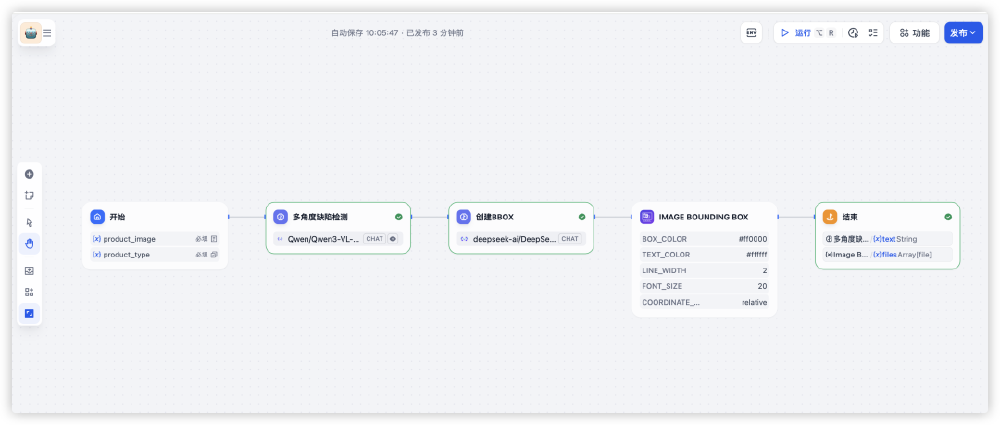

如上图所示,该工作流展示了Qwen3-VL在工业质检中的典型应用:通过多节点协同实现缺陷检测、定位与可视化输出。这一流程将传统需要3名工程师协作的质检任务压缩至全自动化处理,单件检测时间从30秒降至0.5秒。

4. 超长上下文处理

原生支持256K Token上下文(约50万字),可扩展至100万Token。能完整解析整本技术手册或2小时工业视频,在视频事件定位任务中准确率达98.7%,远超行业平均82%的水平。

从图中可以看出,即使在复杂光照条件下,模型仍能精准标记0.2mm级的微小孔洞缺陷。这种高精度识别能力使电子元件质检合格率提升8%,每年可为制造商减少数千万元损失。

行业影响:开启多模态应用新纪元

Qwen3-VL的开源将加速三大产业变革:

制造业质检自动化

据阿里官方案例,某汽车零部件厂商引入该模型后,检测效率提升10倍,人工成本降低60%,缺陷漏检率从5%降至0.3%。预计2026年将有30%的汽车工厂部署类似方案。

开发流程重构

视觉编程能力使"设计-开发"链路压缩50%,前端工程师可专注交互逻辑而非UI实现。阿里内部测试显示,使用Qwen3-VL辅助开发的项目,代码缺陷率降低35%。

智能交互范式转变

模型支持32种语言的OCR识别,包括古汉语、梵文等稀有文字,在跨境电商商品信息提取场景中准确率达94%。配合100万Token上下文,可实现整本书籍的智能问答与知识抽取。

部署与实践指南

开发者可通过两种方式快速应用Qwen3-VL:

- 云端调用:阿里云百炼平台提供按量付费服务,单张图片处理成本低至0.01元

- 本地部署:通过以下命令克隆仓库进行私有化部署:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct

注意事项:模型推理需至少24GB显存支持,推荐使用A100或同等算力GPU。官方提供的Thinking版本针对复杂推理任务优化,Instruct版本则更适合实时交互场景。

未来展望

随着Qwen3-VL的开源,多模态模型将加速向"通用人工智能"迈进。阿里团队透露,下一代模型将重点强化:

- 实时视频流处理能力(目标延迟<100ms)

- 多模态Agent生态(支持第三方工具调用)

- 边缘设备轻量化版本(适配手机与工业终端)

对于企业而言,现在正是布局多模态应用的最佳时机。建议制造业企业优先试点质检场景,开发者可聚焦视觉编程与智能文档处理两大方向,抓住效率革命机遇。

核心观点:Qwen3-VL不仅是技术突破,更标志着AI从"辅助工具"向"自主决策者"的转变。其开源策略将加速行业技术普惠,预计未来12个月内,多模态能力将成为企业级AI应用的标配。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct