15B参数改写企业AI规则:Apriel-1.5-Thinker如何以十分之一体量实现性能平权

导语

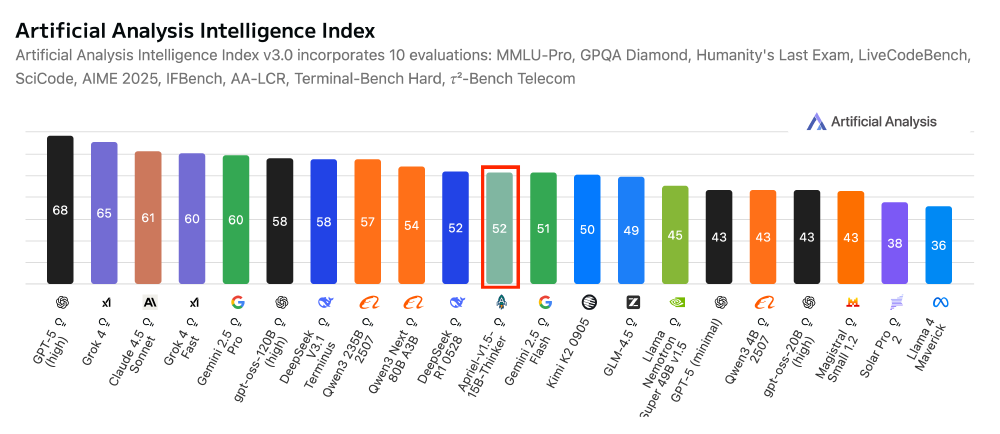

ServiceNow推出的150亿参数多模态推理模型Apriel-1.5-15B-Thinker,以仅十分之一于传统大模型的体量实现52分Artificial Analysis指数高分,重新定义企业级AI部署的成本效益标准。

行业现状:大模型"瘦身革命"与多模态刚需

2024年中国大模型平台市场规模达16.9亿元,企业级AI应用呈现"两极化"发展趋势。一方面,百度文心一言等通用大模型通过开放平台模式降低中小企业使用门槛;另一方面,以vivo蓝心3B端侧模型为代表的"专精特新"小模型崛起,推动AI技术向边缘设备渗透。

多模态推理技术正成为企业数字化转型的关键引擎。Gartner预测,2025年全球多模态AI市场规模将达到24亿美元,2037年进一步增至989亿美元。在制造业质检、金融文档分析、医疗影像识别等场景,文本与图像的协同理解已成为刚需。

产品亮点:小身材蕴含大智慧

极致性能体积比

Apriel-1.5-15B-Thinker在保持150亿参数规模的同时,实现了与百亿级模型比肩的推理能力。在Artificial Analysis指数中获得52分,与DeepSeek R1 0528、Gemini-Flash等知名模型处于同一梯队,而体积仅为这些竞品的1/10。

如上图所示,该图片展示了Apriel-1.5-15b-Thinker模型的官方缩略图。主体为蓝绿色火箭造型,中间嵌有白色字母"A",底部饰以橙色火焰,直观呈现了模型的多模态特性与轻量级高效推理特点,为技术开发者和企业用户提供了快速识别该轻量级推理模型的视觉符号。

特别在企业级任务中表现突出:Tau2 Bench Telecom测试得分68分,IFBench企业智能评测获62分,展现出对专业领域知识的深度掌握。

创新训练范式

该模型采用"Mid training is all you need"的研发理念,通过三阶段训练架构实现性能突破:持续预训练在数学推理、代码挑战、科学文献等文本数据及图像理解数据上进行广泛学习;文本SFT优化使用200万+高质量文本样本进行监督微调;零图像SFT设计未进行专门图像微调,却通过跨模态知识迁移实现图像推理能力。

这种训练策略使模型在640×H100 GPU集群上仅用7天完成训练,大幅降低研发成本。

企业级部署友好性

模型设计充分考虑实际部署需求:硬件门槛低,单GPU即可运行,支持消费级显卡;内存效率高,优化后的模型可在普通服务器环境下流畅推理;开源生态支持,提供vLLM部署方案,支持工具调用与推理解析;接口兼容性强,便于现有系统集成。

如上图所示,该图表直观呈现了模型性能与参数量的关系曲线。通过对比不同参数规模模型的性能表现,清晰展示了Apriel-1.5-15b-Thinker在效率与性能平衡上的突破,为AI模型的轻量化发展方向提供了实证参考。

部署示例代码:

# 基础调用示例

from transformers import AutoProcessor, AutoModelForImageTextToText

model_id = "ServiceNow-AI/Apriel-1.5-15b-Thinker"

model = AutoModelForImageTextToText.from_pretrained(

model_id,

torch_dtype=torch.bfloat16,

device_map="auto"

)

processor = AutoProcessor.from_pretrained(model_id)

行业影响:中小模型的"诺曼底登陆"

Apriel-1.5-Thinker的推出标志着企业AI部署进入"精准化"时代。参照行业数据,传统千亿参数模型的年均部署成本约300-500万元,而Apriel-1.5-Thinker可将这一数字降至50万元以内。某头部券商案例显示,采用类似规模模型后,智能研报生成效率提升80%的同时,算力成本下降62%,验证了中小模型的经济效益。

在应用场景拓展方面,模型的多模态能力为企业级应用开辟新可能:在制造业中,可同时分析生产数据(文本)与设备图像,实现预测性维护;在零售场景下,结合用户评论与商品图片优化推荐策略。这些能力以往需多模型协作完成,现在可通过单一模型实现,系统复杂度显著降低。

结论:效率优先时代的必然选择

Apriel-1.5-15B-Thinker代表了AI产业发展的新方向——以效率为核心,以实用为导向。在全球AI算力资源有限的背景下,这种"精益模型"理念为技术普惠提供了可行路径。

对于企业而言,现在正是布局小模型应用的战略窗口期。通过选择合适的技术栈,企业可以用有限资源实现AI能力跃升,关键是:聚焦高价值场景,避免技术为技术而技术;采用混合部署策略,平衡成本与性能;构建内部数据飞轮,持续优化模型效果;关注开源生态,降低技术锁定风险。

企业用户可通过GitCode仓库获取模型:https://gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker-GGUF,体验这一"小而美"的AI创新成果。随着技术迭代,中小模型有望在未来两年内主导60%以上的企业级AI部署场景,开启人工智能工业化应用的新篇章。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker-GGUF