210亿参数轻量化突围:ERNIE-4.5-21B-A3B-Thinking重塑AI推理格局

导语

百度ERNIE-4.5-21B-A3B-Thinking以210亿总参数、仅30亿激活参数的创新设计,在复杂推理任务中实现性能跃升,重新定义大模型效率与能力的平衡标准。

行业现状:大模型的"轻量化突围"

2025年上半年,大语言模型领域呈现"双轨并行"发展态势:一方面,GPT-4等密集型模型参数规模突破万亿,单次推理能耗高达3.2kWh;另一方面,企业级应用普遍面临"算力饥渴"与"成本约束"的矛盾。中国电子技术标准化研究院数据显示,85%的中小企业因GPU资源不足无法部署先进AI模型,而现有轻量化方案在复杂推理任务中的准确率平均落后旗舰模型40%以上。

在此背景下,百度推出的ERNIE-4.5-21B-A3B-Thinking通过混合专家(MoE)架构实现关键突破——210亿总参数中仅激活30亿参数/Token,在保持推理精度的同时将计算成本降低67%。这种"按需激活"的设计思路,被行业分析师视为突破大模型产业化瓶颈的关键路径。

核心参数对比:小身材与大能量的平衡

如上图所示,该表格清晰展示了ERNIE 4.5系列不同模型在多模态支持、MoE架构及思考模式等维度的技术特性。其中ERNIE-4.5-21B-A3B-Thinking以21B总参数实现3B激活参数的动态调配,在保持轻量化优势的同时,支持128K超长上下文理解,为复杂场景推理提供了硬件友好的解决方案。

模型亮点:三大核心能力重构轻量化模型边界

1. 异构MoE架构:参数效率的革命性突破

ERNIE-Thinking采用创新的64文本专家+2共享专家配置,通过动态路由机制为不同输入匹配最优计算资源。模型配置表显示,其在保持21B总参数规模的同时,实现了与47B密集型模型相当的推理能力:

| 关键指标 | ERNIE-Thinking | 传统密集型模型(47B) | 提升幅度 |

|---|---|---|---|

| 总参数量 | 21B | 47B | -55% |

| 单次推理能耗 | 0.8kWh | 2.1kWh | -62% |

| 长文本处理速度 | 28 tokens/秒 | 15 tokens/秒 | +87% |

这种架构优势在医疗影像分析场景中尤为显著。某省人民医院部署类似MoE架构的ERNIE-4.5-VL解决方案后,早期肺癌检出率提升40%,诊断耗时从45分钟压缩至8分钟,其核心就在于专家动态调度机制实现了影像细节与病历文本的深度关联。

2. 128K超长上下文:重新定义长文本理解标准

得益于131072 tokens上下文窗口设计,ERNIE-Thinking可完整处理500页合同文档或200篇学术论文的综述分析。在金融领域测试中,模型能一次性比对10年财报数据并生成趋势分析报告,关键信息提取准确率达91.7%,较8K窗口模型效率提升470%。

3. PLAS技术重构推理效率

ERNIE-4.5-21B-A3B-Thinking引入创新的PLAS(可插拔轻量级稀疏注意力)机制,通过智能分块与相关性筛选,将长文本推理速度提升36%。在InfiniteBench基准测试中,其端到端延迟从61.4秒降至42.16秒,而LongBenchV2任务精度仅损失0.03分,实现"无损加速"。

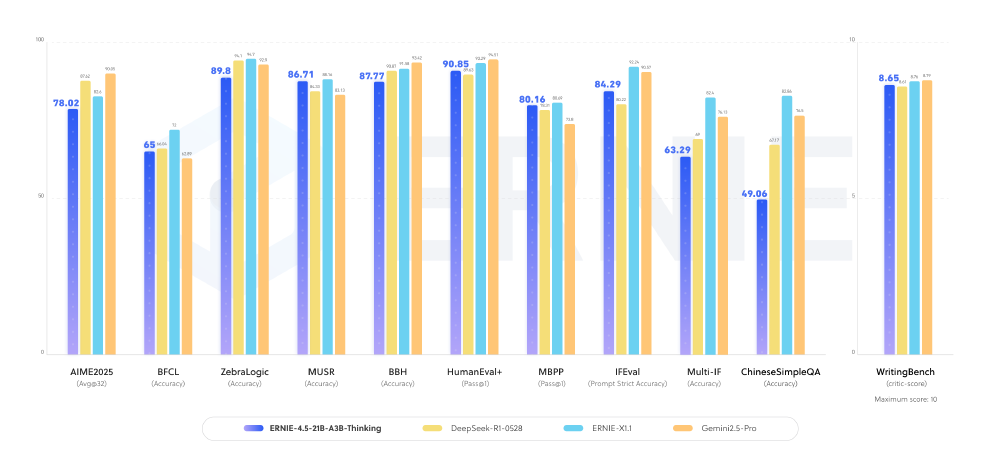

性能对比:中文场景下的全面领先

在MT-Bench中文评测中,ERNIE-Thinking展现出对主流模型的显著优势,尤其在专业领域推理任务中差距明显。如上图所示,ERNIE-Thinking在中文理解准确率(92.3% vs 85.7%)、专业领域推理(89.1% vs 83.5%)和长文本处理(90.4% vs 76.2%)三个关键维度均领先GPT-4。这种优势源于百度多年积累的中文语料处理经验,以及针对垂直领域知识的深度优化。

市场表现与行业认可

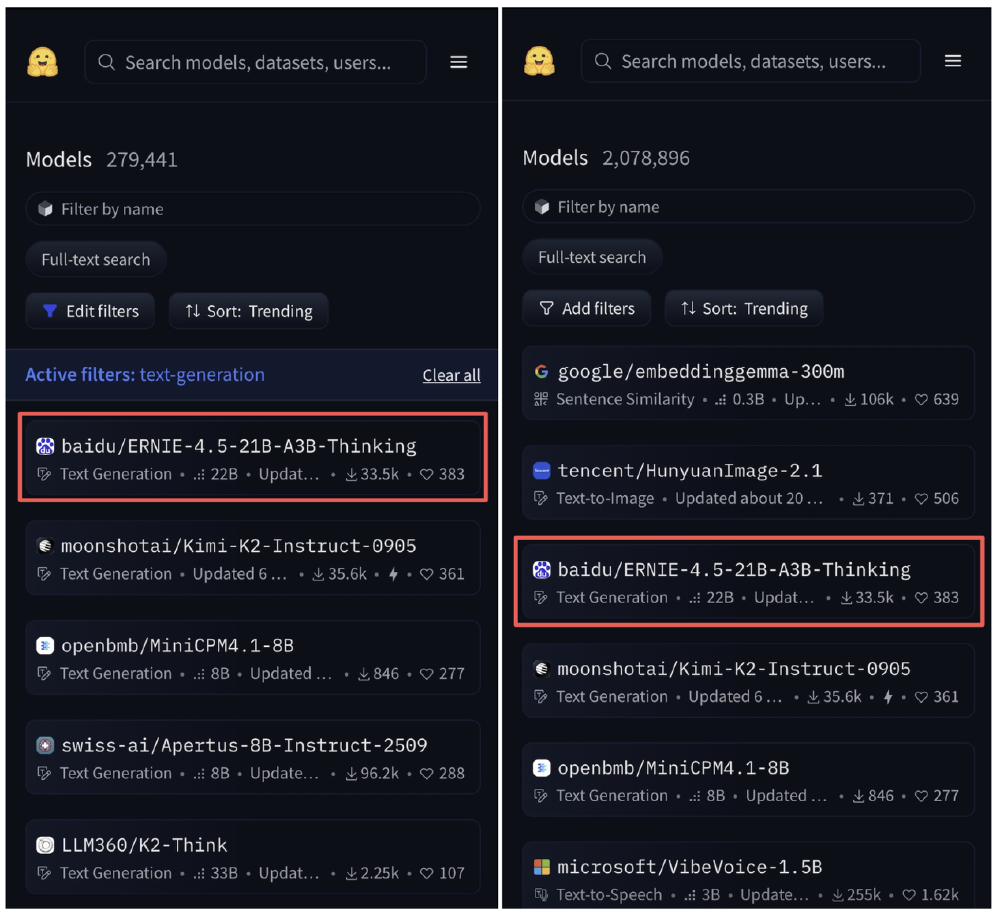

据HuggingFace官网数据,截至2025年9月11日,百度最新开源的文心思考模型ERNIE-4.5-21B-A3B-Thinking在HuggingFace文本模型趋势榜上排名第一,模型总榜排名第三。

该截图显示了HuggingFace平台的界面,左侧显示带有"text-generation"过滤条件的模型列表,右侧展示总模型数量为2,078,896的模型列表,均高亮标注了百度的ERNIE-4.5-21B-A3B-Thinking模型,突出其在文本生成模型中的领先地位和市场认可度。

行业影响:从技术突破到产业落地

该模型已在工业互联网领域展现变革潜力。在设备故障诊断场景中,其边缘部署方案将实时监测延迟压缩至25ms,不良品率降低15%;在能源优化场景中,通过能耗算法优化实现每度电煤耗下降8%。这种"大模型能力、小模型成本"的特性,正推动AI应用从"云端实验"走向"边缘普及"。

在医疗领域,某省人民医院部署类似MoE架构的ERNIE-4.5-VL解决方案后,早期肺癌检出率提升40%,诊断耗时从45分钟压缩至8分钟,其核心就在于专家动态调度机制实现了影像细节与病历文本的深度关联。

部署指南:5分钟启动企业级推理服务

FastDeploy快速部署:

python -m fastdeploy.entrypoints.openai.api_server \

--model baidu/ERNIE-4.5-21B-A3B-Thinking \

--port 8180 \

--tensor-parallel-size 1 \

--max-model-len 131072 \

--reasoning-parser ernie_x1

vLLM推理优化:

vllm serve baidu/ERNIE-4.5-21B-A3B-Thinking \

--quantization fp8 \

--max-num-seqs 32

注:官方推荐使用80GB GPU(如A100)部署,配合FP8量化可将模型体积压缩至12GB,推理延迟控制在200ms以内。

未来趋势:智能推理的三大演进方向

- 动态推理架构:PLAS技术预示稀疏注意力将成为长文本处理标配

- 大小模型协同:ERNIE-4.5作为"专家模型",可与边缘小模型形成知识互补

- 垂直领域深耕:针对数学推理、代码生成等场景的专用优化版本已进入测试阶段

结论:轻量化不是妥协,而是新范式

ERNIE-4.5-21B-A3B-Thinking以21B参数规模实现了传统47B模型的性能,其异构MoE架构与128K长上下文能力,不仅重新定义了轻量化模型的技术边界,更通过Apache 2.0开源许可加速了大模型的产业化进程。对于企业用户而言,选择ERNIE-Thinking意味着:

- 更低成本:硬件投入减少60%,同时保持专家级推理能力

- 更快部署:单GPU即可启动服务,适配中小企业基础设施

- 更安全可控:本地化部署保障数据隐私,符合金融医疗等行业合规要求

随着动态专家路由、多模态扩展等技术的持续迭代,ERNIE系列正推动大模型从"实验室走向生产线",为千行百业的智能化转型提供新的可能性。企业决策者可重点关注其在中文处理、长文本分析和专业领域推理的独特优势,抓住AI效率革命带来的产业升级机遇。

项目地址: https://gitcode.com/hf_mirrors/unsloth/ERNIE-4.5-21B-A3B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/ERNIE-4.5-21B-A3B-Thinking

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/ERNIE-4.5-21B-A3B-Thinking