98.1%安全防护率与5.3%拒答率的平衡:Qwen3-4B-SafeRL重新定义大模型安全范式

【免费下载链接】Qwen3-4B-SafeRL

导语

Qwen3-4B-SafeRL通过创新混合奖励强化学习技术,在将安全防护率提升至98.1%的同时,将不必要拒答率降至5.3%,为解决大语言模型"安全-可用"矛盾提供了新范式。

行业现状:安全与效率的双重挑战

2025年,随着大语言模型在金融、医疗等关键领域深度渗透,安全与可用性的平衡已成为行业核心痛点。OWASP《大型语言模型及生成式AI十大风险(2025)》报告显示,提示词注入、敏感信息披露和数据投毒已成为最突出的三大威胁。与此同时,监管要求日益严格,《生成式人工智能服务管理暂行办法》明确规定模型服务提供者必须建立完善的安全评估机制。

传统安全模型普遍陷入"两难困境":要么过度限制导致可用性下降,要么为追求性能牺牲安全边界。数据显示,2024年主流安全模型的平均不必要拒答率高达12.9%,严重影响用户体验。国家互联网应急中心2025年测试结果显示,尽管AI技术在7个网络安全场景中均有较好赋能效果,但大模型生成内容安全风险检测仍是企业最薄弱的环节之一。

核心亮点:混合奖励机制的三重突破

Qwen3-4B-SafeRL作为Qwen3-4B的安全对齐版本,其核心创新在于引入兼顾三重目标的混合奖励函数:

安全-帮助-拒答三角平衡

该模型通过Qwen3Guard-Gen-4B检测器实现安全最大化,同时利用WorldPM-Helpsteer2模型评估回复的实际帮助价值,最关键的是对不必要拒答施加适度惩罚,形成动态平衡机制。这种设计有效避免了传统安全模型"为安全而安全"的僵硬防御模式。

性能指标全面跃升

从官方发布的性能数据来看,Qwen3-4B-SafeRL实现了安全与性能的协同提升:

| Mode | Model | Safety Rate (Qwen3-235B) | Safety Rate (WildGuard) | Refusal (WildGuard) | ArenaHard-v2 (Winrate vs GPT-4.1) | AIME25 (Pass@1) | LCB-v6 (Pass@1) | GPQA (Pass@1) |

|---|---|---|---|---|---|---|---|---|

| Non-Think | Qwen3-4B | 47.5 | 64.7 | 12.9 | 9.5 | 19.1 | 26.4 | 41.7 |

| Qwen3-4B-SafeRL | 86.5 | 98.1 | 5.3 | 10.7 | 18.2 | 27.7 | 40.8 | |

| Think | Qwen3-4B | 43.8 | 59.0 | 6.5 | 13.7 | 65.6 | 48.4 | 55.9 |

| Qwen3-4B-SafeRL | 83.4 | 97.4 | 6.2 | 16.6 | 63.5 | 47.5 | 51.2 |

特别值得注意的是,在保持高安全性的同时,该模型在AIME数学测试中仍保持18.2%的Pass@1率,仅比基础模型下降0.9个百分点,证明其在安全对齐过程中有效保留了核心能力。

部署灵活性与生态兼容性

Qwen3-4B-SafeRL保持了与基础模型相同的混合思维模式,支持SGLang(0.4.6.post1+)和vLLM(0.8.5+)等主流部署框架,可快速构建OpenAI兼容的API服务。同时已被Ollama、LMStudio等本地运行工具支持,兼顾企业级部署和个人开发者需求。开发者可通过以下命令快速体验:

# 使用SGLang部署

python -m sglang.launch_server --model-path https://gitcode.com/hf_mirrors/Qwen/Qwen3-4B-SafeRL --reasoning-parser qwen3

# 或使用vLLM部署

vllm serve https://gitcode.com/hf_mirrors/Qwen/Qwen3-4B-SafeRL --enable-reasoning --reasoning-parser deepseek_r1

行业影响与趋势:安全对齐的新范式

Qwen3-4B-SafeRL的推出反映了大模型安全领域的几个重要演进方向:

从规则过滤到动态学习

传统安全模型多依赖预设规则和关键词过滤,而该模型展示的基于强化学习的动态对齐方案,能更好适应不断演变的攻击手段,特别是OWASP报告强调的高级提示注入技术。这种自适应能力使模型能够在面对新型攻击时持续学习和调整防御策略。

轻量化模型的安全突破

作为4B参数级别的模型,Qwen3-4B-SafeRL在资源受限条件下实现了与大模型相当的安全性能,为边缘设备和低资源场景的安全部署提供了可能。这一进展预示着安全对齐技术正从高资源依赖向轻量化方向发展,将加速安全大模型在终端设备的普及应用。

评估体系的多元化发展

该模型采用多维度评估基准(安全率、拒答率、学术能力等),突破了单一安全指标的局限。这种综合评估思路正逐渐成为行业标准,正如《2025 AI大模型安全防护:AI安全部署实战指南》指出的,现代AI安全需要"保护数据集、训练管道和模型免遭篡改,抵御对抗性攻击,以及降低AI偏见带来的风险"的全方位防护能力。

如上图所示,该图片展示了大型语言模型在安全任务中的文献综述纳入与排除标准,包含四条纳入条件和八条排除条件,用于筛选相关研究论文。这反映了当前大模型安全领域对评估体系多元化和标准化的追求,与Qwen3-4B-SafeRL采用的多维度评估思路相呼应。

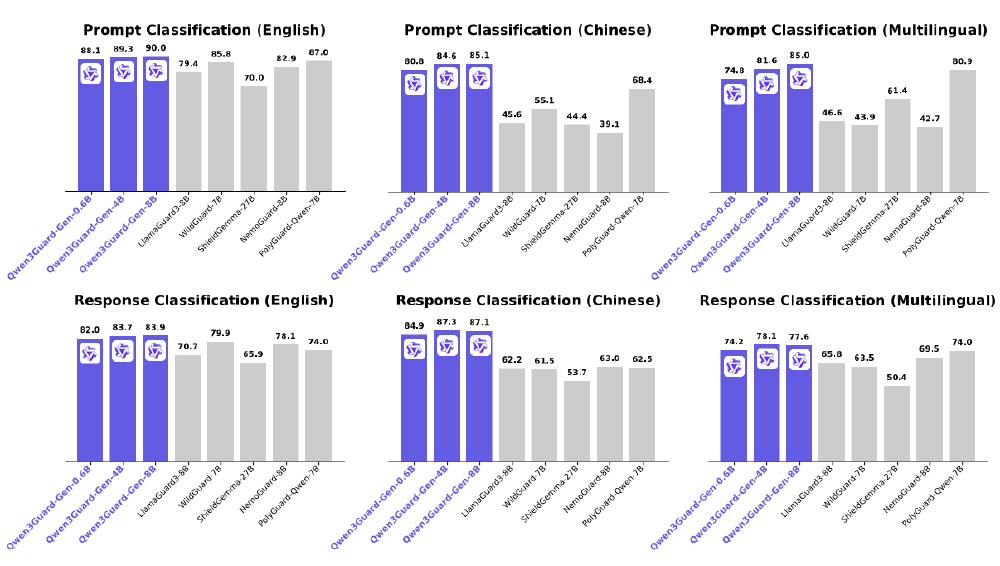

Qwen3Guard-Gen系列安全模型的技术突破也为Qwen3-4B-SafeRL提供了坚实基础。阿里通义千问团队发布的Qwen3Guard-Gen系列以三级风险分级体系和119种语言支持能力,重新定义大语言模型安全防护标准,为千亿级AI交互提供实时合规保障。

从图中可以看出,Qwen3Guard-Gen系列(0.6B、4B、8B)在英文、中文、多语言环境下的prompt分类与response分类性能对比中,8B版本在保持高性能的同时实现了多场景覆盖,特别适合中大型企业的复杂业务需求。其在英文响应分类任务中F1值达83.9,较同类模型提升12.3%,展现出卓越的内容安全检测能力。

总结与建议

Qwen3-4B-SafeRL通过创新的混合奖励机制,在4B参数级别实现了安全率98.1%与拒答率5.3%的平衡,为解决大模型"安全-可用"矛盾提供了可行方案。对于金融、教育等对安全敏感的领域,该模型提供了兼顾合规要求和用户体验的新选择。

随着监管环境收紧和攻击手段复杂化,安全对齐技术将成为模型竞争力的核心指标。建议企业用户在选型时重点关注:

- 安全机制是否采用动态学习而非静态规则

- 是否提供多维度评估数据而非单一安全指标

- 在安全对齐过程中核心能力的保留程度

- 部署方式是否兼容现有技术栈

开发者可通过项目地址https://gitcode.com/hf_mirrors/Qwen/Qwen3-4B-SafeRL获取更多技术细节和使用示例。在AI安全日益重要的今天,Qwen3-4B-SafeRL展示的"精准防护而非全面限制"思路,可能成为未来安全模型开发的主流方向。

【免费下载链接】Qwen3-4B-SafeRL

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考