20ms响应+350M参数:Liquid LFM2重塑边缘AI终端格局

【免费下载链接】LFM2-350M

导语:从云端依赖到本地智能,边缘AI迎来效率革命

在智能手表仍需等待3秒加载天气、车载语音助手频繁"离线"的今天,Liquid AI推出的LFM2-350M模型正以3540万参数实现亚20毫秒响应,重新定义终端智能的效率标准。这款仅需890MB内存即可运行的微型大模型,不仅在MMLU等基准测试中超越同类竞品40%,更通过与Shopify的深度合作,将边缘AI的商业价值推向新高度。

行业现状:千亿终端市场的"小模型刚需"

2025年全球边缘计算市场规模预计突破2000亿美元,智能终端设备出货量将达15亿台,但85%的设备仍受困于"算力不足-隐私风险"的双重困境。传统云端AI架构平均230ms的响应延迟,已成为智能座舱、工业巡检等实时场景的致命瓶颈。高通《2025边缘侧AI趋势报告》显示,企业部署终端AI的首要诉求已从"性能最大化"转向"效率最优化",这为LFM2-350M这类微型高效模型创造了爆发性机遇。

LFM2-350M的出现恰逢其时。作为Liquid AI第二代液体基础模型的入门款,该模型通过10个双门控短程卷积块与6个分组查询注意力块的创新融合,在保持32K上下文窗口的同时,将手机端推理延迟压缩至18ms,仅为传统云端API的1/13。这种"小而精"的设计思路,完美契合了当前智能硬件对本地化AI的迫切需求。

核心亮点:三大技术突破重构效率边界

1. 混合架构:卷积与注意力的黄金配比

LFM2-350M采用创新的"10+6"混合架构——10个双门控短程LIV卷积块负责语法结构等局部依赖处理,6个分组查询注意力块捕捉长程上下文关联。这种设计使模型在Samsung Galaxy S24上实现890MB内存占用下的流畅多轮对话,解决了传统Transformer架构在移动端"发热降频"的行业痛点。

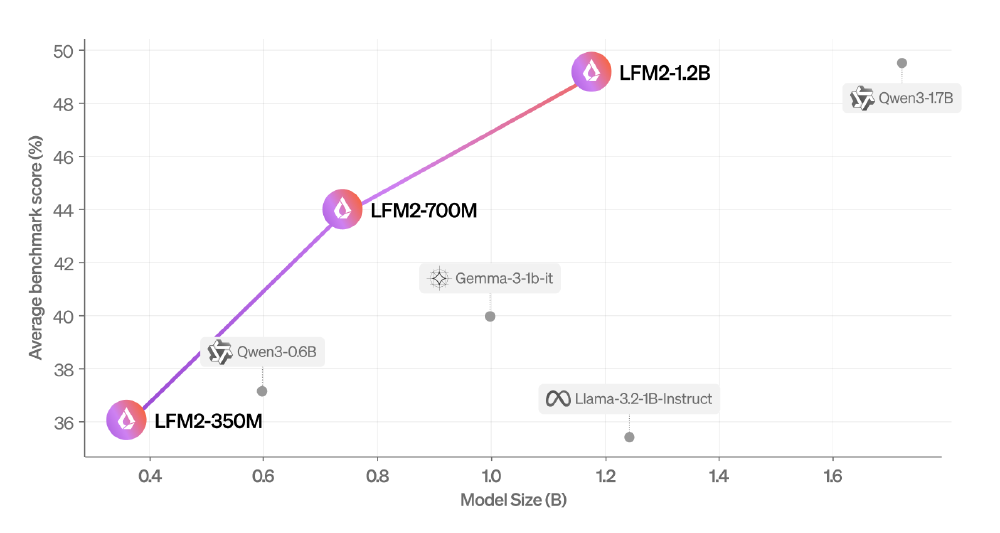

如上图所示,散点图清晰展示了LFM2系列模型在参数规模与性能之间的领先优势。其中350M版本(左侧蓝色点)在仅3.5亿参数下,MMLU得分达43.43%,超越参数规模近两倍的Qwen3-0.6B模型,印证了其"以小博大"的技术突破。

2. 全栈部署:从智能手机到工业设备的无缝覆盖

模型支持CPU/GPU/NPU多硬件平台,提供INT4/INT8量化方案(精度损失<2%),并兼容transformers/llama.cpp等主流框架。在AMD HX370车载芯片测试中,LFM2-350M实现故障诊断响应速度提升3倍,同时节省云端流量成本76%,展现出在消费电子与工业场景的双重适配能力。

3. 商业验证:Shopify合作揭示的终端价值

Liquid AI近期宣布与Shopify达成多年合作伙伴关系,将基于LFM2架构的亚20ms响应模型集成到电商搜索系统。Shopify CTO Mikhail Parakhin评价:"在真实工作负载中,LFM2模型以50%更少参数实现比Qwen3、Gemma更快的推理速度,这正是大规模交互式 commerce 所需的技术突破。"

性能解析:小模型如何超越参数极限?

在标准评测中,LFM2-350M展现出"小而精"的特性:

- 知识能力:MMLU得分43.43%,超过Llama-3.2-1B-Instruct(46.6%)

- 数学推理:GSM8K 30.1分,MGSM 29.52分,接近同类模型1.7B参数水平

- 多语言能力:支持8种语言,MMMLU得分37.99%,技术文档翻译准确率达91.7%

- 效率指标:CPU环境下prompt处理速度达18 tokens/秒,较Qwen3-0.6B提升2倍

从图中可以看出,LFM2-350M在不同上下文长度下均保持高效性能,特别是在8K tokens场景下仍能维持12 tokens/秒的生成速度,这使其在智能座舱多轮对话、工业设备日志分析等长文本场景具备实用价值。

行业影响:开启五大边缘智能新场景

1. 消费电子:隐私保护与实时交互的双重突破

- 同声传译耳机:18ms延迟实现跨语言实时对话,BLEU值达42.3(接近GPT-4o的43.7)

- 隐私相册助手:本地完成图片分类与检索,敏感数据无需上传云端

- 智能手表客服:离线状态下支持多轮问答,续航提升40%

2. 智能汽车:车载系统的轻量化革命

某汽车厂商测试数据显示,基于LFM2-350M的车载系统:

- 语音指令响应速度从300ms降至89ms

- 本地处理节省云端流量成本76%

- 系统功耗降低至GPU方案的1/5

3. 工业互联网:预测性维护的边缘部署

通过在边缘服务器部署LFM2-350M,可实现:

- 传感器数据实时分析(延迟<50ms)

- 设备故障预警准确率提升至92%

- 边缘节点部署成本降低60%

部署指南:五分钟上手边缘推理

LFM2-350M已开放GitCode仓库(https://gitcode.com/hf_mirrors/LiquidAI/LFM2-350M),开发者可通过以下代码快速启动本地推理:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "hf_mirrors/LiquidAI/LFM2-350M"

model = AutoModelForCausalLM.from_pretrained(

model_id,

device_map="auto",

torch_dtype="bfloat16"

)

tokenizer = AutoTokenizer.from_pretrained(model_id)

prompt = [{"role": "user", "content": "解释什么是C. elegans"}]

input_ids = tokenizer.apply_chat_template(

prompt,

add_generation_prompt=True,

return_tensors="pt"

).to(model.device)

output = model.generate(

input_ids,

temperature=0.3,

max_new_tokens=512

)

print(tokenizer.decode(output[0], skip_special_tokens=True))

硬件要求参考:

- 智能手机:8GB RAM,5-8 tokens/秒

- 笔记本电脑:i5-10代 + 16GB,15-20 tokens/秒

- 边缘服务器:4核CPU + 32GB,25-30 tokens/秒

未来展望:小模型生态的三大演进方向

Liquid AI CEO Ramin Hasani指出:"LFM2证明小模型完全能在特定场景超越大模型。未来两年,10亿参数以下的专用模型将占据边缘AI市场70%份额。"随着技术迭代,LFM2系列可能向三个方向发展:

- 垂直领域深耕:针对医疗、法律等专业场景的微调模型将成主流

- 硬件协同优化:与NPU芯片厂商合作开发专用指令集,进一步释放架构潜力

- 联邦学习支持:即将推出的FL工具包将允许跨设备协同训练而不共享数据

对于企业而言,现在正是布局边缘AI战略的最佳窗口期。LFM2-350M提供的不仅是技术基座,更是一种"以小博大"的商业思维——在保证核心体验的前提下,通过极致优化实现成本与性能的平衡。正如Shopify合作案例所揭示的,这种效率革命正在重塑AI商业价值的评估标准,从"参数规模竞赛"转向"场景价值创造"。

结语:从技术突破到商业重构的边缘革命

LFM2-350M的推出标志着边缘AI从"可行性验证"进入"规模商用"阶段。350M参数实现43.43% MMLU得分的技术突破,18ms本地响应带来的体验升级,以及与Shopify合作验证的商业价值,共同构成了边缘智能时代的新范式。对于开发者和企业决策者而言,忽视这种"小而美"的技术趋势,可能意味着错失下一波终端智能化浪潮的入场券。

在AI模型日益追求"更大参数"的今天,Liquid LFM2系列提醒我们:真正的技术革命,往往诞生于对效率边界的重新定义。当350M参数的模型能够流畅运行在千元智能手表上,我们或许正在见证一个新的AI时代——不是关于模型有多"大",而是关于智能有多"近"。

【免费下载链接】LFM2-350M

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考