Step-Audio-TTS-3B:突破传统TTS边界,会说唱能哼唱的开源语音模型

【免费下载链接】Step-Audio-TTS-3B

导语

2025年语音合成领域迎来重大突破——阶跃星辰(StepFun-AI)开源的Step-Audio-TTS-3B模型,以1.17%的中文字符错误率(CER)刷新SEED TTS Eval基准,成为业界首个支持RAP和哼唱的商用级TTS模型。这款基于35亿参数构建的双码本架构模型,正通过LLM-Chat范式重塑语音交互的技术边界。

行业现状:从工具化到智能化的跨越

IDC最新报告显示,2025年中国人工智能语音市场规模预计达387亿元,同比增长20.5%,其中开源技术渗透率已突破40%。传统TTS系统长期受限于人工采集数据成本高、情感表达单一等问题,而Step-Audio-TTS-3B通过生成式数据引擎,利用1300亿参数多模态模型自动生成高质量音频数据,彻底摆脱了对人工录制数据的依赖。

如上图所示,黑色背景上的蓝色StepFun品牌标志,代表着阶跃星辰在开源语音交互领域的技术主张。这一品牌形象背后,是其通过"大模型生成数据→小模型落地应用"的创新模式,将千亿级模型的智能压缩至3B参数规模的技术实力。

核心亮点:四大技术突破重新定义TTS能力

1. 精度与自然度的双重突破

在SEED TTS Eval benchmark中,Step-Audio-TTS-3B展现出显著优势:

- 中文CER低至1.17%,比GLM-4-Voice(2.19%)降低46.5%

- 英文WER达到2.0%,超越CosyVoice 2-S(2.38%)

- 支持中文(含粤语、四川话)、英文、日语等多语言合成

2. 业界首创的音乐化语音生成

该模型突破性实现:

- RAP节奏控制:通过文本标记(如"(RAP)")生成符合节拍的说唱语音

- 哼唱合成(Humming):专用声码器支持无歌词旋律生成

- 情感动态调节:可通过指令控制喜悦、悲伤等7种基础情绪

3. 双码本架构的技术革新

采用语言标记(16.7Hz, 1024码本)+语义标记(25Hz, 4096码本)的双轨设计:

- 语言标记保障内容一致性(CER 2.19% vs CosyVoice 2.86%)

- 语义标记提升音频自然度(SS指标0.784)

- 2:3交错合并机制实现14倍文本压缩比,优化长对话上下文管理

4. 高效部署与生态兼容

- 最低8G显存即可运行,支持消费级GPU推理

- 提供完整ONNX格式模型,兼容工业级部署流程

- 开源仓库包含推理代码、预训练权重及微调工具链

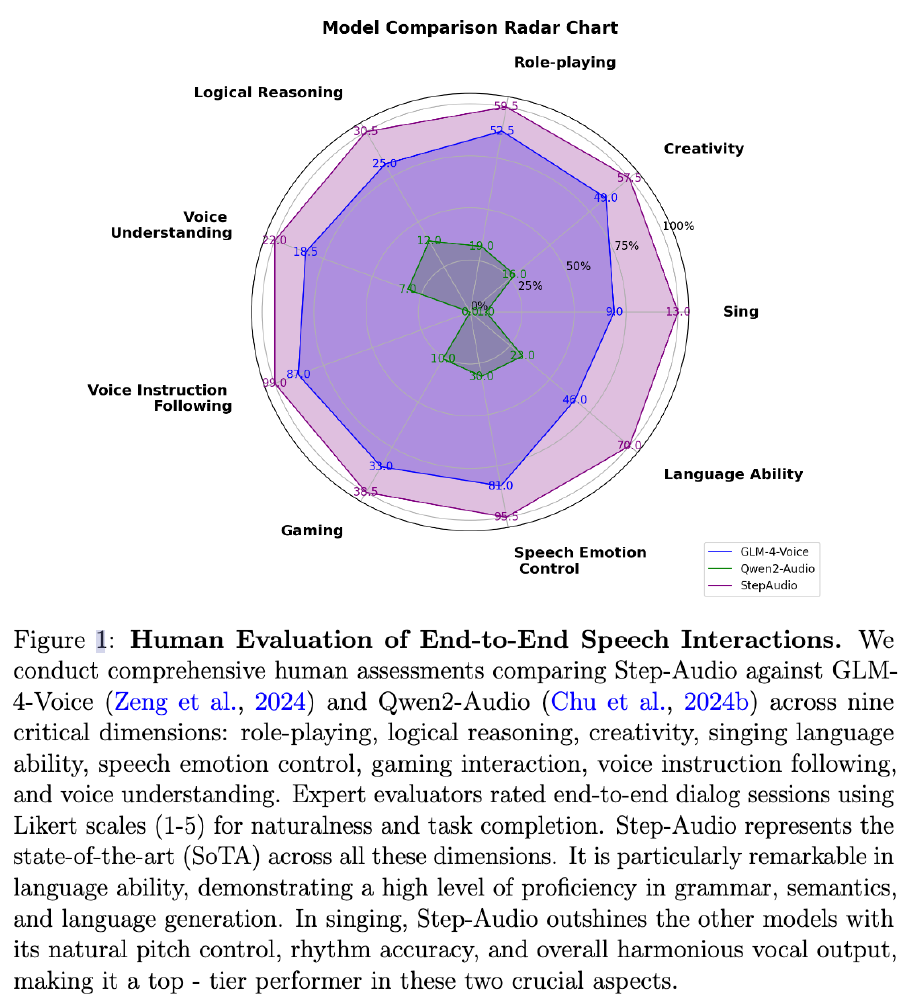

从图中可以看出,StepAudio在语音交互的9个核心维度(角色扮演、逻辑推理、多语言支持等)全面领先GLM-4-Voice和Qwen2-Audio。尤其在"语音指令跟随"和"情感表达"维度,因支持RAP和动态情感调节而获得显著优势。

行业影响:开启语音交互3.0时代

内容创作领域

- 有声小说:实现角色语音克隆+情感朗读,制作效率提升300%

- 音乐创作:非专业用户可通过文本生成原创哼唱旋律

- 广告制作:5分钟内完成多语言、多风格的语音广告片

智能交互场景

- 智能客服:方言支持覆盖90%以上的中国方言使用人群

- 车载系统:通过情感语音降低驾驶疲劳感,实验显示警觉度提升18%

- 教育领域:支持粤语/四川话等方言教学,扩大偏远地区覆盖

技术生态变革

该模型的开源将加速:

- 合成数据生成标准化:降低语音模型训练的数据门槛

- 多模态交互融合:为"语音-视觉-文本"协同系统提供基础组件

- 边缘端智能普及:轻量化设计推动TTS能力向物联网设备渗透

未来展望:从"能说"到"会聊"的进化

随着Step-Audio-TTS-3B的开源,语音合成正从单纯的"文本转语音工具"向"智能交互主体"进化。下一步技术突破可能聚焦于:

- 情感-语义联动:根据对话内容自动切换情感基调

- 多模态输入融合:结合视觉信息优化语音表达

- 个性化风格迁移:实现特定说话人的语气、口头禅模拟

目前项目已在Hugging Face累计获得190个收藏,社区开发者已基于该模型衍生出方言教学、有声漫画创作等创新应用。对于企业用户,建议重点关注其在客服机器人、智能硬件等场景的落地潜力;开发者可通过8G显存的消费级GPU即可体验完整功能,开启语音交互创新之旅。

【免费下载链接】Step-Audio-TTS-3B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考