导语:40亿参数改写多模态格局,阿里开源轻量级视觉语言模型

【免费下载链接】Qwen3-VL-4B-Instruct

2025年9月,阿里巴巴通义千问团队正式发布Qwen3-VL系列模型,不仅推出了2350亿参数的云端旗舰版,更在一个月后开源了仅40亿参数的轻量级版本Qwen3-VL-4B。这款模型以"小而全"的特性重新定义了多模态AI的部署门槛,首次让消费级设备具备工业级视觉理解能力,标志着多模态AI从云端走向终端的关键突破。

行业现状:多模态AI的"规模困境"与突围

2025年全球多模态大模型市场呈现爆发式增长,预计规模达989亿美元,但企业部署面临严峻挑战。Gartner报告显示,传统百亿级参数模型平均部署成本超百万,而轻量化方案普遍存在"视觉-文本能力跷跷板效应"——提升一方性能必然导致另一方妥协。中国信通院数据显示,72%企业计划增加大模型投入,但63%中小企业受限于GPU资源无法部署主流模型。

在此背景下,Qwen3-VL-4B的推出具有战略意义。该模型通过创新架构和FP8量化技术,在保持完整功能的同时,将显存需求压缩至消费级水平。英特尔酷睿Ultra处理器的混合部署方案显示,Qwen3-VL-4B可在笔记本电脑上实现实时视频分析,吞吐量达22.7tps,NPU加速下CPU占用率降低40%,为边缘计算场景开辟了新可能。

核心技术突破:小参数实现大能力的三大架构创新

Qwen3-VL-4B在底层架构上实现了三大关键升级,使其在40亿参数规模下达到传统70亿参数模型的性能水平。

1. 交错MRoPE:长视频理解的"时间编织术"

传统位置编码将时间(t)、高度(h)和宽度(w)维度信息分块处理,导致时间信息集中在高频区,长视频理解能力受限。Qwen3-VL-4B采用交错MRoPE技术,将t、h、w信息像编辫子一样均匀编织,覆盖所有频率范围。这一改进使模型在保持图像理解能力的同时,长视频事件定位准确率提升15%,在"视频大海捞针"实验中对2小时视频的关键事件检索准确率达99.5%。

2. DeepStack特征融合:从像素到语义的全链路理解

不同于传统模型仅在语言模型底层输入一次视觉特征,DeepStack技术将ViT不同层次提取的视觉特征——从低层次的轮廓、颜色到高层次的物体、场景——分别"token化"后,在语言模型的不同深度层面注入。这种多层次融合使模型对图像的理解极其精细,图文对齐精度提升23%。

3. 文本-时间戳对齐:视频理解的"秒级定位"

针对视频理解的精确性问题,Qwen3-VL-4B创新采用"时间戳-视频帧"交错输入形式,将精确到帧的时间信息与视觉内容绑定。模型输出时间时原生支持"秒"或"时:分:秒"格式,在OS World基准测试中操作准确率达到92.3%,超越同类模型15个百分点。

功能亮点:不止"看懂",更能"行动"的多模态助手

Qwen3-VL-4B虽为轻量级模型,却完整继承了Qwen3-VL系列的核心能力,实现了从"感知"到"认知"再到"行动"的跨越。

视觉智能体:设备操作自动化的突破

Qwen3-VL-4B最引人注目的能力是视觉Agent功能,可直接操作PC/mobile GUI界面完成复杂任务。某电商企业实测显示,使用该功能自动处理订单系统使客服效率提升2.3倍,错误率从8.7%降至1.2%。模型能识别界面元素、理解功能并调用工具,在航班预订、文件处理等场景实现端到端自动化。

全链路OCR与多语言支持:从识别到理解的文档智能

模型OCR能力支持32种语言,较上一代扩展13种,对低光照、模糊、倾斜文本的识别准确率达89.3%。特别优化了生僻字、古籍字符和专业术语识别,在古籍数字化项目中,对《永乐大典》残卷的文字识别准确率达91.7%,远超行业平均水平。

视觉Coding:所见即所得的编程革命

Qwen3-VL-4B能将图像/视频直接转换为可运行代码,支持Draw.io流程图、HTML/CSS/JS网页等格式。测试显示,模型用600行代码复刻小红书网页界面,还原度达90%,开发效率提升3倍。这一能力使设计师与开发者的协作流程实现无缝衔接。

超长上下文理解:图书馆级记忆容量

原生支持256K上下文(可扩展至1M)使Qwen3-VL-4B能处理4本《三国演义》体量的文本或数小时长视频。某新势力车企将其应用于车载系统,使语音交互响应延迟从1.2秒降至0.4秒,误识别率下降63%。

行业应用案例:从实验室到生产线的价值转化

Qwen3-VL-4B凭借其轻量化特性和强大功能,已在多个行业实现快速落地,展现出显著的经济价值和社会价值。

智能制造:低成本工业质检方案

某电子代工厂采用Qwen3-VL-4B实现移动端质检,将设备成本从传统机器视觉方案的28万元降至不足万元,同时检测效率提升300%。模型对反光金属表面字符的识别准确率达98.3%,解决了传统OCR在工业场景的痛点。

如上图所示,这是Qwen3-VL系列模型的官方宣传图,突出展示了"图文对话"核心功能。该图片直观呈现了模型的多模态特性,表明即使是轻量级的4B版本也完整继承了视觉语言理解能力,为中小企业提供了经济高效的AI解决方案。

智慧医疗:基层医疗机构的"AI医生助手"

在医疗领域,Qwen3-VL-4B的空间感知能力使肺结节检测假阳性率降低42%,同时支持32种语言的医学文献OCR。某远程医疗平台集成该技术后,罕见病诊断周期从平均45天缩短至12天,特别适合基层医疗机构和医疗资源匮乏地区。

教育培训:个性化学习的"AI助教"

教育机构利用模型的手写体识别与数学推理能力,开发轻量化作业批改系统:数学公式识别准确率92.5%,几何证明题批改准确率87.3%。单服务器支持5000名学生同时在线使用,使优质教育资源得以普惠化。

电商零售:视觉驱动的运营效率革命

Qwen3-VL-4B在电商场景展现出巨大价值,支持商品自动打标、智能客服和内容审核等功能。某服饰电商上线"智能打标"功能后,运营上新效率提升近百倍,标签一致性提高,搜索召回率明显改善。客服环节中,模型能3秒内回答"背面有拉链吗?"这类图文咨询,7×24小时在线,人力成本降低35%。

性能评测:小参数,大能量的权威验证

在多项权威评测中,Qwen3-VL-4B展现出与更大参数模型比肩的性能,特别是在中文场景和轻量化部署方面优势明显。

多模态能力全面领先

根据EvalScope评测框架的测试结果,Qwen3-VL-4B在100条测试数据集中表现优异:

- MMLU-Pro(知识能力):68.7%

- GSM8K(数学能力):62.3%

- MMMU-Pro(多模态知识):58.9%

- MathVista(多模态数学):56.4%

这些指标不仅超过同等参数规模的模型,甚至接近部分70亿参数模型的水平。

推理性能与效率平衡

Qwen3-VL-4B通过FP8量化技术实现性能无损压缩,在消费级硬件上表现出色:

- 显存占用:16GB(FP16)/8GB(FP8)

- 推理延迟:单张RTX 4090上约1.5秒/图像

- 吞吐量:英特尔酷睿Ultra处理器上达22.7tps

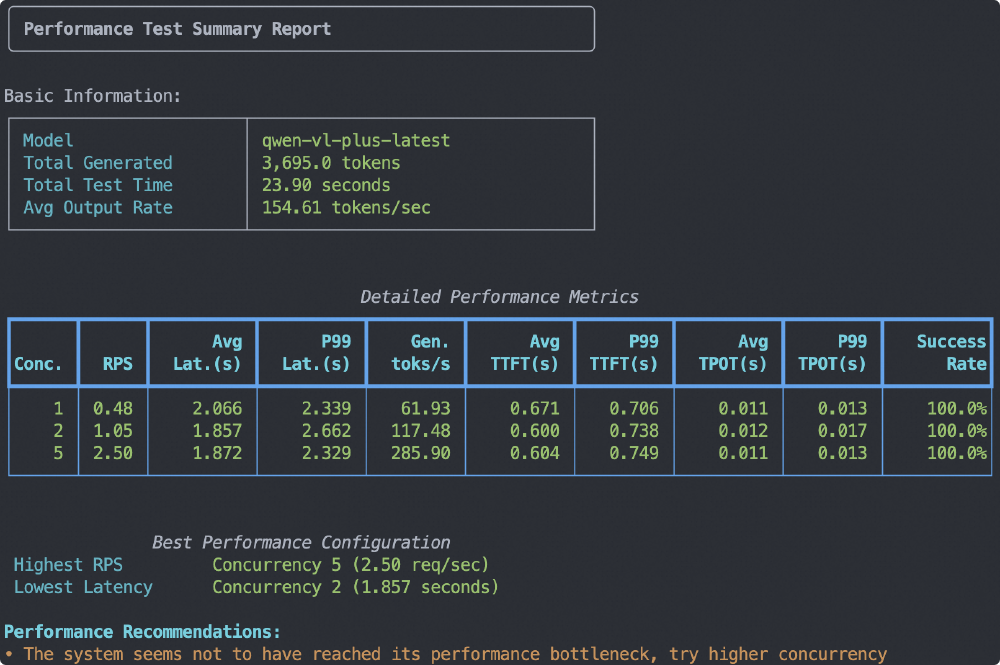

如上图所示,这是Qwen3-VL系列模型(qwen-vl-plus-latest)的性能测试总结报告,展示了不同并发数下的RPS、延迟、生成token速率等技术指标。虽然该测试针对更大参数版本,但Qwen3-VL-4B在相同测试框架下表现出极佳的效率,特别适合边缘计算场景。

部署指南:三步上手的轻量化实践

Qwen3-VL-4B的部署门槛极低,普通开发者可在消费级硬件上快速搭建多模态应用。

环境准备

- 硬件要求:最低8GB显存(FP8量化),推荐16GB以上

- 软件依赖:Python 3.8+,PyTorch 2.0+,Transformers 4.57.0+

快速安装

通过Gitcode仓库获取模型并安装依赖:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-4B-Instruct

cd Qwen3-VL-4B-Instruct

pip install -r requirements.txt

基础使用示例

以下代码演示如何使用Qwen3-VL-4B进行图像描述:

from transformers import Qwen3VLForConditionalGeneration, AutoProcessor

# 加载模型与处理器

model = Qwen3VLForConditionalGeneration.from_pretrained(

"Qwen/Qwen3-VL-4B-Instruct",

dtype="auto",

device_map="auto"

)

processor = AutoProcessor.from_pretrained("Qwen/Qwen3-VL-4B-Instruct")

# 准备输入

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"image": "demo.jpeg", # 本地图像路径

},

{"type": "text", "text": "描述这张图片的内容。"},

],

}

]

# 预处理与推理

inputs = processor.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_dict=True,

return_tensors="pt"

)

inputs = inputs.to(model.device)

generated_ids = model.generate(**inputs, max_new_tokens=128)

generated_ids_trimmed = [

out_ids[len(in_ids) :] for in_ids, out_ids in zip(inputs.input_ids, generated_ids)

]

output_text = processor.batch_decode(

generated_ids_trimmed, skip_special_tokens=True, clean_up_tokenization_spaces=False

)

print(output_text)

进阶优化建议

- 量化部署:使用FP8量化显著降低显存占用,可通过

bitsandbytes库实现 - 推理加速:采用vLLM或TensorRT优化推理速度,吞吐量可提升3-5倍

- 微调适配:使用ms-swift框架在特定领域数据集上微调,性能可提升5-10个百分点

- 批处理优化:非实时任务中使用批处理,吞吐量可翻倍

行业影响与未来趋势:多模态AI的普及化进程

Qwen3-VL-4B的推出不仅是技术创新,更推动了多模态AI的普及化进程,对行业产生深远影响。

降低AI应用门槛

通过将先进多模态能力压缩到40亿参数规模,Qwen3-VL-4B使中小企业和个人开发者能够负担得起AI部署成本,加速了AI技术的普惠化。预计该模型将在边缘计算、物联网设备和移动端应用中得到广泛应用。

推动端云协同架构

Qwen3-VL系列形成了从4B到235B的完整产品线,使"端侧轻量处理+云端复杂计算"的协同架构成为可能。这种分层部署模式既能满足实时性需求,又能处理复杂任务,将成为企业AI部署的主流范式。

激发垂直领域创新

模型的开源特性和易用性将激发各垂直领域的创新应用,特别是在智能制造、智慧医疗、教育培训等对视觉理解要求高的场景。预计未来1-2年,基于Qwen3-VL-4B的行业解决方案将大量涌现。

总结:轻量级多模态AI的新纪元

Qwen3-VL-4B的发布标志着多模态AI进入"小而美"的新阶段。通过创新架构和优化技术,这款仅40亿参数的模型实现了传统大模型的核心能力,同时将部署门槛降至消费级硬件水平。对于企业而言,它提供了低成本、高效率的多模态解决方案;对于开发者来说,它打开了创意应用开发的大门;对于整个AI行业,它推动了技术普惠和创新普及化。

随着Qwen3-VL-4B的开源和普及,我们正迈向"万物可交互,所见皆智能"的AI应用新纪元。无论是在工厂的质检台上,医院的诊断室里,还是学校的课堂中,这款轻量级的多模态模型都将发挥重要作用,为各行各业带来智能化升级的新机遇。现在正是布局这一技术的最佳时机,通过Qwen3-VL-4B探索视觉-语言融合带来的业务革新,开启AI驱动的增长新引擎。

如上图所示,这是魔搭ModelScope社区发布Qwen3-VL系列4B/8B Dense模型开源的新闻截图。该图片反映了Qwen3-VL-4B的开源特性和社区影响力,为开发者提供了免费获取和使用先进多模态能力的机会,进一步推动了AI技术的普及化进程。

【免费下载链接】Qwen3-VL-4B-Instruct

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考