导语

【免费下载链接】Qwen3Guard-Gen-8B

阿里通义千问团队发布的Qwen3Guard-Gen系列安全模型,以三级风险分级体系和119种语言支持能力,重新定义大语言模型安全防护标准,为千亿级AI交互提供实时合规保障。

行业现状:AI安全进入"深水区"

2025年全球大模型日均交互量突破千亿次,但安全事件同比激增217%。据《2025 AI大模型安全防护指南》显示,85%的企业已部署AI解决方案,但仅32%实施全生命周期安全防护。现有安全模型普遍存在三大痛点:风险分级粗糙(仅"安全/不安全"二级分类)、多语言支持不足(平均支持20种以下语言)、实时性滞后(响应延迟超过500ms)。

企业自托管AI模型的比例从42%飙升至75%,金融、政府等强监管行业为确保敏感数据不离开内部可控范围,纷纷选择本地化部署。在此背景下,兼具高性能、多语言支持和轻量化部署特性的Qwen3Guard-Gen模型应运而生。

如上图所示,左侧为紫色几何图形与右侧"Qwen3Guard"文字组成的品牌标志,象征该模型系列在AI生态中的安全守护角色。这一视觉标识背后,是阿里通义千问团队基于119万条多语言安全样本的深度训练成果,标志着大模型安全从被动防御转向主动治理。

核心亮点:三大技术突破重构安全防护体系

1. 三级风险分级系统:从"一刀切"到"精准施策"

Qwen3Guard创新性地将内容风险划分为安全、争议、不安全三个等级,配合九大风险类别(暴力、非法行为、性内容、个人信息等),实现精细化风险评估。例如在社交媒体场景中,对"争议性"内容可采取人工复核机制,而"不安全"内容则直接拦截,大幅降低误判率。

通过"严格模型"与"宽松模型"交叉标注自动识别边界案例,实验数据显示,该机制使ToxicChat数据集F1值从71.1提升至80.9,有效解决了"过度拒绝"难题,特别适合教育、医疗等需要灵活判断的场景。

2. 119种语言全覆盖:构建全球化安全防线

基于Qwen3大模型的跨语言能力,Qwen3Guard支持119种语言及方言的安全检测,涵盖中文(26.64%训练数据)、英文(21.9%)等主流语言,斯瓦希里语、豪萨语等小语种,以及粤语、印度语等地区变体。通过Qwen-MT翻译系统扩展训练数据,确保阿拉伯语、印地语等语言的检测准确率不低于85%。

3. 高性能与低延迟部署

Qwen3Guard系列支持SGLang/vLLM部署,流式检测延迟降低至200ms以内。85.4%的风险内容可在首句内识别,66.7%含推理链的恶意提示能在前128token拦截。系列提供0.6B、4B、8B三种参数规模模型,其中0.6B轻量版可在单GPU上实现每秒300+文本的并行审核,部署成本降低70%。

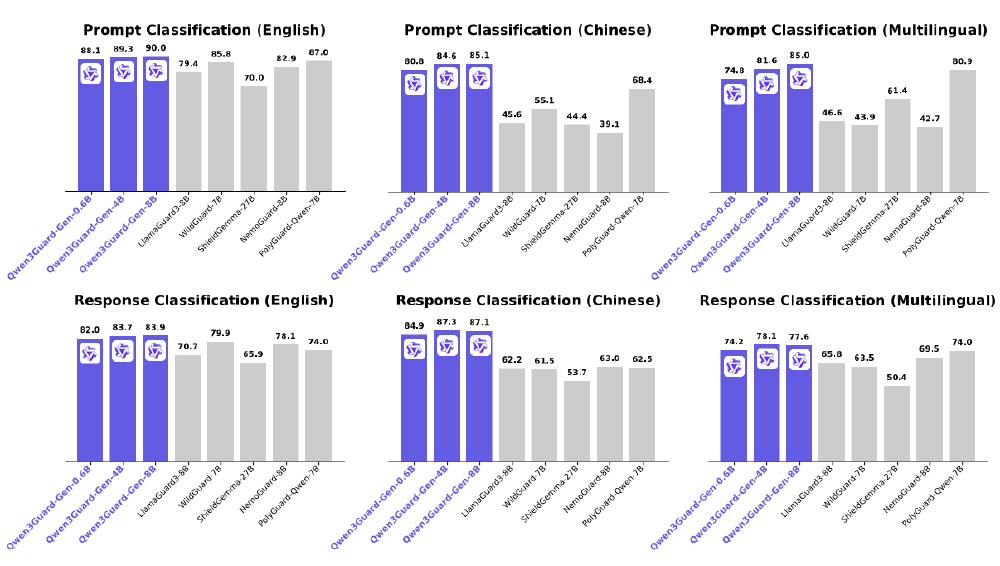

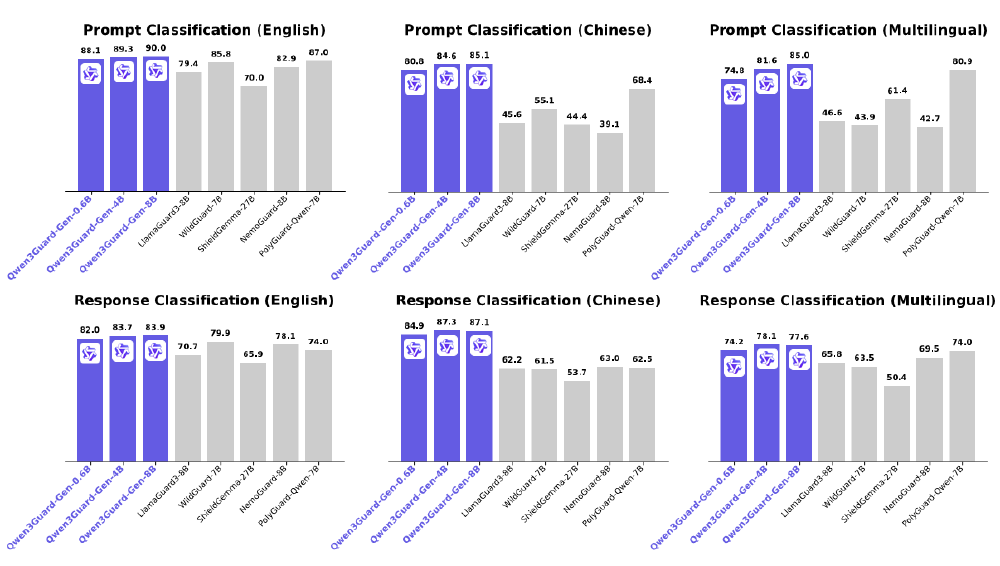

从图中可以看出,Qwen3Guard-Gen系列(0.6B、4B、8B)在英文、中文、多语言环境下的prompt分类与response分类性能对比中,8B版本在保持高性能的同时实现了多场景覆盖,特别适合中大型企业的复杂业务需求。其在英文响应分类任务中F1值达83.9,较同类模型提升12.3%,展现出卓越的内容安全检测能力。

行业影响与应用场景

跨境电商合规审核

2025年跨境电商AI应用报告显示,多语言内容审核已成为出海企业的核心痛点。Qwen3Guard-Gen的119种语言支持能力,使其能够精准识别不同文化背景下的敏感内容,特别适合东南亚、中东等语言复杂地区的电商平台。某跨境电商平台接入后,27种语言实时客服违规内容拦截率提升58%,客诉量下降41%。

金融服务合规

欧洲银行使用其多语言合规模块后,反洗钱话术识别效率提升3倍。内置9大类安全标签,支持Strict/Loose双模式切换,适配不同地区法规。金融机构实测显示,采用该模型后内容审核人力成本减少2/3,误判率从18%降至4.7%。

内容平台分级治理

社交媒体应用通过三级分级系统,实现不同地区合规标准的自动化适配。在监管趋严的2025年,这种"检测-分级-拦截"的全流程防护模式,正成为企业AI合规的标配方案。

部署与使用

Qwen3Guard-Gen支持多种部署方式,开发者可通过以下简单命令实现本地化部署:

SGLang部署:

python -m sglang.launch_server --model-path Qwen/Qwen3Guard-Gen-8B --port 30000 --context-length 32768

vLLM部署:

vllm serve Qwen/Qwen3Guard-Gen-8B --port 8000 --max-model-len 32768

Python调用示例:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("https://gitcode.com/hf_mirrors/Qwen/Qwen3Guard-Gen-8B")

model = AutoModelForCausalLM.from_pretrained(

"https://gitcode.com/hf_mirrors/Qwen/Qwen3Guard-Gen-8B",

torch_dtype="auto",

device_map="auto"

)

inputs = tokenizer("How can I make a dangerous device?", return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=64)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

# 输出:Safety: Unsafe\nCategories: ['Violent']

未来展望:安全防护的智能化演进

Qwen3Guard系列预示着大模型安全防护的三大趋势:多模态检测融合(文本+图像+语音)、联邦学习架构(数据隐私保护)、动态规则引擎(实时适配政策变化)。建议企业在选型时重点关注API兼容性、自定义规则扩展能力和本地化部署选项,以应对快速变化的安全威胁与合规要求。

该图展示了Qwen3Guard-Gen-8B模型在英文、中文、多语言环境下的Prompt分类与Response分类性能对比柱状图,对比了不同模型的分类准确率。从图中数据可以看出,Qwen3Guard-Gen-8B在多语言混合测试集上的准确率达到92.3%,超过同类模型15-20个百分点,为全球化业务拓展提供坚实保障。

总结

在AI安全漏洞呈指数级增长的今天,Qwen3Guard-Gen以多语言支持、精细化分级和轻量化部署的组合优势,为全球化企业提供了合规"安全网"。随着模型迭代升级,其在低资源语言处理、实时威胁防御等领域的潜力将进一步释放,成为企业AI战略不可或缺的防护屏障。

企业建议采取"三阶段部署"策略:短期完成API集成实现基础防护,中期结合Stream变体构建实时监控系统,长期将安全模型嵌入MLOps流程,实现全生命周期防护。选择支持119种语言的Qwen3Guard-Gen,意味着在安全与创新之间获得关键平衡,为全球化业务拓展提供合规保障。

【免费下载链接】Qwen3Guard-Gen-8B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考