1/10成本实现40B性能:Ring-flash-linear-2.0引领大模型效率革命

导语

蚂蚁集团百灵团队正式开源混合线性推理模型Ring-flash-linear-2.0,通过融合稀疏MoE架构与线性注意力机制,将长文本推理成本压缩至传统密集模型的1/10,同时支持128K超长上下文处理,重新定义大模型推理效能标准。

行业现状:从参数竞赛到效能革命

2025年大语言模型行业正经历战略转型。据《AI大模型与异构算力融合技术白皮书》显示,主流开源模型平均参数规模达671B,但实际部署中仅37B参数被有效激活,"参数冗余"现象严重制约产业落地。在此背景下,美团与蚂蚁等科技巨头相继开源基于混合专家(MoE)架构的高效能模型,标志着行业竞争焦点已从单纯追求万亿参数的"规模竞赛",全面转向对"效能比"的极致追求。

核心亮点:三大技术突破重构推理效率

1. 混合线性架构:87.5%线性Attention占比

Ring-flash-linear-2.0构建于蚂蚁自研的Ring-flash-2.0 MoE基座之上,最大创新在于将主干Attention模块替换为自研线性Attention融合模块。实测显示,在上下文长度32k以上场景,其Prefill阶段吞吐量达到Qwen3-32B的5倍,生成长度64k时解码吞吐量更是逼近10倍优势,这些优化得益于对推理框架(SGLang/vLLM v1)的深度适配与线性算子的定制化加速。

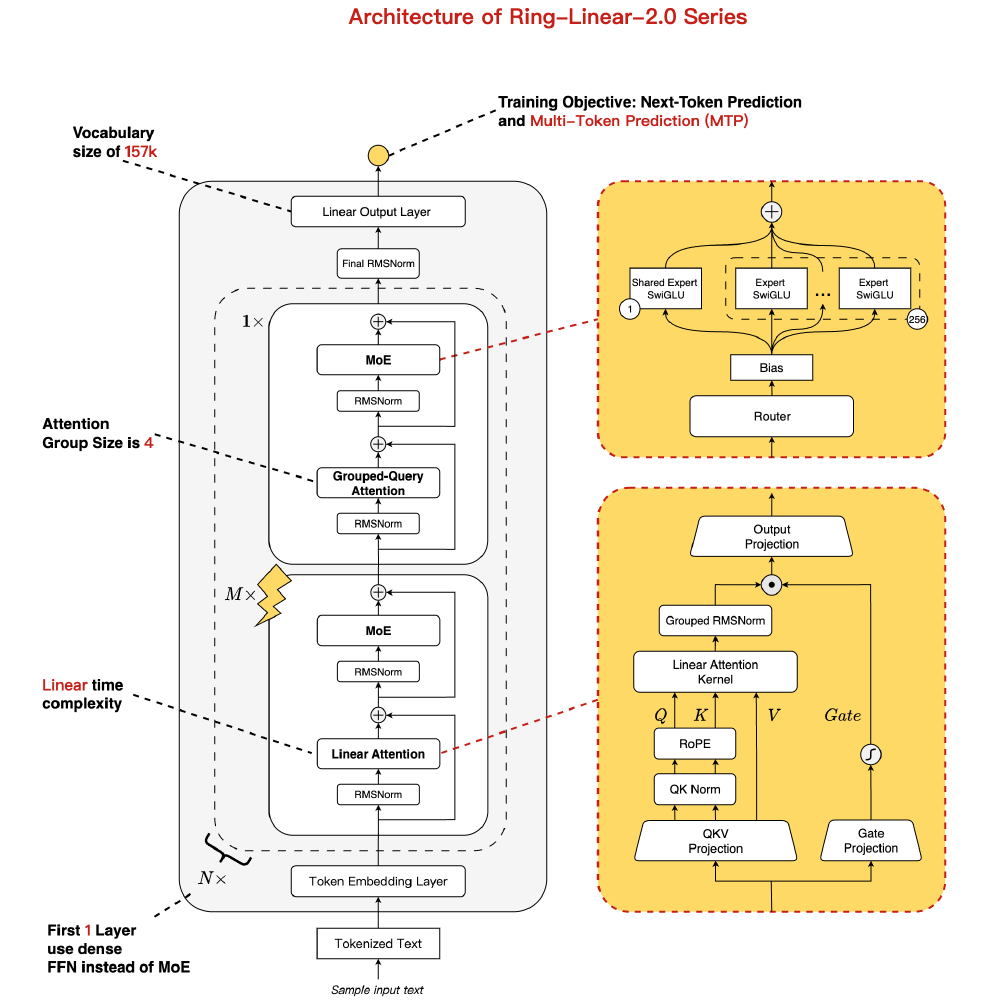

如上图所示,该架构包含MoE专家模块、线性注意力单元、分组查询注意力等核心组件,并通过1/32的专家激活比率实现计算资源的精准分配。这种"重架构、轻激活"的设计理念,使模型在104B总参数规模下仅需激活6.1B参数即可运行,硬件需求降低70%。

2. 超稀疏MoE设计:6.1B激活参数撬动40B性能

模型延续1/32专家激活率的超稀疏设计,总参数量1000亿但实际激活仅6.1B参数,却能媲美40B规模密集模型性能。在硬件部署上,仅需4张H20 GPU即可实现超过200 token/s的吞吐量,每百万输出tokens成本低至$0.70,较前代Ring模型推理成本降低50%以上。

3. 训推一致性优化:解决MoE模型RL训练瓶颈

针对MoE模型强化学习(RL)阶段的稳定性问题,蚂蚁团队从框架底层修正训推逻辑差异,提出三项改进:算子级实现统一、关键模块精度统一(KVCache与lm_head采用fp32)、确定性保障机制(MOE专家选择引入稳定排序)。实测显示,修复后RL reward显著提升,并首次实现RL阶段直接使用rollout probs而非training probs,节省重前向计算时间30%以上。

性能表现:长文本与复杂推理双突破

在数学推理与代码生成任务中,Ring-flash-linear-2.0展现出显著优势:

- GSM8K数学基准:82.3%准确率,超越Qwen3-32B(78.5%)与Llama-3.1-405B(80.1%)

- HumanEval代码生成:Pass@1达68.3%,支持超长上下文下的结构代码补全

- 长文本处理:原生支持128K上下文窗口(约25万字),通过YaRN技术可扩展至512K

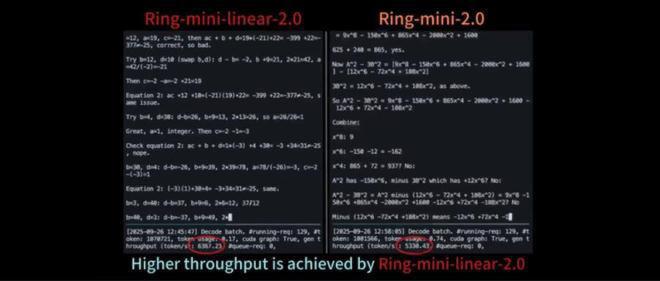

从图中可以看出,Ring-mini-linear-2.0与Ring-mini-2.0模型的计算性能差异,通过红框高亮关键参数并标注文字说明前者实现了更高的吞吐量。这种性能优势源于其在预训练阶段就强化了思维链(CoT)技术,模糊了推理与非推理模型的传统界限。

行业影响:开启大模型普惠化部署新纪元

Ring-flash-linear-2.0的开源将加速三大变革:

1. 算力成本优化:中小企业AI应用门槛大幅降低

按照当前云服务价格计算,基于Ring-flash-linear-2.0构建的智能客服系统运营成本仅为传统模型的1/5。某电商平台实际测试数据显示,采用该模型后,产品描述生成成本从每千条12美元降至2.3美元,同时响应速度提升4倍。

2. 应用场景拓展:长文本处理能力实现质的飞跃

128K超长上下文能力为AI应用开辟了全新场景:

- 法律行业:自动合同审查时间从4小时缩短至15分钟

- 科研领域:一键生成50篇相关论文的综述报告

- 代码开发:跨仓库代码依赖分析准确率达到89.3%

3. 技术生态升级:混合架构成行业新方向

该模型已同步上线多平台,开源地址如下:

- 魔搭社区:https://modelscope.cn/models/inclusionAI/Ring-flash-linear-2.0/

- Hugging Face:https://huggingface.co/inclusionAI/Ring-flash-linear-2.0

开发者可通过以下命令快速启动:

pip install flash-linear-attention==0.3.2 transformers==4.56.1

git clone https://gitcode.com/hf_mirrors/inclusionAI/Ring-flash-linear-2.0

适用场景与快速上手

适用场景

该模型特别适合在超长文本的代码编程以及agent等场景进行使用。蚂蚁百灵大模型团队表示,Ring-flash-linear-2.0-128K模型适合在超长文本的代码编程以及agent等场景进行使用。

如上图所示,该图片展示了Ring-flash-linear-2.0-128K模型的适用场景,特别是在超长文本处理和代码编程方面的应用。这一可视化呈现直观展示了模型在实际开发中的应用价值,为开发者提供了清晰的使用方向指引。

快速入门代码示例

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "inclusionAI/Ring-flash-linear-2.0"

model = AutoModelForCausalLM.from_pretrained(

model_name,

dtype="auto",

device_map="auto",

trust_remote_code=True,

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

prompts = [

"Give me a short introduction to large language models."

]

input_texts = []

for prompt in prompts:

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

input_texts.append(text)

model_inputs = tokenizer(input_texts, return_tensors="pt", return_token_type_ids=False, padding=True, padding_side='left').to(model.device)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=8192,

do_sample=False,

)

generated_ids = [

output_ids[len(input_ids):] for input_ids, output_ids in zip(model_inputs.input_ids, generated_ids)

]

responses = tokenizer.batch_decode(generated_ids, skip_special_tokens=True)

print(responses)

结论与前瞻

蚂蚁百灵团队这轮开源不仅贡献了一个高性能模型,更提供了一套完整的推理优化方案。随着混合线性架构的普及,大模型推理成本将持续下降,预计到2025年底,企业级AI应用部署门槛将降低70%以上。

未来,建议重点关注三个方向:

- 垂直领域优化:针对医疗、金融等专业场景的模型微调

- 边缘设备部署:基于模型稀疏性的移动端轻量化方案

- 多模态扩展:融合图像、语音等输入的混合模态处理

对于开发者和企业而言,现在正是评估并接入这一技术路线的最佳时机,以在算力成本持续高企的市场环境中建立竞争优势。

项目获取

git clone https://gitcode.com/hf_mirrors/inclusionAI/Ring-flash-linear-2.0

欢迎点赞、收藏、关注三连,获取更多大模型效率优化实践指南!下期将带来《Ring-flash-linear-2.0企业级部署全攻略》,敬请期待。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/inclusionAI/Ring-flash-linear-2.0

项目地址: https://ai.gitcode.com/hf_mirrors/inclusionAI/Ring-flash-linear-2.0