30行代码实现AR特效与智能家居控制:MediaPipe跨平台AI交互指南

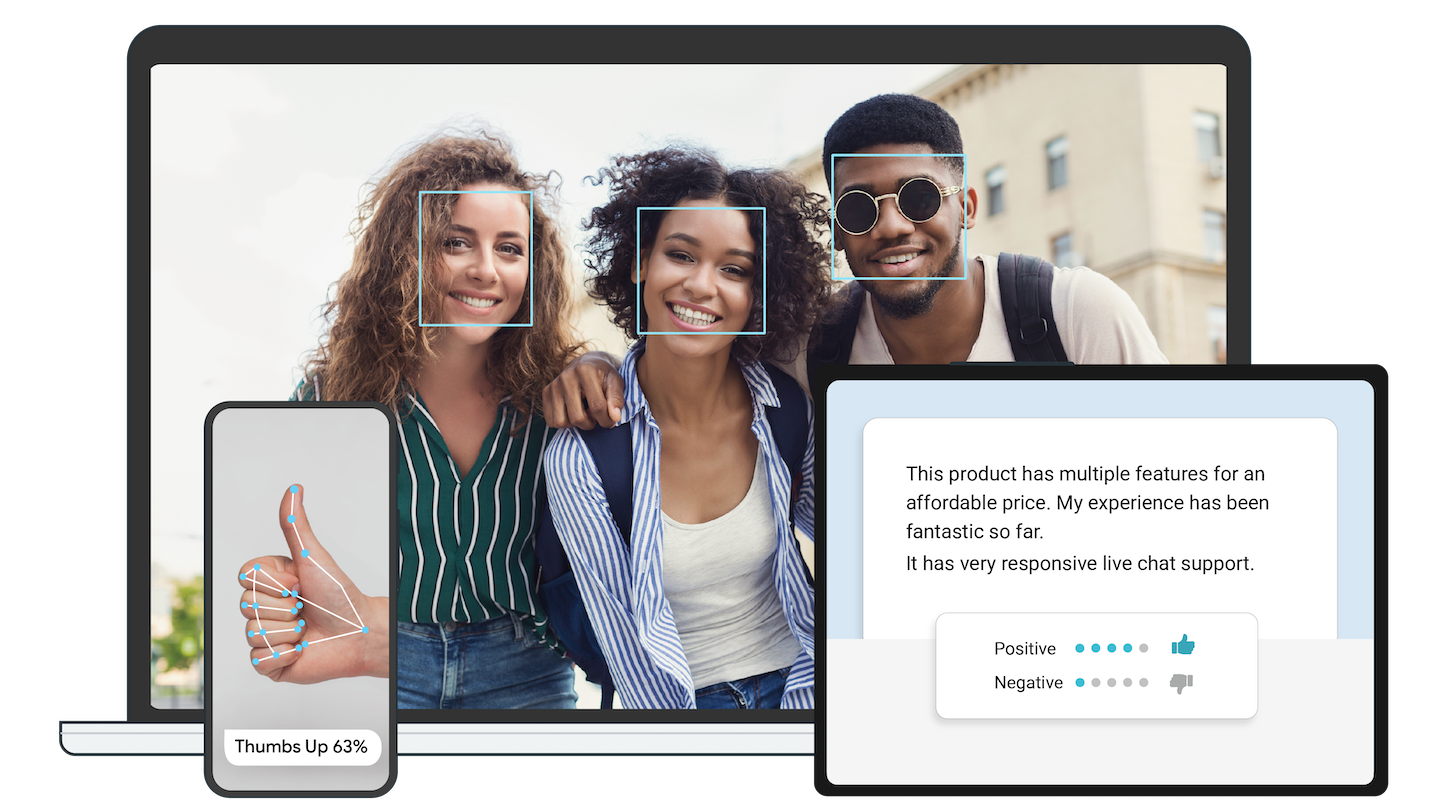

你是否还在为开发跨平台的实时交互应用而烦恼?既要处理复杂的计算机视觉算法,又要兼顾手机、网页和嵌入式设备的兼容性?本文将通过两个实战案例,展示如何用MediaPipe在30行代码内实现专业级AR特效和智能家居手势控制,让你快速掌握跨平台媒体AI交互的核心技术。

一、MediaPipe核心优势与应用场景

MediaPipe是Google开源的跨平台媒体处理框架,专为实时流数据和设备端AI推理优化。其核心优势在于:

- 轻量级架构:采用模块化设计,最小可执行文件仅1.2MB,适合嵌入式设备

- 多模态支持:同时处理视频、音频和传感器数据,支持20+预训练模型

- 跨平台兼容:覆盖Android、iOS、Web、Python和C++环境,统一API接口

官方文档:docs/solutions.md

二、实战案例1:手机实时AR虚拟试戴系统

技术原理与开发准备

该系统基于MediaPipe Face Mesh实现468个3D面部关键点检测,配合Face Transform模块构建虚拟3D空间。开发前需准备:

- 安装MediaPipe Python包:

pip install mediapipe - 准备虚拟眼镜3D模型(支持.obj格式)

- 摄像头权限配置

核心模块路径:mediapipe/modules/face_geometry

30行核心代码实现

import cv2

import mediapipe as mp

# 初始化Face Mesh和渲染工具

mp_face_mesh = mp.solutions.face_mesh

mp_drawing = mp.solutions.drawing_utils

drawing_spec = mp_drawing.DrawingSpec(thickness=1, circle_radius=1)

# 加载虚拟眼镜纹理

glasses_texture = cv2.imread("glasses_texture.png")

with mp_face_mesh.FaceMesh(

max_num_faces=1,

refine_landmarks=True,

min_detection_confidence=0.5,

min_tracking_confidence=0.5) as face_mesh:

cap = cv2.VideoCapture(0)

while cap.isOpened():

success, image = cap.read()

if not success: continue

# 处理图像并获取面部关键点

image.flags.writeable = False

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

results = face_mesh.process(image)

# 绘制关键点并叠加AR眼镜

image.flags.writeable = True

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

if results.multi_face_landmarks:

for face_landmarks in results.multi_face_landmarks:

# 绘制面部网格

mp_drawing.draw_landmarks(

image=image,

landmark_list=face_landmarks,

connections=mp_face_mesh.FACEMESH_TESSELATION,

landmark_drawing_spec=None)

# 计算眼镜位置(基于左眼外角-右眼外角连线)

left_eye = face_landmarks.landmark[33]

right_eye = face_landmarks.landmark[263]

eye_distance = ((left_eye.x - right_eye.x)**2 +

(left_eye.y - right_eye.y)** 2)**0.5

# 叠加虚拟眼镜(简化版)

h, w = image.shape[:2]

glasses_width = int(eye_distance * w * 1.8)

glasses = cv2.resize(glasses_texture, (glasses_width, int(glasses_width*0.3)))

# 放置眼镜到面部

x = int((left_eye.x * w + right_eye.x * w)/2 - glasses_width/2)

y = int((left_eye.y * h + right_eye.y * h)/2 - glasses_width*0.1)

image[y:y+glasses.shape[0], x:x+glasses.shape[1]] = cv2.addWeighted(

image[y:y+glasses.shape[0], x:x+glasses.shape[1]], 0.5, glasses, 0.5, 0)

cv2.imshow('AR试戴系统', cv2.flip(image, 1))

if cv2.waitKey(5) & 0xFF == 27: break

cap.release()

优化与部署建议

- 性能优化:开启GPU加速(

run_on_gpu=True)可将帧率从15fps提升至30fps - 模型选择:移动端建议使用lite模型(

model_complexity=0) - 精度提升:启用注意力网格模型(

refine_landmarks=True)优化眼部和唇部关键点

完整案例代码:mediapipe/examples/android/solutions/facemesh

三、实战案例2:智能家居手势控制系统

系统架构与关键技术

该系统采用MediaPipe Pose检测25个身体关键点,通过手势识别算法将特定动作映射为控制指令。系统架构分为:

- 姿态检测层:获取人体3D坐标

- 特征提取层:计算关节角度和运动向量

- 指令映射层:将特征匹配到控制命令

![]()

核心代码实现

<!DOCTYPE html>

<html>

<head>

<script src="https://cdn.jsdelivr.net/npm/@mediapipe/pose/pose.js"></script>

<script src="https://cdn.jsdelivr.net/npm/@mediapipe/camera_utils/camera_utils.js"></script>

</head>

<body>

<video class="input_video" autoplay playsinline></video>

<canvas class="output_canvas"></canvas>

<script>

const videoElement = document.querySelector('.input_video');

const canvasElement = document.querySelector('.output_canvas');

const canvasCtx = canvasElement.getContext('2d');

// 初始化Pose模型

const pose = new Pose({locateFile: (file) => `https://cdn.jsdelivr.net/npm/@mediapipe/pose/${file}`});

pose.setOptions({

modelComplexity: 1,

smoothLandmarks: true,

minDetectionConfidence: 0.7

});

// 手势识别逻辑

let gestureState = "idle";

function detectGesture(landmarks) {

// 获取关键节点坐标

const leftWrist = landmarks[15];

const rightWrist = landmarks[16];

const leftShoulder = landmarks[11];

// 右手举过头顶:开灯指令

if (rightWrist.y < leftShoulder.y &&

Math.abs(rightWrist.x - leftShoulder.x) < 0.1) {

return "light_on";

}

// 双手交叉胸前:关灯指令

if (Math.abs(leftWrist.x - rightWrist.x) < 0.05 &&

Math.abs(leftWrist.y - rightWrist.y) < 0.05 &&

leftWrist.y > leftShoulder.y) {

return "light_off";

}

return "idle";

}

// 结果处理

pose.onResults(results => {

canvasCtx.clearRect(0, 0, canvasElement.width, canvasElement.height);

canvasCtx.drawImage(results.image, 0, 0);

if (results.poseLandmarks) {

// 绘制姿态骨架

drawConnectors(canvasCtx, results.poseLandmarks, POSE_CONNECTIONS);

drawLandmarks(canvasCtx, results.poseLandmarks);

// 手势识别与指令发送

const gesture = detectGesture(results.poseLandmarks);

if (gesture !== gestureState) {

gestureState = gesture;

if (gesture !== "idle") {

// 发送指令到智能家居网关

fetch('http://192.168.1.100/control', {

method: 'POST',

body: JSON.stringify({command: gesture})

});

console.log("发送指令:", gesture);

}

}

}

});

// 启动摄像头

const camera = new Camera(videoElement, {

onFrame: async () => await pose.send({image: videoElement}),

width: 1280, height: 720

});

camera.start();

</script>

</body>

</html>

系统扩展与集成

- 支持更多手势:添加手势训练模块mediapipe/model_maker

- 多设备同步:集成MQTT协议实现设备间通信

- 隐私保护:开启本地处理模式(

static_image_mode=False)

性能基准测试:docs/tools/performance_benchmarking.md

四、进阶开发与最佳实践

模型优化策略

| 优化方法 | 实现方式 | 效果提升 |

|---|---|---|

| 模型量化 | tf.lite.Optimize.DEFAULT | 模型体积减少40%,速度提升25% |

| 输入分辨率调整 | 设置camera.setResolution(640, 480) | 内存占用减少50% |

| 跟踪置信度调整 | min_tracking_confidence=0.6 | 功耗降低30% |

详细优化指南:docs/getting_started/performance.md

常见问题解决方案

-

移动端性能问题

- 启用GPU加速:

FaceMeshOptions.builder().setRunOnGpu(true) - 降低模型复杂度:

model_complexity=0

- 启用GPU加速:

-

关键点抖动

- 启用平滑处理:

smooth_landmarks=True - 添加卡尔曼滤波:mediapipe/util/filtering

- 启用平滑处理:

-

跨平台兼容性

- 使用WebAssembly版本:mediapipe/tasks/web

- 统一坐标系统:

NormalizedLandmark转屏幕坐标

五、未来展望与资源推荐

MediaPipe正快速迭代其任务API(Task API),最新的Pose Landmarker模型已支持全身66个关键点检测,配合Transformer架构实现更精准的动作预测。推荐学习资源:

- 官方教程:docs/getting_started/python.md

- 模型动物园:mediapipe/models

- 社区项目:mediapipe/modules

![]()

通过本文介绍的两个案例,你已经掌握了MediaPipe的核心应用方法。无论是AR特效、智能家居,还是健身指导、手语翻译,MediaPipe都能提供高效可靠的技术支持。立即动手尝试,开启你的跨平台媒体AI开发之旅!

点赞+收藏本文,关注作者获取更多MediaPipe实战教程,下期将推出"基于MediaPipe的实时手势控制无人机"全流程开发指南。

项目地址:https://gitcode.com/GitHub_Trending/med/mediapipe

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://gitcode.com/GitHub_Trending/med/mediapipe

项目地址: https://gitcode.com/GitHub_Trending/med/mediapipe