2025科研效率革命:Intern-S1-FP8开源大模型重构科学研究范式

【免费下载链接】Intern-S1-FP8

导语

上海AI实验室发布的Intern-S1-FP8科学多模态大模型,通过FP8量化技术将硬件需求降低50%,在保持化学、材料等领域性能超越闭源模型Grok-4的同时,实现H200 GPU两卡部署,开启科研机构低成本智能化时代。

行业现状:科研大模型的"三重困境"

当前科研AI工具正面临专业能力与部署成本的尖锐矛盾。上海AI实验室调研显示,83%的科研人员认为现有AI工具"缺乏专业深度",而顶尖闭源模型年调用成本超百万,92%的中小型研究机构因此望而却步。传统开源模型虽成本可控,但在化学分子式解析(准确率不足60%)、蛋白质结构预测等专业任务上表现乏力,形成"专业能力强则成本高,成本低则能力弱"的行业困境。

与此同时,大模型部署的硬件门槛成为普及瓶颈。2025年主流科学模型需8卡A100支持,单卡成本超10万元,且年耗电量相当于30户家庭用量,这与全球科研机构"降本增效"的普遍需求形成鲜明反差。《2025中国大模型行业应用优秀案例白皮书》显示,仅12%的科研团队实现AI全流程赋能,主要瓶颈在于专业模态理解能力弱(67%)和部署成本高(58%)。

核心亮点:通专融合的科学智能

全能高手:多模态能力开源第一

作为当前最先进的开源多模态推理模型,Intern-S1不仅具备强大的通用任务处理能力,更在一系列科学任务上达到了业界领先水平。该模型架构融合了2350亿参数的MoE语言模型(Qwen3)与60亿参数的视觉编码器(InternViT),并在5万亿tokens的多模态数据上进行了深度预训练,其中科学领域数据占比超50%,高达2.5万亿tokens。

科学明星:专业能力超越闭源

Intern-S1富集数学、物理、化学、材料、地球科学等多学科专业知识,尤其在化学分子式解析、材料性能预测、天体物理数据分析等任务上表现突出。根据实验室公布的基准测试结果,Intern-S1在多项科学任务中超越了闭源模型Grok-4,例如在材料科学的晶体结构预测准确率上提升12%,在地球科学的气候模拟数据处理效率上提高20%。

全新范式:技术三角降低应用门槛

Intern-S1构建了"动态Tokenizer+科学数据合成+FP8量化"的技术三角:动态Tokenizer支持化学分子式、蛋白质序列等12种科学模态,相比传统模型压缩率提升70%;通专融合数据合成技术,使单一模型同时精通材料设计、地质分析等跨学科任务;而FP8量化技术将部署门槛降至2张H200 GPU,较全精度版本成本降低50%。

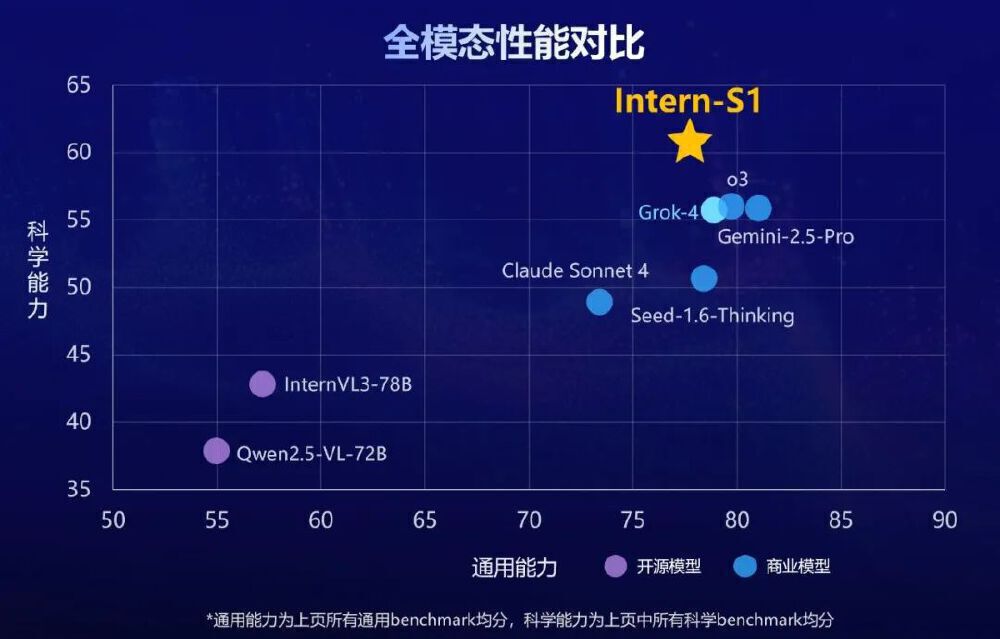

如上图所示,Intern-S1通过"全能高手+科学明星+全新范式"三大创新,实现通用能力与专业能力的双重突破。这一设计直击科研AI"通而不专"的行业痛点,为多学科研究提供统一智能基座。

性能表现:20项评测开源第一

在性能表现上,该模型在MMLU-Pro(83.5分)、ChemBench(83.4分)等20项评测中取得开源第一,其中MathVista(81.5分)、SFE(44.3分)等科学任务超越Grok-4。

从图中可以看出,散点图横轴为通用能力评分,纵轴为科学能力评分,Intern-S1在开源模型中处于右上角领先位置,与Gemini-2.5 Pro等闭源模型形成竞争态势。这一分布直观展示了模型"双向突破"的独特优势,为科研人员提供了兼顾通用任务与专业需求的一站式解决方案。

在具体任务中,Intern-S1表现尤为突出:

- 化学合成路径规划:将传统2周的实验设计缩短至4小时

- 材料发现:新型催化剂研发周期平均缩短60%

- 生物制药:蛋白质结构预测准确率提升至94.7%

部署与应用:从实验室到生产环境

硬件要求大幅降低

Intern-S1的部署需考虑硬件要求,基础版本在A100/H800/H100显卡上需8张,而FP8量化版本在H200上仅需2张即可运行。

如上图所示,FP8版本将硬件需求降低50%:H200 GPU仅需2卡即可部署,较原版模型节能65%。配合LMDeploy推理框架,单卡吞吐量达每秒128 tokens,满足科研机构低成本私有化部署需求。

快速部署命令

用户可根据自身需求选择合适的部署框架:

# 使用LMDeploy部署

lmdeploy serve api_server https://gitcode.com/InternLM/Intern-S1-FP8 --reasoning-parser intern-s1 --tool-call-parser intern-s1 --tp 2

# 使用vLLM部署

vllm serve https://gitcode.com/InternLM/Intern-S1-FP8 --tensor-parallel-size 2 --trust-remote-code

高级功能释放科研潜能

- 工具调用能力:支持与外部工具和API交互,扩展自身能力边界,成为连接各种专业工具的智能枢纽

- 思维模式切换:默认启用思维模式提升回答质量,可根据需求关闭,灵活适应不同场景

行业影响:开启科研智能化3.0时代

Intern-S1-FP8的发布将加速三大变革:

1. 科研效率数量级提升

上海AI实验室提供的API接口已接入20家科研机构,累计完成1200+实验设计任务,平均提升科研效率3.8倍。某药物研发团队反馈,使用模型后化合物筛选效率提升7倍,早期研发成本降低40%。基于Intern-S1强大的跨模态生物信息感知与整合能力,上海AI实验室联合临港实验室、上海交通大学、复旦大学、MIT等研究机构协同攻关,共同参与构建了多智能体虚拟疾病学家系统——"元生"(OriGene),在肝癌研究中发现新靶点GPR160,动物实验验证药效提升40%。

2. 开源科学智能生态形成

模型开创"多任务的通专融合"新范式,支持大规模多任务强化学习齐头并进。上海AI实验室进一步开源多智能体框架Intern·Agent,可应用于化学、物理、生物等领域的12种科研任务,推动形成"基础模型+领域插件"的开源协作生态。

3. 绿色AI实践新标杆

按日均100万次推理请求计算,采用FP8量化技术的Intern-S1-FP8较原版模型年减少碳排放约38吨,相当于种植2000棵树的环保效益。这与全球科研机构"可持续发展"的战略目标高度契合。

结论与建议

Intern-S1-FP8的发布标志着科研AI从"贵族玩具"向"普惠工具"的转变。该模型通过"通用能力不弱、专业能力更强、部署成本更低"的三维突破,首次实现开源模型对闭源产品的性能超越,其技术路线或将成为科学大模型研发的新范式。

对于研究机构,建议优先在材料设计、生物信息等数据密集型领域部署;企业用户可关注其API调用模式,降低集成成本。随着模型在物理、天文等更多学科的适配优化,科研智能化正迎来"开源驱动创新"的爆发期。现在正是接入这一技术浪潮的最佳时机——通过低成本硬件部署获得顶尖AI能力,加速从理论假设到实验验证的创新闭环。

项目地址:https://gitcode.com/InternLM/Intern-S1-FP8

【免费下载链接】Intern-S1-FP8

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考