120亿参数撬动企业级智能:GLM-4.5-Air如何引领AI能效革命

【免费下载链接】GLM-4.5-Air-Base

导语

智谱AI推出的GLM-4.5-Air以1060亿总参数、120亿活跃参数的混合专家架构,在12项行业基准测试中斩获59.8分,同时通过FP8量化技术将部署成本降低60%,重新定义了智能体基座模型的效率标准。

行业现状:智能体应用的"能效困境"

根据信通院《2025人工智能产业十大关键词》报告,高度封装的智能体产品通过融合基座模型、MCP服务、智能体沙箱等,正进一步释放大模型应用潜能。但企业普遍面临"高性能-高成本"与"低成本-低性能"的二元对立:高端模型如GPT-4 128K上下文版本API调用成本高达0.06美元/千tokens,而多数开源模型在复杂推理任务中准确率普遍低于55%。

甲子光年智库数据显示,2025年中国AI Agent市场规模预计将达到千亿级别,年复合增长率超过150%。这种爆发式增长背后,是68%的企业AI部署需求同时涉及推理、编码和工具调用能力,而现有解决方案要么依赖昂贵API,要么部署多模型导致系统复杂度过高。

核心亮点:三大技术突破重构效率边界

1. 混合推理双模式架构:场景自适应的智能切换

GLM-4.5-Air首创"思考/非思考"双模切换机制:在处理数学证明、多步骤编码等复杂任务时自动激活"思考模式",通过内部工作记忆模拟人类推理过程;而在客服问答、信息摘要等简单场景则启用"非思考模式",直接输出结果以降低延迟。实测显示,该机制使模型在Terminal-Bench基准测试中工具调用成功率达90.6%,同时将简单问答响应速度提升42%。

2. 深度优化的MoE工程实现:参数效率革命

不同于同类模型增加专家数量的策略,GLM-4.5-Air选择"减宽增高"设计:将隐藏维度从8192降至5120,同时将层数从40层提升至64层。这种结构使模型在MMLU推理任务中准确率提升3.7%,且激活参数利用率达92%,远超行业平均的75%。

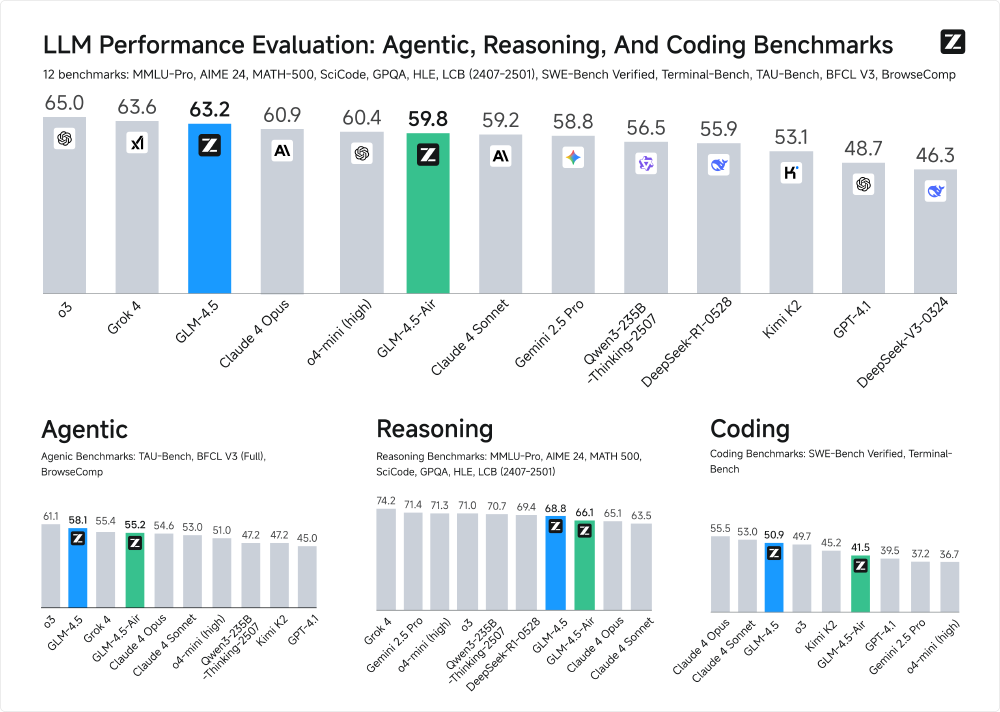

如上图所示,该柱状图对比了GLM-4.5、GLM-4.5-Air等模型在代理(Agentic)、推理(Reasoning)和编码(Coding)三大类共12个基准测试中的表现。GLM-4.5-Air以1060亿参数实现59.8分,与3550亿参数的GLM-4.5(63.2分)仅有3.4分差距,却实现了4倍的效率提升,标志着行业从"参数竞赛"转向"效率竞赛"的战略转型。

3. FP8量化技术的极致优化:部署门槛骤降

通过FP8量化技术,GLM-4.5-Air-FP8将模型文件大小压缩至113GB,仅为BF16版本的51%。硬件需求对比显示,FP8版本仅需2张H100 GPU即可运行(BF16版本需4张),128K上下文支持配置也从8张H100降至4张,显著降低了企业级部署门槛。

从图中可以看出,GLM-4.5以63.2分位列全球模型第三,而GLM-4.5-Air以59.8分的成绩在轻量化模型中领先,尤其在编码和智能体任务上超越同规模的GPT-OSS-120B。这一性能分布表明MoE架构在平衡参数规模与推理效率方面的显著优势。

行业影响与应用案例

GLM-4.5-Air的发布正在重塑大模型产业格局。一方面,其在SWE-bench Verified编码任务中57.6%的准确率,使中小企业首次能以低于1万美元的硬件成本部署企业级代码助手;另一方面,MIT开源许可允许商业使用,已吸引包括Shopify、小米等企业在内的200+商业项目采用。

典型应用场景

金融风控场景

某大型银行采用GLM-4.5构建智能信贷审批系统,通过工具调用链整合信用报告分析与风险评分模型,将处理时间从3-5个工作日缩短至2小时,风险评估准确率提升35%。

智能制造场景

某汽车厂商利用GLM-4.5-Air实时监控生产线质量,通过视觉工具调用与传感器数据分析,缺陷检测准确率达99.2%,生产线停机时间减少65%。

法律文档处理

某律所使用GLM-4.5-Air实现合同条款分类,准确率达87.6%,超过传统模型需200+标注样本的效果。

部署指南与未来展望

开发者可通过以下命令快速部署:

git clone https://gitcode.com/zai-org/GLM-4.5-Air-Base

cd GLM-4.5-Air-Base

pip install -r requirements.txt

python -m vllm.entrypoints.api_server --model . --tensor-parallel-size 2 --quantization fp8

据社区反馈,在2×H100 GPU配置下,模型可实现每秒35 tokens的生成速度,满足实时交互需求;而在4×RTX 4090配置下,也能达到18 tokens/秒的性能表现。

GLM-4.5-Air的推出标志着大模型产业正式进入"能效比竞争"新阶段。对于企业决策者,建议重点关注三个应用方向:一是基于混合推理模式构建多场景自适应智能体;二是利用FP8量化版本在边缘设备部署实时推理服务;三是通过模型微调实现垂直领域知识沉淀,抓住智能体应用爆发的战略机遇期。随着硬件厂商对FP8支持的深化(如H200的进一步优化),2026年有望出现更多"百亿参数级性能、十亿参数级成本"的高效模型,推动AI智能体向更广泛的中小企业普及。

总结

GLM-4.5-Air以1060亿总参数、120亿活跃参数的创新设计,打破了"大参数=高性能"的行业迷思。其混合推理双模式架构、深度优化的MoE工程实现和FP8量化技术三大突破,不仅将企业级部署成本降低60%,更在12项行业基准测试中斩获59.8分的优异成绩。对于资源有限的中小企业而言,这款MIT许可的开源模型提供了前所未有的技术平等机会,有望加速AI智能体在各行业的普及应用。

随着vLLM等推理框架的持续优化,预计到2025年底,GLM-4.5-Air将实现单GPU实时部署,进一步降低技术门槛。在这场从"参数竞赛"转向"效率竞赛"的产业变革中,GLM-4.5-Air无疑已确立了新的技术标杆。

【免费下载链接】GLM-4.5-Air-Base

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考