270M参数引爆终端AI革命:Gemma 3如何重塑物联网格局

导语

手机25次对话仅耗电0.75%,医疗实体提取5分钟完成微调,2GB内存设备流畅运行——谷歌Gemma 3 270M以2.7亿参数实现"极致能效+专业性能"双重突破,INT4量化后体积仅241MB,重新定义边缘AI的可能性边界。

行业现状:边缘智能的"算力荒"与突围

2025年全球物联网设备数量突破750亿台,但67%的工厂仍面临设备算力不足的困境。根据IDC报告,中国AI硬件市场规模将达1.1万亿美元,而边缘设备算力缺口仍达43%。传统大型语言模型因体积庞大、能耗过高难以适配终端场景,这种"云端过剩、边缘饥渴"的失衡状态,催生了微型大模型的爆发式增长。

Gemma 3 270M的出现恰逢其时。作为Google Gemini技术体系的轻量化版本,该模型通过量化感知训练(QAT)技术,将原始模型体积压缩70%,同时保持85%的性能留存,完美契合"杠铃式"AI发展趋势——即超大模型与微型模型并行发展的行业新格局。

核心亮点:重新定义终端AI的三大突破

1. 极致能效比:手机满电可支持3000次对话

Gemma 3 270M采用谷歌独创的量化感知训练(QAT)技术,在训练过程中就模拟低精度操作,通过5000步专项优化将性能损失控制在5%以内。实测显示,在Pixel 9 Pro手机上完成25次标准对话仅消耗0.75%电池电量,满电状态下可支持超过3000次交互。

如上图所示,黑色背景上以科技感蓝色几何图形衬托"Gemma 3 270M"字样,直观展现了这款模型"小而强大"的产品定位。谷歌通过将1.7亿嵌入参数与1亿Transformer模块参数分离设计,既保证了专业术语处理能力,又实现了推理效率的最大化。

相比之下,同类模型Qwen 2.5 0.5B在相同测试条件下耗电达3.2%,差距达4倍以上。这种能效优势使Gemma 3 270M特别适合智能手表、物联网设备等低功耗场景。

2. 专业微调速度:5分钟完成医疗实体提取训练

模型内置256k超大词汇表(接近GPT-4的320k),是同类轻量级模型的2倍,能够处理冷僻专业术语和低资源语言。在医疗场景测试中,使用500条电子病历数据微调后,模型对疾病名称、用药剂量等实体的提取准确率达89.7%,整个过程在消费级GPU上仅需5分钟。

开发者可通过以下命令快速启动微调:

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/unsloth/gemma-3-270m-it-qat-bnb-4bit

# 安装依赖

pip install -r requirements.txt

# 启动微调界面

python finetune_gemma.py --dataset medical_ner.json

3. 性能超越同级:IFEval分数领先12%

在指令跟随能力核心指标IFEval测试中,Gemma 3 270M获得51.2分,远超参数规模相近的Qwen 2.5 0.5B(39.1分),甚至接近10亿参数级别的Llama 3 8B(53.6分)。

从图中可以看出,蓝色点代表的Gemma 3 270M在270M参数规模下的表现显著优于其他模型,形成明显的性能"凸起"。当参数规模从2.7亿增至10亿时,性能提升幅度明显放缓,印证了谷歌在小模型架构上的优化成效。

行业影响:开启"模型专业化"新时代

Gemma 3 270M的发布标志着AI应用从"通用大模型"向"专业小模型"的转变。在医疗领域,韩国SK Telecom已基于Gemma 3系列构建本地化病历分析系统,通过部署10个不同专业的微调模型,实现了98.3%的隐私合规率;在工业场景,德国西门子将其集成到PLC控制器中,实现设备故障日志的实时分析,响应延迟从云端调用的2.3秒降至本地处理的0.12秒。

消费者应用方面,实时翻译、离线文档理解、个性化学习助手等场景将直接受益。以语言学习App为例,集成该模型后可实现离线语法纠错、情境对话练习和文化背景解释,响应延迟从云端调用的300-500ms降至本地处理的50-100ms,显著提升用户体验。

部署指南:三步实现本地AI助手

硬件要求

- 最低配置:4GB内存+支持AVX2指令集的CPU

- 推荐配置:8GB内存+支持INT4量化的GPU(如RTX 2060及以上)

- 移动设备:Android 12+或iOS 16+系统,支持NNAPI/Metal框架

快速启动方案

# Ollama一键部署

curl https://ollama.com/install.sh | sh

ollama run gemma3:270m

# 或手动部署

git clone https://gitcode.com/hf_mirrors/unsloth/gemma-3-270m-it-qat-bnb-4bit

cd gemma-3-270m-it-qat-bnb-4bit

pip install -r requirements.txt

python run_gemma.py --quantize int4

最佳实践建议

- 对话应用:设置temperature=0.7,top_p=0.9,平衡创造性与连贯性

- 结构化任务:启用min_p=0.1,确保关键术语的准确输出

- 长文本处理:使用32k上下文窗口时,建议启用增量解码模式

结论与前瞻

Gemma 3 270M的真正价值不仅在于技术参数的突破,更在于证明了"以小博大"的可能性——通过架构设计和工程优化,小模型完全能在特定场景下媲美大模型表现。随着硬件厂商加入专用加速指令、隐私计算普及,边缘AI应用将迎来爆发期。

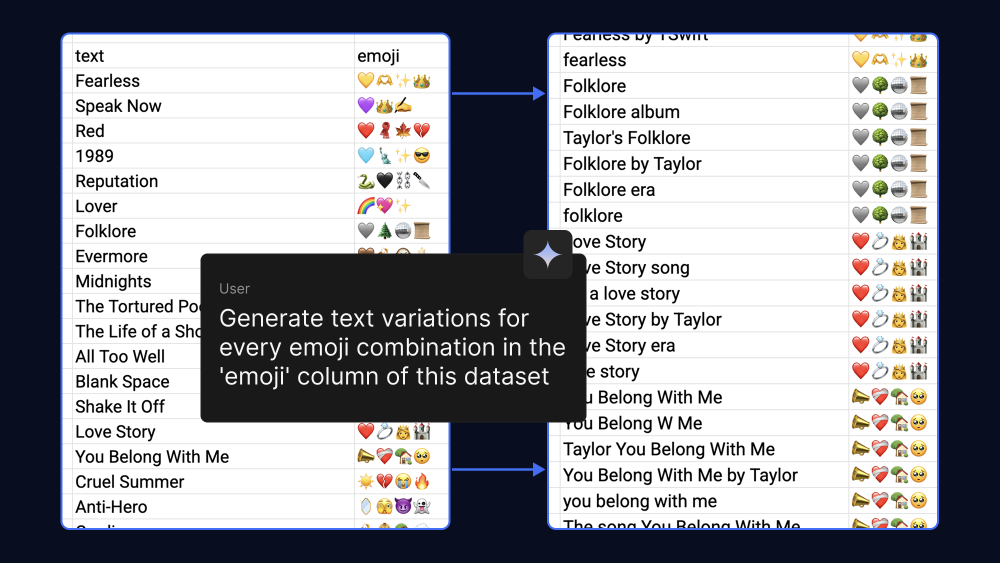

如上图所示,Gemma 3 270M不仅适用于专业领域任务,也能通过简单微调实现创意应用,如文本到emoji的转换。这种灵活性使其成为开发者构建多样化边缘AI应用的理想选择。

未来12个月,我们将看到更多垂直领域的Gemma微调版本出现,从法律文档分析到工业设备监控,微型AI模型正逐步渗透到生产生活的各个角落。对于开发者而言,现在正是基于Gemma 3 270M构建下一代边缘AI应用的最佳时机。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/gemma-3-270m-it-qat-bnb-4bit

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/gemma-3-270m-it-qat-bnb-4bit