Qwen3-VL震撼发布:多模态AI新纪元,重新定义视觉语言交互边界

【免费下载链接】Qwen3-VL-8B-Thinking

在人工智能多模态交互领域,一场革命性的突破正悄然发生。Qwen3-VL作为Qwen系列迄今为止最为强大的视觉语言模型,携带着全面升级的技术矩阵与功能体系,正式揭开神秘面纱。这不仅是一次版本迭代,更是对视觉与语言融合理解范式的重构,其卓越的文本处理能力、深度视觉感知推理机制、超长上下文驾驭能力,以及在空间动态与智能体交互等维度的突破性进展,共同构筑起新一代多模态AI的技术高地。无论是边缘计算场景的轻量化部署,还是云端大规模应用的算力需求,Qwen3-VL通过密集型与MoE(混合专家)双重架构设计,并辅以Instruct指令调优和推理增强的Thinking版本,为不同行业用户提供了前所未有的灵活部署选择,开启了多模态智能应用的无限可能。

视觉智能体:跨越数字界面的自主任务执行者

Qwen3-VL最引人瞩目的革新之一,便是其深度整合的视觉智能体系统。这一系统不再局限于传统的图像识别或文本理解,而是进化为能够自主感知并操控数字界面的智能实体。它可以精准识别PC端或移动端图形用户界面(GUI)中的各类元素,从按钮、菜单到复杂的交互组件,Qwen3-VL都能理解其功能逻辑与操作路径。在此基础上,模型能够根据用户需求主动调用系统工具,完成一系列连贯的任务流程。例如,在办公场景中,它可以自动识别文档编辑器界面,根据用户输入的文字描述调整格式、插入图表;在移动应用操作中,它能模拟人类手指的点击、滑动动作,完成App内的信息查询、数据填报等复杂操作。这种从“理解”到“行动”的跨越,使得Qwen3-VL不再仅仅是信息处理工具,更成为了能够独立完成实际工作的数字助手,极大地拓展了AI在自动化办公、智能客服、无障碍交互等领域的应用边界。

视觉编码与空间感知:从像素到结构的深度解析

在视觉信息处理的底层技术层面,Qwen3-VL实现了质的飞跃。其视觉编码能力已突破传统图像理解的范畴,能够直接从图像或视频流中生成结构化的代码表示。无论是专业的流程图绘制工具Draw.io的文件格式,还是构建网页所需的HTML、CSS与JavaScript代码,Qwen3-VL都能精准输出,实现了视觉内容到数字产品的直接转化。这意味着设计师的手绘草图可以瞬间转化为可交互的网页原型,视频中的动态场景可以自动生成对应的动画代码片段,极大缩短了创意到实现的开发周期。

与此同时,模型的高级空间感知能力也树立了新的行业标准。它不仅能够精确判断物体在二维空间中的位置、相互间的遮挡关系以及拍摄视角,更实现了从2D定位到3D空间推理的跨越。这种能力使得Qwen3-VL在具身AI领域展现出巨大潜力,例如在机器人导航中,它可以根据摄像头捕捉的实时画面构建环境的三维坐标,规划避障路径;在虚拟 reality(VR)内容创建中,能够将现实世界的物体尺寸、空间布局精确映射到虚拟场景,创造出高度逼真的沉浸式体验。空间感知的深度强化,让Qwen3-VL真正“看懂”了世界的结构,为物理世界与数字世界的融合架起了技术桥梁。

长上下文与视频理解:突破信息处理的时空限制

面对当今信息爆炸时代的海量数据,Qwen3-VL在上下文处理能力上实现了历史性突破。模型原生支持高达256K tokens的上下文窗口,并可通过技术扩展至100万tokens级别,这意味着它能够一次性处理整本书籍的文本内容,或是长达数小时的视频流数据。在长文本理解方面,Qwen3-VL不仅能完整回忆文档中的关键信息,更能理解段落间的逻辑关联与整体叙事结构,为学术研究、法律分析等需要深度研读长文档的场景提供了强大支持。

在视频理解领域,Qwen3-VL的表现同样令人惊叹。它具备秒级精度的视频帧索引能力,能够对长时间视频内容进行逐帧分析与内容提取。无论是电影片段中的情节发展、体育比赛的关键动作,还是监控录像中的异常行为,模型都能准确捕捉并生成结构化的描述与分析报告。例如,在教育领域,它可以将一堂数小时的课程视频自动拆解为知识点片段,生成带时间戳的笔记;在安防领域,能够实时监控并识别视频流中的可疑行为,及时发出预警。长上下文与视频理解能力的结合,使得Qwen3-VL成为处理超大容量、时序性多模态数据的理想选择。

多模态推理与视觉识别:学术研究与日常应用的全能助手

Qwen3-VL在多模态推理方面的进步尤为显著,特别是在STEM(科学、技术、工程、数学)领域展现出卓越的问题解决能力。模型能够进行复杂的因果关系分析,基于输入的图像与文本证据,构建严密的逻辑推理链,最终给出准确的答案。例如,在数学解题中,面对包含公式、图表的复杂问题,Qwen3-VL不仅能识别其中的数学符号与图形信息,更能理解题目背后的数学原理,分步推导得出结果,并附上详细的解题过程说明。这种基于证据的推理能力,使其在科研辅助、教育辅导等场景中具备极高的实用价值。

视觉识别系统的全面升级,是Qwen3-VL另一大亮点。通过更广泛、更高质量的预训练数据覆盖,模型实现了“万物可识”的目标。无论是现实中的名人面孔、地标建筑、商品品牌,还是虚拟世界的动漫角色、游戏道具,亦或是自然界的奇花异草、珍稀动物,Qwen3-VL都能快速准确地识别并提供丰富的背景信息。这种全方位的视觉识别能力,使其在内容审核、智能检索、文化传播等领域大显身手,为用户打造了一个随身携带的“视觉百科全书”。

OCR与文本理解:打破语言壁垒的文档智能专家

光学字符识别(OCR)功能在Qwen3-VL中得到了全面强化,语言支持种类从19种大幅扩展至32种,覆盖了更多全球性语言及地区方言。更重要的是,模型在极端条件下的OCR表现实现了质的飞跃。在低光照、图像模糊或文字倾斜的情况下,Qwen3-VL依然能够保持高识别率,有效解决了传统OCR技术在复杂环境下的局限性。对于古籍文献、历史档案中常见的稀有文字、古代字符以及专业领域的生僻术语,模型也能通过深度预训练习得其特征,实现准确识别与转录。

在长文档结构解析方面,Qwen3-VL同样表现出色。它能够自动识别文档的章节标题、段落层级、表格、图片说明等结构信息,将扫描版PDF或图片格式的文档转化为可编辑、可检索的结构化文本。这一功能在数字化档案馆建设、学术论文整理、企业文档管理等场景中具有不可估量的价值,极大提升了信息处理的效率与准确性。值得一提的是,Qwen3-VL的文本理解能力已达到与纯文本大语言模型(LLM)相当的水平,通过无缝的文本-视觉融合技术,实现了两种模态信息的无损、统一理解,确保了多模态输入下信息传递的完整性与准确性。

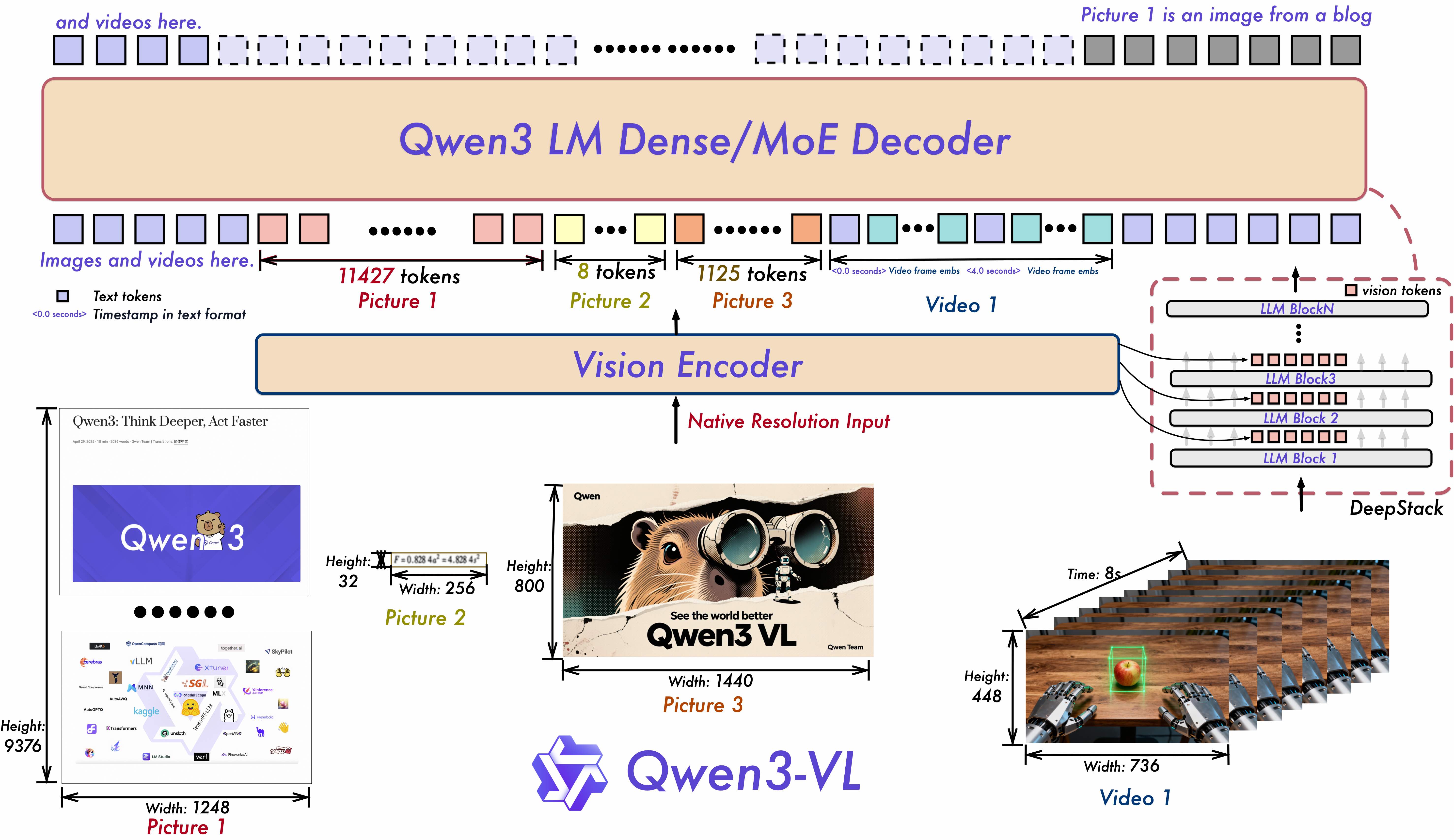

架构革新:Interleaved-MRoPE与DeepStack驱动的性能飞跃

Qwen3-VL的卓越性能,离不开其底层架构的两项关键创新:Interleaved-MRoPE位置嵌入与DeepStack特征融合技术。这些核心升级在模型架构图中得到了清晰展现,为理解其内部工作机制提供了直观视角。

如上图所示,Qwen3-VL的架构核心包含了Interleaved-MRoPE位置嵌入模块和DeepStack特征融合模块。这一架构设计充分体现了模型在时空维度信息处理与多尺度视觉特征融合上的技术突破,为开发者深入理解模型工作原理、进行二次开发与优化提供了重要参考。

如上图所示,Qwen3-VL的架构核心包含了Interleaved-MRoPE位置嵌入模块和DeepStack特征融合模块。这一架构设计充分体现了模型在时空维度信息处理与多尺度视觉特征融合上的技术突破,为开发者深入理解模型工作原理、进行二次开发与优化提供了重要参考。

Interleaved-MRoPE(交错式修改旋转位置编码)技术通过强大的位置嵌入机制,在时间、宽度和高度三个维度上实现了全频率的信息分配。这一创新有效解决了传统位置编码在长序列处理中容易出现的信息衰减问题,尤其增强了模型对长时视频流的时序推理能力。无论是视频中物体运动轨迹的预测,还是多帧图像间语义关联的建立,Interleaved-MRoPE都能提供精准的位置信息支撑。

DeepStack技术则聚焦于视觉特征的深度融合。它通过融合多级视觉Transformer(ViT)提取的特征信息,既保留了图像的细粒度细节,如纹理、颜色、局部形状,又强化了高层语义特征的表达,如物体类别、场景属性、情感倾向。这种多级特征的有机融合,显著提升了图像与文本之间的对齐精度,使得Qwen3-VL在跨模态任务中能够更准确地理解“图意”与“文意”,实现真正意义上的“看图说话”与“依文绘图”。

结语:多模态智能的未来已来

Qwen3-VL的发布,标志着视觉语言模型正式迈入了“全能感知、深度推理、自主行动”的新阶段。从技术架构的底层创新,到应用场景的全面拓展,Qwen3-VL不仅展现了当前AI领域多模态融合的最高水平,更为各行各业的智能化转型提供了强大动力。在教育领域,它可以成为个性化辅导的智能教师,实时解答学生的图文疑问;在医疗健康领域,它能够辅助医生解读医学影像,快速识别病灶特征;在智能制造领域,它可以监控生产线的视觉数据,预测设备故障并优化生产流程。

随着技术的不断迭代,Qwen3-VL未来还将在更广阔的领域释放潜力。例如,结合增强现实(AR)技术,为用户提供实时的视觉信息叠加与交互指引;融入机器人系统,赋予机器更接近人类的环境感知与任务执行能力。可以预见,Qwen3-VL不仅是一款先进的AI模型,更是开启多模态智能时代的钥匙,它将重新定义人机交互的方式,推动整个社会向更高效、更智能的未来加速前进。对于开发者与行业用户而言,把握Qwen3-VL带来的技术机遇,将成为抢占下一波AI应用浪潮制高点的关键所在。

【免费下载链接】Qwen3-VL-8B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考