Qwen3-8B-Base:82亿参数如何重塑开源大模型格局

导语:混合推理革命,开源大模型进入动态效能时代

阿里巴巴通义千问团队于2025年推出的Qwen3-8B-Base,以82亿参数实现了性能与效率的双重突破,首创"思考/非思考"双模式推理架构,标志着开源大语言模型正式进入动态资源配置时代。这一模型不仅在代码生成、多语言处理等核心能力上超越同类产品,更通过三阶段预训练与架构优化,将企业级AI部署成本降低50%以上。

行业现状:性能与成本的双重困境

2025年企业级AI部署中,算力成本占比已达43%,成为制约大模型落地的核心瓶颈。一方面,GPT-4o等闭源模型虽性能强劲但调用成本高昂;另一方面,传统开源模型如Llama 3虽可本地部署,但在复杂推理任务中仍存显著差距。据PPIO平台数据显示,国内开源模型市场呈现"一超三强"格局,DeepSeek以90%份额领跑,Qwen系列则以5%-10%的稳定占比位居第二,成为企业级应用的重要选择。

如上图所示,蓝色背景上展示了Qwen3的品牌标识,配有卡通熊形象和白色"Qwen3"文字。这一视觉设计不仅强化了品牌认知,也体现了Qwen3系列在保持技术领先性的同时,致力于打造友好易用的开发者体验,降低企业与个人开发者的使用门槛。

核心亮点:技术创新与性能突破

1. 首创双模式推理架构

Qwen3-8B-Base最大的技术突破在于支持"思考模式"与"非思考模式"的动态切换。通过简单指令(如/think或/no_think),用户可根据任务复杂度灵活控制模型推理深度:

- 思考模式:针对数学推理、代码生成等复杂任务,模型通过长思维链逐步推演,在HumanEval代码测试中达到89.7%的Pass@1率

- 非思考模式:适用于信息检索、简单对话等场景,响应速度提升50%以上,显著降低算力消耗

这种设计打破了传统大模型"一刀切"的算力分配模式,实现了不同场景下的最优资源配置。

2. 三阶段预训练与架构优化

模型采用创新的三阶段预训练流程:

- 第一阶段:在30万亿token上进行基础语言建模,构建通用知识体系

- 第二阶段:聚焦STEM、编码等推理任务,通过5万亿高质量数据强化逻辑能力

- 第三阶段:专项训练长文本处理能力,将上下文长度扩展至32,768 tokens

架构上,模型采用36层Transformer结构,配备32个查询头和8个键值头(GQA注意力机制),非嵌入参数达6.95B,在保持性能的同时优化了计算效率。

3. 多语言能力与数据规模跃升

相比前代模型,Qwen3-8B-Base在多语言支持上实现质的飞跃:

- 支持119种语言,涵盖中文(含粤语)、阿拉伯语、斯瓦希里语等低资源语言

- 预训练数据量达36万亿token,包含丰富的编码、STEM、书籍和合成数据

- 中文处理能力尤为突出,在相关中文测试中表现超越同类英文模型

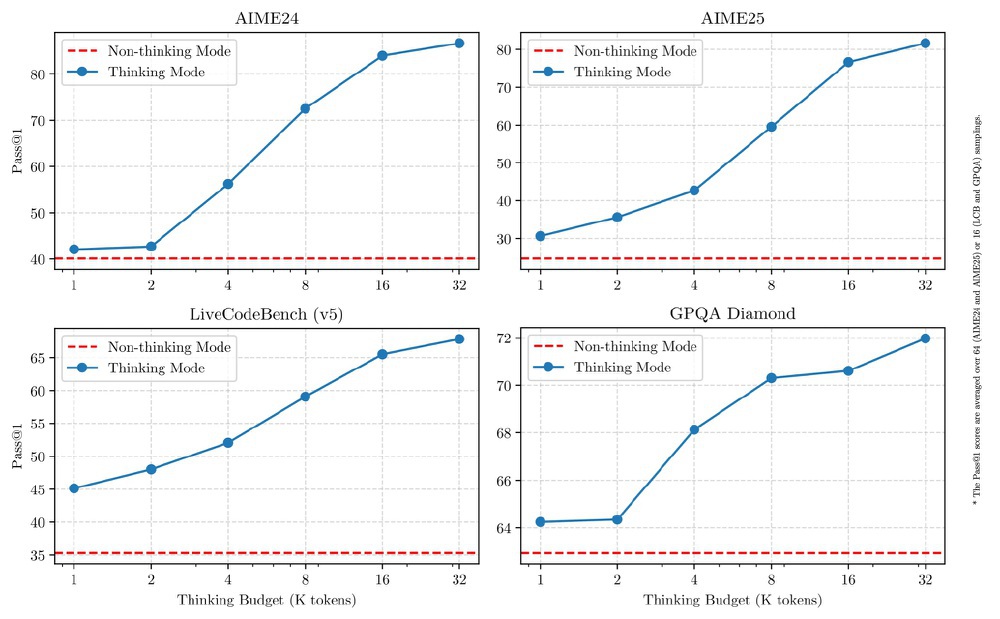

该图展示了Qwen3-8B-Base模型在AIME24、AIME25、LiveCodeBench (v5)和GPQA Diamond四种基准测试中,Thinking Mode与Non-thinking Mode随思考预算(K tokens)变化的Pass@1性能对比。蓝色线(Thinking Mode)随思考预算增加性能显著提升,尤其在数学推理任务中优势明显;红色虚线(Non-thinking Mode)性能基本稳定,体现了不同模式下的资源效率平衡。

性能表现:权威评测中的领先地位

在多项基准测试中,Qwen3-8B-Base表现出与更大规模模型竞争的能力:

- MMLU多任务测试得分78.3%,超越Llama 3 8B(76.5%)

- GSM8K数学推理准确率达95.3%,接近GPT-4o水平

- HumanEval代码生成Pass@1率89.7%,位列开源模型第一梯队

特别值得注意的是,在SGLang框架优化下,Qwen3系列模型展现出优异的推理效率:FP8精度模型在63488 tokens输入时实现1647.89 tokens/s的峰值性能,即使在129042 tokens极限输入下仍保持1442.14 tokens/s的高效推理能力,充分验证了其在长上下文处理上的工程优化水平。

应用场景与行业案例

Qwen3-8B-Base已在多个领域展现出实用价值:

1. 智能编程

- 集成到IDE工具中,实现代码自动补全和Bug修复

- 支持多语言代码生成,尤其在Python、Java等主流语言上表现突出

2. 教育辅助

- 作为个性化学习助手,提供数学问题分步解析

- 支持119种语言的跨文化教育资源生成

3. 工业应用

- 陕煤集团将其集成到矿山风险识别系统,设备故障预测准确率提升至89%

- 年节约维护成本超300万元,展现出显著的经济效益

行业影响与未来趋势

Qwen3-8B-Base的发布进一步缩小了开源模型与闭源模型的性能差距,其混合推理架构为行业树立了新的效率标准。随着多模态能力的融合和长上下文技术的突破,Qwen3系列有望在医疗、金融等专业领域发挥更大价值。

对于开发者和企业而言,现在正是探索Qwen3-8B-Base应用价值的最佳时机:

- 个人开发者可通过Ollama(

ollama run qwen3:8b)快速体验 - 企业用户可基于模型构建垂直领域解决方案,降低AI部署成本

- 研究人员可借助开源特性,深入探索大模型推理机制

结语:开源生态的新里程碑

Qwen3-8B-Base的推出代表了开源大模型发展的重要方向:通过架构创新而非单纯参数扩张来提升性能。其混合推理模式、高效预训练方法和多场景适配能力,为AI技术的普惠化提供了新的可能。正如阿里CEO吴泳铭所言:"开源是AI普惠的基石",Qwen3-8B-Base的发布不仅是技术突破,更是开源生态建设的重要一步,将加速AI技术在千行百业的落地应用。

立即体验Qwen3-8B-Base开源模型,访问仓库地址:https://gitcode.com/hf_mirrors/Qwen/Qwen3-8B-Base

#AI大模型 #通义千问 #开源AI #混合推理

如果觉得本文对你有帮助,请点赞、收藏、关注三连,下期我们将带来Qwen3系列模型的量化部署实战教程!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-8B-Base

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-8B-Base