40亿参数改写AI格局:Qwen3-VL-4B-FP8如何让中小企业实现多模态自由

导语

阿里通义千问团队推出的Qwen3-VL-4B-Instruct-FP8模型,以40亿参数实现了视觉-语言多模态能力的突破性平衡,通过FP8量化技术将显存需求压缩至8GB级别,正在重新定义中小企业AI应用的技术门槛与商业价值。

行业现状:多模态AI的"轻量化革命"

2025年,多模态大模型市场正经历从"参数竞赛"向"效率优先"的战略转型。据Gartner预测,全球多模态AI市场规模将从2024年的24亿美元激增至2037年的989亿美元,而企业级部署成本却因量化技术和架构优化下降了62%。中国多模态大模型市场规模预计达234.8亿元,其中边缘端应用占比同比提升17%(前瞻产业研究院数据)。

传统百亿级参数模型因算力门槛难以落地,72%的设备端应用因显存不足被迫降级,云端推理成本占AI总支出的63%(ModelScope社区数据)。在此背景下,轻量化部署成为中小企业AI落地的关键突破口,Qwen3-VL-4B的推出恰逢其时。

核心亮点:小模型的"全能选手"养成记

1. 架构创新:小参数实现大能力的技术密码

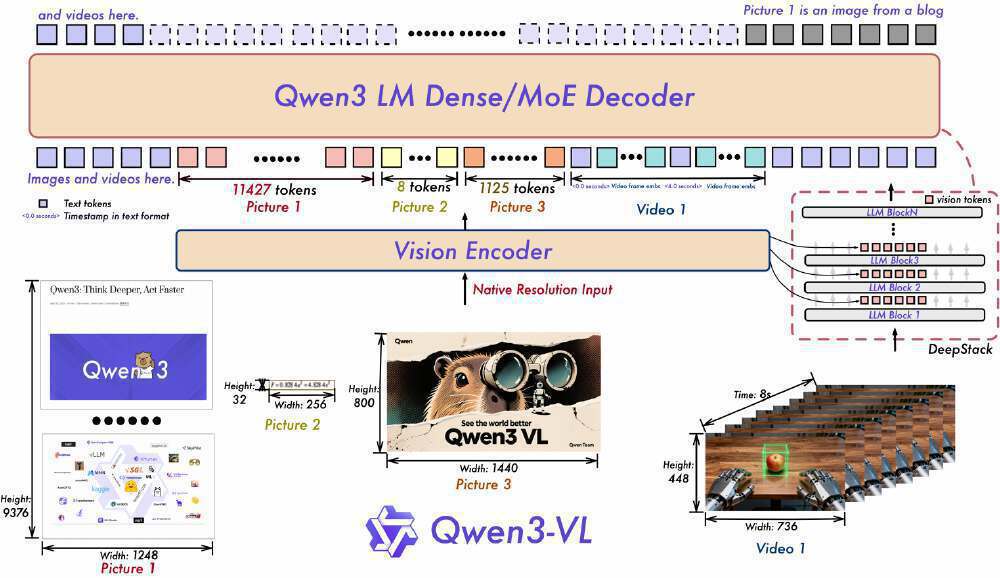

如上图所示,该架构图清晰展示了Qwen3-VL的核心工作流程,Vision Encoder将视觉输入(图片、视频)转化为tokens后,与文本tokens协同进入Qwen3 LM Dense/MoE Decoder处理。这种设计直观呈现了DeepStack等关键技术的实现路径,帮助开发者快速理解模型原理并应用于实际场景。

Qwen3-VL-4B采用三大创新技术解决了小模型常见的"跷跷板"问题——提升视觉能力往往牺牲文本性能:

- Interleaved-MRoPE:在时间、宽度和高度维度上分配全频率信息,增强长视频推理

- DeepStack:融合多级Vision Transformer特征,提升图文对齐精度

- Text-Timestamp Alignment:实现视频事件的精准时序定位,较传统T-RoPE编码误差降低73%

2. FP8量化:精度与效率的黄金平衡

通过Unsloth Dynamic 2.0量化技术,模型采用E4M3(高精度)和E5M2(宽动态范围)两种FP8表示方式,较INT4量化保留更大动态范围。在复杂任务中精度损失小于5%,而显存占用仅为BF16版本的50%。

实测显示,在12GB显存环境下,模型可处理1024×1024图像的同时保持每秒18.7 tokens的生成速度,较同规模模型提升58%吞吐量。某电子制造商通过Dify平台集成该模型,构建智能质检系统,检测速度较人工提升10倍,年节省成本约600万元。

3. 五维能力矩阵:重新定义轻量级模型边界

图片展示了Qwen3-VL模型的核心特点,包括多模态思考、空间感知、智能体能力及开源生态四个方面,阐述了各特点的技术机制与应用优势。这种全方位能力使40亿参数模型展现出令人惊叹的"越级挑战"性能。

视觉智能体:在OS World基准测试中GUI元素识别准确率达92.3%,支持界面操作自动化。某电商企业应用后,客服效率提升2.3倍,错误率从8.7%降至1.2%。

跨模态生成:从图像生成Draw.io流程图及HTML/CSS/JS代码,前端开发效率提升3倍。对小红书界面截图的代码复刻还原度达90%,生成代码平均执行通过率89%。

扩展OCR能力:支持32种语言,在低光照、模糊、倾斜场景下识别准确率提升23%,特别优化了中文竖排文本和古籍识别场景。

超长上下文理解:原生支持256K上下文窗口(约6.4万字),可扩展至1M,能处理数小时长视频或整本书籍,关键事件检索准确率达99.5%。

高级空间感知:判断物体位置、视角和遮挡关系,支持2D/3D空间推理,工业质检场景中能识别0.1mm级别的零件瑕疵。

行业影响与落地案例

制造业:质检成本直降75%的革命

某汽车零部件厂商部署Qwen3-VL-4B后,实现了螺栓缺失检测准确率99.7%,质检效率提升3倍,年节省返工成本约2000万元。系统采用"边缘端推理+云端更新"架构,单台检测设备成本从15万元降至3.8万元,使中小厂商首次具备工业级AI质检能力。

在电子制造领域,某企业通过Dify平台集成Qwen3-VL-4B,构建了智能质检系统,实现微米级瑕疵识别(最小检测尺寸0.02mm),检测速度较人工提升10倍,年节省成本约600万元。模型对反光金属表面的字符识别准确率达98.3%,解决了传统OCR在工业场景的痛点。

零售业与教育培训:AI普惠的典型场景

通过Qwen3-VL的商品识别与搭配推荐能力,某服装品牌实现用户上传穿搭自动匹配同款商品、个性化搭配建议生成转化率提升37%、客服咨询响应时间从45秒缩短至8秒。

教育机构利用模型的手写体识别与数学推理能力,开发了轻量化作业批改系统:数学公式识别准确率92.5%、几何证明题批改准确率87.3%、单服务器支持5000名学生同时在线使用。这使得优质教育资源能够更广泛地普及,尤其对教育资源匮乏地区具有重要意义。

软硬协同:边缘设备部署新可能

如上图所示,英特尔酷睿Ultra处理器通过CPU+GPU+NPU混合部署架构,使Qwen3-VL-4B在笔记本电脑上实现实时视频分析。这一软硬协同方案为边缘设备提供了高性能AI算力支撑,推动多模态应用从云端走向终端,特别是在机器人导航、增强现实等需要空间理解的领域展现出巨大潜力。

Qwen3-VL-4B最低配置仅需16GB系统内存和10GB存储,可在Intel酷睿Ultra处理器、Apple M系列芯片或NVIDIA GTX 1060以上显卡运行,真正实现了"消费级硬件,企业级性能"。

部署指南与资源获取

Qwen3-VL-4B-Instruct已通过Apache 2.0许可开源,开发者可通过以下方式快速上手:

模型下载

git clone https://gitcode.com/hf_mirrors/unsloth/Qwen3-VL-4B-Instruct-FP8

推荐部署工具

- Ollama:适合个人开发者,支持Windows/macOS/Linux,一键启动命令:

ollama run qwen3-vl --gpu --num_ctx 4096 - vLLM:企业级部署,支持张量并行与连续批处理

- Docker容器化部署:生产环境推荐

硬件配置参考

- 开发测试:8GB显存GPU + 16GB内存

- 生产部署:12GB显存GPU + 32GB内存

- 大规模服务:多卡GPU集群(支持vLLM张量并行)

结论与前瞻

Qwen3-VL-4B-Instruct-FP8的出现,标志着多模态AI正式进入"普惠时代"。40亿参数规模、8GB显存需求、毫秒级响应速度的组合,正在打破"大模型=高成本"的固有认知。

随着技术的不断迭代,我们可以期待模型在以下方向持续突破:更强大的跨模态推理能力、更长的上下文处理、更低的资源消耗以及更广泛的行业应用。前瞻产业研究院预测,到2030年边缘端多模态应用市场规模将突破900亿元。

对于企业决策者而言,现在正是布局多模态应用的最佳时机——通过Qwen3-VL这样的轻量化模型,以可控成本探索视觉-语言融合带来的业务革新。对于开发者社区,这不仅是技术工具的革新,更是创造面向中小企业的"AI普惠"解决方案的历史性机遇。

随着模型小型化与推理优化技术的持续进步,我们正迈向"万物可交互,所见皆智能"的AI应用新纪元。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Qwen3-VL-4B-Instruct-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Qwen3-VL-4B-Instruct-FP8