美团LongCat-Video开源:136亿参数视频大模型,推理速度提升10.1倍

【免费下载链接】LongCat-Video

导语

美团LongCat团队正式发布并开源136亿参数视频生成模型LongCat-Video,实现文生/图生/视频续写多任务统一,原生支持5分钟级长视频连贯生成,推理速度提升10.1倍,开启视频生成效率革命。

行业现状:视频生成进入"效率与质量"双突破时代

全球AI视频生成器市场正以20%的年复合增长率高速扩张,从2024年的6.15亿美元增长至2032年的25.63亿美元。当前主流模型面临三大痛点:长视频生成质量衰减、多任务需多模型适配、高分辨率推理效率低下。OpenAI Sora 2虽以超写实效果引领行业,但闭源模式限制技术普惠;开源领域则缺乏兼顾效率与质量的统一解决方案。

在此背景下,美团LongCat-Video的出现填补了开源生态在长视频生成领域的技术空白。作为国内首个支持分钟级连贯视频输出的开源模型,其13.6B参数规模在保持性能竞争力的同时,通过创新架构设计将720p/30fps视频推理时间压缩至分钟级,为内容创作、智能交互等场景提供了新可能。

技术亮点:四大创新突破行业瓶颈

统一模型架构:多任务一体化视频基座

LongCat-Video基于Diffusion Transformer(DiT)架构,创新通过"条件帧数量"实现任务区分:文生视频无需条件帧、图生视频输入1帧参考图、视频续写依托多帧前序内容,原生支持三大核心任务且无需额外模型适配。这种"一模型三任务"的设计大幅降低了开发者使用门槛,形成从文本创意到长视频生成的完整闭环。

在文生视频任务中,模型可精准解析文本描述中的物体属性、人物动作、场景布局及艺术风格,生成720p高清分辨率、30fps流畅帧率的视频内容。图生视频功能则严格保留参考图像的主体特征与背景关系,动态过程符合物理运动规律,支持从详细指令到空指令的多类型输入方式。

长视频生成:原生支持5分钟级连贯输出

作为核心差异化优势,LongCat-Video通过Block-Causual Attention机制和GRPO后训练技术,从根本上解决了行业普遍存在的色彩漂移、画质降解、动作断裂等痛点。在连续生成5分钟长视频的过程中,模型能保持跨帧时序一致性与物理运动合理性,完美满足数字人交互、具身智能训练等对长时序动态模拟有严苛要求的场景。

如上图所示,黑色背景上的绿色网络状图形与"LongCat-Video 正式发布"文字形成鲜明视觉对比,凸显美团在视频生成领域的技术突破。这一设计不仅传递了模型的科技感,也暗示了其构建"世界模型"的技术愿景,为开发者和行业决策者提供了直观的品牌认知。

高效推理:三重优化实现速度与质量平衡

针对高分辨率视频生成的计算瓶颈,LongCat-Video采用"二阶段粗到精生成(C2F)+块稀疏注意力(BSA)+模型蒸馏"的组合优化策略:

- C2F策略:先生成480p/15fps低分辨率视频,再经LoRA精调模块超分至720p/30fps,在降本提效的同时优化画面细节

- 块稀疏注意力:将3D视觉token分块后仅计算关键块注意力,使计算量降至标准密集注意力的10%以下

- 模型蒸馏:结合Classifier-Free Guidance与一致性模型蒸馏,将采样步骤从50步减至16步

三重优化使视频推理速度提升10.1倍,实现了720p/30fps视频的分钟级生成,打破了长视频生成"时长与质量不可兼得"的行业瓶颈。

性能评估:综合能力跻身开源SOTA

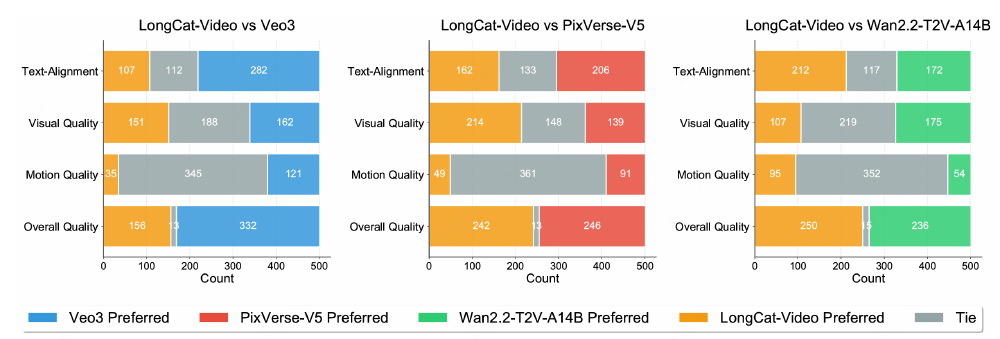

在内部基准测试中,LongCat-Video在文生视频任务的"文本对齐度"指标上获得3.76分(满分5分),超过Wan 2.2-T2V-A14B的3.70分;"整体质量"达到3.38分,领先PixVerse-V5(3.36分)和Wan 2.2(3.35分)。在VBench等公开基准测试中,模型在"常识理解"单项以70.94%的得分位居所有开源模型第一,展现出对真实世界物理规律的精准建模能力。

从图中可以看出,LongCat-Video在文本对齐、视觉质量、运动质量和整体质量四个维度上均表现优异,尤其在文本对齐度和整体质量指标上超过同量级开源模型。这一性能表现验证了美团在视频生成领域的技术实力,为开发者选择开源方案提供了客观参考依据。

行业影响:开源生态与商业价值共振

LongCat-Video的开源发布将加速视频生成技术在多领域的应用落地:

- 内容创作:自媒体创作者可通过文本快速生成高质量视频,大幅降低制作成本。以短视频营销场景为例,原本需要专业团队数天完成的广告片,现在可通过模型在小时级实现从创意到成片的全流程

- 智能交互:为数字人、虚拟主播提供连贯自然的动态表现,提升直播、客服等场景的用户体验

- 自动驾驶:通过模拟复杂交通场景的长时序视频,辅助自动驾驶系统的训练与测试

- 具身智能:为机器人提供物理环境动态预测能力,增强其在真实世界中的交互精度

值得注意的是,模型采用MIT开源协议,允许商业使用,这为企业级应用扫清了法律障碍。美团自身也计划将该技术应用于自动驾驶、即时配送等核心业务场景,探索"世界模型"在真实物理世界的落地可能。

快速上手:三步开启视频生成之旅

环境准备

git clone https://gitcode.com/hf_mirrors/meituan-longcat/LongCat-Video

cd LongCat-Video

conda create -n longcat-video python=3.10

conda activate longcat-video

pip install -r requirements.txt

模型下载

pip install "huggingface_hub[cli]"

huggingface-cli download meituan-longcat/LongCat-Video --local-dir ./weights/LongCat-Video

任务启动

- 文生视频:

torchrun run_demo_text_to_video.py --checkpoint_dir=./weights/LongCat-Video --enable_compile

- 图生视频:

torchrun run_demo_image_to_video.py --checkpoint_dir=./weights/LongCat-Video --enable_compile

- 视频续写:

torchrun run_demo_video_continuation.py --checkpoint_dir=./weights/LongCat-Video --enable_compile

未来展望:从视频生成到世界模型

LongCat-Video的发布仅是美团探索"世界模型"的第一步。随着技术迭代,团队计划在以下方向深化研究:

- 多模态融合:增强模型对音频、3D结构等信息的建模能力

- 交互能力:开发基于反馈的视频内容编辑功能

- 效率优化:进一步降低模型部署门槛,支持边缘设备推理

行业分析师指出,视频生成技术正在从"内容创作工具"向"世界模拟器"演进。LongCat-Video通过长时序动态建模展示的物理规律捕捉能力,为构建能够理解、预测并重构真实世界的AI系统提供了重要技术积累。在开源协作的推动下,这一技术路径有望加速通用人工智能的发展进程。

对于开发者和企业而言,现在正是接入视频生成技术的最佳时机。LongCat-Video提供的不仅是一个工具,更是一套完整的视频智能创作解决方案,其背后蕴含的多任务统一架构思想和高效推理策略,或将成为下一代视频生成系统的设计范式。

欢迎点赞、收藏本文,关注美团LongCat团队技术动态,第一时间获取模型更新与应用案例分享。下一期我们将深入解析LongCat-Video的Block-Causual Attention机制,敬请期待!

项目地址: https://gitcode.com/hf_mirrors/meituan-longcat/LongCat-Video

【免费下载链接】LongCat-Video

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考