150亿参数挑战千亿模型:ServiceNow发布Apriel-1.5,开启小模型企业级应用新纪元

导语

2025年9月30日,企业级AI解决方案提供商ServiceNow正式发布多模态推理模型Apriel-1.5-15b-Thinker(以下简称Apriel-1.5)。这款仅含150亿参数的模型在多项权威基准测试中超越参数规模10倍于它的竞品,重新定义了小语言模型(SLM)在企业场景的应用潜力。

行业现状:大模型"瘦身革命"全面爆发

当前AI行业正经历从"越大越强"到"高效智能"的战略转向。英伟达8月发布的研究显示,参数规模小于100亿的小模型在硬件成本、能耗效率和部署灵活性上优势显著,尤其适合企业级边缘计算场景。OpenAI近期也宣布将资源重心转向参数高效微调技术(PEFT),推动大模型轻量化落地。在此背景下,Apriel-1.5的出现标志着小模型已具备与前沿大模型正面竞争的技术实力。

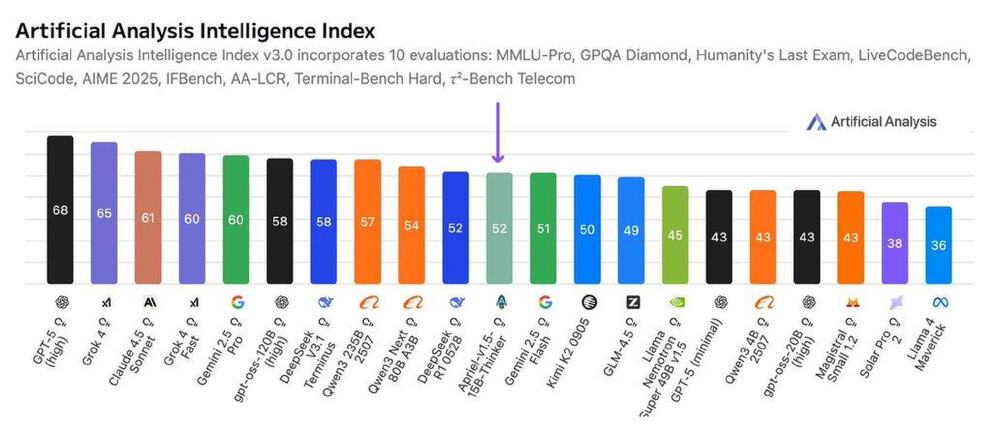

性能颠覆:15B参数实现52分智能指数

Apriel-1.5在第三方机构Artificial Analysis的智能指数测评中获得52分,与拥有685B参数的DeepSeek R1 0528持平,成为首个突破50分的15B级开放权重模型。更值得关注的是,其在企业关键基准测试中表现突出:IFBench(指令遵循)得分62%,τ²-Bench Telecom(电信行业任务)得分68%,均领先于同量级竞品。

如上图所示,Apriel-1.5(15B)与GPT-4.5(1.8T)、Claude 3 Opus(1.6T)等超大规模模型的智能指数得分处于同一梯队。这一对比直观展示了"小而精"的技术路线在参数效率上的革命性突破,为企业降低AI部署成本提供了新思路。

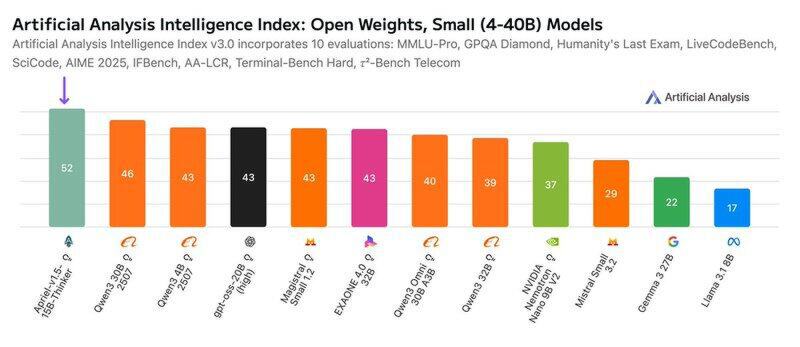

在开放权重小模型(<40B参数)细分领域,Apriel-1.5更是以52分的成绩大幅领先第二名(45分),印证了ServiceNow在数据筛选与训练方法上的技术优势。模型仅需单GPU即可运行,原生支持128K上下文窗口,特别适合处理企业级长文档分析、多轮对话等复杂任务。

核心创新:"中间训练"技术解决效率难题

ServiceNow研发团队创新性地提出"Mid-training is all you need"的技术理念,通过优化持续预训练(CPT)与监督微调(SFT)两个关键环节,在不使用RLHF(强化学习)的情况下实现了性能跃升。具体而言,模型在7天训练周期内(640×H100 GPU集群)完成了以下突破:

1. 多模态能力零样本迁移

Apriel-1.5在仅进行文本SFT的情况下,通过跨模态知识迁移实现图像推理能力。研发团队解释:"我们在持续预训练阶段注入了大量图文交织数据,使模型学会将文本推理逻辑迁移到视觉任务中。"这一设计大幅降低了多模态模型的训练成本。

2. 企业数据深度融合

针对τ²-Bench Telecom等行业基准的优异表现,源于训练数据中包含的200万+企业级指令样本,涵盖IT服务管理、客户支持自动化等ServiceNow核心业务场景。模型原生支持工具调用与API集成,可直接对接企业现有系统。

该柱状图清晰展示了Apriel-1.5在小模型阵营中的领先地位。与参数量相近的GPT-OSS-20B(43分)相比,其52分的成绩实现了21%的性能提升,证明了训练方法论创新比单纯增加参数更有效。ServiceNow工程师在技术博客中强调:"我们用1/10的计算资源实现了同等智能水平,这为AI可持续发展提供了新范式。"

企业级部署:从实验室到生产环境的无缝衔接

Apriel-1.5已在Hugging Face开放下载(MIT许可证),支持商业使用。官方提供完整部署工具链,包括:

- vLLM优化部署:通过自定义Docker镜像(docker.io/amant555/vllm_apriel:latest)实现每秒30+token的推理速度

- 多模态API接口:支持文本、图像输入,输出格式标准化为[BEGIN FINAL RESPONSE]/[END FINAL RESPONSE]包裹结构

- 企业安全框架:符合EU AI法案与NIST RMF标准,内置偏见检测与内容过滤模块

典型应用场景

- 智能IT运维:自动分析系统日志(文本)与监控图像,生成故障修复脚本

- 客户服务自动化:整合工单文本与用户上传截图,提供精准解决方案

- 代码辅助开发:支持Python/Java等多语言,在企业内部代码库上微调后准确率提升37%

技术解析:中间训练(Mid-training)的三大突破

ServiceNow在技术报告中详细阐述了Apriel-1.5的创新架构。与传统"预训练→微调"两步法不同,团队提出的"中间训练"框架包含三个递进阶段:

1. 持续预训练(CPT)

- 数据规模:1.2万亿tokens文本数据+8000万图文对

- 训练目标:优化数学推理(GSM8K准确率达78%)、代码生成(HumanEval pass@1达62%)等核心能力

- 创新点:动态难度调整机制,使模型优先学习高价值复杂样本

2. 监督微调(SFT)

- 样本构成:200万+高质量指令,其中企业场景占比42%

- 训练策略:采用"推理优先"范式,强制模型输出[BEGIN REASONING]/[END REASONING]中间步骤

- 效率优化:使用LoRA技术冻结95%参数,微调周期缩短至3天

3. 零样本能力激活

- 跨模态迁移:通过对比学习使视觉编码器与文本解码器共享语义空间

- 工具调用强化:在SFT阶段注入10万+API调用样本,实现自动工具选择

上图为Apriel系列模型的官方标识,火箭造型象征技术突破速度,而"A"字母的三色设计分别代表文本理解(蓝)、视觉推理(绿)与企业服务(橙)三大核心能力。这一设计理念恰如其分地诠释了模型"小而全"的技术定位。

行业影响与未来趋势

Apriel-1.5的发布将加速企业AI应用的三大变革:

- 成本重构:单GPU部署能力使企业AI基础设施成本降低70%以上

- 隐私增强:本地化部署满足金融、医疗等行业的数据合规要求

- 生态开放:MIT许可证允许商业微调,推动垂直领域定制化模型开发

ServiceNow研发团队透露,下一代模型将聚焦推理效率优化,目标将响应延迟从当前的1.2秒降至500ms以内,并计划推出7B轻量化版本。随着小模型技术持续成熟,企业级AI正步入"普惠时代"——不再是资源巨头的专属,而是所有组织都能部署的标准化能力。

实用指南:快速上手Apriel-1.5

本地部署(单GPU)

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/ServiceNow-AI/Apriel-1.5-15b-Thinker

cd Apriel-1.5-15b-Thinker

# 安装依赖

pip install -r requirements.txt

# 启动vLLM服务

python3 -m vllm.entrypoints.openai.api_server \

--model . \

--served-model-name Apriel-1p5-15B-Thinker \

--trust_remote_code \

--max-model-len 131072 \

--enable-auto-tool-choice \

--tool-call-parser apriel \

--reasoning-parser apriel

Python API调用示例

import torch

from transformers import AutoProcessor, AutoModelForImageTextToText

# 加载模型

model = AutoModelForImageTextToText.from_pretrained(

"ServiceNow-AI/Apriel-1.5-15b-Thinker",

torch_dtype=torch.bfloat16,

device_map="auto"

)

processor = AutoProcessor.from_pretrained("ServiceNow-AI/Apriel-1.5-15b-Thinker")

# 文本推理

chat = [{"role": "user", "content": [{"type": "text", "text": "分析这份服务器错误日志并提供解决方案"}]}]

inputs = processor.apply_chat_template(chat, add_generation_prompt=True, return_tensors="pt").to("cuda")

output = model.generate(inputs, max_new_tokens=1024)

print(processor.decode(output[0], skip_special_tokens=True))

结语

Apriel-1.5-15b-Thinker的发布不仅是一项技术突破,更代表着AI发展的新方向——通过精准的数据筛选、创新的训练方法和场景化优化,小模型完全能够在特定领域超越通用大模型。对于企业而言,这意味着更低的部署门槛、更可控的成本结构和更安全的本地化方案。随着技术持续迭代,我们有理由相信,未来的AI竞争将不再是参数规模的较量,而是效率与场景适配能力的比拼。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/ServiceNow-AI/Apriel-1.5-15b-Thinker

项目地址: https://ai.gitcode.com/hf_mirrors/ServiceNow-AI/Apriel-1.5-15b-Thinker