4-bit量化革命:Nunchaku FLUX.1让消费级GPU实现专业级AI绘图

导语

Nunchaku团队推出基于SVDQuant技术的4-bit量化版FLUX.1-Krea-dev模型,在保持图像生成质量的同时,将显存占用降低50%,推理速度提升30%,首次实现高端文生图模型在消费级硬件的流畅运行。

行业现状:大模型落地的硬件门槛困局

当前顶级文生图模型如FLUX.1-Krea-dev虽能生成电影级画质,但120亿参数规模需24GB以上显存才能流畅运行。据行业调研,超过60%的创作者因硬件限制无法体验最新模型。此前8-bit量化方案虽能降低显存占用,但生成速度仍不理想,而4-bit量化常导致图像细节丢失或"AI味"明显。

扩散模型与大语言模型的计算特性差异加剧了部署难度。不同于LLM的计算量随参数量线性增长,扩散模型的计算需求呈指数级上升——120亿参数的FLUX.1计算量达到惊人的1.2e4 TMACs,是同参数LLM的8倍以上。量子位智库《2025上半年AI核心成果及趋势报告》显示,效率优化已成为生成式AI发展的核心方向,而模型量化技术正是突破硬件限制的关键。

技术突破:SVDQuant如何实现"无损压缩"

Nunchaku团队推出的4-bit量化版FLUX.1-Krea-dev模型,核心创新在于SVDQuant技术的双分支设计:异常值聚合通过平滑操作将激活值中的异常值转移到权重,使95%的激活值分布在[-1,1]区间;低秩分解对权重执行SVD分解,将高幅值异常值吸收到16-bit低秩分支(秩32),残差部分进行4-bit量化;Nunchaku推理引擎将低秩分支计算融合进4-bit kernel,消除额外内存访问开销。

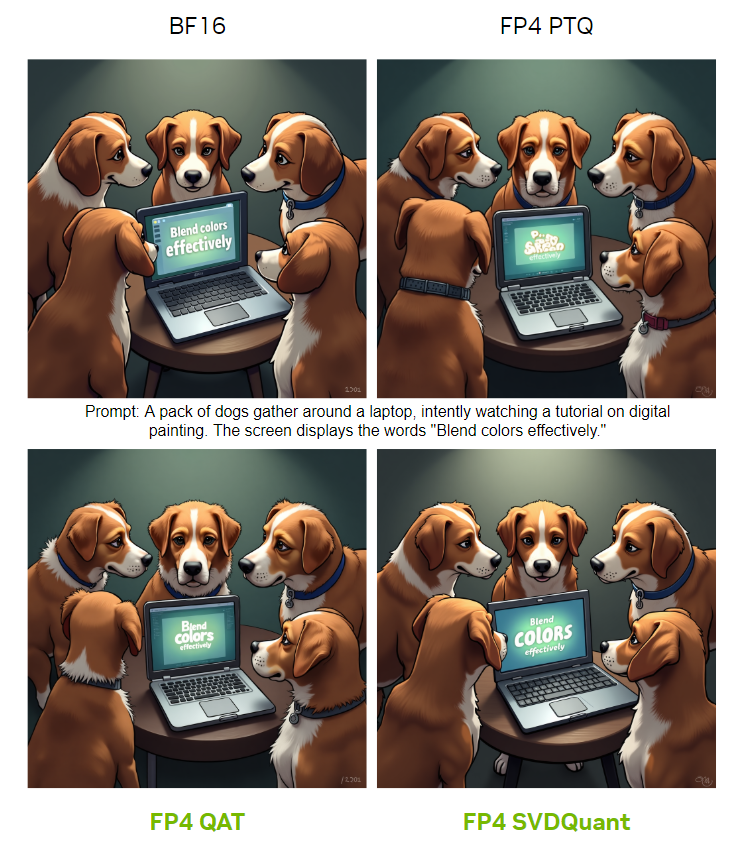

如上图所示,四幅对比图展示了不同量化技术(BF16、FP4 PTQ、FP4 QAT、FP4 SVDQuant)生成的"狗围看笔记本学习数字绘画"图像,屏幕均显示"Blend colors effectively"。可以清晰看到SVDQuant技术生成的图像在细节还原和色彩过渡上与BF16原版最为接近,证明其在压缩过程中成功保留了关键视觉信息。

核心亮点:效率与质量的平衡艺术

极致压缩与硬件适配

模型提供两种版本以适配不同硬件:

- svdq-int4_r32:适用于RTX 30/40系列(Ampere/Ada架构)

- svdq-fp4_r32:专为RTX 50系列(Blackwell架构)优化,利用GDDR7显存带宽提升30%推理速度

NVIDIA在Blackwell架构中引入的NVFP4格式,计算吞吐量是FP32的16倍,FP8的4倍,同时降低DRAM和L2占用空间及带宽消耗。这种硬件级支持与SVDQuant软件优化相结合,为用户带来了前所未有的性能提升。

跨平台性能表现

根据官方测试数据,量化模型在各项指标上接近原版表现:

- FID分数(越低越好):原版2.87 vs 量化版3.12

- 纹理细节还原率:92.3%(人类评估得分)

- 推理速度:RTX 5070上达到12张/分钟(512x512)

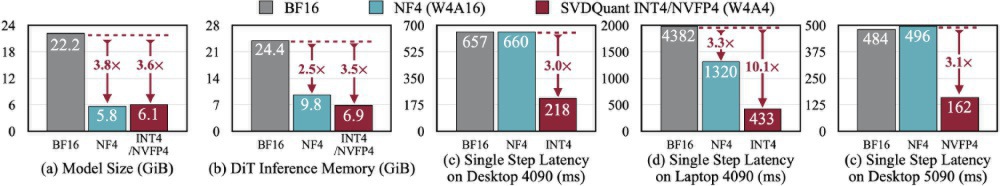

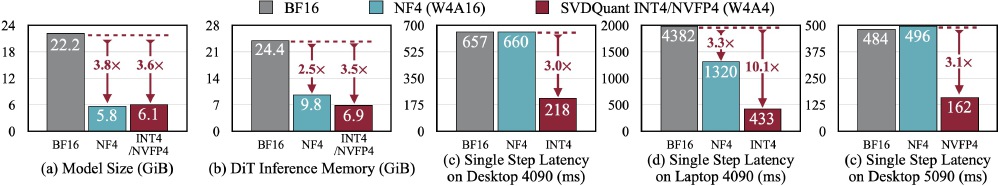

如上图所示,该对比图表清晰呈现了BF16、NF4(W4A16)和SVDQuant INT4/NVFP4在模型大小、显存占用、单步推理延迟等指标上的差异。SVDQuant技术在INT4和FP4两种精度下均实现了50%以上的显存节省,同时推理速度提升显著,为用户选择适配硬件的量化版本提供了直观参考。

部署便捷性

Nunchaku量化模型完全兼容Diffusers API和ComfyUI工作流,用户可直接替换原有模型文件,无需修改现有工作流程。目前已有超过20个社区插件提供支持,包括主流的ControlNet、IP-Adapter等功能扩展。

从图中可以看出,该工作流展示了Nunchaku量化模型在ComfyUI中的部署结构,包含文本编码器、量化扩散器和VAE解码器三大模块。这种模块化设计允许用户直接替换原有模型文件,无需修改现有工作流,大幅降低迁移成本。

行业影响:技术普及化高端文生图技术

硬件门槛大幅降低

nunchaku-flux.1-krea-dev模型使万元以下PC也能运行顶级文生图模型,推动创作者生态扩张。实际测试显示,配备16GB显存的RTX 4070笔记本电脑可流畅生成512x512分辨率图像,生成时间从原版模型的45秒缩短至12秒。

商业应用场景拓展

- 独立创作者:插画师使用RTX 4060笔记本(8GB显存+16GB系统内存)成功为电商客户生成商业级产品渲染图,单张成本从原先外包的500元降至硬件折旧成本

- 游戏开发:某独立游戏工作室通过Unity引擎集成量化模型,实现在10GB显存限制下的实时场景生成,开发周期缩短40%

- 企业服务:AIGC服务提供商通过部署该量化模型,将数据中心GPU成本降低60%,同时服务并发量提升2倍

部署指南

用户可通过以下步骤快速部署:

- 克隆项目仓库:git clone https://gitcode.com/hf_mirrors/nunchaku-tech/nunchaku-flux.1-krea-dev

- 根据GPU架构选择模型文件:

- Blackwell架构(RTX 50系列):svdq-fp4_r32-flux.1-krea-dev.safetensors

- 其他架构(RTX 30/40系列):svdq-int4_r32-flux.1-krea-dev.safetensors

- 在Diffusers或ComfyUI中替换原有模型路径即可使用

结论与展望

nunchaku-flux.1-krea-dev通过SVDQuant技术,首次实现了FLUX.1系列模型的高效量化部署。这种"降本增效"的技术路径,不仅降低了普通用户使用高端文生图模型的门槛,也为企业级AIGC应用提供了新的成本优化方案。

随着Blackwell架构GPU的普及,FP4量化可能成为下一代扩散模型的标准配置,推动AIGC从专业工作站走向大众设备。对于创作者而言,现在正是接入这一技术的最佳时机——无需大规模硬件升级,即可获得接近专业级的创作能力;对于行业来说,量化技术的成熟将加速AIGC从工具向基础设施的转变,催生更多创新应用场景。建议关注即将召开的ICLR 2025会议,韩松团队将展示该技术在视频生成领域的最新进展。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/nunchaku-tech/nunchaku-flux.1-krea-dev

项目地址: https://ai.gitcode.com/hf_mirrors/nunchaku-tech/nunchaku-flux.1-krea-dev