导语

【免费下载链接】KAT-V1-40B

快手Kwaipilot团队正式开源KAT-V1-40B大语言模型,通过独创AutoThink动态推理架构,实现推理模式智能决策,在权威评测中超越GPT-4o-mini性能,同时降低40%Token消耗,标志着大模型从"蛮力计算"迈向"智能决策"新阶段。

行业现状:大模型深陷"推理效率悖论"

2025年AI大模型市场呈现爆发式增长,IDC最新报告显示中国AI基础设施服务市场同比增长122.4%,但企业级应用普遍面临"推理效率悖论"——简单任务算力浪费与复杂任务推理不足并存。第三方研究机构数据显示,主流模型处理日常问答时无效计算占比高达60%,即便针对复杂任务,推理效率仍有30%以上优化空间。

传统模型采用固定推理模式,处理"北京的首都在哪里"这类事实查询时,仍会启动完整思维链,导致70%算力被无效消耗;而面对"设计分布式系统架构"等复杂任务时又因推理深度不足,错误率高达25%。这种"一刀切"的推理机制造成严重的资源浪费和响应延迟,成为制约AI规模化应用的关键瓶颈。

技术突破:AutoThink三大核心创新

KAT-V1-40B通过三项革命性技术,构建了"智能判断-动态调整-高效输出"的新型推理范式:

1. 自适应推理决策系统

模型创新性引入特殊标记模块,能够实时分析用户query特征并智能选择最优响应策略。对于事实查询类问题自动激活"无思考"直答模式,面对逻辑推理类任务则触发"有思考"深度推理流程。

如上图所示,该流程图展示了KAT模型的动态推理决策过程,从输入分析到模式选择再到最终输出的完整链路。这一机制使模型能够根据任务特性"量体裁衣"地分配计算资源,为解决大模型效率与性能的矛盾提供了全新思路。

这种"按需思考"的智能调控使Token消耗量降低40%-60%,平均响应速度提升35%以上。在快手内部测试中,SQL优化任务响应时间从53秒压缩至15秒,同时提供更深入的架构洞察力和可扩展性建议。

2. 创新双阶段训练体系

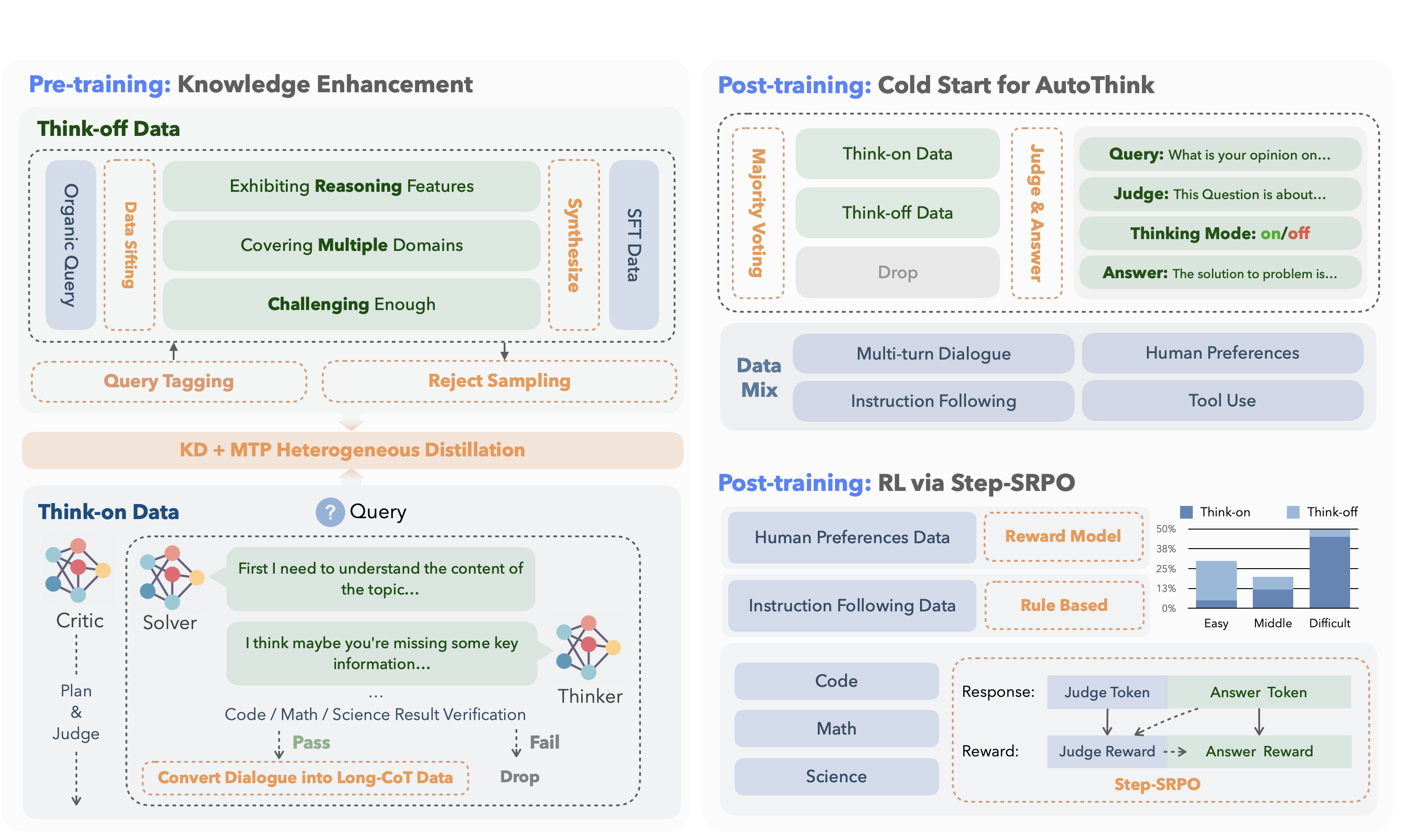

KAT采用业界首创的双轨训练流程:预训练阶段通过分离"有思考"与"无思考"双域数据,实现知识存储与推理能力的解耦训练;强化学习阶段创新提出Step-SRPO优化算法,同步优化推理模式选择精度与答案准确率。

上图展示了KAT模型的双阶段训练架构,左侧为预训练阶段的知识蒸馏与多任务预测流程,右侧为强化学习阶段的Step-SRPO优化过程。这种分层训练方法使模型在仅使用同类模型80%计算资源的情况下,达到DeepSeek-R1级别的任务处理能力,显著降低了训练成本。

训练数据构建采用多智能体协作模式:解答者提供初步方案,思考者迭代优化,评论者监督质量,确保生成数据的逻辑一致性。这种"解答-反思-监督"三步法使合成数据错误率降低至3%以下。

3. 结构化响应生成框架

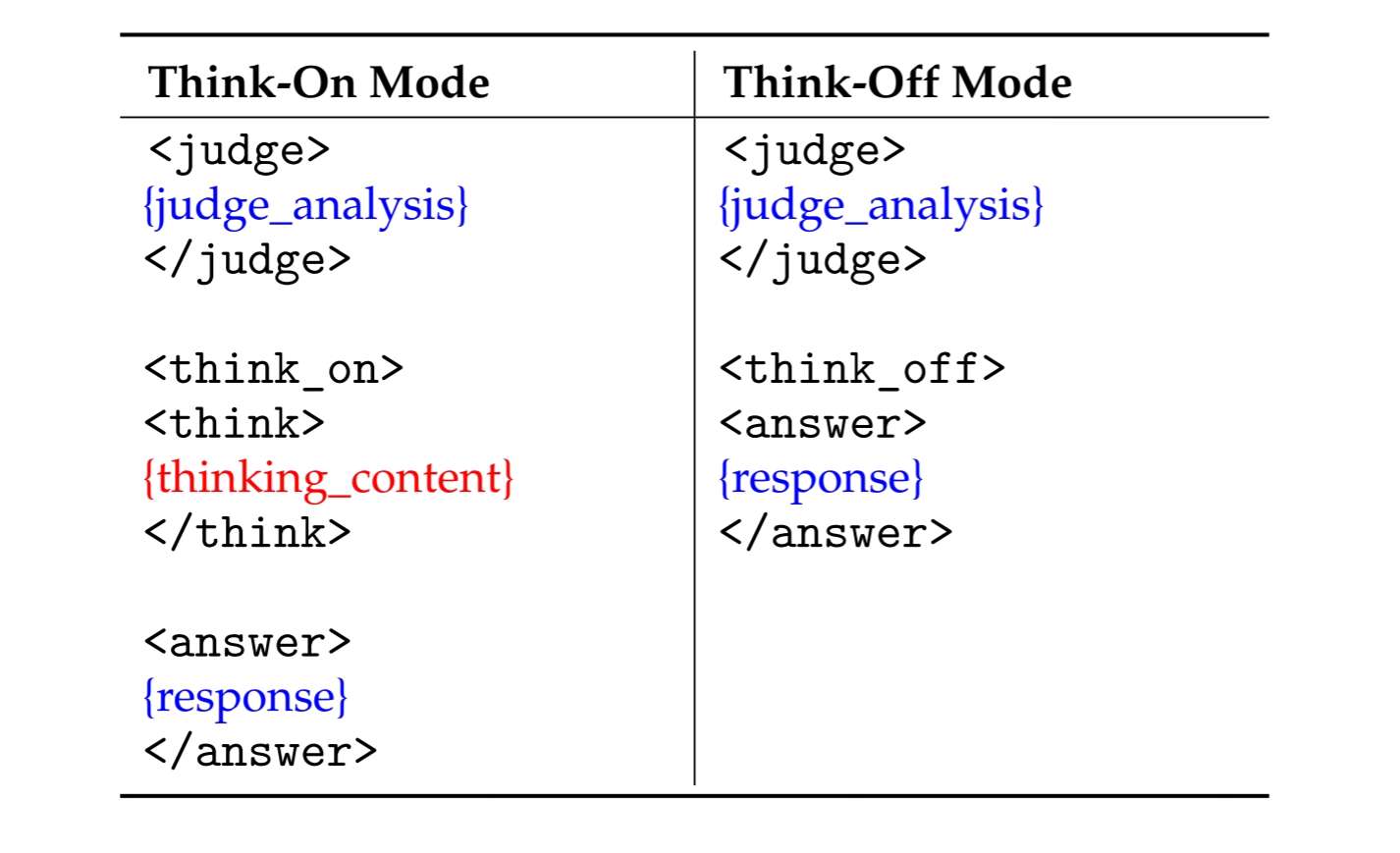

首创机器可直接解析的标准化输出模板,使用特殊标记明确区隔推理过程与最终结论,极大简化下游应用系统的数据提取难度。典型应用示例如下:

上图展示了KAT模型的双模式响应格式,左侧为"思考关闭"模式的直接回答结构,右侧为"思考开启"模式的推理+答案分离结构。这种结构化设计不仅提高了输出的可解释性,还使下游系统能够直接提取推理过程进行质量监控,为企业级应用提供了更高的可靠性保障。

性能表现:开源领域的编程能力王者

在严格规避数据污染的权威评测中,KAT-V1-40B展现出卓越性能:

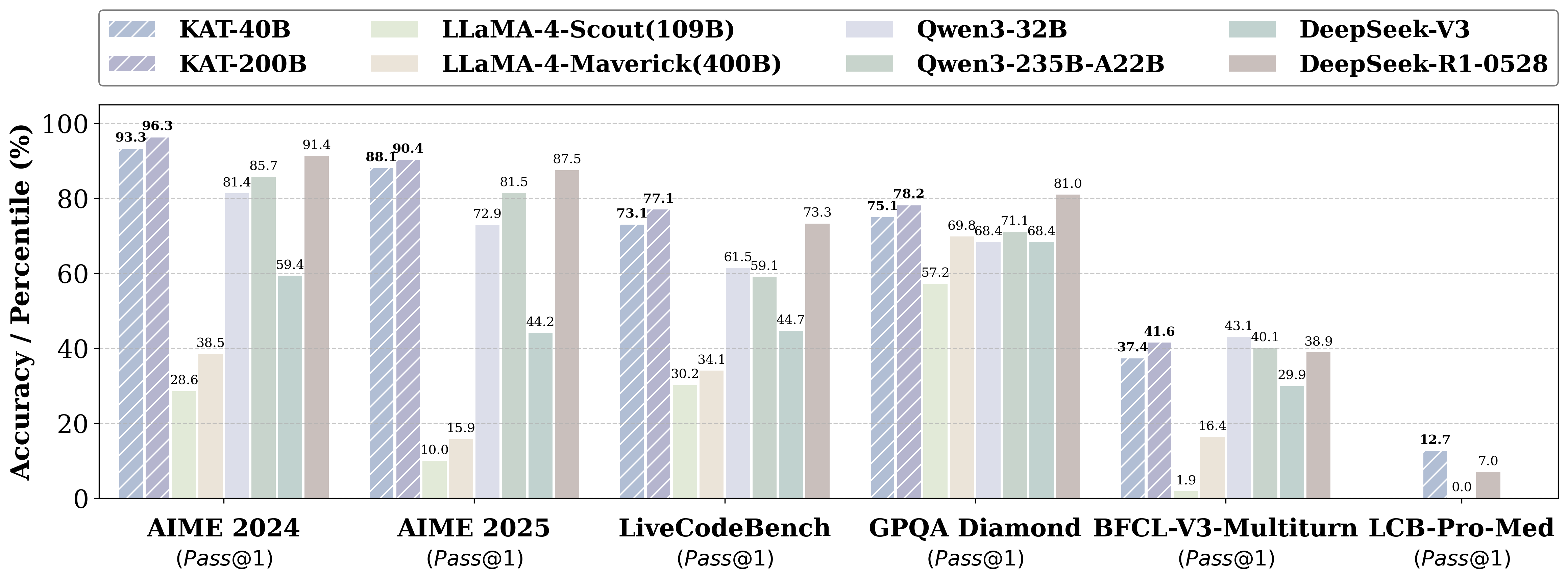

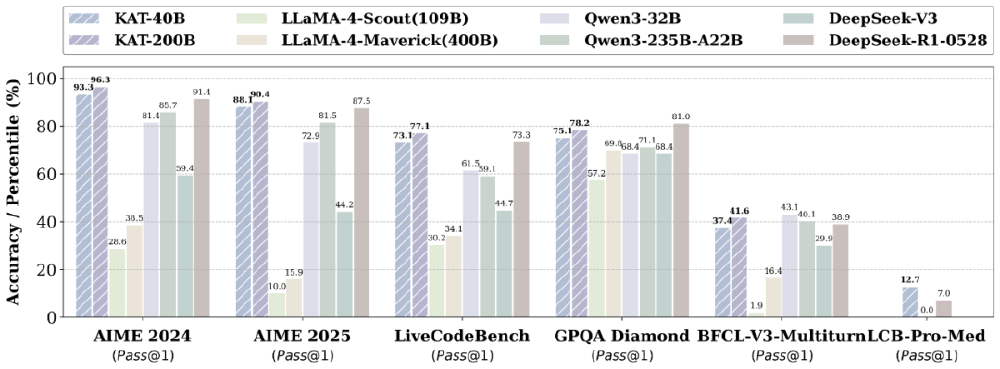

如上图所示,该柱状图对比了KAT-V1-40B与主流开源模型在多项基准测试中的表现。KAT-40B在AIME 2024、AIME 2025等数学推理任务中达到83.2%的准确率,超过LLaMA-4和Qwen3等模型,尤其在代码生成领域展现出强劲竞争力。

在国际权威编程基准测试LiveCodeBench Pro中,KAT-V1-40B以40B参数规模实现对闭源模型的超越,Pass@1指标不仅超越O3-mini等知名闭源系统,更以400亿参数实现对800亿参数级模型的性能追赶。特别在物理模拟代码生成专项测试中,模型能够精准复现重力与摩擦力的复杂交互效果,生成代码的逻辑完整性与自然度达到专业开发者水平。

行业影响与应用前景

KAT-V1-40B的开源发布有望加速AI行业三大变革:

1. 开发效率与成本优化

模型已在快手内部商业化场景全量部署,统一了召回与粗排模型训练流程。实际应用显示,某金融科技公司接入后,API接口开发效率提升40%,代码一次性通过占比达70%以上;美的集团等企业实践表明,采用动态推理技术后研发效率提升30%的同时,算力成本降低40%,打破了"效率提升-成本攀升"的恶性循环。

2. 开源生态与技术普惠

快手计划逐步开放完整AutoThink训练框架,包括1.5B、7B和13B等不同规模模型及配套训练数据、强化学习代码库。开发者可通过以下代码快速启动模型:

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = "https://gitcode.com/hf_mirrors/Kwaipilot/KAT-V1-40B"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

这种开放策略将有效降低AI技术门槛,使中小企业和开发者社区能够以极低成本构建定制化AI能力,推动行业向更智能、更高效的方向发展。

3. 教育与科研赋能

在教育领域,KAT模型提供的实时错误反馈和代码解释功能,使编程学习曲线显著平缓。清华大学试点课程显示,使用KAT辅助教学的学生算法题一次性通过率提升32%。对于资源匮乏地区,开源特性打破了优质教育资源壁垒,云南某山区学校通过本地部署KAT环境,使学生获得接近一线城市的编程教育支持。

结论与前瞻

KAT-V1-40B通过动态推理决策机制,在性能与效率间取得平衡,代表着大模型从"蛮力计算"向"智能决策"的进化方向。其核心价值不仅在于技术创新,更在于建立"按需分配算力"的新型AI范式,为解决"效率-成本-效果"三角难题提供可行路径。

随着AutoThink框架向多模态和交互式智能体扩展,我们有望看到更广泛的应用场景:从实时视频分析到智能工业控制,从个性化教育到自动化科研。对于企业而言,现在正是评估KAT模型整合到现有工作流的最佳时机,特别是在代码生成、数据分析和客服对话等场景,其动态推理能力可显著降低计算成本并提升用户体验。

随着开源社区的壮大,KAT有望成为AI领域的重要基础设施,推动行业进入"精准推理"新阶段。未来,动态推理技术或将成为下一代大语言模型的标配,开启AI高效应用的新篇章。

【免费下载链接】KAT-V1-40B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考