Kimi K2:万亿参数MoE架构如何重塑企业级AI部署格局

导语

月之暗面发布的Kimi K2大模型以1万亿总参数的混合专家(MoE)架构和320亿激活参数设计,在代码任务准确率(69.2%)和超长上下文(256K tokens)处理上实现突破,重新定义企业级AI应用的性能与成本边界。

行业现状:大模型进入"深水区"竞争

2025年企业级AI市场呈现三大变革趋势:智能体能力成为核心竞争力(72%企业增加相关投入)、混合专家(MoE)架构主导技术路线、上下文长度突破百万token级。根据Kong Research报告,具备工具调用能力的模型部署量同比增长300%,而MoE架构在参数效率上比传统密集模型提升4-8倍。当前主流大模型已形成差异化竞争格局,如GPT-5侧重全模态交互、Claude 4专注法律合规场景,而Kimi K2则凭借Agent数据合成与工具链原生集成能力,在自动化编程领域占据独特优势。

如上图所示,词云图清晰展示了当前AI大模型生态的核心技术要素与市场格局。Kimi作为其中的重要参与者,正通过技术创新重塑企业级AI应用的价值边界,特别是在超长上下文处理和代码智能领域形成差异化竞争力。

模型核心亮点

1. 超长长文本理解能力

Kimi K2将上下文窗口从128K升级至256K tokens,支持处理约50万字文档(相当于2.5本科幻小说),输出速度达60-100 tokens/秒。在SWE-bench多语言测试中,中文代码任务准确率提升至55.9%,较上版本增长18%。这一能力使企业可以直接处理完整的项目代码库、法律合同或医学文献,无需再进行碎片化处理。

2. 工业级编码智能

在SWE-bench Verified基准测试中,模型单轮代码修复准确率达69.2%,接近Claude Sonnet 4(72.7%)的商业模型水平。支持全栈开发流程:从架构设计(自动生成React+Node.js技术栈)到单元测试,将传统3周的开发周期压缩至3天。某SaaS公司应用后,代码审查效率提升60%,发现潜在bug数量增加200%。

3. 动态计算优化架构

采用384专家的MoE架构,每token激活8个专家(320亿参数),通过MLA注意力机制实现计算资源动态分配。这种设计使模型在保持高性能的同时,显著降低了计算成本。某电商平台客服系统应用后,首次解决率从60%提升至85%,人力成本降低40%。

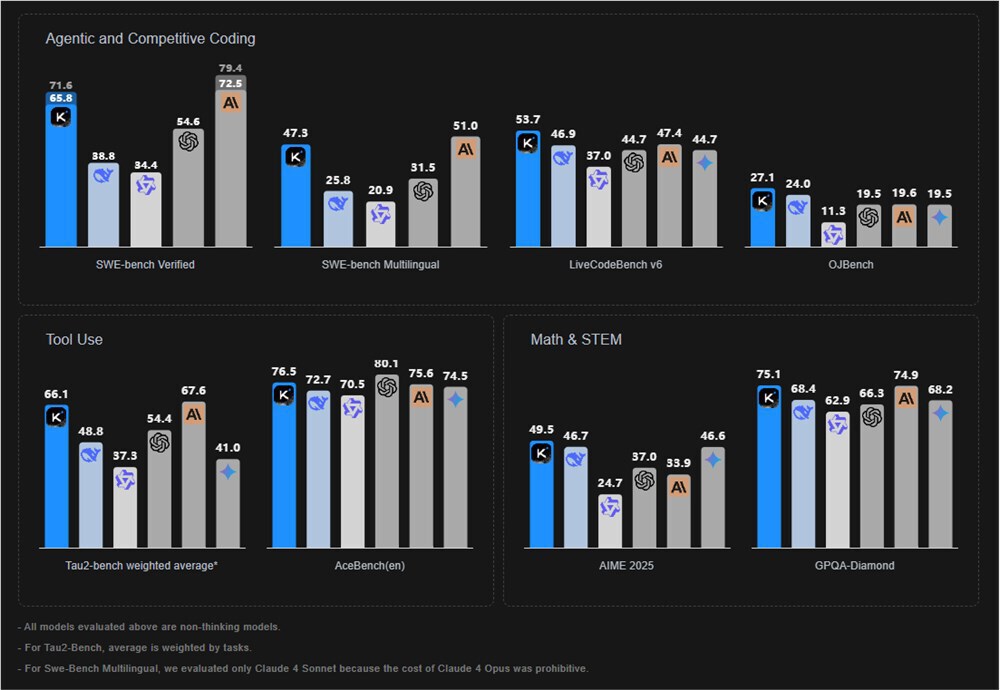

该图展示了Kimi K2在多个AI基准测试中的性能表现,涵盖编码(如SWE-bench、LiveCodeBench)、工具使用(Tau2-bench、AceBench)和数学推理(AIME 2025、GPOA-Diamond)等任务,直观呈现了其在开源模型中的领先地位。

企业应用场景与价值

企业级部署案例显示,Kimi K2已在四类场景实现价值闭环:

- 自主编码代理:某SaaS公司代码审查效率提升60%,发现潜在bug数量增加200%

- 智能数据分析:50万条电商订单数据处理从2天缩短至1小时,自动生成30+交互式图表

- 内容营销自动化:数字营销公司内容产量提升4倍,邮件转化率增长30%

- 客服系统重构:响应时间从5分钟压缩至30秒,客户满意度达4.6/5分

部署与使用指南

Kimi K2支持多种部署方式,满足不同企业需求:

本地化部署

通过vLLM或SGLang推理引擎,在企业私有环境部署,满足数据隐私要求。推荐配置为至少128GB统一内存,16GB VRAM可实现5+ tokens/sec的生成速度。企业可通过以下命令快速获取模型:

git clone https://gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF

API调用

通过Novita AI等平台提供的OpenAI兼容API,快速集成至现有系统,按调用量付费,降低初始投入。API定价为每百万输入tokens 4元、输出16元,成本约为Claude的五分之一。

性能优化建议

- 使用INT4量化:

--load-in-4bit参数可减少75%显存占用 - 调整批处理大小:根据硬件配置设置

--batch-size 8-32 - 启用PagedAttention:vLLM引擎下推理吞吐量提升2-4倍

行业影响与趋势

Kimi K2的发布印证了三大行业趋势:上下文竞赛进入"百万字时代"、MoE架构成为参数效率最优解、智能体能力从实验室走向工业化。其Modified MIT许可证开放商用的策略,将加速开源大模型在企业级场景的普及,可能引发新一轮AI技术普惠浪潮。

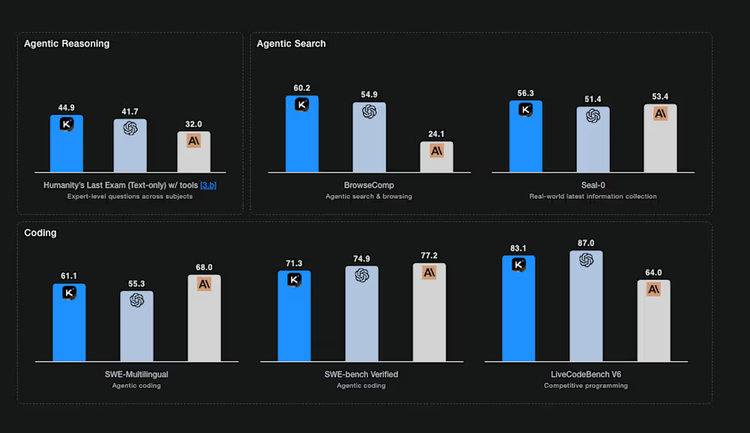

从图中可以清晰看到,Kimi K2在BrowseComp(60.2%)、SWE-Bench Verified(71.3%)等关键指标上不仅领先所有开源模型,还超越了GPT-5和Claude 4.5等闭源旗舰产品,标志着开源模型在核心能力上实现历史性突破。

结论与前瞻

Kimi K2通过256K上下文窗口、69.2%代码准确率和MoE架构优化,为企业提供了高性能与低成本兼备的AI解决方案。无论是客服系统重构、代码开发效率提升还是长文档处理,该模型都展现出显著的商业价值。

对于企业决策者,建议优先关注K2的工具调用框架(支持函数参数自动补全)和长文档处理能力,这两大特性已在实际案例中展现出最高的投入产出比。随着开源生态的完善,K2有望成为继Llama之后,又一个推动行业技术标准重构的关键模型。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF