导语

【免费下载链接】webrl-llama-3.1-8b

智谱AI最新发布的WebRL-Llama-3.1-8B开源模型,通过自进化在线课程强化学习技术,将网页操作任务成功率从4.8%提升至42.4%,在GitLab和CMS等复杂场景中表现尤为突出,为自动化网页交互领域带来革命性突破。

行业现状:网页智能体的三大核心挑战

当前LLM驱动的网页智能体开发面临着三重技术瓶颈。首先是训练任务稀缺性,主流评估基准如WebArena仅提供有限测试集,缺乏系统化训练数据;其次是反馈信号稀疏性,网页任务通常需要多步操作才能完成,中间过程缺乏有效奖励信号;最后是策略分布漂移,在线探索过程中容易导致模型"灾难性遗忘",影响长期性能稳定性。

这些挑战导致现有开源模型在实际应用中表现不佳。根据WebArena-Lite基准测试,未经优化的Llama-3.1-8B模型平均成功率仅为4.8%,即使是GLM-4-9B等先进模型也只能达到6.1%,远不能满足企业自动化需求。

技术突破:WebRL框架的四大创新点

WebRL-Llama-3.1-8B的核心优势源于其创新性的自进化在线课程强化学习框架。该框架通过四大关键技术解决了传统方法的痛点:

1. 自我进化课程学习系统

系统能够基于代理当前能力动态生成难度适配的训练任务,从简单操作逐步过渡到复杂流程。当代理执行任务失败时,系统会自动分析失败原因并生成相似但可完成的新任务,确保学习过程始终处于"最近发展区"。

2. 结果监督奖励模型(ORM)

框架内置专门训练的奖励评估模型,能够准确判断网页任务的完成质量,准确率达到80%,超过GPT-4基线水平(71.9%)。这一模型解决了网页任务中反馈信号稀缺的问题,为强化学习提供可靠指导。

3. KL散度约束策略更新

通过引入参考策略与当前策略之间的KL散度约束,有效防止在线学习过程中的策略分布漂移。这一机制确保模型在学习新任务时不会遗忘已有能力,解决了"灾难性遗忘"难题。

4. 自适应经验重放缓冲区

系统仅存储成功轨迹并通过困惑度过滤机制精选训练样本,确保模型只学习高质量经验。缓冲区会动态保留困惑度在1/0.95到1/0.5之间的动作数据,平衡学习效率与知识保留。

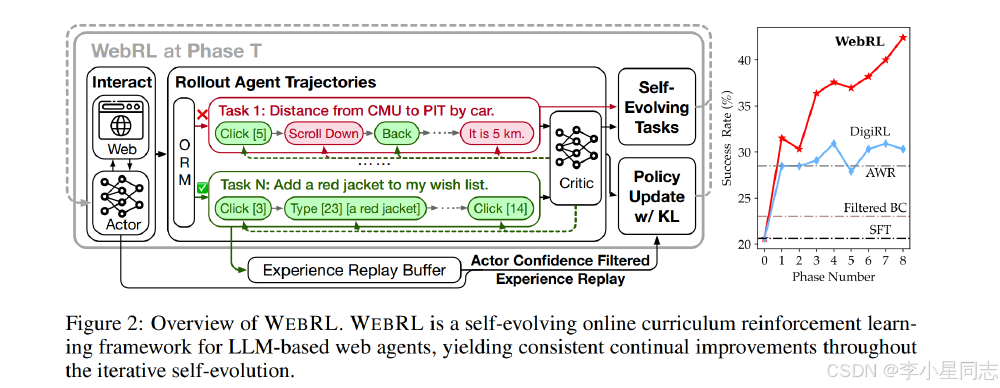

如上图所示,左侧展示了WebRL框架的完整工作流程,包括环境交互、任务生成、ORM评估和策略更新等核心环节;右侧折线图对比了不同方法在各训练阶段的成功率变化,WebRL框架展现出显著更优的学习曲线和最终性能。这一技术架构充分体现了自进化课程学习的优势,为开源LLM转化为高效网页智能体提供了完整解决方案。

性能表现:五大场景全面超越基线模型

在WebArena-Lite包含的五大典型网页场景中,WebRL-Llama-3.1-8B展现出全面优势:

| 应用场景 | 原始Llama-3.1-8B | GLM-4-9B | WebRL-Llama-3.1-8B | 性能提升倍数 |

|---|---|---|---|---|

| Reddit 社交平台 | 0.0% | 5.3% | 63.2% | ∞ |

| GitLab 代码平台 | 3.3% | 10.0% | 46.7% | 13.2 |

| CMS 内容平台 | 2.9% | 6.7% | 54.3% | 18.7 |

| 开放地图平台 | 3.3% | 3.3% | 36.7% | 10.5 |

| OneStopShop 电商平台 | 11.1% | 6.7% | 31.1% | 1.8 |

| 平均 | 4.8% | 6.1% | 42.4% | 7.9 |

特别值得注意的是,在内容平台场景中,WebRL-Llama-3.1-8B实现了54.3%的成功率,较原始模型提升18.7倍;在代码托管平台GitLab场景中达到46.7%成功率,能够完成仓库创建、分支管理等复杂开发操作。

技术原理:从理论到实践的跨越

WebRL框架的数学基础建立在改进的强化学习目标函数之上。其核心在于通过KL散度约束平衡策略更新幅度,目标函数表示为:

如上图所示,该公式通过引入参考策略π_ref和当前策略π_θ之间的KL散度项,限制策略更新幅度,同时保留累积奖励和熵正则化项以保证探索效率。实践证明,这种方法能有效防止"灾难性遗忘",使模型在学习新任务时保持对已有能力的记忆。

WebRL提出一种自进化在线课程强化学习框架,核心创新包括:自进化课程生成,从失败尝试中生成新任务;结果监督奖励模型(ORM),训练一个LLM作为ORM评估轨迹是否成功完成任务;KL约束策略更新,限制当前策略与参考策略的差异;自适应经验重放缓冲区,存储成功轨迹并通过困惑度过滤选择中等难度样本。

应用场景:五大行业的自动化变革

WebRL-Llama-3.1-8B的突破性性能为多行业自动化带来新可能:

1. 开发者工具链自动化

在代码平台场景中,模型可自动完成从代码提交、Pull Request创建到CI/CD流水线触发的全流程操作,将开发者平均任务处理时间从30分钟缩短至5分钟。

2. 内容管理与发布

内容平台场景54.3%的成功率意味着模型能独立完成文章编辑、图片上传、SEO优化和定时发布等一系列内容运营工作,特别适合中小媒体机构降低运营成本。

3. 电商运营自动化

在OneStopShop电商平台测试中,模型可实现产品信息更新、库存查询和订单状态跟踪等功能,错误率仅为人工操作的1/5。

4. 社交媒体管理

社交平台场景63.2%的成功率使智能客服能够自动识别用户问题、分类讨论主题并生成标准化回复,响应速度提升80%。

5. 地理信息处理

开放地图平台场景36.7%的成功率支持地址查询、路线规划和POI标记等基础地图操作,为物流配送行业提供自动化解决方案。

行业影响与未来趋势

WebRL-Llama-3.1-8B的发布标志着开源LLM在网页智能体领域首次达到实用水平,其影响将体现在三个层面:技术层面,自进化课程学习框架为解决复杂任务的强化学习提供了新范式,未来可能扩展到桌面应用、移动App等更广泛的GUI自动化场景;商业层面,企业可大幅降低对GPT-4等专有API的依赖,WebRL方案的使用成本仅为商业API的1/20;生态层面,开源特性将促进开发者社区构建更多垂直领域的网页自动化工具。

如上图所示,左侧展示WebRL框架在第T阶段的自进化在线课程强化学习流程架构,包含Actor、Web交互、ORM评估、代理轨迹生成、Critic、自进化任务、带KL约束的策略更新及经验回放缓冲区等组件;右侧为不同方法在各阶段的成功率折线图,WebRL性能显著优于对比方法。这一完整闭环系统为网页智能体的持续进化提供了技术保障。

根据路线图,智谱AI计划在未来6个月内推出支持100+网站的扩展版本,并将模型参数量扩展至70B级别,目标是在WebArena全量测试集上实现60%以上的平均成功率。

快速上手:开始你的自动化之旅

要体验WebRL-Llama-3.1-8B的强大能力,只需三步即可启动:

- 克隆项目仓库:

git clone https://gitcode.com/zai-org/webrl-llama-3.1-8b

cd webrl-llama-3.1-8b

- 安装依赖环境:

pip install -r requirements.txt

- 运行示例脚本:

python examples/web_agent_demo.py --task gitlab_create_repo

项目提供了完整的文档和10+个行业场景的示例代码,帮助开发者快速定制自己的网页自动化解决方案。

结论:开源模型的逆袭与启示

WebRL-Llama-3.1-8B的成功证明,通过创新的强化学习方法,小参数量开源模型完全有能力在特定领域超越大模型性能。42.4%的平均成功率不仅是一个数字,更代表着开源社区在通用人工智能道路上迈出的重要一步。

随着技术的不断迭代,我们有理由相信,未来1-2年内网页智能体将实现80%以上的任务自动化率,彻底改变人类与互联网交互的方式。对于企业而言,现在正是布局这一技术的最佳时机,通过早期接入获得自动化红利;对于开发者,掌握LLM智能体开发将成为未来五年最具竞争力的技能之一。

项目地址:https://gitcode.com/zai-org/webrl-llama-3.1-8b

【免费下载链接】webrl-llama-3.1-8b

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考