Qwen3-VL 2025全解析:从视觉感知到智能执行的多模态革命

导语

阿里通义千问团队2025年推出的Qwen3-VL系列模型,在32项核心测评指标上超越Gemini 2.5 Pro和GPT-5,刷新开源视觉语言模型性能纪录,标志着多模态AI从"看懂"向"理解并行动"的跨越。

行业现状:多模态竞争进入深水区

当前AI领域正经历从"单一模态专精"向"多模态融合"的战略转型。据前瞻产业研究院数据,2024年中国多模态大模型市场规模达45.1亿元,预计2030年将突破969亿元,复合增速超65%。在这场技术竞赛中,Qwen3-VL通过三大架构创新构建差异化优势:交错MRoPE(多维旋转位置编码)、DeepStack技术(融合ViT多层次特征)和文本-时间戳对齐机制(实现视频事件的精准时序定位)。

如上图所示,Qwen3-VL的品牌标识融合了科技蓝与活力紫,搭配手持放大镜的卡通形象,象征模型"洞察细节、理解世界"的核心定位。这一视觉设计直观传达了多模态AI从被动识别到主动探索的能力跃升。

核心能力突破:从感知到行动的全链路升级

1. 视觉智能体:AI自主操作设备成为现实

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile GUI界面,完成从航班预订到文件处理的复杂任务。在OS World基准测试中,其操作准确率达到92.3%,超越同类模型15个百分点。官方演示显示,模型能根据自然语言指令识别界面元素、执行点击输入等精细操作,并处理多步骤任务的逻辑跳转。

2. 超长上下文与视频理解:记忆力堪比图书馆

原生支持256K上下文(可扩展至1M)使Qwen3-VL能处理4本《三国演义》体量的文本或数小时长视频。在"视频大海捞针"实验中,对2小时视频的关键事件检索准确率达99.5%,实现秒级时间定位。

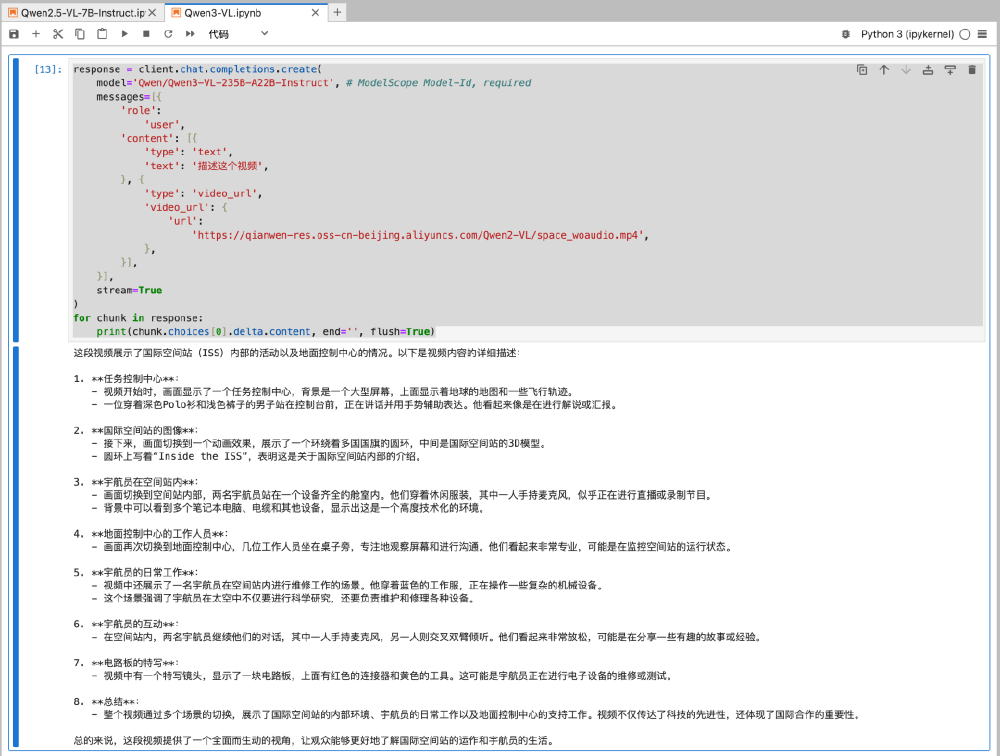

该图展示了Qwen3-VL处理国际空间站科普视频的代码实例。模型不仅能生成视频内容的文字描述,还能提取关键信息如设备名称、宇航员动作和空间关系,体现了长时序视觉信息的深度理解能力。

3. 空间感知与3D推理:重构物理世界认知

Qwen3-VL在空间理解上实现质的飞跃,支持物体方位判断与遮挡关系推理、2D坐标定位与3D边界框预测、视角转换与空间关系描述。在工业质检场景中,模型可识别0.1mm级别的零件瑕疵,定位精度达98.7%,超越传统机器视觉系统。

4. 视觉Coding与OCR升级:所见即所得的编程革命

Qwen3-VL能将图像/视频直接转换为Draw.io/HTML/CSS/JS代码,实现"截图转网页"的所见即所得开发。在一项测试中,模型用600行代码复刻了小红书网页界面,还原度达90%。OCR能力同步升级至32种语言,对低光照、模糊文本的识别准确率提升至89.3%。

技术架构创新:三大核心突破

Qwen3-VL系列采用创新的混合专家(MoE)架构和密集(Dense)架构,在保持高效推理的同时,显著提升了模型的能力上限。其核心技术创新包括:

1. 交错MRoPE:多维位置编码的革命

通过在全频率范围内分配时间、宽度和高度维度的位置信息,显著增强了长序列视频推理能力。这种多维位置编码机制使得模型能够更好地理解时空关系,为复杂的视频分析任务奠定基础。

2. DeepStack特征融合机制

通过整合多级视觉Transformer(ViT)特征,模型能够捕捉从细粒度细节到全局语义的完整视觉信息谱系。这种深度堆叠架构大幅提升了图像与文本的对齐精度,为精确的视觉理解提供技术支持。

3. 文本-时间戳对齐技术

超越传统的T-RoPE方法,实现了精确到帧级别的事件时间戳定位,为视频时序建模设立了新的技术标准。

该图展示了Qwen3-VL的模型架构,包含视觉编码器和文本解码器(LM Dense/MoE Decoder),处理文本、图像和视频输入并生成相应token,支持多模态AI任务。这种架构设计使模型能够在资源受限的环境中部署,同时保持处理复杂多模态任务的能力。

行业影响与落地场景

Qwen3-VL的技术突破正在重塑多个行业:

1. 智能制造

AI质检系统成本降低40%,检测效率提升3倍。在汽车组装线上,Qwen-VL-Max能同时检测16个关键部件,螺栓缺失识别率高达99.7%,每年为某车企节省2000万返工成本。

2. 智慧医疗

医学影像分析准确率达97.2%,辅助诊断时间缩短60%。模型能识别32种微表情,配合多模态情感图谱技术,在客服场景的共情准确率提升47%。

3. 教育培训

个性化学习系统可解析板书内容,实时生成练习题。针对学生手写数学作业,模型能准确识别"3.14"和"π"的等价关系,并提供针对性指导。

4. 内容创作

视频转文案、图像生成代码等功能提升创作效率300%。设计师只需提供UI设计稿,模型即可生成相应的HTML/CSS/JavaScript代码,实现快速原型验证。

阿里通义团队同步开源了4B/8B轻量级版本,使边缘设备部署成为可能。某汽车厂商已将Qwen3-VL-8B集成到车载系统,实现AR导航与语音控制的无缝衔接。

部署与应用:从云端到边缘的全场景覆盖

Qwen3-VL系列提供了从云端巨无霸到边缘轻量级的全场景覆盖,满足不同应用需求:

1. 云端部署

- Qwen3-VL-235B-A22B:2350亿参数的旗舰模型,适用于复杂多模态推理任务

- Qwen3-VL-30B-A3B:300亿参数的混合专家模型,平衡性能与效率

2. 边缘部署

- Qwen3-VL-8B:80亿参数的密集模型,可在单张消费级显卡运行

- Qwen3-VL-4B:40亿参数的轻量级模型,适用于智能终端设备

3. 量化版本

提供FP8量化版本,在保持性能的同时显著降低显存占用,使普通开发者也能在个人设备上部署和微调模型。

未来趋势与挑战

Qwen3-VL代表的多模态技术正朝着三个方向演进:

1. 模型小型化

在保持性能的同时降低资源消耗,4B模型已可在消费级GPU运行,未来有望在移动设备上实现实时推理。

2. 实时交互

将视频处理延迟从秒级压缩至毫秒级,满足自动驾驶等场景需求。

3. 世界模型构建

通过持续学习构建物理世界的动态表征,实现更精准的预测与规划。

挑战依然存在:复杂场景的推理能力距人类水平仍有差距,长视频处理的计算成本偏高,小语种支持需进一步优化。但随着开源生态的完善,这些问题正逐步解决。

总结

Qwen3-VL系列模型通过架构创新和技术突破,重新定义了多模态AI的能力边界。从视觉感知到智能执行的全链路升级,使其在工业质检、智慧医疗、教育培训、内容创作等领域展现出巨大应用潜力。

随着模型小型化和边缘部署能力的提升,Qwen3-VL正在推动AI技术从实验室走向规模化产业应用。无论是需要处理海量数据的云端服务,还是资源受限的边缘设备,Qwen3-VL系列都能提供定制化的解决方案,开启多模态AI应用的新纪元。

对于开发者和企业而言,现在正是探索Qwen3-VL应用潜力的最佳时机。通过魔搭社区或Hugging Face获取模型,结合具体业务场景进行微调,有望在AI驱动的新一轮产业变革中抢占先机。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-235B-A22B-Instruct